【自然语言处理的验证误区】:验证集在NLP模型验证中的正确应用与技巧

发布时间: 2024-11-23 08:35:56 阅读量: 23 订阅数: 36

英文翻中文的小数据集,适合做自然语言处理NPL的机器翻译模型验证

# 1. 自然语言处理模型验证的重要性

在自然语言处理(NLP)领域,构建和验证高质量的模型是确保其在实际应用中有效性的关键步骤。模型验证不仅关乎模型的性能评估,更关系到其在不同场景下的普适性和可靠性。验证集的构建和应用是这一过程中的核心部分,它为开发者提供了一个可以公平评价模型表现的平台。通过深度分析验证集的构建方法、应用策略,以及优化技巧,本章旨在揭示验证在模型开发周期中的重要性,并为进一步研究和应用提供指导。

## 2.1 验证集在NLP中的作用

### 2.1.1 验证集定义和目的

验证集(Validation Set)是模型训练过程中用来评估模型性能的独立数据集。它的主要目的是通过与训练集分离,确保对模型进行客观的性能评估,避免过拟合。在训练过程中,开发者会使用验证集来观察模型在未见数据上的表现,以此调整超参数和改进模型结构。

### 2.1.2 验证集与训练集、测试集的关系

验证集、训练集和测试集共同构成了典型的机器学习数据划分方法。训练集用于模型学习数据中的模式,验证集用于指导模型调整和优化,而测试集则用于最终评估模型的泛化能力。在NLP任务中,由于语言的多样性和复杂性,合理划分这三个部分显得尤为重要。

下一章节,我们将深入探讨验证集的理论基础与构建。

# 2. 验证集的理论基础与构建

## 2.1 验证集在NLP中的作用

### 2.1.1 验证集定义和目的

验证集是一种在模型训练过程中用来评估模型性能的数据集合。它在模型的开发阶段扮演着至关重要的角色,原因在于它帮助研究人员和开发者理解模型在未见数据上的表现,从而对模型参数和结构进行调整优化。在机器学习中,通常将数据集分为训练集、验证集和测试集三个部分。训练集用于模型学习,验证集用于模型选择与调整,测试集则用于最终评估模型性能。

验证集的选取应避免任何与训练集的数据重叠,并且要尽可能地反映真实世界的数据分布,这样可以避免模型对训练数据过拟合,同时还能评估模型的泛化能力。因此,验证集是机器学习和自然语言处理(NLP)模型优化不可或缺的部分,它保证了模型在新数据上表现的稳定性和可靠性。

### 2.1.2 验证集与训练集、测试集的关系

在模型训练和评估过程中,数据集通常按照一定的比例被划分为训练集、验证集和测试集。训练集用于模型的初步学习,是模型参数调整的主要依据。验证集则用于在模型训练过程中,针对不同的超参数选择、网络结构调整等进行性能评估,从而对模型进行优化。它提供了对模型泛化能力的初步估计。

一旦模型通过验证集评估并选择最终参数,就需要使用独立的测试集进行性能评估。测试集用于模拟模型在实际应用中的表现,它是对模型最终性能的客观评价。因此,验证集和测试集在评估模型性能时起到相互补充的作用,共同确保模型的训练和评估过程的公正性和准确性。

## 2.2 构建高质量验证集的原则

### 2.2.1 数据分布的代表性

构建高质量的验证集,首先要保证数据分布的代表性,这样模型在验证集上的表现才能真实反映其对未见数据的泛化能力。代表性意味着验证集中的数据应覆盖训练集中的所有主要类别,并且各类别数据的比例应尽可能地接近它们在总体数据集中的比例。这样做可以确保模型在各个类别上都有良好的性能,而不是仅仅在某个特定类别的数据上表现良好。

为了评估数据分布的代表性,可以使用一些统计分析方法,如直方图、箱型图等可视化工具,来观察不同类别数据的分布情况。在处理不平衡数据集时,可能还需要引入重采样技术,如过采样少数类别或欠采样多数类别,以平衡数据分布。

### 2.2.2 数据多样性和平衡性

除了数据分布的代表性,构建高质量验证集还需考虑数据的多样性和平衡性。多样性意味着验证集中的数据应尽可能覆盖各种场景和条件,以保证模型能够学习到不同情况下的数据特征。例如,在文本分类任务中,验证集应包括不同主题的文本,以及各种书写风格和语言表达形式的样本。

平衡性则意味着各类数据在验证集中的占比应该相对均衡,以确保模型不会偏重于某个特定类别的特征。在某些情况下,完全的平衡并不总是可能或必要,但应该通过适当的采样策略和加权方法来尽可能地减少类别间的性能差距。

## 2.3 验证集设计的常见错误

### 2.3.1 过拟合到验证集的风险

设计验证集时的一个常见错误是过拟合到验证集。过拟合指的是模型对于验证集中的特定样本过于敏感,从而导致模型对未见数据泛化能力的下降。这通常是由于验证集选取不当或验证集中的样本过于单一导致的。例如,如果验证集是按照某种特定的顺序选取的,那么模型可能会学习到与数据顺序有关的无关特征,而不是学习到对数据内容的理解。

为了避免过拟合到验证集,可以采用随机抽样的方法来构造验证集,确保验证集中的数据在特征空间内是分布均匀的。此外,可以定期更新验证集,或者采用多轮交叉验证的方法,让模型在多个不同的验证集上进行训练和测试,以此来增加验证的稳健性。

### 2.3.2 数据泄露的问题与对策

数据泄露是另一个在设计验证集时需要警惕的问题。数据泄露指的是训练数据中的信息被错误地引入到验证集或测试集中,从而导致模型性能评估的不准确。在NLP任务中,数据泄露可能出现在诸如使用了未来的信息、共享了相同的文档片段,或者验证集包含了训练集中的噪声数据等情况。

为了预防数据泄露,首先需要确保验证集和测试集是从总体数据集中分离出来的,且在模型开发的任何阶段都没有被使用过。在实际操作中,常常需要严格的数据管理流程,比如采用时间戳或数据来源标签来追踪数据样本的使用历史。另外,可以采用人工审核的方式来检测潜在的数据泄露风险,确保验证集和测试集的独立性和公正性。

# 3. 验证集在不同类型NLP任务中的应用

在自然语言处理(NLP)中,模型验证是一个关键环节,它确保了模型在不同任务中的泛化能力和可靠性。不同的NLP任务对验证集的设计提出了不同的要求和挑战。本章将深入探讨机器翻译、文本分类和问答系统这三个典型NLP任务中验证集的应用和设计。

## 3.1 机器翻译任务的验证集设计

### 3.1.1 评价指标与数据集特性

在机器翻译任务中,验证集的设计直接关系到翻译质量的评估。评价指标如BLEU、METEOR、TER等被广泛使用,它们各有侧重点,如BLEU关注n-gram匹配度,METEOR则考虑了词形变化和同义词替换等。选择合适的评价指标对构建有效验证集至关重要。

为了使评价更为公正和全面,验证集应具有以下特性:

- **代表性**:数据应覆盖模型可能遇到的各种场景,如日常对话、专业文献、新闻报道等。

- **多样性**:包括不同的语言对、表达风格、话题范围和语法结构。

- **平衡性**:应涵盖常见的用语和少见的表达,保证训练数据的覆盖面。

### 3.1.2 语言对的选择和数据增强

构建验证集时,语言对的选择应考虑实际应用需求。对于广泛使用的语言对,如英语和中文,应保证有足够的样本量,对于低资源语言对,可能需要通过数据增强技术(如回译、数据扩充)来增加样本多样性。

数据增强技术的应用示例如下:

```python

from nlpaug.util import AudioLoader

from nlpaug.augmenter.spectrogram import AudioSpectrogramAugmenter

# 语音增强示例

aug = AudioSpectrogramAugmenter(stateless=True)

aug.augment('path/to/audio/file.wav')

```

上述代码块展示了如何使用`nlpaug`库对音频文件进行数据增强。这种技术可以扩展数据集,提高模型在处理不同语料时的鲁棒性。

## 3.2 文本分类任务的验证集应用

### 3.2.1 标签不平衡处理

在文本分类任务中,标签不平衡是一个普遍存在的问题。为了减少验证集中的偏见,需要采用平衡策略。常见的策略包括过采样少数类、欠采样多数类、合成新样本(如SMOTE算法)等。

```python

from imblearn.over_sampling import SMOTE

# 使用SMOTE算法进行过采样

X_resampled, y_resampled = SMOTE().fit_resample(X, y)

```

通过SMOTE算法,可以在保持数据分布的基础上增加少数类的样本数量,从而减少验证集中由于标签不平衡带来的误差。

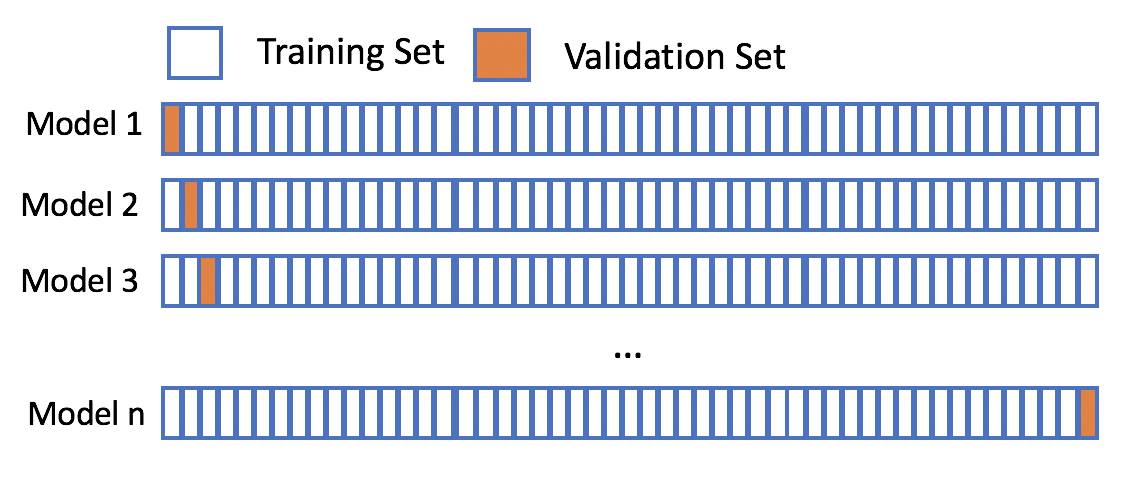

### 3.2.2 交叉验证的策略

在分类任务中,交叉验证是常用的模型评估方法。它通过将数据集分成k个大小相似的互斥子集,每个子集轮流作为测试集,其余的子集作为训练集,可以更全面地评估模型性能。

交叉验证的示例如下:

```python

from sklearn.model_selection import KFold

# K折交叉验证

kfold = KFold(n_splits=5, shuffle=True, random_state=7)

for train_index, test_index in kfold.split(X):

X_train, X_test = X[train_index], X[test_index]

y_train, y_test = y[train_index], y[test_index]

# 这里可以添加模型训练和测试的代码

```

通过上述代码,我们可以看到如何利用`sklearn`的`KFold`进行交叉验证。这有助于避免因数据分割方式不同

0

0