【超参数调整的艺术】:验证集策略在优化机器学习模型中的高级用法

发布时间: 2024-11-23 07:40:59 阅读量: 6 订阅数: 19

# 1. 超参数调整的艺术导论

超参数调整是机器学习中的一个核心环节,可以比喻为模型训练的“调音师”。对于有经验的从业者而言,掌握这门“艺术”能够显著提升模型的性能和泛化能力。不同于在数据中学习的参数,超参数是模型训练之前必须设定好的参数,它们决定了学习的过程和模型的结构。超参数设置的好坏直接影响模型的训练效率和最终性能。在本章,我们将探讨超参数调整的艺术,为读者提供理论基础和实际操作的入门指导。

在本章的后续部分,我们将:

- 讨论超参数的定义和分类,

- 解释模型性能的关键指标,

- 并引入超参数调整的基本原则和方法。

这些内容将为读者在接下来的章节中深入探讨超参数优化和验证集策略打下坚实的基础。通过这些讨论,我们可以了解到超参数调整并不仅仅是技术问题,更是一种艺术,它依赖于我们的直觉、经验以及对数据和模型的深刻理解。

# 2. 理解验证集策略的理论基础

## 2.1 超参数和模型性能的关系

### 2.1.1 超参数的定义和分类

超参数是机器学习模型的外部参数,它们在学习过程之前设置,不同于模型训练过程中学习的内部参数(例如权重和偏置)。超参数通常包括学习率、批大小、迭代次数等,它们控制学习算法的行为,影响模型的学习效率和泛化能力。

超参数分为两类:

- **数值超参数**:通常是指可以连续取值的参数,如学习率、正则化系数等。

- **离散超参数**:指的是可以取有限固定值的参数,如优化算法类型、激活函数选择等。

### 2.1.2 模型性能指标

评估模型性能的标准包括但不限于准确率、召回率、F1分数、ROC-AUC等。不同的评估指标适用于不同的业务场景,没有绝对的优劣之分,关键在于选择合适的指标来衡量特定问题上模型的表现。

准确率虽然简单易懂,但当数据类别不平衡时,高准确率可能掩盖模型在少数类别的低召回率问题。因此,在实际应用中,根据问题的需求选择合适的性能指标至关重要。

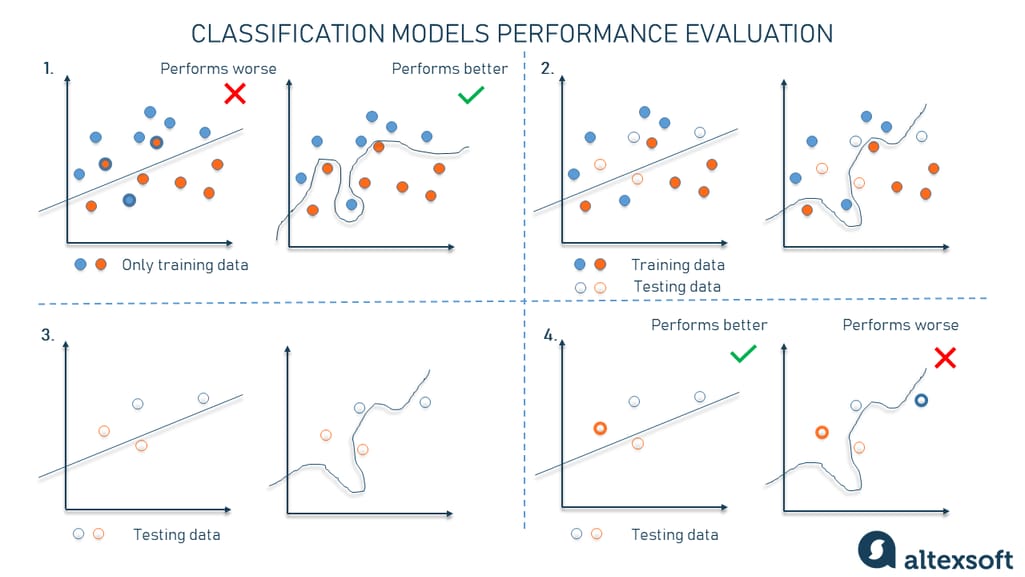

## 2.2 验证集的构建和重要性

### 2.2.1 训练集、验证集和测试集的划分原则

模型训练之前,数据需要被分为训练集、验证集和测试集三部分。这三部分数据用于不同的目的:

- **训练集**:用于训练模型,是模型学习过程中的主要数据源。

- **验证集**:用于调参和模型选择,通过在验证集上的表现来评估和调整超参数。

- **测试集**:用于模型最终评估,用于评估模型在未见过的数据上的泛化能力。

数据划分比例通常为 70%~80% 训练集,10%~15% 验证集,10%~15% 测试集,具体划分方法可以是随机划分,也可以根据时间序列划分等。

### 2.2.2 验证集的作用和优势

验证集的主要作用是为模型提供一个在训练过程中能够评估其性能的标准。通过观察模型在验证集上的表现,研究人员可以判断模型是否出现过拟合或欠拟合,并据此调整模型的超参数。

使用验证集的优势包括:

- **防止过拟合**:通过验证集,可以监控模型对训练数据的过度学习情况。

- **超参数调优**:提供一个相对独立的数据集进行超参数的搜索和选择。

- **客观评估**:提供了一个评估标准,以衡量模型对未知数据的预测能力。

## 2.3 验证策略的类型

### 2.3.1 留出法(Holdout)

留出法是最简单的验证策略,它直接将数据集随机分割为训练集和验证集,这种方法操作简单,但缺点是分割结果的随机性可能导致验证结果不稳定。

### 2.3.2 交叉验证(Cross-Validation)

交叉验证通过将数据集分成 K 个大小相等的互斥子集,每个子集轮流作为验证集,其余作为训练集。这种方法的优点在于可以更充分地利用有限的数据集,提高评估的稳定性和准确性。

### 2.3.3 时间序列分割(Time Series Split)

在时间序列数据上,为了保持数据的时间顺序,通常使用时间序列分割的方法。这种方法保证了数据集被按照时间顺序分割,避免了未来数据影响过去的预测,从而更好地评估模型对时间序列数据的预测性能。

```mermaid

graph TD;

A[数据集] -->|分割| B[训练集]

A -->|分割| C[验证集]

A -->|分割| D[测试集]

B --> E[模型训练]

C --> F[模型评估]

D --> G[模型最终评估]

```

在介绍这些验证策略时,我们需要注意每个策略对于不同类型数据的适用性,以及它们各自的优缺点。理解这些基本概念,对于后续章节中深入探讨超参数优化方法具有基础性的作用。

# 3. 超参数优化方法论

超参数优化是机器学习模型训练过程中的关键步骤。它涉及选择、调整和优化模型参数来达到最佳性能。本章节将探讨不同的优化方法,包括随机搜索与网格搜索、贝叶斯优化、进化算法以及梯度下降法及其变体。

## 3.1 随机搜索与网格搜索

### 3.1.1 随机搜索的原理和应用

随机搜索是一种简单的超参数优化方法。它通过随机选择超参数组合来搜索最优值,而不是像网格搜索那样系统地探索每一组合。这种方法的优势在于能够在较少的尝试次数内探索较宽广的超参数空间,尤其适用于超参数空间庞大且无法全面遍历的情况。

```python

import random

# 示例:随机搜索超参数

def random_search(param_grid, num_trials):

best_score = float('-inf')

best_params = None

for _ in range(num_trials):

# 随机选择超参数

params = {k: random.choice(v) for k, v in param_grid.items()}

score = evaluate_model(params) # 假设此函数根据超参数评价模型性能

if score > best_score:

best_score = score

best_params = params

return best_params

# 假设的超参数网格

param_grid = {

'learning_rate': [0.01, 0.001, 0.0001],

'n_estimators': [100, 200, 300],

'max_depth': [3, 4, 5]

}

# 调用随机搜索函数

best_params = random_search(param_grid, 10)

print(best_params)

```

在上述代码中,`random_search` 函数随机选择超参数组合,并通过`evaluate_model`函数来评估性能,最终返回得到最佳性能的参数组合。注意,在实际应用中,`evaluate_model`需要根据具体问题来实现。

### 3.1.2 网格搜索的原理和应用

与随机搜索不同,网格搜索会穷举预定义的超参数网格中的所有可能组合。这种方法保证了找到的超参数组合是最优的,但当参数数量和每个参数的取值范围增加时,计算成本迅速上升。

```python

from sklearn.model_selection import GridSearchCV

from sklearn.ensemble import RandomForestClassifier

from sklearn.datasets import load_digits

# 加载数据集

digits = load_digits()

X, y = digits.data, digits.target

# 创建模型

rf = RandomForestClassifier()

# 设置超参数网格

param_grid = {

'n_estimators': [100, 200],

'max_depth': [3, 4, 5]

}

# 创建GridSearchCV实例

grid_search = GridSearchCV(estimator=rf, param_grid=param_grid, cv=5)

# 进行网格搜索

grid_search.fit(X, y)

# 输出最优参数

print(grid_search.best_params_)

```

上述代码使用了`GridSearchCV`来对随机森林模型的两个超参数进行网格搜索。在`param_grid`中定义了两个超参数及其取值范围,`GridSearchCV`自动完成模型训练、交叉验证和最优参数选择。

## 3.2 贝叶斯优化和进化算法

### 3.2.1 贝叶斯优化的理论和实践

贝叶斯优化是一种基于概率模型的超参数优化方法。与网格搜索和随机搜索不同,贝叶斯优化通过构建一个概率模型来预测最优超参数,然后在这个预测的基础上选择下一步要评估的超参数,从而有效减少需要评估的超参数组合数。

```python

from skopt import BayesSearchCV

from skopt.space import Real, Categorical, Integer

from sklearn.datasets import load_iris

from sklearn.ensemble import RandomForestClassifier

# 加载数据集

iris = load_iris()

X, y = iris.data, iris.target

# 定义随机森林的超参数空间

rf = RandomForestClassifier()

param_space = {

'n_estimators': Integer(50, 500),

'max_depth': Integer(3, 15),

'min_samples_split': Integer(2, 15),

'learning_rate': Real(0.01, 0.5, 'log-uniform')

}

# 创建贝叶斯搜索实例

bayes_search = BayesSearchCV(rf, param_space, n_iter=32, random_state=1)

# 进行搜索

bayes_search.fit(X, y)

# 输出最优参数

print(bayes_search.best_params_)

```

在此代码段中,使用了`BayesSearchCV`来优化随机森林的四个超参数。贝叶斯优化被用来指定搜索过程,并在给定的迭代次数内找到最佳的超参数。

### 3.2.2 进化算法在超参数优化中的应用

进化算法借鉴了生物进化论的原理,通过模拟自然选择和遗传变异的过程来优化超参数。个体(超参数组合)通过适应度函数(模型性能指标)被评估,并按照优胜劣汰的规则进行选择、交叉和变异操作,最终进化出性能更优的个体。

## 3.3 梯度下降法和其变体

### 3.3.1 梯度下降法的基本原理

梯度下降是一种迭代优化算法,通常用于最小化模型损失函数。其核心思想是沿着损失函数梯度的反方向更新参数,逐渐逼近最优解。

```python

# 示例:梯度下降

```

0

0