【避免过拟合的黄金法则】:机器学习中验证集的正确选择与应用

发布时间: 2024-11-23 07:26:55 阅读量: 43 订阅数: 36

Matlab与机器学习入门 进阶与提高13降维与特征选择.zip

# 1. 机器学习中的过拟合问题

## 简介

过拟合是机器学习模型在训练过程中学习到的数据中噪声和细节的一种现象,导致模型在训练集上表现良好,但在新数据上泛化能力差。

## 过拟合的识别

识别过拟合现象通常需要观察模型在训练数据和验证数据上的表现差异。如果模型在训练集上精度很高而在验证集上却很低,这往往意味着过拟合。

## 过拟合的影响

过拟合会导致模型的性能不稳定,特别是在新数据或者实际应用环境中。解决过拟合问题是提升模型泛化能力的关键所在。

```python

from sklearn.model_selection import train_test_split

from sklearn.metrics import accuracy_score

from sklearn.datasets import load_iris

# 加载数据集

iris = load_iris()

X, y = iris.data, iris.target

# 划分数据集

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.3, random_state=42)

# 模型训练和预测

# ...(此处应有模型训练和预测的代码)

# 模型在训练集和验证集上的表现

train_accuracy = accuracy_score(y_train, predicted_train)

test_accuracy = accuracy_score(y_test, predicted_test)

# 输出模型在两个数据集上的准确率

print(f'Train Accuracy: {train_accuracy}')

print(f'Test Accuracy: {test_accuracy}')

# 如果test_accuracy远低于train_accuracy,则可能存在过拟合问题

```

上例代码中通过scikit-learn库划分数据集并进行模型训练,然后分别计算在训练集和测试集上的准确率,以识别过拟合问题。

# 2. ```

# 第二章:验证集的基本概念和重要性

## 2.1 过拟合与欠拟合的区别

### 2.1.1 过拟合的定义和特点

过拟合是指模型对训练数据拟合程度过高,导致模型对于训练集中的噪声和异常值也进行了学习,从而失去了泛化能力。具体表现为模型在训练集上的性能非常优秀,但在未见过的新数据上的表现却不尽如人意。过拟合的主要特点包括:

- **复杂模型**:使用了过多的特征或者参数,模型过于复杂。

- **数据敏感**:模型对于输入数据的微小变动非常敏感。

- **训练误差低**:在训练数据集上的误差非常低。

- **泛化能力差**:模型在新的数据集上的误差较高。

### 2.1.2 欠拟合的定义和影响

与过拟合相反,欠拟合是指模型对训练数据拟合不足,模型过于简单,无法捕捉数据中的特征和规律。欠拟合通常表现为:

- **简单模型**:模型没有足够的能力来拟合数据。

- **泛化能力差**:模型不仅在训练集上表现不佳,在新数据上表现同样差。

- **性能瓶颈**:增加模型复杂度可能会提升性能,但仅限于一定程度。

- **优化空间大**:可以通过增加更多特征、使用更复杂的模型来改善。

## 2.2 验证集的角色和功能

### 2.2.1 验证集在模型训练中的作用

验证集在机器学习模型的训练过程中扮演着极其重要的角色,主要体现在以下几点:

- **性能评估**:验证集用作评估模型性能的一个中间步骤,帮助我们了解模型在新数据上的泛化能力。

- **超参数优化**:通过验证集可以调整和选择最佳的超参数设置,以避免过拟合或欠拟合。

- **早停法**:在训练过程中使用验证集的性能来决定是否提前停止训练,以防止过拟合。

### 2.2.2 验证集与训练集、测试集的区别

在机器学习模型的评估中,训练集、验证集和测试集各自承担不同的角色:

- **训练集**:用于模型的训练,是模型拟合的主要数据来源。

- **验证集**:用于模型超参数的选择和调整,避免过拟合。

- **测试集**:在模型训练和验证完成后使用,用于评估模型的最终性能。

通常情况下,模型在测试集上的表现最能反映模型在真实世界中的效果。因此,测试集的使用要尽可能的少,以保证其独立性和公正性。下表概括了它们之间的区别:

| 数据类型 | 主要用途 | 目的 |

|---------|---------|-----|

| 训练集 | 拟合模型 | 让模型学习数据的规律和特征 |

| 验证集 | 调整模型 | 选择模型和超参数,防止过拟合 |

| 测试集 | 评估模型 | 最终评估模型在未见数据上的性能 |

在下一节中,我们将深入探讨如何选择合适的验证集策略,以及不同划分方法和交叉验证技术在实际应用中的具体操作步骤。

```

# 3. 选择合适的验证集策略

## 3.1 验证集的划分方法

### 3.1.1 简单随机划分

在机器学习中,简单随机划分是将原始数据集随机分成训练集、验证集和测试集的一种方法。这种方法的特点是每个样本被选入训练集、验证集或测试集的概率是相同的。对于验证集而言,简单随机划分能够帮助我们评估模型在未知数据上的表现,但其随机性也有可能导致划分得到的各个数据子集之间存在较大的方差,从而影响模型性能的评估。

```python

import random

from sklearn.model_selection import train_test_split

# 假设df为一个包含数据和标签的DataFrame

df = ...

# 简单随机划分数据集为训练集、验证集和测试集

train_set, test_set = train_test_split(df, test_size=0.2, random_state=42)

train_set, val_set = train_test_split(train_set, test_size=0.1, random_state=42)

```

在上述代码中,`train_test_split` 函数被用来进行简单的随机划分。参数 `test_size=0.2` 表示测试集占原始数据集的20%,`val_size=0.1` 表示验证集占原始数据集的10%(注意这里省略了验证集的划分,通常我们会先划分出训练集和测试集,然后再在训练集上进一步划分出验证集)。`random_state` 参数保证每次划分都能产生相同的结果,有助于结果的可重复性。

### 3.1.2 分层抽样方法

分层抽样(Stratified Sampling)是一种更为细致的划分方法,它在保证训练集、验证集和测试集比例相同的同时,还保持了各类别在各个集合中所占的比例。特别是在样本类别分布不平衡时,分层抽样特别有用,因为它能确保每个类别在训练过程中都被充分代表。

```python

from sklearn.model_selection import train_test_split

# 分层划分

train_set, test_set = train_test_split(df, test_size=0.2, stratify=df['label'], random_state=42)

train_set, val_set = train_test_split(train_set, test_size=0.1, stratify=train_set['label'], random_state=42)

```

在上面的代码中,`stratify` 参数确保了各个标签在划分后的数据集中保持与原始数据集相同的比例。这种划分方法特别适用于分类问题,其中`df['label']`表示标签列。需要注意的是,在使用分层抽样时,也需要在训练集划分出验证集的步骤中设置 `stratify` 参数,以确保验证集的类别分布也与训练集保持一致。

## 3.2 交叉验证技术

### 3.2.1 K折交叉验证

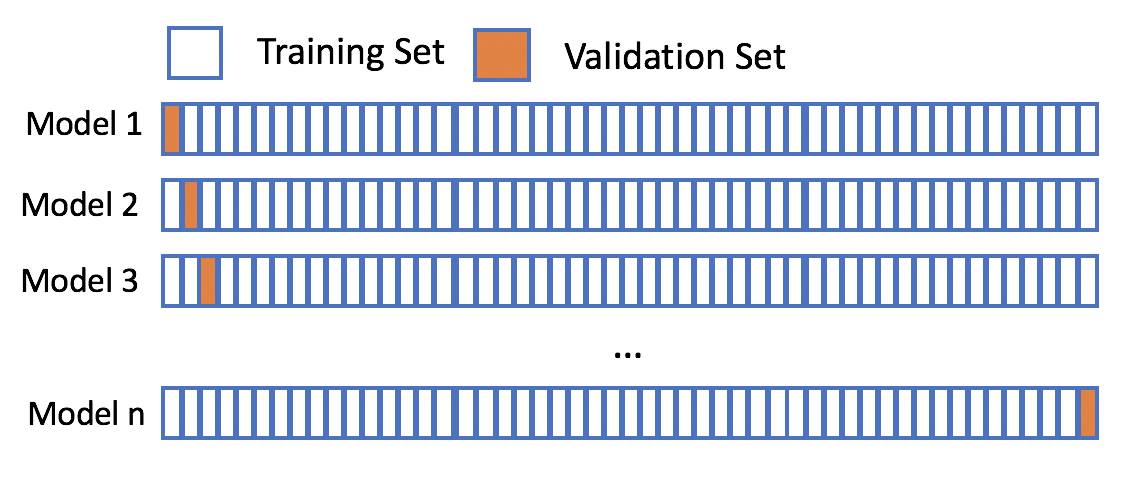

K折交叉验证是通过将整个数据集分成K个大小相似的互斥子集,然后每个子集轮流作为验证集,其余K-1个子集作为训练集的方法。最终模型的性能评估是基于K次训练和验证的平均表现。这种方法能够使模型在不同数据子集上进行多次训练和验证,从而减少模型评估时的方差,提高评估的稳定性。

```python

from sklearn.model_selection import KFold

# K折交叉验证

kf = KFold(n_splits=5, random_state=42, shuffle=True)

for train_index, val_index in kf.split(df):

train_set = df.iloc[train_index]

val_set = df.iloc[val_index]

# 在这里进行模型训练和验证...

```

在上述代码中,`KFold` 类被用来进行K折交叉验证,其中 `n_splits=5` 表示将数据集分为5个子集。`random_state` 参数保证了随机划分的可重复性,而 `shuffle=True` 保证了每次分割前数据的随机化,有助于减少偶然性导致的误差。循环体内部应当包含模型的训练与验证过程。

### 3.2.2 留一法和留P法

留一法(Leave-One-Out, LOO)和留P法(Leave-P-Out, LPO)是K折交叉验证的特例。留一法是指每次只留一个样本作为验证集,其余所有样本作为训练集。留P法则是每次留P个样本作为验证集。这两种方法在小数据集上十分有用,但计算成本相对较高,因此不适用于大数据集。

```python

from sklearn.model_selection import LeaveOneOut, LeavePOut

# 留一法

loo = LeaveOneOut()

for train_index, val_index in loo.split(df):

train_set = df.iloc[train_index]

val_set = df.iloc[val_index]

# 在这里进行模型训练和验证...

# 留P法

lpo = LeavePOut(p=10)

for train_index, val_index in lpo.split(df):

train_set = df.iloc[train_index]

val_set = df.iloc[val_index]

# 在这里进行模型训练和验证...

```

在上述代码中,`LeaveOneOut` 和 `LeavePOut` 类分别用于实现留一法和留P法。由于留一法每次划分只留下一个样本,因此其循环次数等于样本总数。留P法则需要指定P的大小,它会根据P值的不同进行相应次数的训练和验证。

### 3.2.3 分组交叉验证

分组交叉验证(Grouped Cross-Validation)通常用于那些数据之间存在组内相关性的情况,如时间序列数据或来自不同受试者的生物医学数据。在这种情况下,需要保证数据的分组特性在划分过程中得到保留,防止将相关性高的样本分到不同的子集中。

```python

from sklearn.model_selection import GroupKFold

# 假设每个样本都有一个group_id表示其分组信息

groups = df['group_id'].values

# 分组交叉验证

gkf = GroupKFold(n_splits=5)

for train_index, val_index in gkf.split(df, groups=groups):

train_set = df.iloc[train_index]

val_set = df.iloc[val_index]

# 在这里进行模型训练和验证...

```

在上述代码中,`GroupKFold` 类用来实现分组交叉验证,其中 `groups` 数组保存了每个样本的分组信息。在划分数据集时,`GroupKFold` 确保同一组内的样本不会被分配到训练集和验证集的不同部分,从而保持数据的分组特性。

## 3.3 验证集大小的影响

### 3.3.1 验证集大小与模型性能的关系

验证集的大小会直接影响到模型性能的估计。如果验证集太小,模型可能无法得到充分的验证,从而导致性能评估的不确定性增加。反之,如果验证集太大,可能会导致用于训练模型的数据减少,影响模型的训练效果。

表1展示了在不同大小验证集下,模型性能评估可能出现的情况。

| 验证集大小 | 模型性能评估 | 优点 | 缺点 |

|------------|--------------|------------------------|---------------------------|

| 非常小 | 不稳定 | 计算资源需求少 | 不准确,高方差 |

| 小 | 可接受 | 近似反映模型泛化能力 | 方差较大,可能欠拟合 |

| 中等 | 稳定 | 泛化能力评估较好 | 可能造成过拟合 |

| 大 | 非常稳定 | 非常接近真实性能评估 | 训练数据减少,可能欠拟合 |

### 3.3.2 如何确定合适的验证集大小

确定合适的验证集大小往往需要在资源可用性和评估准确性之间寻找平衡。常用的一些启发式规则包括:

1. 使用简单的随机划分,验证集的大小设置为总数据量的10%至30%。

2. 对于拥有大量数据的情况,可以使用K折交叉验证,其中K的值为5至10。

3. 对于小数据集,可以使用留一法或留P法。

使用这些规则时,应考虑到特定应用的要求和数据的特性。例如,在某些对性能要求非常高的场景中,可能需要调整验证集的大小以获得更为可靠的性能评估。

综上所述,验证集大小的选择需要根据实际问题、数据集的大小和特性以及模型的复杂度来综合考虑,确保在保证评估准确性和稳定性的前提下,最小化资源的消耗。

# 4. 验证集的实践应用和案例分析

在机器学习和深度学习模型训练中,验证集的应用对于模型性能的提升有着至关重要的作用。本章节将详细探讨验证集在实际操作中的应用方法,以及通过案例分析来加深对验证集使用方法的理解。

## 4.1 实践中的验证集应用

### 4.1.1 数据预处理和特征选择

在利用验证集进行模型训练前,数据预处理和特征选择是不可或缺的步骤。高质量的训练数据能有效减少过拟合的风险,而合适的特征选择可以提高模型的泛化能力。

- **数据预处理**:对数据进行清洗、标准化、归一化等操作,减少数据中的噪声和异常值。

- **特征选择**:使用统计测试、模型选择、正则化等方法识别对预测任务最有用的特征。

**代码块示例**:

```python

from sklearn.preprocessing import StandardScaler

from sklearn.feature_selection import SelectKBest, f_classif

# 假设X是特征矩阵,y是标签

scaler = StandardScaler()

X_scaled = scaler.fit_transform(X)

# 使用卡方检验选择前K个最佳特征

selector = SelectKBest(score_func=f_classif, k=10)

X_selected = selector.fit_transform(X_scaled, y)

```

在上述代码中,`StandardScaler`用于标准化数据,`SelectKBest`结合`f_classif`用于选择最重要的特征。通过预处理和特征选择,数据集变得更适合模型训练。

### 4.1.2 超参数调优和模型选择

模型性能往往受到超参数设置的影响。为了找到最优的模型配置,通常需要借助验证集进行超参数的调优。

- **超参数调优**:使用网格搜索、随机搜索、贝叶斯优化等方法寻找最优超参数。

- **模型选择**:比较不同模型在验证集上的性能,选择最佳模型。

**代码块示例**:

```python

from sklearn.model_selection import GridSearchCV

from sklearn.ensemble import RandomForestClassifier

# 设置超参数网格

param_grid = {

'n_estimators': [100, 200, 300],

'max_depth': [None, 10, 20, 30],

}

# 使用随机森林分类器和网格搜索

rf = RandomForestClassifier(random_state=42)

grid_search = GridSearchCV(estimator=rf, param_grid=param_grid, cv=5)

grid_search.fit(X_selected, y)

# 输出最佳参数和分数

print("Best parameters: ", grid_search.best_params_)

print("Best cross-validation score: ", grid_search.best_score_)

```

在上述代码中,使用`GridSearchCV`对随机森林分类器的两个超参数进行网格搜索,利用交叉验证来评估不同参数组合的效果,最终找到性能最优的模型。

## 4.2 验证集应用案例研究

### 4.2.1 图像识别项目的验证集应用

在图像识别项目中,验证集用于评估模型在未知图像上的表现至关重要。常见的任务包括图像分类、目标检测等。

- **验证集划分**:从大规模图像数据集中划分出一部分作为验证集,通常按比例进行,比如10%的数据用于验证。

- **模型性能评估**:使用准确率、召回率、F1分数等指标来评估模型在验证集上的性能。

**示例**:

假设有一个猫狗分类问题,我们按照7:2:1的比例将数据集分为训练集、验证集和测试集。使用卷积神经网络(CNN)进行分类,并通过验证集调整网络结构和超参数。

### 4.2.2 自然语言处理项目的验证集应用

在自然语言处理(NLP)项目中,验证集的应用同样重要。比如,在情感分析、机器翻译、文本分类等任务中,验证集用于监控模型的泛化能力。

- **文本数据预处理**:进行分词、去除停用词、词干提取等。

- **模型训练与评估**:使用验证集来调整模型结构、训练策略、超参数,并评估模型在未见数据上的表现。

**示例**:

在文本分类任务中,我们可能使用TF-IDF向量化方法处理文本数据,然后利用支持向量机(SVM)或深度学习模型进行训练。在模型训练过程中,使用验证集监控模型的准确率,根据需要调整模型或超参数,以达到更好的泛化效果。

通过实践中的应用和案例研究,我们可以看到验证集是如何在不同类型的机器学习项目中发挥作用的。下一章节,我们将探讨高级验证集策略以及未来在该领域的发展趋势。

# 5. 高级验证集策略与未来趋势

## 5.1 验证集在深度学习中的应用

### 5.1.1 深度学习中的验证集挑战

在深度学习模型的训练过程中,由于模型的复杂性和高参数性,验证集的选择和应用面临着一些独特的挑战。深度学习模型通常需要大量的数据和计算资源,这使得数据的划分更加敏感。例如,在深度学习任务中,如果验证集选择不当,可能会导致模型训练不够稳定,甚至出现泛化能力差的问题。

另一个挑战是过拟合。深度学习模型容易在训练数据上学习到过多的噪声,而不是底层的真实规律,特别是在数据量有限的情况下。因此,需要精心设计验证集来监测和防止过拟合现象的发生。

### 5.1.2 深度学习的验证集优化技术

为了应对这些挑战,研究人员和工程师们开发了多种验证集优化技术。一种常见的技术是早停法(Early Stopping),它通过在验证集上的性能指标来动态决定何时停止模型的训练。这可以防止模型在训练集上过度训练,并有助于提高模型的泛化能力。

此外,正则化技术(如L1、L2正则化)和Dropout技术也在深度学习中被广泛应用,这些技术通过在模型中引入某种形式的约束或随机性,帮助减少过拟合现象,提高模型在验证集上的表现。

## 5.2 验证集研究的新进展

### 5.2.1 最新验证集策略的研究动态

近年来,验证集策略的研究已取得了一些新的进展。例如,研究者们提出了基于学习率调整的验证集策略,利用验证集上的性能变化来自动调整学习率,从而提高模型的训练效率和最终性能。

此外,还有一些研究专注于如何更好地平衡验证集和训练集的大小。在某些情况下,过大的验证集可能会减少训练数据的规模,影响模型的训练效果;过小的验证集则无法提供有效的性能反馈。因此,如何确定最佳的验证集大小和分配比例,已成为模型选择和优化中的一个研究热点。

### 5.2.2 验证集未来的研究方向和展望

展望未来,验证集的研究可能会朝以下几个方向发展:

- **自适应验证集策略**:研究能够根据数据特性和模型表现动态调整验证集的方法,以更精准地评估模型性能。

- **多任务学习中的验证集**:在多任务学习场景下,如何设计有效的验证集来同时评估和优化多个任务的模型性能。

- **不确定性量化**:利用验证集来量化模型预测的不确定性,为模型部署和决策提供更多的信息支持。

- **小数据学习**:在数据稀缺的情况下,研究如何设计和利用验证集来提升模型的泛化能力。

综上所述,验证集作为一种重要的模型评估工具,在机器学习和深度学习领域中将继续扮演着关键角色。随着技术的发展,我们可以期待更先进的验证集策略来提升模型的性能和泛化能力。

0

0