注意力机制实战:自然语言生成

发布时间: 2024-05-02 13:17:01 阅读量: 80 订阅数: 51

白色卡通风格响应式游戏应用商店企业网站模板.zip

# 1. 注意力机制简介**

注意力机制是一种神经网络技术,它允许模型专注于输入数据的特定部分。在自然语言处理 (NLP) 中,注意力机制使模型能够识别和加权输入序列中的重要元素,从而提高理解和生成能力。

# 2. 注意力机制在自然语言生成中的理论基础

### 2.1 注意力机制的原理和类型

**原理:**

注意力机制是一种神经网络技术,它允许模型专注于输入序列中与当前任务最相关的部分。它通过分配权重来实现,权重表示每个输入元素对输出的重要性。

**类型:**

* **加性注意力:**将输入元素的权重相加,得到一个上下文向量。

* **点积注意力:**计算输入元素和查询向量的点积,得到一个权重向量。

* **缩放点积注意力:**在点积注意力基础上,对权重向量进行缩放,以增强权重差异。

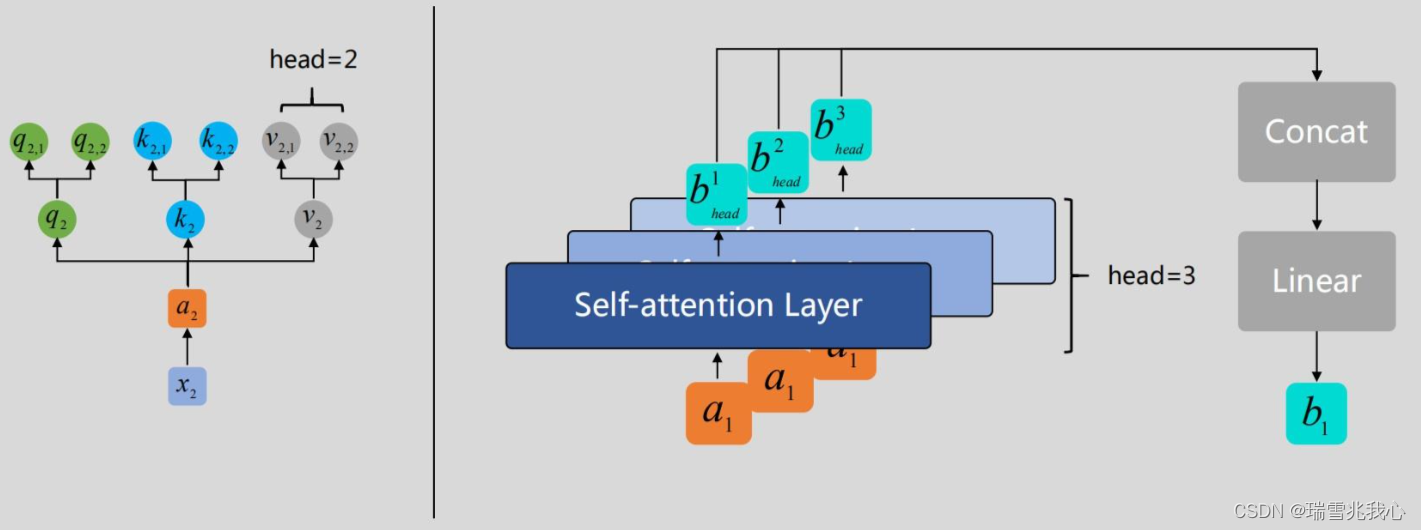

* **多头注意力:**使用多个注意力头并行计算,每个头专注于输入的不同方面。

### 2.2 注意力机制在自然语言生成中的作用

注意力机制在自然语言生成中发挥着至关重要的作用:

* **捕捉长期依赖关系:**注意力机制允许模型跨越长距离捕捉输入序列中的相关信息,解决传统神经网络的依赖关系有限问题。

* **增强语义理解:**通过分配权重,注意力机制帮助模型理解输入序列中单词和短语的相对重要性,从而提高语义理解。

* **生成连贯文本:**注意力机制使模型能够关注先前生成的单词,从而生成连贯且语义合理的文本。

**代码示例:**

```python

import torch

import torch.nn as nn

class Attention(nn.Module):

def __init__(self, query_dim, key_dim, value_dim, num_heads=1):

super(Attention, self).__init__()

self.query_proj = nn.Linear(query_dim, key_dim)

self.key_proj = nn.Linear(key_dim, key_dim)

self.value_proj = nn.Linear(value_dim, value_dim)

self.num_heads = num_heads

def forward(self, query, key, value):

# Project the query, key, and value vectors

query = self.query_proj(query)

key = self.key_proj(key)

value = self.value_proj(value)

# Calculate the attention weights

weights = torch.matmul(query, key.transpose(1, 2)) / math.sqrt(key.size(2))

weights = torch.softmax(weights, dim=-1)

# Calculate the context vector

context = torch.matmul(weights, value)

return context

```

**逻辑分析:**

* `query_proj`、`key_proj`、`value_proj`分别将查询、键、值向量投影到统一维度。

* `weights`计算查询和键向量的点积,并进行softmax归一化,得到注意力权重。

* `context`通过权重加权和值向量,得到上下文向量。

# 3. 注意力机制在自然语言生成中的实践应用

注意力机制在自然语言生成(NLG)领域中有着广泛的应用,它能够显著提升 NLG 模型的性能。本章将重点介绍注意力机制在 NLG 中的三大实践应用:语言模型、文本摘要和机器翻译。

### 3.1 基于注意力机制的语言模型

语言模型是 NLG 的基础,它能够预测给定文本序列中的下一个单词。注意力机制可以显著提升语言模型的性能,因为它允许模型专注于输入序列中与预测相关的信息。

**BERT(双向编码器表示模型)**是基于注意力机制的语言模型的典型代表。BERT 通过使用多层 Transformer 编码器对输入文本进行编码,其中每个编码器都包含一个自注意力层。自注意力层允许模型关注输入序列中的不同部分,并学习它们之间的关系。这使得 BERT 能够捕获文本中的上下文信息,并生成更连贯、更流畅的文本。

```python

import transformers

# 创建一个 BERT 模型

model = transformers.AutoModelForMaskedLM.from_pretrained("bert-base-uncased")

# 输入文本序列

inp

```

0

0