序列到序列模型中的注意力机制应用

发布时间: 2024-05-02 13:20:20 阅读量: 76 订阅数: 45

# 2.1 注意力机制的原理和类型

### 2.1.1 注意力机制的定义和作用

注意力机制是一种神经网络技术,它允许模型专注于输入序列中特定部分的信息。它模拟了人类在阅读或聆听时,将注意力集中在文本或声音中特定部分的能力。在序列到序列模型中,注意力机制允许编码器和解码器在生成输出时关注输入序列中的相关部分。

### 2.1.2 常见的注意力机制类型

有几种常见的注意力机制类型,包括:

- **加性注意力:**将输入序列中每个元素的权重相加,得到一个上下文向量。

- **点积注意力:**计算输入序列中每个元素与查询向量的点积,得到一个权重向量。

- **缩放点积注意力:**类似于点积注意力,但在计算点积之前对输入序列进行缩放。

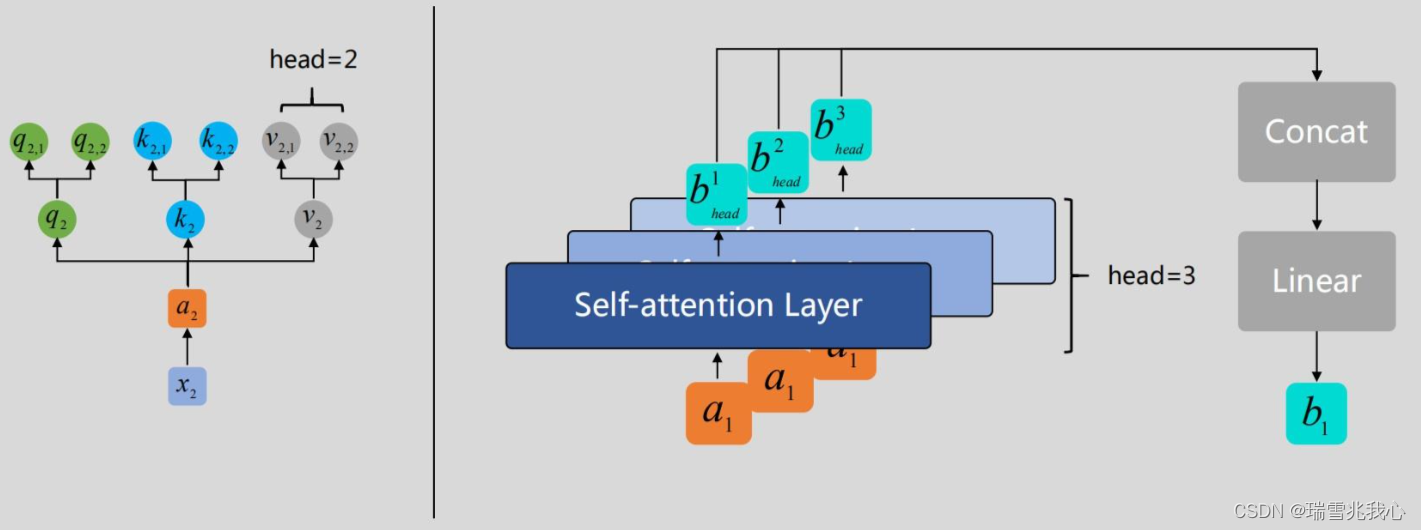

- **多头注意力:**使用多个注意力头并对结果进行拼接,以获得更丰富的表示。

# 2. 注意力机制理论

### 2.1 注意力机制的原理和类型

#### 2.1.1 注意力机制的定义和作用

注意力机制是一种神经网络技术,它允许模型关注输入序列中的特定部分。在序列到序列模型中,注意力机制通过计算一个权重向量来分配给输入序列中的每个元素。这个权重向量表示了模型对每个元素重要性的估计。

注意力机制的主要作用是:

- **选择性关注:**允许模型专注于输入序列中与当前输出相关的部分。

- **信息聚合:**将输入序列中相关元素的信息聚合到一起,用于生成输出。

- **长期依赖性建模:**通过允许模型访问输入序列中的任何位置,有助于建模序列中的长期依赖性。

#### 2.1.2 常见的注意力机制类型

有许多不同的注意力机制类型,每种类型都有其独特的优势和劣势。最常见的注意力机制类型包括:

- **加性注意力:**将输入序列中每个元素的权重相加,得到一个单一的权重向量。

- **点积注意力:**计算输入序列中每个元素与查询向量的点积,得到权重向量。

- **缩放点积注意力:**与点积注意力类似,但对点积结果进行缩放,以防止梯度消失。

- **多头注意力:**使用多个注意力头并行计算权重向量,然后将结果连接起来。

### 2.2 注意力机制在序列到序列模型中的应用

#### 2.2.1 注意力机制在编码器和解码器中的作用

在序列到序列模型中,注意力机制通常用于编码器和解码器组件。

- **编码器:**注意力机制允许编码器关注输入序列中与当前输出相关的部分,并生成一个包含这些相关信息的信息向量。

- **解码器:**注意力机制允许解码器在生成输出序列时访问编码器生成的的信息向量。这有助于解码器生成与输入序列相关的、连贯的输出。

#### 2.2.2 注意力机制的训练和优化

注意力机制的训练和优化通常涉及以下步骤:

- **计算权重向量:**使用所选的注意力机制类型计算输入序列中每个元素的权重向量。

- **加权求和:**将输入序列中每个元素乘以其相应的权重,然后将结果相加,得到一个信息向量。

- **反向传播:**使用反向传播算法计算注意力机制中参数的梯度。

- **优化:**使用优化算法(如 Adam 或 RMSProp)更新注意力机制的参数,以最小化损失函数。

# 3. 注意力机制实践应用

### 3.1 基于注意力机制的机器翻译

**3.1.1 注意力机制在机器翻译中的优势**

注意力机制在机器翻译中具有以下优势:

- **捕捉源语言和目标语言之间的语义联系:**注意力机制允许模型关注源语言中与当前目标语言输出最相关的部分,从而提高翻译质量。

- **解决长序列翻译问题:**传统的机器翻译模型在处理长序列时容易出现信息丢失和误译。注意力机制通过允许模型动态关注源语言的不同部分,缓解了这一问题。

- **提高翻译流畅性:**注意力机制使模型能够考虑源语言的上下文信息,从而生成更流畅、更自然的翻译结果。

**3.1.2 基于注意力机制的机器翻译模型**

基于注意力机制的机器翻译模型通常采用编码器-解码器架构:

- **编码器:**将源语言序列编码为一个固定长度的向量。

- **解码器:**根据编码器的输出,逐个生成目标语言序列。

- **注意力机制:**在解码过程中,注意力机制计算源语言和目标语言之间的对齐,并使用对齐信息加权编码器的输出,以生成更准确的翻译。

### 3.2 基于注意力机制的问答系统

**3.2.1 注意力机制在问答系统中的作用**

注意力机制在问答系统中发挥着以下作用:

- **识别问题中关键信息:**注意力机制帮助模型关注问题中与答案最相关的部分,从而提高问答的准确性。

- **定位文档中相关段落:**在文档检索阶段,注意力机制允许模型关注文档中与问题最相关的段落,提高检索效率。

- **生成准确的答案:**在答案生成阶段,注意力机制使模型能够根据问题和相关段落,生成更准确、更全面的答案。

**3.2.2 基于注意力机制的问答系统模型**

基于注意力机制的问答系统模型通常采用以下流程:

- **问题编码:**将问题编码为一个固定长度的向量。

- **文档检索:**使用注意力机制计算问题与文档中段落的相似度,并检索最相关的段落。

- **答案生成:**使用注意力机制加权相关段落,并根据加权后的段落生成答案。

# 4. 注意力机制进阶应用

### 4.1 注意力机制在文本摘要中的应用

**4.1.1 注意力机制在文本摘要中的作用**

在文本摘要任务中,注意力机制发挥着至关重要的作用。它允许模型专注于源文本中与摘要相关的关键部分。通过对源文本中不同单词的权重进行建模,注意力机制能够识别出最重要的信息,并将其纳入到摘要中。

**4.1.2 基于注意力机制的文本摘要模型**

基于注意力机制的文本摘要模型通常采用编码器-解码器架构。编码器负责将源文本转换为一个固定长度的向量,而解码器则利用注意力机制来生成摘要。

一个典型的基于注意力机制的文本摘要模型如下:

```python

import torch

import torch.nn as nn

class Attention(nn.Module):

def __init__(self, hidden_size):

super(Attention, self).__init__()

self.hidden_size = hidden_size

self.W = nn.Linear(hidden_size, hidden_size)

self.v = nn.Linear(hidden_size, 1)

def forward(self, query, key, value):

# query: (batch_size, query_len, hidde

```

0

0