BERT模型中的注意力机制详解

发布时间: 2024-05-02 13:15:28 阅读量: 123 订阅数: 51

注意力机制

# 2.1 注意力机制的定义和分类

### 2.1.1 软性注意力和硬性注意力

**软性注意力**:将输入序列中的每个元素赋予一个权重,权重值在 0 到 1 之间,表示该元素对输出的影响程度。

**硬性注意力**:将输入序列中的一个元素选择为输出,并忽略其他元素。

### 2.1.2 自注意力和异注意力

**自注意力**:关注输入序列本身,计算序列中每个元素与自身其他元素之间的相关性。

**异注意力**:关注两个不同的输入序列,计算两个序列中元素之间的相关性。

# 2. 注意力机制理论基础

### 2.1 注意力机制的定义和分类

注意力机制是一种神经网络技术,它允许模型选择性地关注输入数据的特定部分。这类似于人类在阅读文本或观察图像时如何将注意力集中在相关信息上。

#### 2.1.1 软性注意力和硬性注意力

* **软性注意力:**生成一个概率分布,表示每个输入元素的重要性。这允许模型对输入进行加权,并根据其重要性对它们进行不同程度的处理。

* **硬性注意力:**选择输入中最重要的元素,并仅关注该元素。这类似于人类在阅读文本时如何突出显示或圈出关键单词。

#### 2.1.2 自注意力和异注意力

* **自注意力:**模型关注输入中的不同元素之间的关系。这允许模型捕获输入中不同部分之间的依赖性。

* **异注意力:**模型关注来自不同输入源的元素之间的关系。这允许模型在不同的输入之间建立联系,例如文本和图像。

### 2.2 注意力机制的数学原理

注意力机制的数学原理基于以下步骤:

1. **查询(Q):**将输入表示为一个查询向量。

2. **键(K):**将输入表示为一个键向量。

3. **值(V):**将输入表示为一个值向量。

4. **注意力权重:**计算查询和键向量之间的相似性,得到一个注意力权重矩阵。

5. **加权和:**将注意力权重与值向量相乘,得到一个加权和,表示模型关注的输入部分。

### 2.2.1 点积注意力

点积注意力是计算注意力权重最简单的方法。它计算查询和键向量的点积,如下所示:

```python

attention_weights = torch.matmul(Q, K.transpose(1, 2))

```

### 2.2.2 加性注意力

加性注意力通过将查询和键向量投影到一个较小的维度,然后计算点积来计算注意力权重。这允许模型学习更复杂的注意力模式。

```python

Q_proj = torch.matmul(Q, W_Q)

K_proj = torch.matmul(K, W_K)

attention_weights = torch.matmul(Q_proj, K_proj.transpose(1, 2))

```

### 2.2.3 乘性注意力

乘性注意力通过将查询和键向量逐元素相乘来计算注意力权重。这允许模型学习非线性注意力模式。

```python

attention_weights = torch.matmul(Q, K.transpose(1, 2))

attention_weights = torch.softmax(attention_weights, dim=-1)

```

# 3.1 BERT模型的架构和原理

#### 3.1.1 Transformer编码器

BERT模型基于Transformer编码器架构,该架构由编码器堆叠组成,每个编码器包含两个子层:自注意力层和前馈神经网络层。

**自注意力层:**

自注意力层计算输入序列中每个元素与其他所有元素之间的关联程度。它通过以下步骤实现:

```python

def scaled_dot_product_attention(query, key, value, mask=None):

"""Scaled dot-product attention.

Args:

query: Queries for attention. [batch_size, seq_len, d_k]

key: Keys for attention. [batch_size, seq_len, d_k]

value: Values for attention. [batch_size, seq_len, d_v]

mask: Mask for attention. [batch_size, seq_len]

Returns:

Output of attention. [batch_size, seq_len, d_v]

"""

d_k = query.shape[-1]

scores = tf.matmul(query, key, transpose_b=True) / tf.sqrt(tf.cast(d_k, tf.float32))

if mask is not None:

scores += (1.0 - mask) * -1e9

weights = tf.nn.softmax(scores)

output = tf.matmul(weights, value)

return output

```

**逻辑分析:**

* `scaled_dot_product_attention`函数计算查询(`query`)、键(`key`)和值(`value`)之间的点积注意力。

* `d_k`是键的维度。

* 点积结果除以`d_k`的平方根进行缩放,以防止梯度消失。

* 如果存在掩码(`mask`),则将掩码应用于分数,以屏蔽填充令牌。

* 使用softmax函数对分数进行归一化,生成注意力权重。

* 最后,将注意力权重与值相乘,得到注意力输出。

**前馈神经网络层:**

前馈神经网络层是一个简单的多层感知器(MLP),它对自注意力层的输出进行非线性变换。

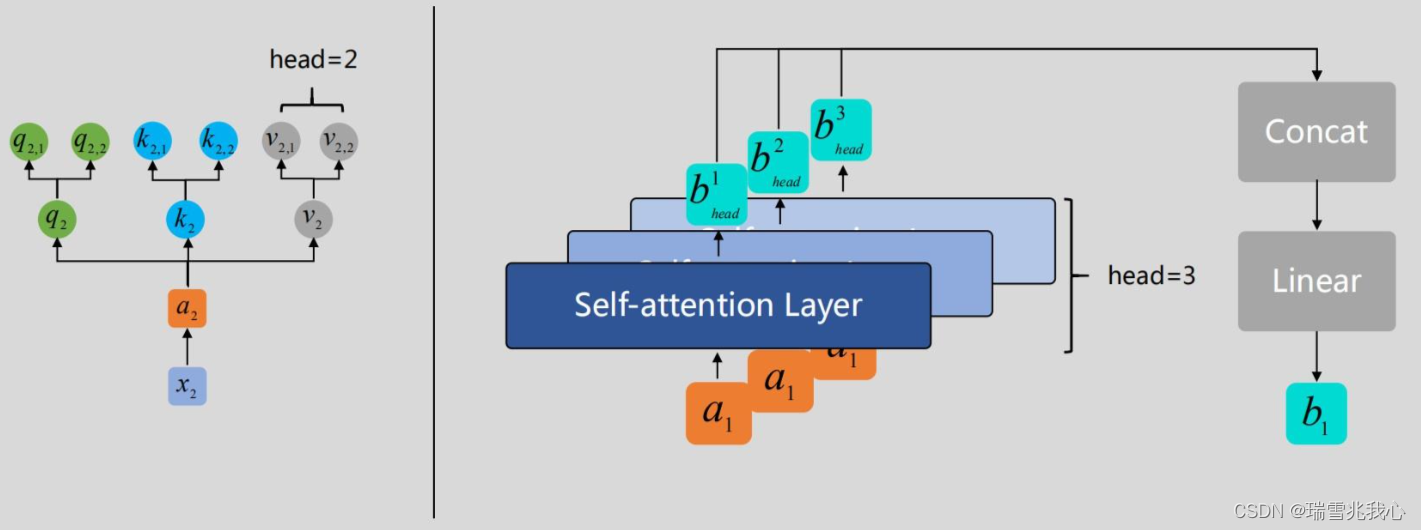

#### 3.1.2 多头自注意力

BERT模型使用多头自注意力机制,它将自注意力层并行执行多次,每个头关注输入序列的不同子空间。

```python

def multi_head_attention(query, key, value, num_heads, d_model):

"""Multi-head attention.

Args:

query: Queries for attention. [batch_size, seq_len, d_model]

key: Keys for attention. [batch_size, seq_len, d_model]

value: Values for attention. [batch_size, seq_len, d_model]

num_heads: Number of attention heads.

d_model: Dimension of the model.

Returns:

Output of attention. [batch_size, seq_len, d_model]

"""

d_head = d_model // num_heads

query = tf.reshape(query, [batch_size, seq_len, num_heads, d_head])

key = tf.reshape(key, [batch_size, seq_len, num_heads, d_head])

value = tf.reshape(value, [batch_size, seq_len, num_heads, d_head])

outputs = []

for i in range(num_heads):

outputs.append(scaled_dot_product_attention(query[:, :, i, :], key[:, :, i, :], value[:, :, i, :]))

output = tf.concat(outputs, axis=-1)

output = tf.reshape(output, [batch_size, seq_len, d_model])

return output

```

**逻辑分析:**

* `multi_head_attention`函数将查询、键和值投影到多个头。

* 每个头都有自己的查询、键和值矩阵。

* 每个头计算自注意力,然后将结果连接起来。

* 最后,连接的结果投影回原始维度。

# 4. 注意力机制在BERT模型中的应用

### 4.1 文本分类任务中的注意力机制

#### 4.1.1 文本分类的原理和挑战

文本分类是指将文本数据分配到预定义类别中的任务。它在自然语言处理中至关重要,用于情感分析、垃圾邮件检测和主题建模等应用。

文本分类的挑战在于,文本数据通常具有高维和稀疏性,并且类别之间可能存在重叠。因此,需要强大的模型来捕获文本中的关键特征并区分不同类别。

#### 4.1.2 BERT模型在文本分类中的应用

BERT模型通过其强大的注意力机制,在文本分类任务中取得了显著的成功。BERT通过使用多头自注意力层来捕获文本中的长期依赖关系和局部交互。

BERT模型的文本分类过程如下:

1. **文本预处理:**将文本转换为数字化的形式,例如词嵌入。

2. **BERT编码:**将预处理后的文本输入到BERT模型中,通过多头自注意力层进行编码。

3. **池化:**对编码后的文本进行池化操作,生成一个固定长度的向量表示。

4. **分类:**将池化后的向量输入到分类器中,预测文本的类别。

### 4.2 问答任务中的注意力机制

#### 4.2.1 问答任务的类型和难点

问答任务是指从文本中提取特定信息的任务。它分为两种主要类型:

* **事实问答:**从文本中提取明确的事实信息。

* **开放域问答:**从文本中提取更复杂的答案,可能需要推理和常识。

问答任务的难点在于,需要模型理解文本的语义,并根据问题准确提取相关信息。

#### 4.2.2 BERT模型在问答任务中的应用

BERT模型通过其注意力机制,在问答任务中表现出色。BERT可以关注问题和文本之间的相关部分,并提取与问题相关的答案。

BERT模型的问答过程如下:

1. **问题和文本编码:**将问题和文本分别输入到BERT模型中,通过多头自注意力层进行编码。

2. **注意力机制:**计算问题编码和文本编码之间的注意力权重,突出与问题相关的文本部分。

3. **答案提取:**根据注意力权重,从文本中提取答案。

4. **答案生成:**将提取的答案生成自然语言形式。

# 5. 注意力机制在BERT模型中的优化和发展

### 5.1 注意力机制的变体和改进

为了提升注意力机制的性能,研究人员提出了多种变体和改进方法:

- **层次注意力:**将注意力机制应用于不同层次的文本表示,例如词嵌入、句向量和段落向量,实现多粒度信息提取。

- **交互式注意力:**允许注意力机制在不同层级或不同时间步之间交互,增强不同表示之间的信息交换。

### 5.2 注意力机制在BERT模型中的未来发展

注意力机制在BERT模型中的应用仍在不断探索和发展,未来主要关注以下方向:

- **可解释性增强:**增强注意力机制的可解释性,理解模型如何利用注意力信息进行决策。

- **效率优化:**优化注意力机制的计算效率,使其适用于更大规模的文本处理任务。

**代码示例:**

```python

# 层次注意力

def hierarchical_attention(word_embeddings, sentence_embeddings):

word_attn_weights = tf.nn.softmax(tf.matmul(word_embeddings, tf.transpose(word_embeddings)))

sentence_attn_weights = tf.nn.softmax(tf.matmul(sentence_embeddings, tf.transpose(sentence_embeddings)))

return tf.matmul(word_attn_weights, word_embeddings), tf.matmul(sentence_attn_weights, sentence_embeddings)

# 交互式注意力

def interactive_attention(query, key, value):

attn_weights = tf.nn.softmax(tf.matmul(query, tf.transpose(key)))

context = tf.matmul(attn_weights, value)

return context

```

0

0