Java算法大数据处理:算法在海量数据中的神奇作用

发布时间: 2024-08-28 03:15:24 阅读量: 43 订阅数: 31

# 1. 大数据处理概述**

大数据处理涉及管理和分析海量、复杂且多样化的数据集。这些数据集通常超过传统数据库管理系统的容量和处理能力。大数据处理的目的是从这些庞大数据集提取有价值的见解,从而支持数据驱动的决策和业务优化。

大数据处理面临着各种挑战,包括数据量大、数据类型多样、处理速度要求高以及数据安全和隐私问题。为了应对这些挑战,已经开发了各种技术和框架,例如 Hadoop、Spark 和 NoSQL 数据库。这些技术使组织能够有效地存储、处理和分析大数据,从而释放其潜力。

# 2. Java算法在海量数据处理中的应用**

**2.1 Java算法的分类和选择**

Java算法广泛应用于海量数据处理中,根据算法的特性和应用场景,可分为以下几类:

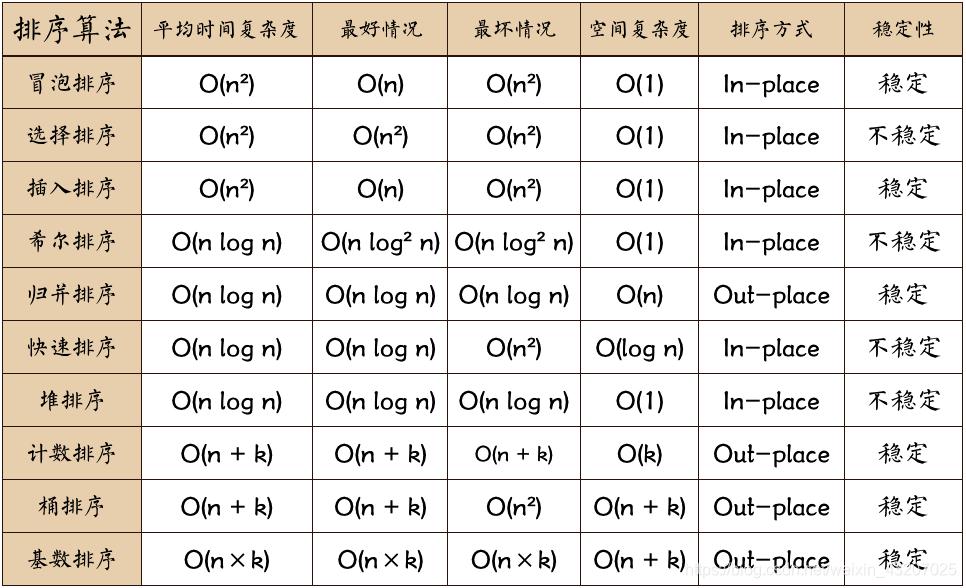

* **排序算法:**快速排序、归并排序、堆排序等,用于对海量数据进行排序。

* **搜索算法:**二分查找、哈希表查找等,用于在海量数据中快速查找特定元素。

* **数据结构:**链表、树、图等,用于组织和存储海量数据,提高数据访问效率。

* **并行算法:**多线程、分布式算法等,用于将计算任务并行化,提高数据处理速度。

* **机器学习算法:**决策树、支持向量机、神经网络等,用于从海量数据中提取知识和模式。

算法的选择应根据数据规模、处理需求和系统资源等因素综合考虑。例如,对于海量数据排序,快速排序或归并排序是不错的选择;对于海量数据查找,哈希表查找效率更高。

**2.2 分布式算法和并行处理**

海量数据处理往往涉及到分布式系统和并行处理技术。分布式算法将计算任务分配到多个节点上并行执行,提高处理效率。常用的分布式算法包括:

* **MapReduce:**将数据处理任务拆分为Map和Reduce两个阶段,并行执行。

* **Spark:**基于内存计算的分布式计算框架,提供丰富的API和优化机制。

* **Flink:**流式数据处理框架,支持实时数据分析和处理。

并行处理技术通过多线程或多进程的方式,将计算任务并行化。Java中提供了丰富的多线程和并行编程API,例如:

```java

// 创建一个多线程任务

ExecutorService executorService = Executors.newFixedThreadPool(4);

executorService.submit(() -> {

// 执行任务

});

```

**2.3 算法优化和性能提升**

算法优化是提升海量数据处理性能的关键。常见的优化方法包括:

* **数据结构优化:**选择合适的数据结构,如使用哈希表代替线性表提高查找效率。

* **算法选择优化:**根据数据规模和处理需求选择最合适的算法,如对于海量数据排序,使用快速排序或归并排序。

* **并行化优化:**将算法并行化,充分利用多核CPU或分布式系统资源。

* **代码优化:**优化代码结构、减少不必要的计算,提高代码执行效率。

通过算法优化,可以显著提升海量数据处理性能,满足实时性和高吞吐量的数据处理需求。

# 3. 大数据处理实践

### 3.1 Hadoop生态系统和MapReduce编程

#### Hadoop生态系统

Hadoop是一个开源的分布式计算框架,用于处理海量数据。它由以下组件组成:

| 组件 | 描述 |

|---|---|

| Hadoop Distributed File System (HDFS) | 分布式文件系统,用于存储和管理大数据 |

| MapReduce | 分布式计算框架,用于并行处理大数据 |

| Yarn | 资源管理框架,用于管理Hadoop集群中的资源 |

| Hive | 数据仓库工具,用于查询和分析大数据 |

| Pig | 数据流处理工具,用于处理和转换大数据 |

| HBase | NoSQL数据库,用于存储和管理非结构化数据 |

#### MapReduce编程

MapReduce是一种编程模型,用于在分布式集群上并行处理大数据。它将数据处理任务分解为两个阶段:

* **Map阶段:**将输入数据映射到一组键值对。

* **Reduce阶段:**将映射的键值对聚合和汇总。

**MapReduce编程步骤:**

1. **定义Mapper类:**实现`map()`方法,将输入数据映射到键值对。

2. **定义Reducer类:**实现`reduce()`方法,将映射的键值对聚合和汇总。

3. **提交作业:**使用`Job`类提交MapReduce作业,指定输入和输出路径、Mapper和Reducer类。

**代码示例:**

```java

import org.apache.hadoop.io.IntWritable;

import org.apache.hadoop.io.Text;

import org.apache.hadoop.mapreduce.Mapper;

import org.apache.hadoop.mapreduce.Reducer;

import org.apache.hadoop.mapreduce.Job;

import org.apache.hadoop.mapreduce.lib.input.FileInputFormat;

import org.apache.hadoop.mapreduce.lib.output.FileOutputFormat;

public class WordCount {

public static class WordCountMapper extends Mapper<Object, Text, Text, IntWritable> {

@Override

public void map(Object key, Text value, Context context) throws

```

0

0