【MATLAB数据分析秘籍】:回归分析实用技巧全揭露

发布时间: 2024-08-30 19:03:33 阅读量: 131 订阅数: 33

# 1. MATLAB数据分析基础与回归分析概述

## 简介

MATLAB (Matrix Laboratory) 是一款强大的数学软件,广泛应用于数据分析、算法开发和工程计算等多领域。回归分析是数据分析中最重要的技术之一,它能够帮助我们理解和预测变量之间的关系。本章将介绍MATLAB在数据分析中的基础应用,并对回归分析的基本概念进行概述。

## MATLAB数据分析入门

在MATLAB中进行数据分析,首先需要了解其基本的数据结构,如矩阵和数组。利用MATLAB内置的函数和工具箱,我们可以轻松地进行数据导入、清洗、转换等操作。对于初学者,`load`、`csvread`、`xlsread`等函数是导入数据的常用方法。数据清洗通常涉及去除缺失值、异常值和数据转换等,MATLAB提供了诸如`ismissing`、`rmmissing`等函数辅助这一过程。

## 回归分析的定义与作用

回归分析是研究变量之间相关关系的一种统计方法。在MATLAB中,通过回归分析,用户能够建立一个或多个预测变量(自变量)和一个响应变量(因变量)之间的数学关系模型。这个模型可以用于预测新的数据点的响应变量值或分析数据中的趋势和模式。简而言之,回归分析帮助我们在存在不确定性因素的情况下,揭示变量间潜在的关系和规律。

# 2. 回归分析的理论基础

## 2.1 线性回归分析的数学原理

### 2.1.1 最小二乘法的理论推导

线性回归分析的核心是通过最小化误差的平方和寻找数据的最佳函数匹配。最小二乘法的理论基础在于最小化成本函数或损失函数,通常表示为误差平方和(SSE)。

假设我们有一组数据点 $(x_i, y_i)$ ,其中 $i = 1, 2, ..., n$,并且我们想找到一条直线 $y = ax + b$ 来最好地描述这些点。线性回归模型通过选择参数 $a$ 和 $b$,使得预测的 $y$ 值与实际的 $y$ 值之差的平方和最小。数学表达式如下:

\text{minimize} \quad S = \sum_{i=1}^{n} (y_i - (ax_i + b))^2

为了找到使 $S$ 最小的 $a$ 和 $b$,我们可以对 $a$ 和 $b$ 分别求偏导并令导数为零来求解极值问题。

\frac{\partial S}{\partial a} = 0, \quad \frac{\partial S}{\partial b} = 0

通过求解这两个方程,我们得到以下的正规方程组:

a = \frac{\sum_{i=1}^{n} (x_i - \bar{x})(y_i - \bar{y})}{\sum_{i=1}^{n} (x_i - \bar{x})^2}

b = \bar{y} - a\bar{x}

其中,$\bar{x}$ 和 $\bar{y}$ 分别是 $x_i$ 和 $y_i$ 的均值。

### 2.1.2 参数估计与假设检验

在确定了线性回归模型的参数 $a$ 和 $b$ 之后,我们需要对这些估计值进行假设检验,以了解它们是否在统计上显著,以及我们是否可以拒绝模型中的零假设(即系数为零)。这通常涉及到计算 $t$ 统计量:

t = \frac{\hat{\beta} - \beta_0}{SE(\hat{\beta})}

其中,$\hat{\beta}$ 是估计参数,$\beta_0$ 是零假设下参数的值(通常是0),$SE(\hat{\beta})$ 是估计参数的标准误差。

我们还需要计算自由度为 $n-k-1$ 的 $t$ 分布的临界值,其中 $n$ 是样本大小,$k$ 是模型中自变量的数量(在简单线性回归中,$k=1$)。如果计算出的 $t$ 值大于临界值,我们则拒绝零假设,表明该参数在统计上是显著的。

此外,$R^2$ 统计量用来衡量模型对数据的拟合程度:

R^2 = 1 - \frac{\sum_{i=1}^{n} (y_i - \hat{y}_i)^2}{\sum_{i=1}^{n} (y_i - \bar{y})^2}

$R^2$ 的值越接近1,表示模型拟合得越好。在多元线性回归中,调整后的 $R^2$ 会考虑自变量的数量对模型复杂度的影响。

## 2.2 非线性回归模型

### 2.2.1 常见非线性模型的介绍

非线性回归模型是指响应变量与解释变量之间的关系不是线性的。常见的非线性回归模型包括多项式回归、逻辑斯蒂回归、指数增长模型等。这些模型能够描述更复杂的数据关系,适用于线性模型无法很好拟合的情况。

多项式回归模型具有形式 $y = \beta_0 + \beta_1 x + \beta_2 x^2 + ... + \beta_k x^k$,其中 $k$ 是多项式的阶数。逻辑斯蒂回归模型一般用于二分类问题,其模型形式为:

P(Y=1|X=x) = \frac{e^{\beta_0 + \beta_1 x}}{1 + e^{\beta_0 + \beta_1 x}}

指数增长模型可以描述复利增长或衰减,形式为 $y = ae^{bx}$,其中 $a$ 和 $b$ 是模型参数。

### 2.2.2 非线性回归的参数优化方法

非线性回归的参数优化通常比线性回归复杂,因为模型形式不再保证参数估计的唯一性或解的凸性。常用的参数估计方法有牛顿-拉夫森迭代法、高斯-牛顿方法、以及最速下降法等。

牛顿-拉夫森方法是一种迭代过程,用于求解函数的根,也可以用来求解非线性最小化问题。假设我们有一个目标函数 $f(\beta)$,我们希望找到使 $f$ 最小化的 $\beta$ 值。牛顿-拉夫森方法通过以下迭代公式更新参数:

\beta_{\text{new}} = \beta_{\text{old}} - [H(\beta_{\text{old}})]^{-1}g(\beta_{\text{old}})

其中 $g(\beta)$ 是 $f$ 关于 $\beta$ 的梯度,$H(\beta)$ 是 $f$ 的Hessian矩阵。这种方法能够快速收敛,但需要良好的初始估计,否则可能不收敛。

### 2.3 回归分析的适用条件和诊断

在应用回归模型时,了解其适用条件至关重要。以下是几个关键的适用条件和相应的诊断技术。

#### 2.3.1 模型适用性检验

模型适用性检验通常包括检查残差的正态性、方差齐性、以及线性关系的假设。

- 正态性:可以通过绘制残差的Q-Q图来检验,或者使用Shapiro-Wilk检验等统计检验方法。

- 方差齐性:可以通过绘制残差的散点图与拟合值的对比图来检验,或者使用Bartlett检验或Levene检验等。

- 线性关系:通过观察数据的散点图,或使用相关系数检验等方法。

#### 2.3.2 异常值和影响点的诊断技术

异常值或影响点可能会扭曲回归分析的结果。诊断它们的常用方法包括:

- 标准化残差:异常值通常会表现为较大的标准化残差。

- Cook's距离:这是一种衡量单个观测对回归模型拟合的影响程度的指标。

- DFFITS和DFBETAS:这些指标分别衡量单个观测对预测值的影响和对系数估计的影响。

通过这些诊断技术,研究者可以识别并处理模型中的异常值和影响点,以提高模型的稳健性和预测准确性。

# 3. MATLAB回归分析工具和函数

在前一章节中,我们已经对回归分析的理论基础进行了深入探讨,包括线性回归和非线性回归模型的概念、参数优化方法以及模型的适用性和诊断技术。在本章节中,我们将注意力转向MATLAB环境中的回归分析工具和函数,通过具体应用实例来展示这些工具的使用和效果。

## 3.1 基于命令行的回归分析工具

### 3.1.1 regres函数的使用和实例

MATLAB提供了`regress`函数,这是一个基于命令行的工具,能够方便地执行线性回归分析。`regress`函数可以快速得到回归系数估计、残差以及相关统计量。

**实例代码:**

```matlab

% 假设有一组数据存储于变量X和Y中

X = [ones(length(Y), 1), X]; % 添加常数项,以形成截距

[b, bint, r, rint, stats] = regress(Y, X);

% 输出回归系数

disp('回归系数:');

disp(b);

```

**参数说明:**

- `Y`:响应变量(因变量)向量。

- `X`:设计矩阵,包含了预测变量(自变量),并且应该包括一个全为1的列,用于计算截距。

- `b`:回归系数向量。

- `bint`:回归系数的置信区间。

- `r`:残差向量。

- `rint`:残差的预测区间。

- `stats`:包含各种统计量的向量,如R²、F统计量等。

**逻辑分析:**

使用`regress`函数进行线性回归分析时,首先构建设计矩阵`X`,这通常意味着把自变量放入矩阵,并确保包含一个全为1的列以考虑截距项。`regress`函数执行后,返回包括回归系数在内的多个输出,其中`stats`变量中的第一个元素就是决定系数R²,表示模型解释变量的变异比例。

### 3.1.2 fitlm函数与线性模型的构建

`fitlm`函数是MATLAB中用于构建线性模型的现代替代方法。与`regress`相比,`fitlm`提供了更为丰富的输出和更加直观的模型对象。

**实例代码:**

```matlab

% 构建线性模型

lm = fitlm(X, Y);

% 显示回归模型的详细结果

disp(lm);

```

**逻辑分析:**

`fitlm`函数通过输入数据的矩阵`X`和向量`Y`来构建线性模型。它返回一个`LinearModel`对象,该对象包含了模型的详细统计信息和方法。在MATLAB中,可以使用这个对象来获取模型参数、预测、残差等信息,并且该对象还支持包括图形展示在内的多种交互操作。

## 3.2 回归分析的图形化工具

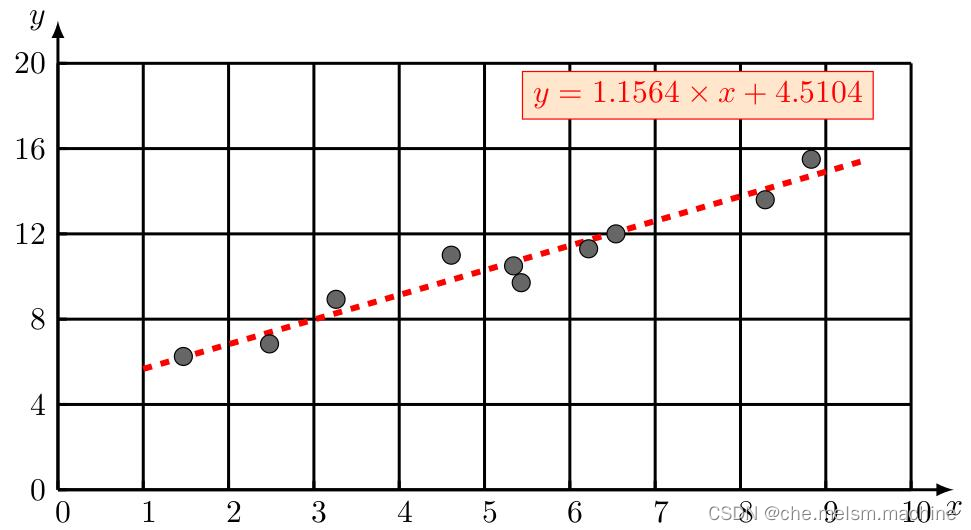

### 3.2.1 绘制散点图与拟合线

除了命令行工具外,MATLAB也提供了图形化界面工具来帮助进行回归分析,其中最直接的是使用`scatter`函数绘制散点图,并利用`fit`函数进行线性拟合。

**实例代码:**

```matlab

% 绘制散点图

scatter(X(:,2), Y, 'filled');

hold on; % 保持图像,以便在同一个图上绘制拟合线

% 使用fit函数进行线性拟合

[p, s] = polyfit(X(:,2), Y, 1);

% 拟合线的绘制

x_values = linspace(min(X(:,2)), max(X(:,2)), 100);

y_values = polyval(p, x_values);

plot(x_values, y_values, 'r-', 'LineWidth', 2);

legend('数据点', '拟合线');

xlabel('自变量');

ylabel('因变量');

title('散点图与线性拟合');

```

**逻辑分析:**

`scatter`函数用于绘制散点图,而`polyfit`函数执行最小二乘拟合,得到线性回归模型的参数。接着,通过`polyval`函数计算拟合线的坐标值,并使用`plot`函数进行绘制。这样,我们可以直观地观察数据分布与拟合线的关系。

### 3.2.2 图形化界面下的模型诊断

MATLAB的图形化工具还支持模型的诊断,包括残差的可视化分析,这有助于我们识别模型的假设是否成立。

**操作步骤:**

1. 使用`fitlm`函数构建模型对象。

2. 使用`plot`方法来绘制残差图。

3. 通过诊断图来检查模型假设,如残差的正态性、均值的恒定性等。

## 3.3 高级回归分析函数应用

### 3.3.1 nlinfit函数在非线性回归中的应用

对于非线性回归问题,MATLAB提供了`nlinfit`函数,该函数基于非线性最小二乘法来估计模型参数。

**实例代码:**

```matlab

% 定义非线性模型函数

nlModel = @(b, x) b(1)*exp(-b(2)*x) + b(3)*x + b(4);

% 初始参数估计

beta0 = [1 1 1 1];

% 使用nlinfit进行参数估计

[beta, R, J, CovB, MSE] = nlinfit(X, Y, nlModel, beta0);

```

**逻辑分析:**

在非线性回归中,我们首先定义一个非线性函数`nlModel`,该函数描述了模型的结构,其中`b`是参数向量,`x`是自变量。然后,为参数`beta`提供一个初始估计值,接着`nlinfit`函数会通过迭代优化来找到最佳参数估计值。返回的`beta`包含最优估计的参数,`CovB`是参数的协方差矩阵,`MSE`是均方误差。

### 3.3.2 多元回归分析的实现

对于包含多个预测变量的回归分析,我们可以使用`fitlm`函数来实现多元回归。

**实例代码:**

```matlab

% 构建多元线性模型

lm = fitlm(X, Y);

% 显示多元回归模型的详细结果

disp(lm);

```

**逻辑分析:**

在多元线性回归中,`fitlm`函数同样可以处理。在多元回归中,我们关心的是各个自变量对因变量的影响,并且需要考虑变量间的多重共线性问题。`fitlm`函数通过内置的统计方法能够给出每个自变量的偏回归系数、标准误、t统计量和对应的p值等统计信息,从而帮助研究者了解每个自变量对因变量的作用和显著性。

在接下来的章节中,我们将进一步探讨回归分析在数据处理中的实践应用,包括数据预处理、变量选择、实际案例的回归分析,以及回归模型的性能评估等,从而更深入地理解回归分析在实际问题中的应用。

# 4. 回归分析在数据处理中的实践应用

## 4.1 数据预处理与变量选择

在进行回归分析之前,数据预处理和变量选择是两个关键步骤,它们对于确保模型质量和解释性至关重要。数据预处理包括数据清洗、数据转换等操作,而变量选择则是确定哪些变量应该包含在回归模型中。

### 4.1.1 数据清洗与转换

数据清洗的目的是纠正数据集中的错误和不一致性,这是提高数据质量和后续分析准确性的前提。数据清洗的常见步骤包括处理缺失值、异常值检测与处理,以及数据类型转换。

**处理缺失值**:在实际数据集中,缺失值是常见的问题。处理缺失值的方法包括删除含有缺失值的记录、用均值、中位数或众数填充缺失值,或者采用更复杂的插补方法。

**异常值处理**:异常值可能会对模型的预测能力产生负面影响。异常值的检测方法有很多,例如箱线图、标准差判断等。处理异常值的常见方法有删除、变换、或采用鲁棒的回归方法。

**数据类型转换**:数据类型转换包括将分类变量转换为哑变量(dummy variables),确保数据适合进行数学运算。

```matlab

% 假设有一个数据集data,含有一个分类变量Category

data.Category = categorical(data.Category);

% 将分类变量转换为哑变量

dummyVar = dummyvar(data.Category);

% 将数据集data与哑变量合并

data = [data dummyVar];

```

在上述代码中,`categorical` 函数将分类变量转换为 MATLAB 可以识别的分类类型,而 `dummyvar` 函数生成了对应的哑变量矩阵。

### 4.1.2 变量选择方法与实施步骤

变量选择是确定哪些自变量对于预测目标变量最为重要。通过变量选择可以减少模型复杂性,避免过拟合,并提高模型的解释能力。常用的变量选择方法包括逐步回归、Lasso回归等。

**逐步回归**:逐步回归是一种自动选择变量的方法,它通过逐个添加或删除变量来改进模型。

**Lasso回归**:Lasso(Least Absolute Shrinkage and Selection Operator)回归是一种带有L1正则化的线性回归方法。它不仅可以减少模型复杂性,还可以处理多重共线性问题。

```matlab

% 假设X为自变量矩阵,y为目标变量向量

% 使用Lasso回归进行变量选择

lambda = cvglmnet(X, y, 'alpha', 1, 'nfolds', 10);

```

在上述代码中,`cvglmnet` 函数用于执行交叉验证,并选择最佳的正则化参数lambda,`'alpha', 1` 指定了Lasso回归。

## 4.2 实际案例的回归分析

实际应用中的回归分析案例可以帮助我们更好地理解回归模型在不同场景下的应用。

### 4.2.1 经济学数据回归分析实例

在经济学研究中,回归分析常被用于分析不同经济指标之间的关系。例如,分析GDP、消费和投资之间的关系,以预测未来经济走势。

```matlab

% 假设有一个经济数据集ecoData,其中包含GDP, Consumption, Investment等变量

% 使用多元线性回归分析GDP与其他经济指标的关系

lm = fitlm(ecoData(:,2:end), ecoData(:,1));

```

在这个例子中,`fitlm` 函数创建了一个线性模型对象`lm`,其中包含了GDP与其他经济指标(消费和投资)的关系。

### 4.2.2 生物医学数据的回归分析应用

在生物医学领域,回归分析可以用于研究疾病发生的可能性和生物标志物的关系。比如,使用回归分析研究血压和体重、年龄等因素对心脏病发病风险的影响。

```matlab

% 假设有一个生物医学数据集medData,其中包含HeartDisease, BloodPressure, Weight, Age等变量

% 使用逻辑回归分析心脏病发病风险

logReg = fitglm(medData, 'HeartDisease ~ BloodPressure + Weight + Age', 'Distribution', 'binomial');

```

在上述代码中,`fitglm` 函数用于拟合一个逻辑回归模型,分析不同变量对心脏病发病风险的影响,其中`'Distribution', 'binomial'`指定了使用二项分布进行拟合。

## 4.3 回归模型的性能评估

评估回归模型的性能对于模型优化和验证至关重要。

### 4.3.1 拟合优度的评价指标

拟合优度评价指标用于衡量模型对于已有数据的拟合程度。在MATLAB中,可以通过R平方值、调整R平方值、均方误差(MSE)等指标来评价模型的拟合优度。

```matlab

% 假设有一个线性回归模型lm

% 获取R平方值和调整R平方值

rSquare = lm.Rsquared.Ordinary;

adjRSquare = lm.Rsquared.Adjusted;

% 计算均方误差(MSE)

y = lm.Y;

yHat = lm.Fitted;

mse = sum((y - yHat).^2) / length(y);

```

在该代码段中,`Rsquared.Ordinary` 和 `Rsquared.Adjusted` 属性分别返回普通R平方值和调整R平方值,而MSE是通过计算真实值与预测值的差的平方和除以观测点的数量得到的。

### 4.3.2 模型预测能力的评估方法

除了拟合优度指标之外,评估模型的预测能力也是非常重要的。交叉验证是一种常用的评估方法,可以减少模型过拟合的风险。

```matlab

% 使用交叉验证评估线性回归模型

cvResults = crossval(lm);

% 获取交叉验证结果的均方误差(MSE)

mseCV = kfoldLoss(cvResults);

```

在这段代码中,`crossval` 函数用于执行k折交叉验证,`kfoldLoss` 函数则计算交叉验证结果的平均MSE。这些指标为我们提供了一个评估模型在未见数据上表现的依据。

通过上述章节内容的介绍,我们深入探讨了回归分析在数据处理中的实际应用,从数据预处理到模型性能评估。这为我们理解如何将回归分析应用于解决真实世界的问题提供了重要的视角和方法。在下一章中,我们将进一步探索回归分析的高级技巧与应用拓展。

# 5. 回归分析高级技巧与应用拓展

回归分析不仅限于基础应用,随着技术的发展,它已经扩展到更为复杂的场景,比如时间序列数据和分类数据的处理。此外,机器学习的兴起也使得回归分析与之结合,扩展了其在预测建模中的应用。本章将深入探讨这些高级技巧以及回归分析未来的发展趋势。

## 5.1 复杂数据结构的回归分析

### 5.1.1 时间序列数据的回归分析

时间序列数据由于其自身的时间依赖性和周期性特征,对回归模型提出了额外的挑战。在应用回归分析时,必须考虑时间相关性的影响,以避免伪回归的发生。使用自回归移动平均(ARMA)或自回归积分滑动平均(ARIMA)模型,可以有效解决时间序列数据中的时间依赖问题。

以下是使用Python中的statsmodels库进行ARIMA模型拟合的示例代码:

```python

import statsmodels.api as sm

# 假设data是一个时间序列数据集

model = sm.tsa.ARIMA(data, order=(1,1,1))

results = model.fit()

# 打印模型参数

print(results.summary())

```

### 5.1.2 分类数据的回归分析技巧

分类数据的回归分析需要特别注意变量的编码方式。通常,分类变量需要被转换为一系列的二进制变量(虚拟变量),这样才能在回归模型中使用。这种处理方法被称为独热编码(One-Hot Encoding)。

以Python为例,我们可以使用pandas库将分类变量转换为独热编码格式:

```python

import pandas as pd

# 假设df是一个包含分类变量的DataFrame

category = df['Category']

one_hot = pd.get_dummies(category, drop_first=True)

# 结果one_hot就是独热编码后的DataFrame

```

## 5.2 机器学习与回归分析的结合

### 5.2.1 回归分析在预测模型中的应用

回归分析可以作为机器学习预测模型的基础。在实际应用中,经常结合其他机器学习技术来提升模型性能。比如,通过特征工程技术增强模型的预测能力,或者使用集成学习方法来提高模型的稳定性。

例如,随机森林是集成学习的一种,可以有效提高回归预测的准确性。以下是使用Python中的scikit-learn库实现随机森林回归的代码示例:

```python

from sklearn.ensemble import RandomForestRegressor

# 假设X为特征矩阵,y为响应变量

model = RandomForestRegressor(n_estimators=100, random_state=0)

model.fit(X, y)

# 使用模型进行预测

predictions = model.predict(X)

```

### 5.2.2 集成学习方法与回归模型的结合

集成学习方法,如Bagging、Boosting和Stacking,通过组合多个模型来提高预测的准确性。在回归分析中,这些方法可以帮助模型更好地捕捉数据的复杂关系,从而提升模型的泛化能力。

在Python中,可以使用scikit-learn库轻松实现这些集成学习方法。下面的代码展示了一个使用梯度提升树进行回归分析的例子:

```python

from sklearn.ensemble import GradientBoostingRegressor

# 假设X_train和y_train是训练数据集

gbr = GradientBoostingRegressor(n_estimators=100, learning_rate=0.1)

gbr.fit(X_train, y_train)

# 使用模型进行预测

gbr_predictions = gbr.predict(X_test)

```

## 5.3 回归分析的未来趋势与研究方向

### 5.3.1 大数据环境下的回归分析挑战

在大数据环境下,回归分析面临诸多挑战,如数据维度增加、数据不平衡以及计算资源限制等。为了应对这些挑战,需要开发更为高效的算法,以及能够处理大规模数据集的分布式回归分析框架。

### 5.3.2 研究前沿:贝叶斯回归与其他高级模型

贝叶斯回归提供了一种与传统最大似然估计不同的概率框架,能够对模型参数进行不确定性评估。此外,基于深度学习的高级回归模型,例如深度信念网络(DBN)和受限玻尔兹曼机(RBM),也在不断发展之中,为回归分析提供了新的研究方向和应用可能性。

通过采用先进的技术和算法,回归分析将继续在各种数据分析任务中发挥关键作用,并且随着大数据和机器学习技术的不断进步,回归分析将在数据分析领域中保持其重要地位。

0

0