写入本地磁盘策略:MapReduce数据持久化的高效选择

发布时间: 2024-10-31 04:54:38 阅读量: 17 订阅数: 28

# 1. MapReduce数据持久化概述

MapReduce作为一种分布式的数据处理模式,已经被广泛应用于大数据处理领域。其核心在于将大数据集分割成独立的块,通过Map函数处理后,再通过Reduce函数进行汇总。在这过程中,数据持久化扮演着至关重要的角色。数据持久化意味着处理结果被保存在可靠的存储介质上,确保在系统故障或其他意外情况下,数据不会丢失。

MapReduce框架中,数据持久化不是简单的读写操作,而是涉及到数据在网络中的传输、在节点间的数据分割和重组等复杂流程。因此,本章将着重介绍MapReduce的数据持久化,为后续章节深入探讨各类持久化策略和技术实现打下基础。我们会从数据持久化的概念和重要性入手,逐步深入到具体的技术实现细节,以及在实际业务场景中的应用和优化。通过系统性的分析和案例研究,我们将揭示如何有效地利用本地磁盘持久化策略来提升MapReduce作业的性能和可靠性。

# 2. MapReduce数据持久化的理论基础

在信息技术领域,数据持久化是确保数据安全和长期有效管理的关键组成部分。MapReduce作为一种强大的数据处理框架,其数据持久化机制不仅对数据完整性至关重要,也直接影响到整个处理流程的效率和性能。接下来,我们将深入探讨MapReduce数据持久化的相关理论基础。

## 2.1 数据持久化的定义与重要性

### 2.1.1 数据持久化的概念

数据持久化是指将数据从临时存储(如内存)转移到持久存储(如硬盘或固态硬盘)的过程。这个过程确保了即便在系统崩溃或断电的情况下,数据也不会丢失,从而保证了数据的持久性和可靠性。

在MapReduce框架中,数据持久化不仅涉及数据的存储,还包括从输入源获取数据,处理计算任务,并将结果存储到可靠的存储介质中。这一系列动作确保了数据在整个生命周期中的安全和可用性。

### 2.1.2 持久化与数据完整性的关系

数据完整性是指数据的准确性和一致性,保证数据在存储和传输过程中的准确性,不会因为错误的操作或外部因素而发生改变。MapReduce框架中的持久化机制是维护数据完整性的关键因素之一。

通过定期的数据持久化,即使发生故障,也能从最近一次持久化的状态恢复,而不会丢失所有后续的处理结果。这在大规模数据处理环境中尤其重要,因为数据量大且复杂,一旦丢失,重新处理的代价将非常高昂。

## 2.2 MapReduce框架中的数据处理

### 2.2.1 MapReduce工作原理

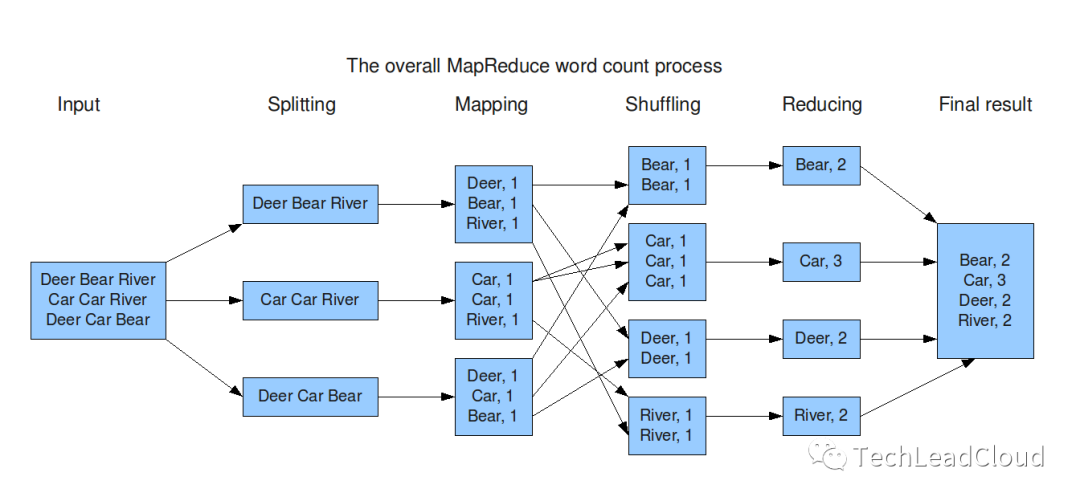

MapReduce的工作原理分为两个主要阶段:Map阶段和Reduce阶段。在Map阶段,框架读取输入数据,将其分割成独立的块,并分配给Map任务进行处理。在Reduce阶段,框架将Map阶段输出的中间结果进行汇总,输出最终结果。

### 2.2.2 MapReduce的输入输出机制

MapReduce的输入输出机制遵循特定的格式和规则。输入数据被切分成多个小块,然后被Map任务读取和处理。Map任务输出的中间键值对会根据键进行排序并分组,然后传递给Reduce任务。

输出结果通常存储在分布式文件系统(如HDFS)中,以便于持久化存储。输出的数据格式通常也是可读的,例如文本文件或二进制文件,这取决于具体的应用场景。

## 2.3 持久化策略的类型与选择

### 2.3.1 内存持久化与磁盘持久化的比较

在MapReduce框架中,数据持久化策略主要分为内存持久化和磁盘持久化。内存持久化是将数据存储在服务器的RAM中,以提高访问速度和处理效率。然而,内存持久化具有有限的存储空间,且易受系统故障影响,数据安全性较低。

磁盘持久化则将数据存储在硬盘或固态硬盘中,确保了数据即使在断电或系统崩溃的情况下也不会丢失。磁盘持久化的缺点是读写速度较慢,但其稳定性和可靠性使其成为持久化大量数据的首选方案。

### 2.3.2 选择合适持久化策略的标准

选择MapReduce持久化策略时,需要考虑多种因素,包括数据的大小、处理速度要求、系统的稳定性和可靠性需求等。对于需要高速处理和较小数据量的任务,可以考虑内存持久化。而对于大规模数据处理任务,磁盘持久化则更为合适。

此外,还需考虑成本、能耗和硬件的兼容性。例如,尽管SSD相比传统硬盘具有更快的读写速度,但其价格更高,且可能不适用于所有硬件配置。

在下一章中,我们将探讨本地磁盘策略在MapReduce中的具体优势及其实现方法。这一策略结合了内存持久化和磁盘持久化的优点,能够在保持高性能的同时,确保数据的持久性和可靠性。

# 3. 本地磁盘策略的优势与实现

## 3.1 本地磁盘策略的理论优势

### 3.1.1 提升数据处理速度

在大数据处理领域,数据传输的速度往往是性能的瓶颈之一。利用本地磁盘策略,可以直接在存储数据的节点上进行计算,从而避免了数据在网络中的传输,显著提高了数据处理速度。这种方法特别适用于那些计算密集型的任务,其中数据处理的开销远大于数据传输的开销。

由于数据不需要通过网络进行传输,减少了网络I/O的开销,这直接加快了MapReduce任务的处理速度。尤其是在处理大数据量的情况下,这种策略能显著缩短任务完成时间。

### 3.1.2 减少网络带宽消耗

数据在网络中

0

0