【进阶】常见优化算法详解(SGD, Adam等)

发布时间: 2024-06-26 20:34:35 阅读量: 103 订阅数: 110

# 2.1 随机梯度下降(SGD)

### 2.1.1 SGD原理及实现

随机梯度下降(SGD)是一种优化算法,用于最小化损失函数。它通过迭代更新模型参数来进行,每次更新都使用训练数据集中一个随机样本的梯度。SGD的更新规则如下:

```python

w = w - lr * ∇L(w, x, y)

```

其中:

* w 是模型参数

* lr 是学习率

* ∇L(w, x, y) 是损失函数关于 w 的梯度

### 2.1.2 SGD的优缺点及应用场景

**优点:**

* 计算简单,实现容易

* 适用于大规模数据集,因为每次更新只使用一个样本

**缺点:**

* 收敛速度慢,可能产生振荡

* 容易陷入局部最优

**应用场景:**

* 大规模数据集的训练

* 鲁棒性要求不高的任务

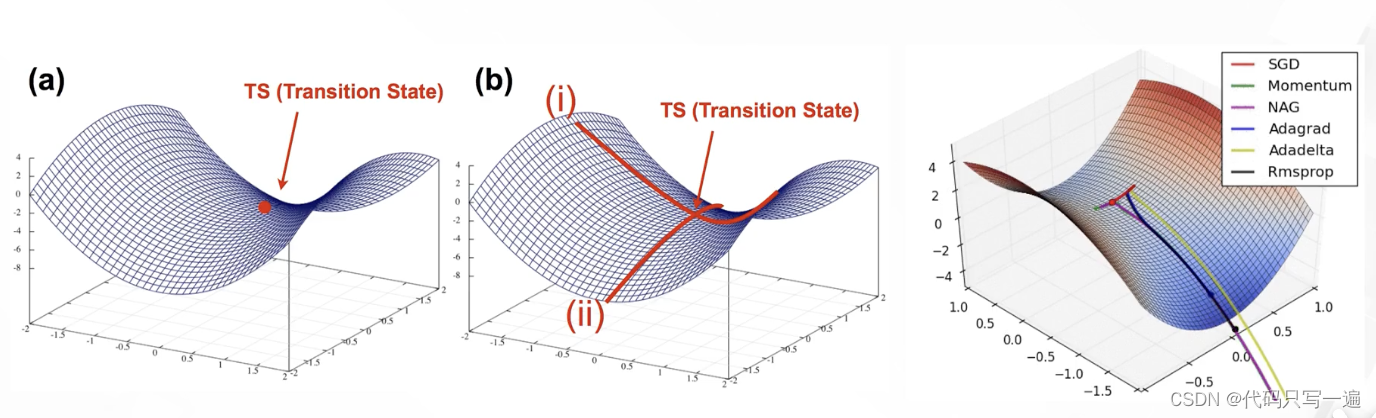

# 2. 梯度下降算法

梯度下降算法是一种一阶优化算法,它通过迭代更新模型参数来最小化损失函数。在每次迭代中,算法都会计算损失函数的梯度,并沿着梯度负方向更新参数。

### 2.1 随机梯度下降(SGD)

#### 2.1.1 SGD原理及实现

随机梯度下降(SGD)是梯度下降算法的一种变体,它在每次迭代中仅使用训练数据集的一个随机样本(称为小批量)来计算梯度。这使得SGD比标准梯度下降算法更有效,因为它可以避免计算整个训练数据集的梯度。

SGD的伪代码如下:

```python

def SGD(loss_function, parameters, learning_rate, num_epochs, batch_size):

for epoch in range(num_epochs):

for batch in get_batches(training_data, batch_size):

gradients = compute_gradients(loss_function, parameters, batch)

parameters -= learning_rate * gradients

```

#### 2.1.2 SGD的优缺点及应用场景

**优点:**

* **效率高:**SGD只使用小批量样本计算梯度,因此比标准梯度下降算法更有效。

* **鲁棒性强:**SGD对噪声和异常值不敏感,因为它只使用小批量样本。

**缺点:**

* **收敛速度慢:**SGD的收敛速度比标准梯度下降算法慢,因为它使用随机样本计算梯度。

* **可能无法找到全局最优解:**SGD可能会收敛到局部最优解,而不是全局最优解。

**应用场景:**

SGD通常用于训练大型数据集,其中计算整个训练数据集的梯度过于耗时。它还用于训练对噪声和异常值鲁棒的模型。

### 2.2 动量梯度下降(Momentum)

#### 2.2.1 Momentum原理及实现

动量梯度下降(Momentum)是梯度下降算法的另一种变体,它通过引入动量项来加速收敛。动量项是一个累积的梯度,它可以帮助算法克服局部最优解并更快地收敛到全局最优解。

Momentum的伪代码如下:

```python

def Momentum(loss_function, parameters, learning_rate, momentum, num_epochs, batch_size):

velocity = 0

for epoch in range(num_epoc

```

0

0