MobileNetV3: 效率与精度并存的神经网络设计

需积分: 9 167 浏览量

更新于2024-07-08

收藏 3.34MB PDF 举报

"该资源是关于Mobilenetv3的修正版研究,由StellaSeoYeonYang在2019年12月22日的AIRoboticsKR活动中分享。主要内容涉及到神经网络的量化与紧凑网络设计,特别是ShiftNet的概念以及其在MobileNetV3中的应用。ShiftNet利用单个1x1内核矩阵实现特征位移,通过点卷积进行通道间的连接。此外,还探讨了Grouped Shift和Active Shift的概念,以及如何通过整数运算实现并保持网络的可微性。MobileNetV3作为高效神经网络的代表,追求更高的准确性、更低的延迟和更少的电池消耗,它主要依赖于深度可分离卷积来实现这些目标。"

详细内容:

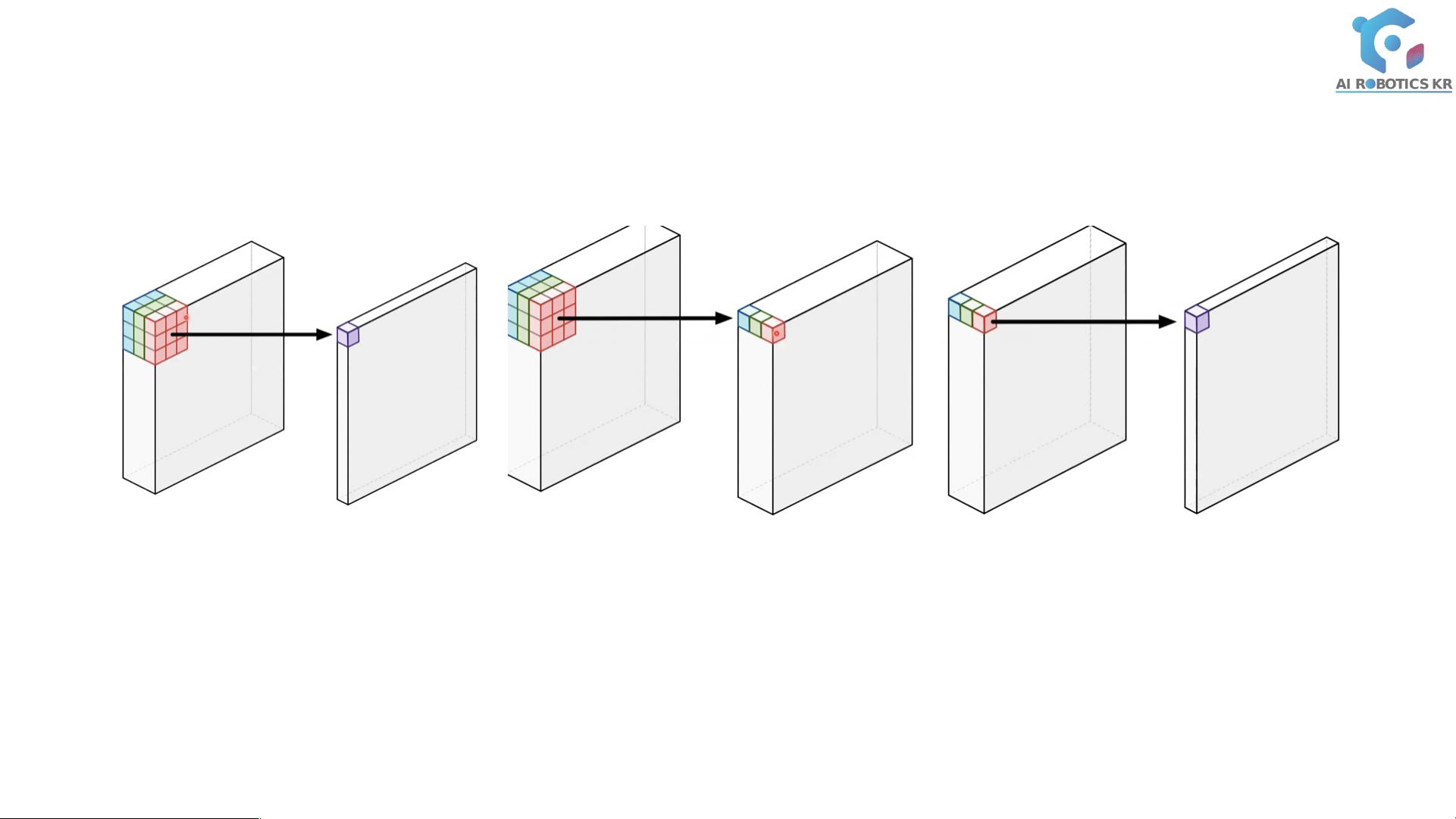

1. ShiftNet: ShiftNet是一种利用单一1x1内核矩阵进行特征位移的方法,这种位移导致了空间变化之外的通道连接。这种方法旨在减少计算复杂度,同时保持模型的效果。

2. Grouped Shift与Active Shift: Grouped Shift是指将通道分组,尝试在每个组内寻找最佳的位移。而Active Shift则通过学习来找到每个通道的最佳位移,由于位移是像素级的整数操作,不支持微分,因此通常先用实值进行学习,然后通过双线性插值估算整数值。

3. MobileNetV3: MobileNetV3是针对移动设备优化的高效神经网络,目标是在保持高精度的同时,降低延迟,减少电池消耗。其核心是深度可分离卷积,这包括深度卷积(Depthwise Convolution)和点卷积(Pointwise Convolution)。

4. 深度可分离卷积: 传统的标准卷积涉及通道间的加权线性组合,计算量大。深度可分离卷积首先通过深度卷积仅考虑每个通道的spatial信息,接着使用点卷积进行通道间的融合,从而减少了维度和参数的数量,形成瓶颈结构(Bottleneck)。

5. 瓶颈结构: 瓶颈结构(BottleNeck)是深度学习中常用的设计,通过线性瓶颈层和逆线性瓶颈层实现维度减小和参数减少,提高计算效率,同时保持模型性能。

6. Linear BottleNeck and Inverted Residuals: MobileNetV3中还引入了线性瓶颈层和倒残差结构,这是一种改进的瓶颈设计,它可以提高模型的表示能力,同时保持网络轻量化。

这个资源深入讲解了如何通过ShiftNet技术优化MobileNetV3的设计,以及如何通过深度可分离卷积和瓶颈结构实现高效的神经网络,这对于理解和优化适用于移动设备的深度学习模型具有重要意义。

2024-08-25 上传

2023-06-12 上传

2023-07-22 上传

2023-06-12 上传

2023-05-11 上传

2023-09-13 上传

2024-01-09 上传

2023-06-10 上传

weixin_44956555

- 粉丝: 0

- 资源: 5

最新资源

- AirKiss技术详解:无线传递信息与智能家居连接

- Hibernate主键生成策略详解

- 操作系统实验:位示图法管理磁盘空闲空间

- JSON详解:数据交换的主流格式

- Win7安装Ubuntu双系统详细指南

- FPGA内部结构与工作原理探索

- 信用评分模型解析:WOE、IV与ROC

- 使用LVS+Keepalived构建高可用负载均衡集群

- 微信小程序驱动餐饮与服装业创新转型:便捷管理与低成本优势

- 机器学习入门指南:从基础到进阶

- 解决Win7 IIS配置错误500.22与0x80070032

- SQL-DFS:优化HDFS小文件存储的解决方案

- Hadoop、Hbase、Spark环境部署与主机配置详解

- Kisso:加密会话Cookie实现的单点登录SSO

- OpenCV读取与拼接多幅图像教程

- QT实战:轻松生成与解析JSON数据