主成分分析(PCA):从原理到应用的深度解析,助你降维提效

发布时间: 2024-08-20 06:00:06 阅读量: 35 订阅数: 25

主成分分析(PCA)深度解析:降维利器的理论与实践

# 1. 主成分分析(PCA)简介**

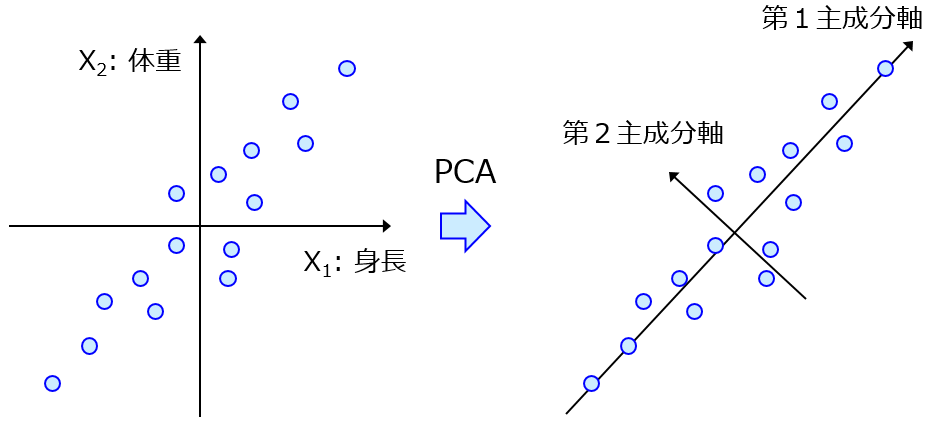

主成分分析(PCA)是一种降维技术,通过线性变换将高维数据投影到低维空间,同时保留数据的最大方差。PCA在数据分析和机器学习中广泛应用,因为它可以有效减少数据维度,简化模型构建,提高计算效率。

PCA的基本思想是将原始数据中的相关变量转换为一组不相关的变量,称为主成分。这些主成分按方差从大到小排列,表示数据中最大的方差方向。通过选择前几个主成分,可以有效地保留数据的关键信息,同时降低维度。

# 2. PCA原理

PCA是一种线性降维技术,其原理是将高维数据投影到低维空间中,同时尽可能保留数据的方差。

### 2.1 协方差矩阵和特征值分解

协方差矩阵是衡量数据集中变量之间相关性的矩阵。对于一个具有n个变量的数据集,其协方差矩阵C为一个n×n矩阵,其中元素Cij表示变量xi和xj之间的协方差。

特征值分解是将协方差矩阵分解为特征值和特征向量的过程。特征值表示协方差矩阵沿其特征向量方向的方差。特征向量表示协方差矩阵沿其特征向量方向的单位向量。

### 2.2 主成分的计算

PCA的主要步骤是计算协方差矩阵的特征值和特征向量。特征值和特征向量可以用来计算主成分,即数据集中方差最大的方向。

主成分是协方差矩阵特征向量组成的正交基。第一个主成分是沿协方差矩阵特征值最大的特征向量方向的单位向量。第二个主成分是沿协方差矩阵特征值第二大的特征向量方向的单位向量,以此类推。

### 2.3 降维过程

降维过程是将数据投影到主成分上。对于一个具有n个变量的数据集,其降维后的数据为一个k×n矩阵,其中k是降维后的维度。

```python

import numpy as np

from sklearn.decomposition import PCA

# 数据

data = np.array([[1, 2, 3], [4, 5, 6], [7, 8, 9]])

# PCA模型

pca = PCA(n_components=2)

pca.fit(data)

# 降维后的数据

data_reduced = pca.transform(data)

```

代码逻辑:

1. 导入NumPy和Scikit-Learn的PCA模块。

2. 创建一个3×3的数据集。

3. 创建一个PCA模型,指定降维后的维度为2。

4. 拟合PCA模型到数据。

5. 使用PCA模型对数据进行降维。

参数说明:

* `n_components`:降维后的维度。

# 3. PCA实践

### 3.1 数据预处理

在应用PCA之前,需要对数据进行预处理,以确保数据质量和模型的有效性。数据预处理步骤包括:

- **缺失值处理:**处理缺失值的方法有删除、插补或使用缺失值指示符。

- **异常值处理:**异常值可能会对PCA结果产生较大影响,需要将其删除或转换。

- **数据标准化:**不同特征的单位和范围可能不同,需要对数据进行标准化,以消除量纲的影响。

### 3.2 PCA模型的构建和评估

PCA模型的构建和评估过程如下:

1. **协方差矩阵计算:**计算输入数据的协方差矩阵,协方差矩阵反映了特征之间的相关性。

2. **特征值分解:**对协方差矩阵进行特征值分解,得到特征值和特征向量。

3. **主成分选择:**选择特征值最大的主成分,这些主成分代表了数据中最大的方差。

4. **降维变换:**将原始数据投影到主成分上,得到降维后的数据。

PCA模型的评估指标包括:

- **累计方差贡献率:**表示主成分解释了原始数据中多少方差。

- **奇异值:**表示主成分的方差。

- **重建误差:**表示降维后数据与原始数据的差异程度。

### 3.3 降维后的数据分析

降维后的数据可以用于各种分析任务,例如:

- **可视化:**将降维后的数据可视化,可以帮助识别数据中的模式和结构。

- **聚类:**对降维后的数据进行聚类,可以识别数据中的不同组或类别。

- **分类:**使用降维后的数据训练分类模型,可以提高分类的准确性。

- **回归:**使用降维后的数据训练回归模型,可以提高回归的预测能力。

**代码块:**

```python

import numpy as np

from sklearn.decomposition import PCA

# 数据预处理

data = np.array([[1, 2, 3], [4, 5, 6], [7, 8, 9]])

data_normalized = (data - np.mean(data)) / np.std(data)

# PCA模型构建

pca = PCA(n_components=2)

pca.fit(data_normalized)

# 降维变换

data_reduced = pca.transform(data_normalized)

```

**逻辑分析:**

- `data_normalized`是标准化后的数据。

- `pca`是一个PCA模型,`n_components`参数指定降维后的主成分数。

- `pca.fit()`方法拟合PCA模型。

- `data_reduced`是降维后的数据。

**参数说明:**

- `n_components`:降维后的主成分数。

- `whiten`:是否对降维后的数据进行白化处理。

- `svd_solver`:特征值分解的求解方法。

# 4. PCA进阶应用

### 4.1 PCA在图像处理中的应用

**人脸识别**

PCA在人脸识别中发挥着至关重要的作用。通过将高维的人脸图像投影到低维的主成分空间中,可以有效地减少数据维度,同时保留人脸的关键特征。这种降维过程不仅提高了识别效率,还降低了计算成本。

```python

import numpy as np

from sklearn.decomposition import PCA

# 加载人脸图像数据集

faces = np.load('faces.npy')

# 构建PCA模型

pca = PCA(n_components=100)

pca.fit(faces)

# 将人脸图像投影到主成分空间

projected_faces = pca.transform(faces)

# 使用投影后的数据进行人脸识别

```

**图像压缩**

PCA还可以用于图像压缩。通过将图像表示为其主成分的线性组合,可以大大减少图像文件的大小,同时保持图像质量。

```python

import cv2

# 加载图像

image = cv2.imread('image.jpg')

# 转换为灰度图像

gray_image = cv2.cvtColor(image, cv2.COLOR_BGR2GRAY)

# 构建PCA模型

pca = PCA(n_components=100)

pca.fit(gray_image)

# 将图像投影到主成分空间

projected_image = pca.transform(gray_image)

# 重建图像

reconstructed_image = pca.inverse_transform(projected_image)

# 保存压缩后的图像

cv2.imwrite('compressed_image.jpg', reconstructed_image)

```

### 4.2 PCA在自然语言处理中的应用

**文本分类**

PCA在文本分类中可以帮助提取文本数据的关键特征。通过将高维的文本数据投影到低维的主成分空间中,可以有效地减少数据维度,同时保留文本的语义信息。

```python

import numpy as np

from sklearn.decomposition import PCA

from sklearn.linear_model import LogisticRegression

# 加载文本数据集

texts = np.load('texts.npy')

# 构建PCA模型

pca = PCA(n_components=100)

pca.fit(texts)

# 将文本数据投影到主成分空间

projected_texts = pca.transform(texts)

# 构建逻辑回归分类器

classifier = LogisticRegression()

classifier.fit(projected_texts, labels)

# 使用投影后的数据进行文本分类

```

**主题建模**

PCA还可以用于自然语言处理中的主题建模。通过将高维的文本数据投影到低维的主成分空间中,可以识别文本中的潜在主题。

```python

import numpy as np

from sklearn.decomposition import PCA

from sklearn.feature_extraction.text import TfidfVectorizer

# 加载文本数据集

texts = np.load('texts.npy')

# 构建TF-IDF向量化器

vectorizer = TfidfVectorizer()

tfidf_matrix = vectorizer.fit_transform(texts)

# 构建PCA模型

pca = PCA(n_components=10)

pca.fit(tfidf_matrix)

# 将文本数据投影到主成分空间

projected_texts = pca.transform(tfidf_matrix)

# 分析主成分,识别潜在主题

```

### 4.3 PCA在生物信息学中的应用

**基因表达分析**

PCA在基因表达分析中可以帮助识别基因表达模式和异常。通过将高维的基因表达数据投影到低维的主成分空间中,可以可视化基因表达的变化,并识别与疾病或其他生物学过程相关的基因。

```python

import numpy as np

from sklearn.decomposition import PCA

import matplotlib.pyplot as plt

# 加载基因表达数据

gene_expression_data = np.load('gene_expression_data.npy')

# 构建PCA模型

pca = PCA(n_components=2)

pca.fit(gene_expression_data)

# 将基因表达数据投影到主成分空间

projected_gene_expression_data = pca.transform(gene_expression_data)

# 可视化基因表达模式

plt.scatter(projected_gene_expression_data[:, 0], projected_gene_expression_data[:, 1])

plt.show()

```

**疾病诊断**

PCA还可以用于疾病诊断。通过将患者的生物医学数据(如基因表达数据、影像数据等)投影到低维的主成分空间中,可以识别与疾病相关的特征,并辅助疾病诊断。

```python

import numpy as np

from sklearn.decomposition import PCA

from sklearn.linear_model import LogisticRegression

# 加载患者生物医学数据

patient_data = np.load('patient_data.npy')

# 构建PCA模型

pca = PCA(n_components=10)

pca.fit(patient_data)

# 将患者数据投影到主成分空间

projected_patient_data = pca.transform(patient_data)

# 构建逻辑回归分类器

classifier = LogisticRegression()

classifier.fit(projected_patient_data, labels)

# 使用投影后的数据进行疾病诊断

```

# 5. PCA的局限性和替代方案**

PCA是一种强大的降维技术,但它也存在一些局限性。

**局限性:**

* **线性转换:**PCA仅适用于线性可分的特征。对于非线性数据,PCA可能无法有效降维。

* **数据丢失:**降维过程会不可避免地导致信息丢失,特别是当舍弃的特征包含重要信息时。

* **解释性差:**PCA生成的主成分可能难以解释,这使得它难以理解降维后的数据。

* **对异常值敏感:**异常值会对PCA模型产生重大影响,导致不准确的降维结果。

**替代方案:**

为了克服PCA的局限性,可以考虑以下替代方案:

* **t-SNE(t分布随机邻域嵌入):**一种非线性降维技术,可以处理非线性数据。

* **MDS(多维标度):**一种基于距离的降维技术,可以保留数据之间的距离关系。

* **UMAP(统一流形近似和投影):**一种基于拓扑的降维技术,可以生成具有良好局部和全局保真度的低维表示。

* **Autoencoder(自动编码器):**一种神经网络模型,可以学习数据的非线性表示,并进行降维。

在选择降维技术时,需要考虑数据的类型、目标和PCA的局限性。通过仔细评估替代方案,可以找到最适合特定应用的降维技术。

0

0