主成分分析(PCA)实战指南:5个案例解析,手把手教你降维

发布时间: 2024-08-20 06:02:46 阅读量: 46 订阅数: 48

# 1. 主成分分析(PCA)简介

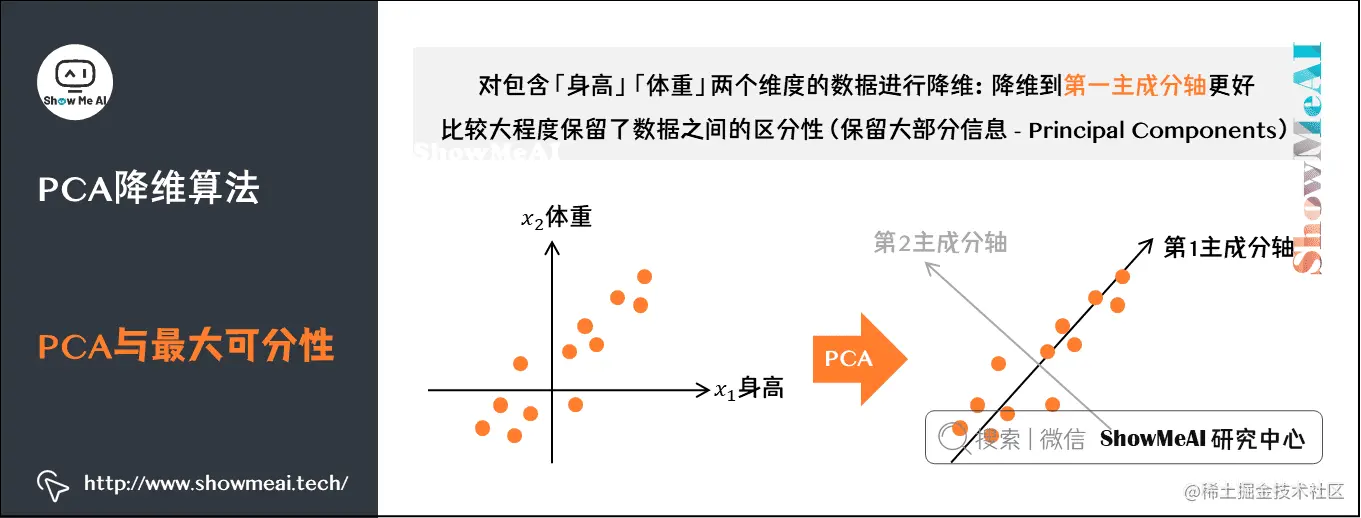

主成分分析(PCA)是一种降维技术,用于将高维数据投影到低维空间中,同时保留原始数据中最重要的信息。PCA通过寻找数据中方差最大的方向(主成分)来实现降维,从而保留了数据中的大部分信息。

PCA广泛应用于各种领域,包括数据可视化、异常值检测、特征提取和降噪。在数据科学和机器学习中,PCA是一种重要的预处理技术,可以提高模型的性能和可解释性。

# 2. PCA的数学原理

### 2.1 协方差矩阵和特征值分解

**协方差矩阵**

协方差矩阵是一个对称矩阵,其元素表示不同特征之间的协方差。对于一个包含n个样本和m个特征的数据集,其协方差矩阵C定义为:

```python

C = 1/(n-1) * X^T * X

```

其中,X是数据矩阵,每一行代表一个样本,每一列代表一个特征。

**特征值分解**

协方差矩阵的特征值分解将矩阵分解为以下形式:

```

C = V * D * V^T

```

其中,V是特征向量矩阵,每一列是一个特征向量;D是对角矩阵,其对角线元素是特征值。

### 2.2 主成分的提取和解释

**主成分**

特征值分解将协方差矩阵分解为一组正交特征向量和对应的特征值。这些特征向量就是主成分。

**解释方差**

每个主成分解释了数据集中总方差的一定比例。第i个主成分解释的方差比例为:

```

λ_i / Σλ_j

```

其中,λ_i是第i个特征值,Σλ_j是所有特征值的和。

**主成分的解释**

主成分可以被解释为数据集中线性相关的特征的组合。例如,如果两个特征高度相关,那么它们的主成分将表示这两个特征的线性组合,解释了这两个特征的共同方差。

**代码示例**

以下Python代码演示了协方差矩阵的特征值分解和主成分的提取:

```python

import numpy as np

from sklearn.decomposition import PCA

# 数据矩阵

X = np.array([[1, 2, 3], [4, 5, 6], [7, 8, 9]])

# 协方差矩阵

C = np.cov(X)

# 特征值分解

eig_vals, eig_vecs = np.linalg.eig(C)

# 主成分

pca = PCA(n_components=2)

pca.fit(X)

```

# 3. PCA实战应用

### 3.1 数据预处理和归一化

在PCA实战应用中,数据预处理和归一化是至关重要的步骤。数据预处理包括数据清洗、缺失值处理、异常值处理等操作,目的是去除噪声和异常数据,确保数据质量。归一化则可以消除不同特征量纲的影响,使数据处于同一量级,提高PCA算法的性能。

#### 数据清洗

数据清洗是去除数据中错误、缺失或不一致的数据的过程。常见的清洗方法包括:

- **删除缺失值:**对于缺失值较多的特征,可以考虑直接删除该特征或该样本。

- **填充缺失值:**对于缺失值较少的特征,可以使用均值、中位数或众数等方法填充缺失值。

- **去除异常值:**异常值是指明显偏离数据分布的点,可以考虑删除或替换异常值。

#### 归一化

归一化是将数据映射到特定范围的过程,通常将数据归一化到[0, 1]或[-1, 1]的范围内。常见的归一化方法包括:

- **最小-最大归一化:**将数据线性变换到[0, 1]的范围内,公式为:

```python

x_normalized = (x - x_min) / (x_max - x_min)

```

其中,`x`为原始数据,`x_min`和`x_max`分别为原始数据的最小值和最大值。

- **标准化:**将数据线性变换到均值为0,标准差为1的范围内,公式为:

```python

x_normalized = (x - x_mean) / x_std

```

其中,`x`为原始数据,`x_mean`和`x_std`分别为原始数据的均值和标准差。

### 3.2 PCA模型构建和评估

数据预处理和归一化完成后,就可以构建PCA模型了。PCA模型构建的过程如下:

1. 计算协方差矩阵:协方差矩阵反映了不同特征之间的相关性。

2. 求解协方差矩阵的特征值和特征向量:特征值表示协方差矩阵沿不同方向的方差,特征向量表示协方差矩阵沿不同方向的单位向量。

3. 选择主成分:根据特征值的大小选择主成分,特征值越大的主成分越重要。

PCA模型构建完成后,需要评估模型的性能。常用的评估指标包括:

- **累计方差贡献率:**衡量主成分解释原始数据方差的程度,公式为:

```python

cumulative_variance_ratio = sum(eigenvalues[:k]) / sum(eigenvalues)

```

其中,`k`为选取的主成分数,`eigenvalues`为特征值。

- **重建误差:**衡量PCA模型重建原始数据的准确性,公式为:

```python

reconstruction_error = mean_squared_error(original_data, reconstructed_data)

```

其中,`original_data`为原始数据,`reconstructed_data`为PCA模型重建的数据。

# 4. PCA降维案例解析

### 4.1 高维数据可视化

在实际应用中,高维数据往往难以直观地展示和理解。PCA可以将高维数据投影到低维空间,从而实现数据的可视化。

**案例:手写数字图像降维**

考虑一个包含 784 个特征(28×28 像素)的手写数字图像数据集。使用 PCA 将数据投影到 2 维空间,并绘制散点图:

```python

import numpy as np

import pandas as pd

import matplotlib.pyplot as plt

# 加载手写数字图像数据集

data = pd.read_csv('digits.csv')

X = data.drop('label', axis=1).values

# 标准化数据

X = (X - np.mean(X)) / np.std(X)

# PCA 降维

from sklearn.decomposition import PCA

pca = PCA(n_components=2)

X_pca = pca.fit_transform(X)

# 可视化降维后的数据

plt.scatter(X_pca[:, 0], X_pca[:, 1], c=data['label'])

plt.colorbar()

plt.show()

```

**逻辑分析:**

* `X` 矩阵存储了标准化后的手写数字图像数据。

* `pca` 对象使用 PCA 将数据投影到 2 维空间。

* `X_pca` 矩阵包含降维后的数据。

* 散点图展示了降维后的数据,其中不同颜色表示不同的数字标签。

### 4.2 异常值检测和数据清洗

PCA 还可以用于异常值检测和数据清洗。异常值是与其他数据点明显不同的数据点。PCA 可以将数据投影到低维空间,并识别与主成分方向明显偏离的数据点。

**案例:异常值检测和移除**

考虑一个包含 1000 个样本和 10 个特征的数据集。使用 PCA 将数据投影到 2 维空间,并绘制散点图:

```python

import numpy as np

import pandas as pd

import matplotlib.pyplot as plt

# 加载数据集

data = pd.read_csv('data.csv')

X = data.drop('label', axis=1).values

# 标准化数据

X = (X - np.mean(X)) / np.std(X)

# PCA 降维

from sklearn.decomposition import PCA

pca = PCA(n_components=2)

X_pca = pca.fit_transform(X)

# 可视化降维后的数据

plt.scatter(X_pca[:, 0], X_pca[:, 1])

plt.show()

# 识别异常值

threshold = 3 # 异常值阈值

outliers = np.where(np.abs(X_pca) > threshold)[0]

# 移除异常值

X_clean = np.delete(X, outliers, axis=0)

```

**逻辑分析:**

* `threshold` 参数设置异常值阈值。

* `outliers` 数组存储了异常值索引。

* `X_clean` 矩阵包含了移除异常值后的数据。

**参数说明:**

* `n_components`:PCA 降维后的主成分数。

* `threshold`:异常值检测阈值。

# 5.1 图像处理和人脸识别

PCA在图像处理和人脸识别领域有着广泛的应用。在图像处理中,PCA可用于图像降噪、图像压缩和图像增强。在人脸识别中,PCA可用于人脸识别、人脸检测和人脸表情识别。

**图像降噪**

图像降噪是图像处理中的一项重要任务。PCA可以通过提取图像中的主成分来去除噪声。主成分是图像中方差最大的分量,它们包含了图像中的大部分信息。通过去除方差较小的分量,可以有效地去除噪声。

**代码块:**

```python

import numpy as np

from sklearn.decomposition import PCA

# 加载图像

image = cv2.imread('image.jpg')

# 转换为灰度图

gray_image = cv2.cvtColor(image, cv2.COLOR_BGR2GRAY)

# 归一化

gray_image = gray_image / 255.0

# PCA降噪

pca = PCA(n_components=0.95)

pca.fit(gray_image)

denoised_image = pca.inverse_transform(pca.components_)

# 显示降噪后的图像

cv2.imshow('Denoised Image', denoised_image)

cv2.waitKey(0)

cv2.destroyAllWindows()

```

**逻辑分析:**

* `PCA(n_components=0.95)`:创建一个PCA模型,保留95%的方差。

* `fit(gray_image)`:将归一化的灰度图像拟合到PCA模型中。

* `inverse_transform(pca.components_)`:使用PCA模型的组件重建降噪后的图像。

**图像压缩**

图像压缩是将图像文件大小减小的一种技术。PCA可以通过去除图像中的冗余信息来实现图像压缩。冗余信息是指图像中重复或相关的信息。通过去除冗余信息,可以有效地减小图像文件大小。

**代码块:**

```python

import numpy as np

from sklearn.decomposition import PCA

# 加载图像

image = cv2.imread('image.jpg')

# 转换为灰度图

gray_image = cv2.cvtColor(image, cv2.COLOR_BGR2GRAY)

# 归一化

gray_image = gray_image / 255.0

# PCA压缩

pca = PCA(n_components=100)

pca.fit(gray_image)

compressed_image = pca.inverse_transform(pca.components_)

# 保存压缩后的图像

cv2.imwrite('compressed_image.jpg', compressed_image)

```

**逻辑分析:**

* `PCA(n_components=100)`:创建一个PCA模型,保留100个主成分。

* `fit(gray_image)`:将归一化的灰度图像拟合到PCA模型中。

* `inverse_transform(pca.components_)`:使用PCA模型的组件重建压缩后的图像。

**人脸识别**

人脸识别是识别和验证人脸的一种技术。PCA可以通过提取人脸图像中的主成分来实现人脸识别。主成分是人脸图像中方差最大的分量,它们包含了人脸图像中的大部分信息。通过比较不同人脸图像的主成分,可以有效地识别和验证人脸。

**代码块:**

```python

import numpy as np

from sklearn.decomposition import PCA

from sklearn.svm import SVC

# 加载人脸图像

face_images = []

for i in range(1, 11):

image = cv2.imread(f'face_{i}.jpg')

gray_image = cv2.cvtColor(image, cv2.COLOR_BGR2GRAY)

face_images.append(gray_image)

# 归一化

face_images = np.array(face_images) / 255.0

# PCA降维

pca = PCA(n_components=100)

pca.fit(face_images)

face_components = pca.transform(face_images)

# 训练SVM分类器

svm = SVC()

svm.fit(face_components, [i for i in range(1, 11)])

# 识别新的人脸图像

new_image = cv2.imread('new_face.jpg')

gray_image = cv2.cvtColor(new_image, cv2.COLOR_BGR2GRAY)

new_image = gray_image / 255.0

new_components = pca.transform([new_image])

predicted_label = svm.predict(new_components)

# 显示识别结果

print(f'识别结果:{predicted_label}')

```

**逻辑分析:**

* `PCA(n_components=100)`:创建一个PCA模型,保留100个主成分。

* `fit(face_images)`:将归一化的人脸图像拟合到PCA模型中。

* `transform(face_images)`:使用PCA模型将人脸图像转换为主成分。

* `SVC()`:创建一个SVM分类器。

* `fit(face_components, [i for i in range(1, 11)])`:将主成分和对应的标签拟合到SVM分类器中。

* `transform([new_image])`:使用PCA模型将新的人脸图像转换为主成分。

* `predict(new_components)`:使用SVM分类器预测新的人脸图像的标签。

# 6.1 核PCA和流形学习

### 核PCA

经典PCA假设数据在原始特征空间中是线性可分的。然而,在实际应用中,数据往往是非线性的,无法通过线性变换投影到低维空间。核PCA通过引入核函数将数据映射到高维特征空间,使其在高维空间中线性可分。

核函数的作用是将原始特征空间中的数据点映射到一个更高维度的特征空间,在这个高维特征空间中,数据点之间的关系变得线性可分。常用的核函数包括:

- 线性核:`K(x, y) = x^T y`

- 多项式核:`K(x, y) = (x^T y + c)^d`

- 高斯核:`K(x, y) = exp(-||x - y||^2 / (2σ^2))`

### 流形学习

流形学习是一种非线性降维技术,它假设数据分布在一个低维流形上,流形是嵌入在高维空间中的一个低维子空间。流形学习算法通过寻找数据点之间的局部邻域关系,将数据投影到流形上。

常用的流形学习算法包括:

- 局部线性嵌入(LLE)

- 等距映射(Isomap)

- t分布随机邻域嵌入(t-SNE)

流形学习算法通常需要指定一个超参数,该超参数控制流形的维度。较低的维度可以更好地保留数据的局部结构,而较高的维度可以更好地保留数据的全局结构。

### 优化

PCA的优化主要集中在以下几个方面:

- **计算效率:**对于大规模数据集,PCA的计算量可能非常大。可以使用随机抽样、近似算法和分布式计算等技术来提高计算效率。

- **鲁棒性:**PCA对异常值和噪声数据敏感。可以使用稳健PCA等方法来提高PCA的鲁棒性。

- **可解释性:**PCA的主成分可能难以解释。可以使用旋转PCA等方法来提高PCA的主成分的可解释性。

0

0