机器学习中的PCA降维:化繁为简,提升模型性能

发布时间: 2024-08-20 06:10:33 阅读量: 52 订阅数: 48

# 1. 机器学习中的降维概述

降维是一种在机器学习中广泛使用的技术,它可以将高维数据投影到低维空间,同时保留原始数据中最重要的信息。在机器学习中,降维的主要目标是:

* **减少数据冗余:**去除数据中的相关性,从而提高模型训练效率。

* **提高模型性能:**通过减少数据维度,可以降低模型过拟合的风险,从而提高模型的泛化能力。

# 2. PCA降维原理与算法

### 2.1 PCA的数学原理

#### 2.1.1 协方差矩阵和特征值分解

协方差矩阵是一个对称方阵,其元素表示不同特征之间的协方差。对于一个数据集中的n个样本,每个样本有m个特征,协方差矩阵C的元素C(i, j)计算如下:

```python

C(i, j) = 1 / (n - 1) * sum((x_i - x_i_mean) * (x_j - x_j_mean))

```

其中,x_i和x_j是第i个和第j个特征,x_i_mean和x_j_mean是其对应的均值。

特征值分解(EVD)将协方差矩阵分解为特征值和特征向量。特征值表示协方差矩阵沿其特征向量方向的方差。特征向量是协方差矩阵沿其特征值方向的单位向量。

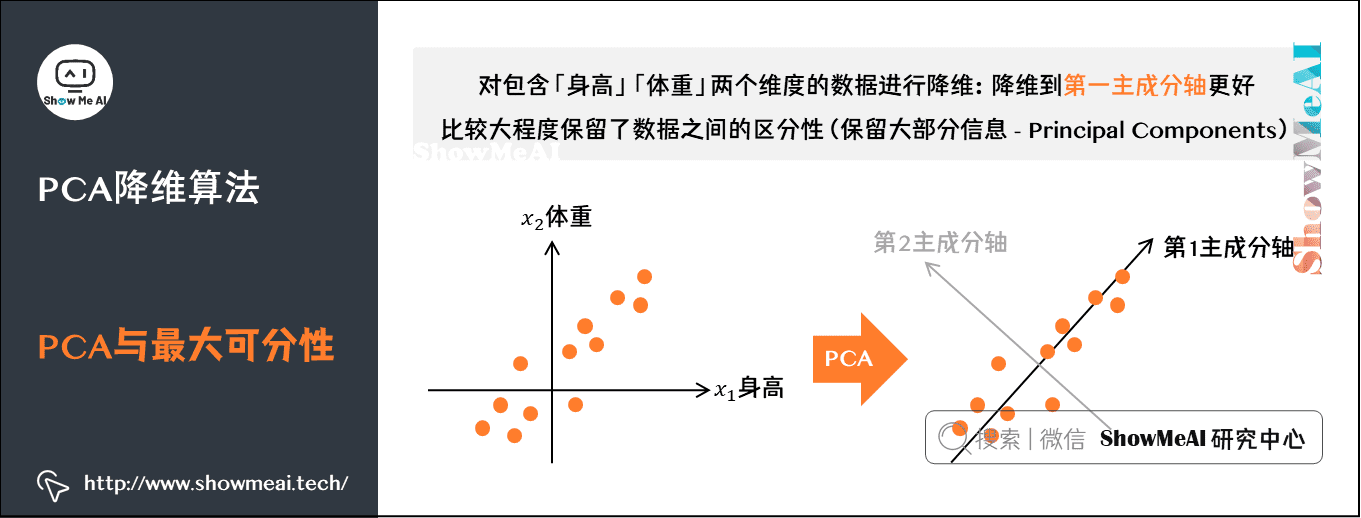

#### 2.1.2 主成分的计算和解释

主成分是协方差矩阵特征向量对应的单位向量。每个主成分表示数据集中方差最大的方向。主成分按其对应的特征值从大到小排序,因此前k个主成分包含了数据集中方差最大的k个方向。

主成分的计算过程如下:

1. 计算协方差矩阵C。

2. 对C进行特征值分解,得到特征值λ_1, λ_2, ..., λ_m和特征向量v_1, v_2, ..., v_m。

3. 将特征向量按其对应的特征值从大到小排序,得到主成分u_1, u_2, ..., u_m。

### 2.2 PCA的算法实现

#### 2.2.1 奇异值分解(SVD)

奇异值分解(SVD)是一种数值分解技术,可以将矩阵分解为三个矩阵的乘积:

```

A = U * Σ * V^T

```

其中,U和V是正交矩阵,Σ是对角矩阵,其对角线元素是A的奇异值。

对于协方差矩阵C,其SVD分解为:

```

C = U * Σ * U^T

```

其中,U的列向量就是PCA的主成分,Σ的对角线元素就是主成分对应的特征值。

#### 2.2.2 主成分分析(PCA)

主成分分析(PCA)是一种直接计算主成分的算法,其步骤如下:

1. 计算协方差矩阵C。

2. 对C进行特征值分解,得到特征值λ_1, λ_2, ..., λ_m和特征向量v_1, v_2, ..., v_m。

3. 将特征向量按其对应的特征值从大到小排序,得到主成分u_1, u_2, ..., u_m。

# 3. PCA降维在机器学习中的应用

### 3.1 PCA用于数据预处理

#### 3.1.1 减少数据冗余和噪声

PCA降维可以通过去除数据中的冗余和噪声来提高机器学习模型的性能。冗余是指数据中存在高度相关的特征,而噪声是指数据中存在不相关的或异常的数据点。PCA通过将数据投影到主成分子空间中来解决这些问题。主成分子空间包含了数据中方差最大的方向,这些方向代表了数据中最重要的信息。通过投影到主成分子空间,冗余和噪声会被最小化,从而提高数据质量。

#### 3

0

0