【从理论到实践】:神经网络超参数调优案例分析全解

发布时间: 2024-09-05 16:25:40 阅读量: 50 订阅数: 31

# 1. 神经网络超参数调优概述

神经网络超参数调优是机器学习中的关键步骤,它涉及选择和优化模型配置以获得最佳性能。超参数包括学习率、批次大小、优化器选择、网络层数等,这些因素直接影响模型的训练过程和最终表现。理解超参数的本质及其对模型性能的影响至关重要。有效的调优不仅需要理论知识,还需要实践经验,以达到预期的精度和泛化能力。本章节将为读者提供一个关于神经网络超参数调优的宏观视角,概述其重要性、常见方法和面临的挑战。

# 2. 神经网络基础知识与理论

## 2.1 神经网络基本结构

### 2.1.1 神经元与激活函数

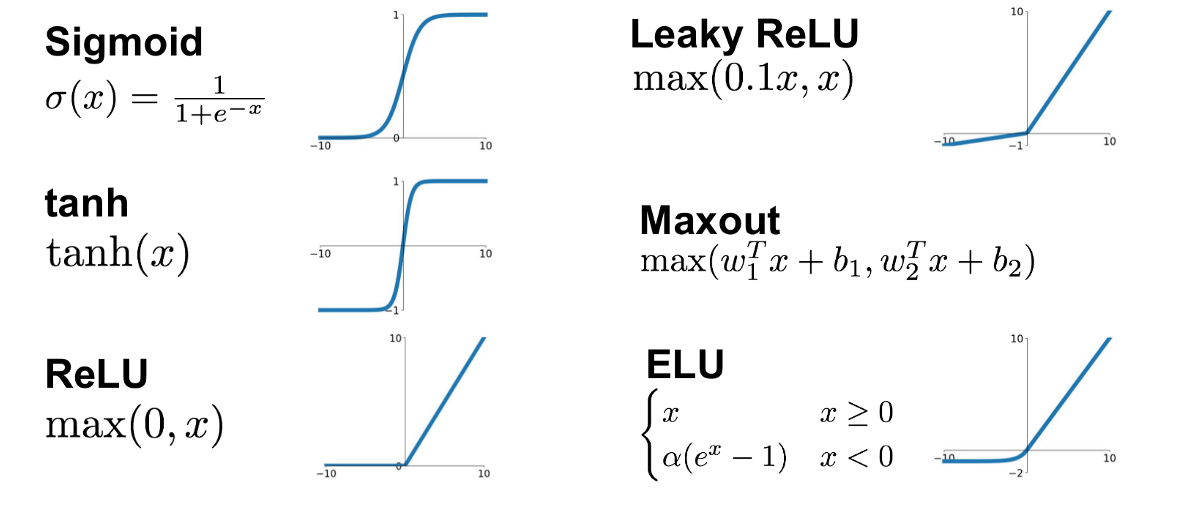

神经网络由大量的节点组成,这些节点被称为神经元,它们模仿生物神经系统的结构和功能。每个神经元接收输入信号,进行加权求和,然后通过一个非线性函数(激活函数)产生输出信号。激活函数的存在允许网络学习和执行复杂的任务,如分类和回归分析。

激活函数的选择对模型的性能有着直接影响。常见的激活函数包括:

- Sigmoid 函数:输出范围在0到1之间,适合二分类问题。

- Tanh 函数:输出范围在-1到1之间,与Sigmoid类似,但中心更接近于零。

- ReLU(Rectified Linear Unit)函数:输出输入中的最大值,即 `max(0, x)`,它在实践中非常流行,因为它加速了训练过程并减少梯度消失问题。

- Softmax 函数:常用于多类分类的输出层,它将一个固定大小的向量压缩成一个概率分布。

在选择激活函数时,需要考虑任务的性质和网络结构,以确保模型能够准确学习和预测。

### 2.1.2 前馈与反向传播算法

神经网络的学习过程涉及信息的前馈传播和权重的反向更新。在前馈传播中,输入数据通过网络层逐层传递,直至输出层产生预测结果。如果预测结果与真实结果存在差异,就需要通过反向传播算法调整权重。

反向传播算法通过链式法则计算损失函数关于网络权重的梯度,然后通过梯度下降法或其他优化算法更新权重,以最小化损失函数。

## 2.2 超参数的作用与分类

### 2.2.1 超参数与模型性能的关系

超参数是神经网络训练前设置的参数,它们不是通过训练过程直接学习得到的,而是需要根据经验预先设定。超参数包括网络架构、学习速率、批量大小、正则化强度等。

超参数的选择对模型的性能有着决定性的影响。不恰当的超参数设置可能导致模型过拟合或欠拟合,影响模型的泛化能力。因此,研究超参数与模型性能之间的关系,对于提高模型准确性和效率至关重要。

### 2.2.2 常见超参数详解

- **网络架构**:包括层数、每层的神经元数等。过深的网络可能导致梯度消失或爆炸,而过浅的网络可能无法捕捉复杂模式。

- **学习速率**:决定了权重更新的速度和幅度。学习速率过高可能导致训练过程不稳定,过低则可能导致收敛速度过慢。

- **批量大小**:影响内存使用、计算速度和模型稳定性。较大的批量大小可以加快单次权重更新,但可能减少泛化能力。

- **正则化强度**:包括L1、L2正则化项系数,用于防止过拟合。正则化过强会压制模型的表达能力,过弱则失去防止过拟合的效果。

## 2.3 超参数调优方法论

### 2.3.1 调优策略与算法概述

超参数调优是寻找最佳超参数组合的过程,这通常是一个尝试和错误的过程。调优策略主要有网格搜索、随机搜索、贝叶斯优化等。

- **网格搜索**:通过枚举所有可能的超参数组合来寻找最佳配置,但其计算成本随着超参数数量和范围的增加而显著增加。

- **随机搜索**:从指定的超参数分布中随机选择值进行尝试,比网格搜索更高效,尤其是在超参数空间很大时。

- **贝叶斯优化**:基于贝叶斯原理,通过概率模型来指导搜索过程,能够更智能地选择接下来的参数组合。

### 2.3.2 调优过程中的最佳实践

在实际操作中,以下是一些超参数调优的最佳实践:

- **明确优化目标**:确定优化目标(例如最小化损失函数)和评估指标(如准确率)。

- **预设合理的范围和分布**:根据问题的特性和计算资源预设合理的超参数范围和分布。

- **使用交叉验证**:通过交叉验证减少过拟合并更准确地估计超参数的影响。

- **记录和分析**:记录每一次实验的配置和结果,分析哪些超参数或参数组合效果更好。

- **多阶段调优**:先使用粗糙的网格或随机搜索进行宽泛的搜索,然后使用贝叶斯优化进行精细化搜索。

以上内容展示了神经网络的超参数调优的基础知识和理论,接下来我们将深入探讨超参数调优的实践经验。

# 3. 超参数调优的实践经验

在深度学习领域,超参数调优是提升模型性能的关键步骤之一。超参数的调整往往需要大量的尝试与实践,如何根据经验选择合适的优化器、调整学习率、优化网络结构是本章节将深入探讨的话题。

## 3.1 实战:选择合适的优化器

### 3.1.1 优化器选择的影响因素

在训练神经网络时,优化器是调整参数的重要工具,它影响着模型收敛的速度和最终性能。选择一个合适的优化器需要考虑多个因素,包括但不限于数据集的大小、模型的复杂度、以及计算资源的限制。

### 3.1.2 实例对比分析

为了更好地理解不同优化器的效果,我们可以通过一个案例来进行比较。例如,可以对一个标准的图像分类任务,分别使用SGD(随机梯度下降)、Adam、RMSprop等不同的优化器进行训练,并记录下它们的损失函数下降曲线、收敛速度及准确率。

```python

import tensorflow as tf

from tensorflow import keras

# 定义模型结构

model = keras.Sequential([

keras.layers.Flatten(input_shape=(28, 28)),

keras.layers.Dense(128, activation='relu'),

keras.layers.Dense(10, activation='softmax')

])

# 编译模型

***pile(optimizer='SGD', loss='sparse_categorical_crossentropy', metrics=['accuracy'])

# 训练模型

history_sgd = model.fit(train_images, train_labels, epochs=10, validation_split=0.2)

# 更换优化器为Adam并重新编译模型

***pile(optimizer='Adam', loss='

```

0

0