揭秘线性回归:预测模型的秘密武器,助你洞悉数据奥秘

发布时间: 2024-07-01 16:40:34 阅读量: 53 订阅数: 41

线性回归分析的预测模型

# 1. 线性回归概述**

线性回归是一种强大的预测模型,它利用一条直线来描述两个或多个变量之间的关系。它广泛应用于各种领域,从金融预测到医疗诊断。

线性回归模型假设数据点分布在一条直线上,该直线由方程 y = mx + c 表示,其中 m 是斜率,c 是截距。模型的目标是找到最佳拟合直线,以最小化数据点与直线之间的距离。

为了找到最佳拟合直线,线性回归使用最小二乘法。该方法通过最小化平方误差(数据点与直线之间的距离的平方和)来确定 m 和 c 的值。

# 2. 线性回归理论基础

### 2.1 线性模型与假设

线性回归是一种统计建模技术,它假设数据点可以由一条直线拟合。这条直线被称为回归线,它表示自变量(x)和因变量(y)之间的线性关系。

**线性模型方程:**

```

y = mx + b

```

其中:

* y 是因变量

* x 是自变量

* m 是斜率

* b 是截距

**线性回归假设:**

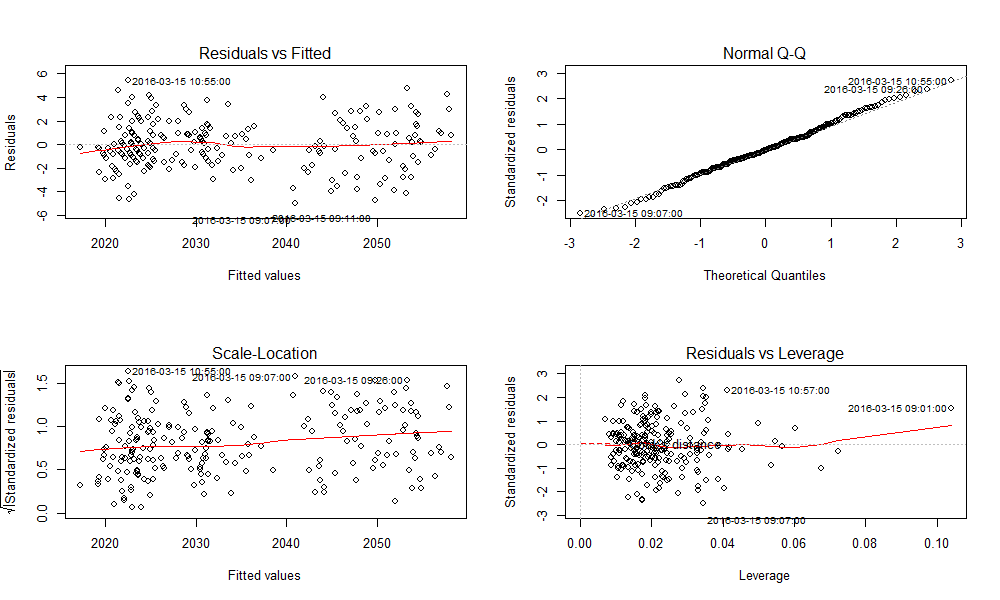

* **线性关系:**自变量和因变量之间存在线性关系。

* **独立性:**自变量之间是独立的。

* **正态分布:**因变量的误差项服从正态分布。

* **同方差性:**因变量的误差项具有相同的方差。

### 2.2 最小二乘法与损失函数

最小二乘法是一种优化技术,用于寻找最佳拟合直线,即使预测值与实际值之间的平方误差最小。

**损失函数:**

```

J(m, b) = Σ(y_i - (mx_i + b))^2

```

其中:

* J(m, b) 是损失函数

* y_i 是第 i 个数据点的实际值

* x_i 是第 i 个数据点的自变量值

* m 是斜率

* b 是截距

最小二乘法通过迭代调整 m 和 b 的值,使损失函数 J(m, b) 最小化。

### 2.3 模型评估指标

为了评估线性回归模型的性能,可以使用以下指标:

**均方误差(MSE):**衡量预测值与实际值之间的平均平方误差。

**均方根误差(RMSE):**MSE 的平方根,表示预测误差的标准差。

**决定系数(R^2):**衡量模型拟合程度,取值范围为 0 到 1,1 表示完美拟合。

**调整决定系数(Adjusted R^2):**考虑了模型的复杂度,惩罚过拟合。

# 3. 线性回归实践应用**

### 3.1 数据预处理与特征工程

在构建线性回归模型之前,对数据进行预处理和特征工程至关重要。这些步骤有助于提高模型的性能和鲁棒性。

**数据预处理**

* **缺失值处理:**使用均值、中位数或众数填充缺失值,或删除包含大量缺失值的样本。

* **异常值处理:**识别和删除异常值,因为它们可能会扭曲模型。

* **数据标准化:**将特征值缩放到相同的范围,以避免某些特征对模型产生过大影响。

**特征工程**

* **特征选择:**选择与目标变量最相关的特征,以提高模型的精度。

* **特征转换:**将原始特征转换为更具信息性的形式,例如对数转换或哑变量编码。

* **特征创建:**创建新的特征,例如特征之间的交互或多项式项,以捕获更复杂的非线性关系。

### 3.2 模型训练与调优

**模型训练**

* 选择一个损失函数,例如均方误差或绝对值误差。

* 使用最小二乘法或梯度下降算法优化损失函数。

* 确定模型的超参数,例如学习率和正则化参数。

**模型调优**

* **交叉验证:**将数据集分割成训练集和验证集,以避免过拟合。

* **网格搜索:**系统地搜索超参数的最佳组合。

* **正则化:**添加惩罚项以防止模型过拟合,例如 L1 正则化或 L2 正则化。

### 3.3 模型部署与评估

**模型部署**

* 将训练好的模型部署到生产环境中。

* 使用实时数据对模型进行评分。

**模型评估**

* 使用未见过的测试集评估模型的性能。

* 计算模型评估指标,例如均方根误差 (RMSE)、平均绝对误差 (MAE) 和 R 平方值。

* 监控模型的性能并根据需要进行重新训练或微调。

# 4.1 正则化与模型选择

### 4.1.1 正则化

**目的:**防止过拟合,提高模型泛化能力。

**原理:**在损失函数中加入正则化项,惩罚模型的复杂度。

**常见正则化方法:**

- **L1 正则化(Lasso 回归):**惩罚模型系数的绝对值,导致系数稀疏化。

- **L2 正则化(岭回归):**惩罚模型系数的平方值,导致系数平滑化。

**代码示例:**

```python

# 导入正则化方法

from sklearn.linear_model import Lasso, Ridge

# 创建正则化模型

lasso = Lasso(alpha=0.1) # L1 正则化,alpha 为正则化系数

ridge = Ridge(alpha=0.1) # L2 正则化,alpha 为正则化系数

```

### 4.1.2 模型选择

**目的:**选择最优的模型参数,包括正则化系数和模型复杂度。

**方法:**

- **交叉验证:**将数据集划分为多个子集,依次使用子集作为测试集和训练集,评估模型性能。

- **网格搜索:**遍历正则化系数和模型复杂度等参数的组合,选择性能最佳的模型。

**代码示例:**

```python

# 导入网格搜索模块

from sklearn.model_selection import GridSearchCV

# 设置正则化系数和模型复杂度的参数范围

param_grid = {'alpha': [0.01, 0.1, 1], 'max_depth': [3, 5, 7]}

# 创建网格搜索对象

grid_search = GridSearchCV(lasso, param_grid, cv=5) # cv 为交叉验证次数

# 执行网格搜索

grid_search.fit(X_train, y_train)

# 获取最优模型

best_model = grid_search.best_estimator_

```

### 4.1.3 模型复杂度

**概念:**模型参数的数量和结构的复杂程度。

**影响:**

- **模型复杂度过高:**容易过拟合,泛化能力差。

- **模型复杂度过低:**欠拟合,无法充分捕捉数据的规律。

**选择原则:**

- **奥卡姆剃刀原理:**在多个模型中,选择最简单的模型,即复杂度最低的模型。

- **偏差-方差权衡:**模型的偏差(欠拟合)和方差(过拟合)之间存在权衡关系,选择偏差和方差都较小的模型。

### 4.1.4 模型评估指标

**选择模型评估指标时应考虑:**

- **任务类型:**回归、分类、聚类等。

- **数据分布:**正态分布、非正态分布等。

- **业务目标:**预测准确度、泛化能力等。

**常见模型评估指标:**

- **回归任务:**均方误差(MSE)、平均绝对误差(MAE)、R 平方(R2)

- **分类任务:**准确率、召回率、F1 分数

- **聚类任务:**轮廓系数、戴维森堡指数(DBI)

**代码示例:**

```python

# 导入模型评估模块

from sklearn.metrics import mean_squared_error, r2_score

# 计算均方误差和 R 平方

mse = mean_squared_error(y_true, y_pred)

r2 = r2_score(y_true, y_pred)

```

# 5.1 预测股票价格

线性回归在金融领域有着广泛的应用,其中之一便是预测股票价格。通过建立股票价格与影响因素之间的线性关系模型,我们可以预测未来股票价格的走势。

### 数据准备

预测股票价格需要收集历史股票数据,包括开盘价、收盘价、最高价、最低价、成交量等指标。这些数据可以通过金融数据平台或API获取。

### 特征工程

影响股票价格的因素众多,包括宏观经济指标、公司财务数据、市场情绪等。在特征工程阶段,需要对这些因素进行筛选和处理,提取出与股票价格相关性较高的特征。

### 模型训练

根据选定的特征,我们可以建立线性回归模型:

```python

import numpy as np

import pandas as pd

from sklearn.linear_model import LinearRegression

# 加载数据

data = pd.read_csv('stock_data.csv')

# 提取特征

features = ['open', 'high', 'low', 'volume']

X = data[features]

# 目标变量

y = data['close']

# 训练模型

model = LinearRegression()

model.fit(X, y)

```

### 模型评估

训练完成后,需要评估模型的性能。常用的评估指标包括均方误差(MSE)、均方根误差(RMSE)和决定系数(R^2)。

### 预测

训练好的模型可以用于预测未来股票价格。给定新的特征值,我们可以使用模型预测股票价格:

```python

# 预测股票价格

new_features = [100, 105, 95, 100000]

prediction = model.predict([new_features])

print(prediction)

```

0

0