集成学习中的剪枝策略

发布时间: 2024-09-04 11:19:37 阅读量: 100 订阅数: 45

Python机器学习实验 - 决策树2-预剪枝-设置 max-depth、max-leaf-nodes 或 min-sample

# 1. 集成学习基础

## 1.1 集成学习概念解析

集成学习是一种机器学习范式,旨在通过构建并结合多个学习器来解决单一学习器难以处理的问题。它通过组合多个基学习器的预测结果来提升整体模型的泛化能力和稳定性能。

## 1.2 集成学习的工作机制

工作机制一般分为两种:Bagging和Boosting。前者通过在训练集中进行采样来训练多个模型,然后通过投票或平均的方式结合模型结果。后者则是专注于提高之前模型预测错误的样本,通过迭代的方式逐步提升模型性能。

## 1.3 集成学习的应用领域

由于其出色的性能,集成学习在多个领域都有应用,包括但不限于图像识别、推荐系统、生物信息学等。它在处理复杂数据和提高预测准确性方面显示出巨大的潜力。

```mermaid

flowchart LR

A[集成学习基础] --> B[工作原理]

B --> C[Bagging]

B --> D[Boosting]

A --> E[应用领域]

```

在本章中,我们将深入探讨集成学习的基础知识,帮助读者建立对集成学习的理解,为其后的剪枝策略章节打下坚实的基础。

# 2. 剪枝策略的理论基础

### 2.1 集成学习概述

集成学习是一种通过构建并结合多个学习器来完成学习任务的方法。它依赖于创建不同的模型,并将它们组合起来,以期达到比单一模型更好的性能。

#### 2.1.1 集成学习的原理

集成学习的基本原理是利用多样性来提高整体模型的性能。多样性可以通过不同的方式实现,例如使用不同的算法、对训练数据进行抽样或引入随机性。当这些模型被正确结合时,它们往往能够更好地泛化,减少模型的过拟合风险。

```mermaid

flowchart TD

A[开始] --> B[收集数据集]

B --> C[训练多个基学习器]

C --> D[集成方法]

D --> E[结合学习器的预测]

E --> F[输出最终预测结果]

```

- **基学习器**:在集成学习中,单个学习器被称为基学习器,可以是决策树、神经网络或任何其他类型的预测模型。

- **集成方法**:将各个基学习器的预测结果以某种方式整合起来,常见的方法有投票法、平均法和堆叠法。

#### 2.1.2 常见集成学习算法

集成学习领域中有许多著名的算法,其中最著名的包括Bagging、Boosting和Stacking。

- **Bagging**:通过并行构建多个模型,并将它们的预测结果进行简单平均或多数投票来整合。它减少了模型的方差,最著名的Bagging算法例子是随机森林。

- **Boosting**:是一种顺序构建模型的方法,每个模型都试图纠正前一个模型的错误。它通过给予之前错误分类的样例更大的权重,来提高模型的精度。代表算法有AdaBoost和Gradient Boosting Machine (GBM)。

- **Stacking**:将不同类型的模型的预测结果作为新模型的输入,通过学习一个元模型来产生最终的预测结果。这种集成方法增加了模型的多样性。

### 2.2 剪枝策略的定义与分类

#### 2.2.1 剪枝的基本概念

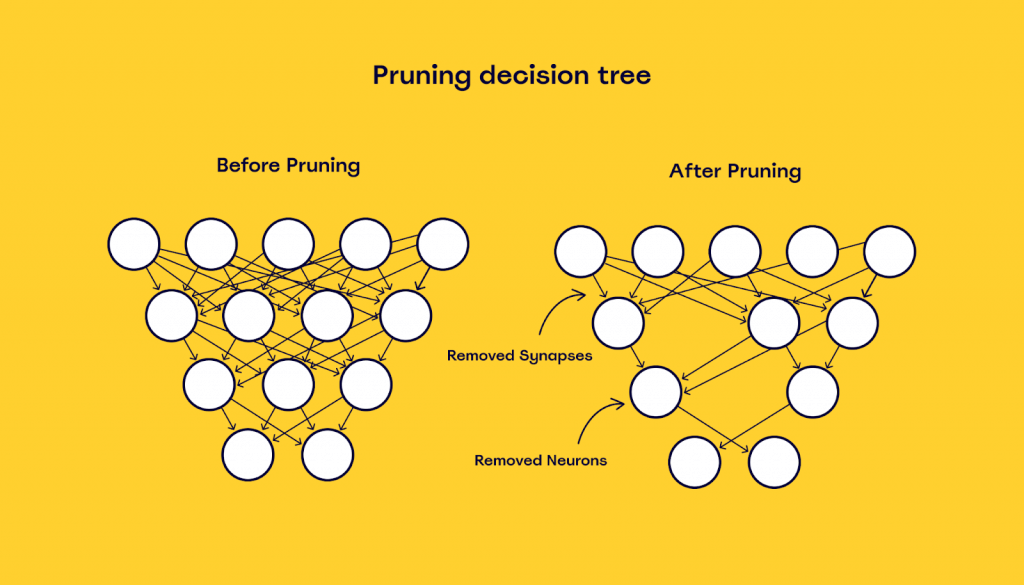

在集成学习中,剪枝是指减少模型复杂度的一种方法,通常是指减少决策树的大小。剪枝可以分为预剪枝和后剪枝。

- **预剪枝**:在构建决策树的过程中,通过提前停止树的生长来避免过拟合。例如,当节点中的样本数小于某个阈值时就停止分裂。

- **后剪枝**:首先构建一棵完整的决策树,然后通过剪枝操作去除一些不重要的节点。后剪枝的决策树更为简洁,并且具有更好的泛化能力。

```mermaid

graph LR

A[构建决策树] -->|预剪枝| B[提前停止分裂]

A -->|后剪枝| C[构建完整的树]

C --> D[剪掉不重要的节点]

```

#### 2.2.2 剪枝策略的类型

剪枝策略根据执行的时间可以分为预剪枝和后剪枝,而根据具体的方法又可以分为多种不同的类型:

- **简化剪枝**:通过移除子树并用一个单一节点替换来减少树的复杂度。

- **错误剪枝**:基于错误率的变化,只有当剪枝导致的错误率提高在可接受范围内时才进行剪枝。

- **最小错误剪枝**:这是一种比较激进的剪枝方式,通过统计方法计算出最优的剪枝节点。

### 2.3 剪枝的理论依据

#### 2.3.1 过拟合与模型复杂度

过拟合是机器学习中的一个普遍问题,尤其在决策树模型中更为常见。模型复杂度高意味着模型在训练数据上表现良好,但在未见过的数据上表现可能很差。

- **决策树的过拟合**:由于决策树会尽可能多地根据特征划分数据,因此非常容易产生过拟合。

- **剪枝对过拟合的影响**:剪枝通过限制树的大小或复杂度来减少过拟合的风险,使模型更加健壮。

#### 2.3.2 剪枝与模型泛化能力

泛化能力是指模型对于新数据的预测能力。剪枝通过减少模型复杂度,从而提高模型的泛化能力。

- **模型复杂度与泛化误差的关系**:模型复杂度与泛化误差之间存在一种折衷关系,即模型太简单则欠拟合,太复杂则过拟合。

- **剪枝如何提升泛化能力**:通过优化这种折衷关系,剪枝策略能够提升模型对未知数据的预测性能。

```markdown

| 模型复杂度 | 泛化误差 |

|------------|-----------|

| 低 | 高 |

| 中 | 中等 |

| 高 | 高 |

```

通过理解剪枝策略的理论基础,我们可以更好地应用这些技术来改善集成学习模型的性能,特别是在处理过拟合和泛化能力方面。下一章将深入探讨剪枝策略的实践技巧,包括预剪枝和后剪枝的实际应用。

# 3. 剪枝策略的实践技巧

在深入探索集成学习和剪枝策略的理论基础后,本章节将聚焦于将这些理论转化为实际可行的技术和方法。我们将详细分析预剪枝和后剪枝策略的实现,以及如何在实际应用中对模型进行性能评估。

## 3.1 预剪枝策略的实现与应用

预剪枝是一种在训练集成学习模型之前就进行的剪枝操作,目的是在模型训练过程中防止过拟合,并减少模型的复杂度。

### 3.1.1 预剪枝的参数调整

预剪枝的核心在于合理地调整模型的超参数,以实现剪枝效果。以决策树为例,常见的超参数包括树的最大深度(max_depth)、内部节点最少样本数(min_samples_split)、叶节点最少样本数(min_samples_leaf)等。调整这些参数可以控制模型的复杂度。

```python

from sklearn.tree import DecisionTreeClassifier

# 初始化决策树分类器

dt = DecisionTreeClassifier(

max_depth=3, # 最大深度设置为3

min_samples_split=10, # 内部节点至少有10个样本才能继续分割

min_samples_leaf=5 # 叶节点至少有5个样本

)

# 训练模型

dt.fit(X_train, y_train)

```

在这个例子中,通过限制决策树的最大深度和节点的最小样本数,实现了预剪枝。这可以在一定程度上避免决策树过于复杂而导致的过拟合。

### 3.1.2 预剪枝的实际案例分析

以一个经典的分类问题为例,我们将使用预剪枝的决策树对鸢尾花(Iris)数据集进行分类。在这个案例中,我们将调整不同的超参数,观察模型性能的变化。

```python

from sklearn.datasets import load_iris

from sklearn.model_selection import train_test_split

from sklearn.metrics import accuracy_score

# 加载数据集

iris = load_iris()

X, y = iris.data, iris.target

# 划分训练集和测试集

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.3, random_state=42)

# 应用预剪枝的决策树模型

dt = DecisionTreeClassifier(

max_depth=3,

min_samples_split=10,

min_samples_leaf=5

)

dt.fit(X_train,

```

0

0