矩阵分解的利器:掌握矩阵运算的秘密武器

发布时间: 2024-07-10 08:17:16 阅读量: 52 订阅数: 36

# 1. 矩阵分解概述**

矩阵分解是一种强大的数学工具,用于将矩阵分解为多个较小、更易于管理的矩阵。它在图像处理、数据分析和机器学习等领域有着广泛的应用。矩阵分解可以帮助我们理解数据的潜在结构,提取有用的特征,并解决各种复杂问题。

矩阵分解技术有多种类型,包括特征值分解、奇异值分解和QR分解。这些技术基于线性代数原理,利用矩阵的特征值和特征向量来分解矩阵。通过矩阵分解,我们可以获得对矩阵内在结构的深刻理解,并将其应用于各种实际问题中。

# 2.1 矩阵分解的定义和类型

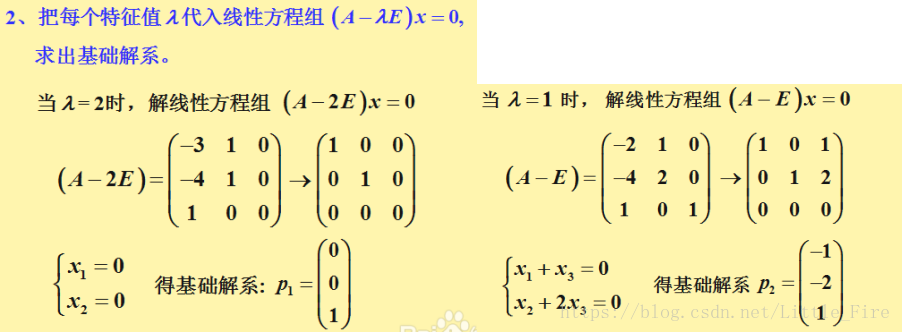

### 2.1.1 特征值分解

特征值分解(EVD)是一种将矩阵分解为特征向量和特征值集合的数学技术。特征向量是矩阵乘以某个标量后仍保持不变的向量,而特征值就是这个标量。

**定义:**

对于一个 n x n 矩阵 A,其特征值分解形式为:

```

A = QΛQ^-1

```

其中:

* Q 是 n x n 的正交矩阵,其列向量是 A 的特征向量。

* Λ 是 n x n 的对角矩阵,其对角线元素是 A 的特征值。

**代码示例:**

```python

import numpy as np

# 定义矩阵 A

A = np.array([[2, 1], [1, 2]])

# 计算特征值分解

eigenvalues, eigenvectors = np.linalg.eig(A)

# 输出特征值和特征向量

print("特征值:", eigenvalues)

print("特征向量:", eigenvectors)

```

**逻辑分析:**

`np.linalg.eig()` 函数计算矩阵 A 的特征值和特征向量。`eigenvalues` 数组包含特征值,`eigenvectors` 数组包含特征向量。

### 2.1.2 奇异值分解

奇异值分解(SVD)是一种将矩阵分解为奇异向量和奇异值集合的数学技术。奇异向量是矩阵乘以某个标量后仍保持不变的向量,而奇异值就是这个标量。

**定义:**

对于一个 m x n 矩阵 A,其奇异值分解形式为:

```

A = UΣV^T

```

其中:

* U 是 m x m 的正交矩阵,其列向量是 A 的左奇异向量。

* Σ 是 m x n 的对角矩阵,其对角线元素是 A 的奇异值。

* V 是 n x n 的正交矩阵,其列向量是 A 的右奇异向量。

**代码示例:**

```python

import numpy as np

# 定义矩阵 A

A = np.array([[1, 2], [3, 4]])

# 计算奇异值分解

U, S, Vh = np.linalg.svd(A, full_matrices=False)

# 输出奇异值和奇异向量

print("奇异值:", S)

print("左奇异向量:", U)

print("右奇异向量:", Vh)

```

**逻辑分析:**

`np.linalg.svd()` 函数计算矩阵 A 的奇异值和奇异向量。`S` 数组包含奇异值,`U` 数组包含左奇异向量,`Vh` 数组包含右奇异向量。

### 2.1.3 QR分解

QR 分解是一种将矩阵分解为正交矩阵和上三角矩阵的数学技术。正交矩阵的列向量相互正交,而上三角矩阵的对角线以上元素为 0。

**定义:**

对于一个 m x n 矩阵 A,其 QR 分解形式为:

```

A = QR

```

其中:

* Q 是 m x n 的正交矩阵。

* R 是 m x n 的上三角矩阵。

**代码示例:**

```python

import numpy as np

# 定义矩阵 A

A = np.array([[1, 2], [3, 4]])

# 计算 QR 分解

Q, R = np.linalg.qr(A)

# 输出正交矩阵和上三角矩阵

print("正交矩阵:", Q)

print("上三角矩阵:", R)

```

**逻辑分析:**

`np.linalg.qr()` 函数计算矩阵 A 的 QR 分解。`Q` 数组包含正交矩阵,`R` 数组包含上三角矩阵。

# 3. 矩阵分解实践应用

### 3.1 图像处理

矩阵分解在图像处理领域有着广泛的应用,主要用于图像降噪和图像压缩。

**3.1.1 图像降噪**

图像降噪旨在去除图像中的噪声,以提高图像质量。矩阵分解可以通过分离噪声和图像信号来实现降噪。

**代码块:**

```python

import numpy as np

import cv2

# 读取图像

image = cv2.imread('noisy_image.jpg')

# 将图像转换为灰度图

gray_image = cv2.cvtColor(image, cv2.COLOR_BGR2GRAY)

# 进行奇异值分解

U, s, Vh = np.linalg.svd(gray_image, full_matrices=False)

# 重构图像,去除噪声

denoised_image = np.dot(U, np.dot(np.diag(s), Vh))

# 显示降噪后的图像

cv2.imshow('Denoised Image', denoised_image)

cv2.waitKey(0)

cv2.destroyAllWindows()

```

**代码逻辑分析:**

* 使用 `cv2` 读取图像并转换为灰度图。

* 使用 `np.linalg.svd` 进行奇异值分解,得到奇异值矩阵 `s`。

* 通过去除较小的奇异值来过滤噪声。

* 重构图像,去除噪声。

* 显示降噪后的图像。

**3.1.2 图像压缩**

图像压缩旨在减少图像文件大小,同时保持图像质量。矩阵分解可以通过去除图像中的冗余信息来实现压缩。

**代码块:**

```python

import numpy as np

import cv2

# 读取图像

image = cv2.imread('large_image.jpg')

# 将图像转换为灰度图

gray_image = cv2.cvtColor(image, cv2.COLOR_BGR2GRAY)

# 进行奇异值分解

U, s, Vh = np.linalg.svd(gray_image, full_matrices=False)

# 保留前 k 个奇异值

k = 50

s_k = s[:k]

# 重构图像,进行压缩

compressed_image = np.dot(U[:, :k], np.dot(np.diag(s_k), Vh[:k, :]))

# 计算压缩率

compression_ratio = 1 - (compressed_image.size / image.size)

# 显示压缩后的图像

cv2.imshow('Compressed Image', compressed_image)

cv2.waitKey(0)

cv2.destroyAllWindows()

```

**代码逻辑分析:**

* 使用 `cv2` 读取图像并转换为灰度图。

* 使用 `np.linalg.svd` 进行奇异值分解,得到奇异值矩阵 `s`。

* 保留前 `k` 个奇异值,去除冗余信息。

* 重构图像,进行压缩。

* 计算压缩率。

* 显示压缩后的图像。

### 3.2 数据分析

矩阵分解在数据分析中有着重要的作用,主要用于主成分分析和聚类分析。

**3.2.1 主成分分析**

主成分分析(PCA)是一种降维技术,旨在将高维数据投影到低维空间,同时保留数据的最大方差。矩阵分解可以通过计算数据的协方差矩阵的特征值和特征向量来实现 PCA。

**代码块:**

```python

import numpy as np

import pandas as pd

# 加载数据

data = pd.read_csv('data.csv')

# 计算协方差矩阵

covariance_matrix = np.cov(data)

# 计算特征值和特征向量

eigenvalues, eigenvectors = np.linalg.eig(covariance_matrix)

# 保留前 k 个特征向量

k = 2

eigenvectors_k = eigenvectors[:, :k]

# 投影数据到低维空间

reduced_data = np.dot(data, eigenvectors_k)

```

**代码逻辑分析:**

* 使用 `pandas` 加载数据。

* 计算数据的协方差矩阵。

* 计算协方差矩阵的特征值和特征向量。

* 保留前 `k` 个特征向量。

* 将数据投影到低维空间。

**3.2.2 聚类分析**

聚类分析旨在将数据点分组为不同的簇,以便识别数据中的模式。矩阵分解可以通过计算数据的相似性矩阵的特征值和特征向量来实现聚类分析。

**代码块:**

```python

import numpy as np

import scipy.cluster.hierarchy as sch

# 加载数据

data = pd.read_csv('data.csv')

# 计算相似性矩阵

similarity_matrix = 1 - sch.distance.pdist(data, metric='euclidean')

# 计算特征值和特征向量

eigenvalues, eigenvectors = np.linalg.eig(similarity_matrix)

# 聚类数据

clusters = sch.fcluster(eigenvectors, t=0.5, criterion='distance')

```

**代码逻辑分析:**

* 使用 `pandas` 加载数据。

* 计算数据的相似性矩阵。

* 计算相似性矩阵的特征值和特征向量。

* 根据特征值和特征向量对数据进行聚类。

### 3.3 机器学习

矩阵分解在机器学习中有着广泛的应用,主要用于降维和特征提取。

**3.3.1 降维**

降维旨在将高维数据投影到低维空间,以提高机器学习模型的性能。矩阵分解可以通过计算数据的协方差矩阵的特征值和特征向量来实现降维。

**代码块:**

```python

import numpy as np

from sklearn.decomposition import PCA

# 加载数据

data = np.loadtxt('data.txt')

# 进行 PCA 降维

pca = PCA(n_components=2)

reduced_data = pca.fit_transform(data)

```

**代码逻辑分析:**

* 使用 `numpy` 加载数据。

* 使用 `sklearn.decomposition.PCA` 进行 PCA 降维。

* 将数据投影到低维空间。

**3.3.2 特征提取**

特征提取旨在从数据中提取有用的特征,以提高机器学习模型的性能。矩阵分解可以通过计算数据的协方差矩阵的特征值和特征向量来实现特征提取。

**代码块:**

```python

import numpy as np

from sklearn.decomposition import SparsePCA

# 加载数据

data = np.loadtxt('data.txt')

# 进行稀疏 PCA 特征提取

sparse_pca = SparsePCA(n_components=2)

sparse_data = sparse_pca.fit_transform(data)

```

**代码逻辑分析:**

* 使用 `numpy` 加载数据。

* 使用 `sklearn.decomposition.SparsePCA` 进行稀疏 PCA 特征提取。

* 从数据中提取有用的特征。

# 4. 矩阵分解进阶技巧

### 4.1 分布式矩阵分解

#### 4.1.1 分布式计算原理

分布式计算是一种将计算任务分配到多个计算机或节点上执行的技术。它允许并行处理大规模数据集,从而显著提高计算效率。在矩阵分解的背景下,分布式计算可以将矩阵分解任务分解成较小的块,并分配给不同的节点同时执行。

#### 4.1.2 Hadoop和Spark中的矩阵分解

Hadoop和Spark是两个流行的分布式计算框架,它们提供了用于矩阵分解的模块和算法。

**Hadoop中的矩阵分解**

Hadoop使用MapReduce编程模型,它将计算任务分解成两个阶段:Map和Reduce。在矩阵分解中,Map阶段通常用于将矩阵分解成块,而Reduce阶段用于聚合和计算最终结果。

**Spark中的矩阵分解**

Spark是一个基于内存的分布式计算框架,它提供了更高级别的API,简化了分布式计算的编程。Spark中的矩阵分解算法包括:

- **MLlib Singular Value Decomposition (SVD)**:用于奇异值分解。

- **MLlib Principal Component Analysis (PCA)**:用于主成分分析。

### 4.2 稀疏矩阵分解

#### 4.2.1 稀疏矩阵的特性

稀疏矩阵是大多数元素为零的矩阵。在现实世界的数据中,稀疏矩阵非常常见,例如图像、文本和社交网络数据。稀疏矩阵的特性使其在存储和计算方面具有独特的挑战。

#### 4.2.2 稀疏矩阵分解算法

专门针对稀疏矩阵设计的分解算法可以提高计算效率和准确性。这些算法通常利用稀疏矩阵的结构和特性来优化计算过程。

**稀疏奇异值分解 (SVD)**

稀疏SVD算法考虑了稀疏矩阵中非零元素的分布,并使用迭代方法计算奇异值和奇异向量。

**稀疏主成分分析 (PCA)**

稀疏PCA算法利用稀疏矩阵的低秩特性,通过迭代方法提取主成分。

**稀疏QR分解**

稀疏QR分解算法将稀疏矩阵分解成正交矩阵Q和上三角矩阵R。该算法利用稀疏矩阵的结构来优化计算过程。

### 代码示例:分布式奇异值分解

```python

import numpy as np

import pyspark.mllib.linalg as mllib_linalg

# 创建一个稀疏矩阵

data = np.array([[1, 0, 0], [0, 2, 0], [0, 0, 3]])

sparse_matrix = mllib_linalg.SparseMatrix(3, 3, data.flatten())

# 使用Spark MLlib进行分布式奇异值分解

svd = mllib_linalg.SingularValueDecomposition(sparse_matrix, computeU=True, computeV=True)

# 获取奇异值和奇异向量

u = svd.U

s = svd.s

vt = svd.V.T

```

**代码逻辑分析**

该代码示例使用Spark MLlib中的分布式奇异值分解算法对稀疏矩阵进行分解。

1. `SparseMatrix`类用于创建稀疏矩阵,它将非零元素存储为元组列表。

2. `SingularValueDecomposition`类执行分布式奇异值分解。`computeU`和`computeV`参数指定是否计算U和V矩阵。

3. `U`、`s`和`vt`分别表示U矩阵、奇异值和V矩阵的转置。

### 总结

矩阵分解进阶技巧,如分布式矩阵分解和稀疏矩阵分解,可以显著提高大规模数据集的矩阵分解效率和准确性。分布式计算框架,如Hadoop和Spark,提供了并行处理矩阵分解任务的能力。稀疏矩阵分解算法利用稀疏矩阵的特性来优化计算过程。通过这些进阶技巧,矩阵分解可以应用于更广泛的领域,并解决更复杂的问题。

# 5. 矩阵分解工具和库

### 5.1 NumPy

#### 5.1.1 NumPy的基本操作

NumPy是一个用于科学计算的Python库。它提供了对多维数组的支持,以及各种数学和统计函数。NumPy的基本操作包括:

- 创建和操作数组

- 数组的数学运算(如加法、减法、乘法、除法)

- 数组的统计运算(如求和、求平均值、求方差)

- 数组的索引和切片

#### 5.1.2 NumPy中的矩阵分解函数

NumPy提供了几个用于矩阵分解的函数,包括:

- `linalg.svd()`:奇异值分解

- `linalg.qr()`:QR分解

- `linalg.eig()`:特征值分解

这些函数可以用于各种矩阵分解任务,例如:

```python

import numpy as np

# 奇异值分解

A = np.array([[1, 2], [3, 4]])

U, s, Vh = np.linalg.svd(A)

# QR分解

A = np.array([[1, 2], [3, 4]])

Q, R = np.linalg.qr(A)

# 特征值分解

A = np.array([[1, 2], [3, 4]])

eigvals, eigvecs = np.linalg.eig(A)

```

### 5.2 SciPy

#### 5.2.1 SciPy的矩阵分解模块

SciPy是一个用于科学和技术计算的Python库。它提供了比NumPy更高级的功能,包括用于矩阵分解的模块。SciPy的矩阵分解模块包括:

- `scipy.linalg.svd()`:奇异值分解

- `scipy.linalg.qr()`:QR分解

- `scipy.linalg.eig()`:特征值分解

这些模块提供了比NumPy中相应的函数更高级的功能,例如:

```python

import scipy.linalg

# 奇异值分解

A = np.array([[1, 2], [3, 4]])

U, s, Vh = scipy.linalg.svd(A, full_matrices=False)

# QR分解

A = np.array([[1, 2], [3, 4]])

Q, R = scipy.linalg.qr(A, mode='economic')

# 特征值分解

A = np.array([[1, 2], [3, 4]])

eigvals, eigvecs = scipy.linalg.eig(A)

```

#### 5.2.2 SciPy中的高级矩阵分解算法

除了基本的矩阵分解函数,SciPy还提供了高级矩阵分解算法,例如:

- `scipy.sparse.linalg.svds()`:稀疏矩阵的奇异值分解

- `scipy.sparse.linalg.qr()`:稀疏矩阵的QR分解

- `scipy.sparse.linalg.eigsh()`:稀疏矩阵的特征值分解

这些算法可以用于处理大规模稀疏矩阵的矩阵分解问题。

0

0