MapReduce高效秘技: Combine策略与实践,打造极致性能

发布时间: 2024-10-30 18:19:57 阅读量: 18 订阅数: 17

# 1. MapReduce简介与性能挑战

MapReduce是一种编程模型,用于处理大规模数据集的并行运算。它由Google提出,并被广泛应用于各种大数据处理场景中。尽管MapReduce在大数据处理领域有着无可替代的地位,但它的性能优化依然面临着不少挑战。从网络通信开销、磁盘IO到内存管理等不同方面,MapReduce性能的提升需要综合考虑多种因素。这一章节将简要介绍MapReduce模型的基本概念,以及在实际应用中可能遇到的性能瓶颈和挑战。我们会探讨如何通过调整配置和理解框架特性来优化MapReduce作业,以期在实际应用中达到更好的性能表现。

# 2. 深入理解MapReduce Combine策略

## 2.1 Combine策略的基本概念

### 2.1.1 MapReduce框架下的Combiner组件

Combiner组件是MapReduce框架中的一个可选组件,其主要目的是在Map任务输出后,对中间数据进行局部合并,减少传输到Reduce任务的数据量。这不仅可以减少网络带宽的压力,还能加快数据传输速度,进而提升作业的整体执行效率。Combiner的使用并不是强制性的,但是它在很多场景下可以显著改善MapReduce作业的性能。

Combiner的逻辑与Reducer相似,但它只会接收来自一个Map任务的输出,并且这个过程在Map任务结束后立即发生。因此,Combiner可以看作是Reducer的一个局部实例,它只处理Map任务的数据分片。这使得Combiner成为一种优化手段,可以在不影响最终结果的前提下,减少Shuffle阶段的数据传输。

### 2.1.2 Combine策略的工作原理与作用

Combine策略的核心工作原理是合并中间结果。它通过对Map输出的中间键值对进行合并操作,尽可能地减少需要传输到Reduce阶段的数据量。例如,在进行单词计数时,如果同一个Map任务中输出的多个键值对具有相同的键,Combiner可以将这些值合并,只输出单个键值对到Reduce阶段。

这不仅可以减少网络传输的数据量,还能加快Shuffle阶段的速度,因为网络I/O和磁盘I/O是MapReduce中最可能成为瓶颈的部分。Combine策略在很多情况下可以使***uce作业的性能提升一个数量级。然而,值得注意的是,并不是所有的MapReduce作业都适合使用Combiner。只有那些能够满足Combiner操作的交换律和结合律的作业才能从中受益。

## 2.2 Combine策略与Shuffle过程的交互

### 2.2.1 Shuffle过程的详细步骤

Shuffle过程是MapReduce中的关键阶段,负责将Map任务的输出传输到Reduce任务。这个过程大致分为以下几个步骤:

1. Map阶段完成后,框架将输出的中间键值对根据它们的目标Reduce任务进行分区。

2. 排序:框架对每个分区内的数据按键进行排序,确保相同的键会聚集在一起。

3. 分组:排序后的数据被分组,每组数据都会被发送到对应的Reduce任务。

4. Reduce阶段的Map任务输出被拉取:Reduce任务通过网络拉取所有Map任务的输出,这一步是Shuffle过程中的主要网络负载。

5. 最终排序:拉取到的数据在Reduce任务本地进行排序,为最终的合并做准备。

### 2.2.2 Combine在Shuffle中的位置和影响

Combine操作通常在Map阶段之后、Shuffle的排序和分组之前进行。其影响可以体现在以下几个方面:

- **减少数据量**:通过Combine合并中间键值对,显著减少了需要进行Shuffle的数据量。

- **提高传输效率**:减少数据量意味着降低网络传输负载,加快数据传输速度。

- **提升总体性能**:由于数据量减少,最终执行Reduce任务时的I/O操作也会减少,从而加快整个作业的执行速度。

Combine策略的效果依赖于数据的分布和操作的特性。如果Map输出中有大量重复的键,则Combine可以显著减少数据的大小。但如果输出数据没有可合并的模式,或者合并操作本身开销很大,则可能不会有太大的性能提升。

## 2.3 Combine策略的类型和选择

### 2.3.1 不同场景下Combine策略的应用

在不同的作业场景下,Combine策略的应用需要根据具体的数据特性和作业需求进行选择。例如:

- **计数类作业**:如单词计数,非常适合使用Combiner,因为相同键的值可以相加合并。

- **数据统计作业**:一些求平均值或汇总的作业也可以应用Combine策略,但是合并逻辑可能需要根据业务逻辑进行定制。

此外,一些不适合使用Combiner的场景包括:

- **数据去重**:如果目的是去重,则无法通过Combiner进行合并。

- **数据排序**:在排序作业中,Combiner可能会打乱原有的排序逻辑。

### 2.3.2 如何选择合适的Combine策略

选择合适的Combine策略首先需要对作业的数据和处理逻辑有深入理解。以下是一些选择合适Combine策略的建议:

- **分析数据特征**:检查中间输出的数据,查看是否具有可以合并的模式。

- **考虑操作的特性**:确保所选用的Combiner操作满足交换律和结合律。

- **测试Combiner的影响**:通过实验不同的Combine策略来评估对作业性能的实际影响。

- **定制Combiner逻辑**:对于特殊的业务逻辑,可能需要实现自定义的Combiner逻辑以达到最优性能。

正确选择和实现Combine策略可以极大地提升MapReduce作业的性能,尤其是在处理大规模数据集时。然而,错误的实现也可能导致错误的结果,因此在实际应用中需要小心谨慎。

# 3. MapReduce Combine策略实践

随着大数据处理需求的增长,MapReduce框架的性能优化成为了重要的研究领域。Combine策略作为MapReduce中的重要组成部分,它可以在Map阶段和Shuffle阶段之前,对数据进行局部的合并操作,减少网络传输数据量,提高整体的计算效率。本章节将详细介绍如何在Hadoop中实现Combine策略,并深入探讨其优化技巧和具体案例分析。

## 3.1 在Hadoop中实现Combine策略

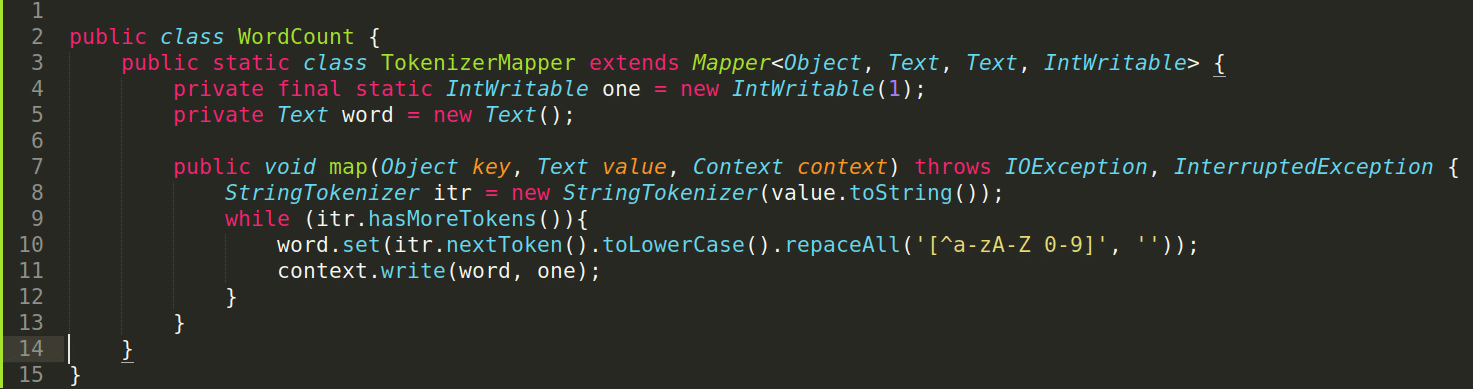

### 3.1.1 配置和使用自定义Combiner

要在Hadoop中使用自定义的Combiner,需要编写自己的Combiner类并继承自Reducer类。然后,需要在Job配置中设置Combiner类。

下面是一个自定义Combiner类的示例:

```java

public class CustomCombiner extends Reducer<Text, IntWritable, Text, IntWritable> {

@Override

protected void reduce(Text key, Iterable<IntWritable> values, Context context)

throws IOException, InterruptedException {

int sum = 0;

for (IntWritable val : values) {

sum += val.get();

}

context.write(key, new IntWritable(sum));

}

}

```

在Job配置中设置Combiner:

```java

Configuration conf = new Configuration();

Job job = Job.getInstance(conf, "word count");

// 设置自定义的Combiner

job.setCombinerClass(CustomCombiner.class);

// 设置Mapper和Reducer类

job.setMapperClass(TokenizerMapper.class);

job.setCombinerClass(CustomCombiner.class);

job.setReducerClass(IntSumReducer.class);

// 其他设置...

```

### 3.1.2 分析Combine对作业性能的影响

使用Combiner可以显著减少Map任务输出的数据量,减轻网络I/O的负担。具体影响取决于数据的分布和Combiner逻辑的效率。

当输入数据中存在大量重复的key时,Combiner的效果最为明显。例如,在单词计数的MapReduce作业中,多个Map任务可能对同一个单词进行了计数,Combiner可以将这些计数合并,减少shuffle阶段的数据传输。

使用Combiner的一个潜在问题是它可能会对最终的reduce结果造成影响。在某些情况下,合并操作可能不满足交换律和结合律,这时就不适合使用Combiner。

## 3.2 Combine策略的优化技巧

### 3.2.1 数据本地性优化

在MapReduce作业中,数据本地性指的是Map和Reduce任务能够尽量在存储有输入数据的机器上执行。通过提高数据本地性,可以减少数据传输的时间,提高作业效率。

Hadoop通过设置`mapreduce.job locality.wait.node`和`mapreduce.job locality.wait.rack`参数来控制等待数据本地性的时间。合理配置这些参数可以有效优化作业性能。

### 3.2.2 资源管理与调度优化

在多用户环境中,MapReduce作业需要和其他作业共享集群资源。资源管理与调度的优化包括合理配置CPU、内存等资源,以及采用高效的任务调度策略。

YARN(Yet Another Resource Negotiator)是Hadoop中的资源管理器,它负责集群资源的分配和任务调度。在YARN中可以配置不同的队列,按需分配资源。例如,可以根据作业的优先级和资源需求,将作业分配到不同的队列中执行。

## 3.3 Combine策略案例分析

### 3.3.1 统计类作业的Combine应用案例

在统计类作业中,如日志分析,往往会产生大量的中间数据。使用Combiner可以有效减少这些中间数据的大小,减轻网络I/O的压力。

例如,日志中的每一行都包含了一个用户的浏览记录。Map任务可能产生大量的中间键值对,键为用户ID,值为浏览次数。通过在Map任务后使用Combiner合并这些记录,可以减少数据量,加速后续的shuffle过程。

```java

// Mapper

map(key, value, context) {

context.write(new Text(user_id), new IntWritable(1));

}

// Reducer

reduce(key, values, context) {

int sum = 0;

for (IntWritable val : values) {

sum += val.get();

}

context.write(key, new IntWritable(sum));

}

// Combiner

combine(key, values, context) {

// 和Reducer逻辑相同,这里就是对中间输出进行本地合并

}

```

### 3.3.2 分析类作业的Combine应用案例

在数据分析类作业中,例如矩阵乘法或图的连接操作,合理应用Combiner能够有效减少中间数据的存储和传输。

例如,在进行矩阵乘法时,每个Map任务负责输出中间键值对,键为乘法中矩阵C的索引,值为中间结果。通过在Shuffle之前使用Combiner合并相同索引的中间结果,可以大大减少Reduce任务处理的数据量。

```java

// Mapper

map(key, value, context) {

// 假设value是矩阵B的一行

for each row in MatrixA {

context.write(new Text(row_index), new Text(value));

}

}

// Reducer

reduce(key, values, context) {

// 对应索引的矩阵B所有行的相乘结果

List<String> matrixB_rows = new ArrayList<>();

for (Text val : values) {

matrixB_rows.add(val.toString());

}

// 执行乘法操作,计算最终结果

}

// Combiner

combine(key, values, context) {

// 和Reducer逻辑相同,合并相同key的值,减少数据量

}

```

以上案例展示了如何在不同的MapReduce作业中应用Combine策略,通过减少中间数据量来提高作业的执行效率。合理配置和使用Combiner对于提升大数据处理作业的性能至关重要。

# 4. MapReduce性能极致提升策略

在现代的大数据处理场景中,提升MapReduce的性能是至关重要的。它直接影响到数据处理的速度、效率和成本。为了实现这一目标,开发者和数据工程师需要深入挖掘和应用各种优化技术。在本章中,我们将探讨一些高级的MapReduce优化技术,并展示如何将它们应用于实际的工作流程中。

## 4.1 探索MapReduce的其他优化技术

MapReduce作为一种数据处理框架,其性能的提升不仅仅依赖于对Combine策略的优化,还包括了其他层面的深入挖掘。这一节将深入探讨两个重要的优化领域:任务调度和数据序列化。

### 4.1.1 Map和Reduce任务的合理调度

任务调度是影响MapReduce性能的关键因素之一。通过合理配置资源和调度策略,可以在保证数据处理准确性的同时,最大程度上优化资源的使用效率。

- **资源预估和预留**:在作业开始之前,预估所需的Map和Reduce任务资源,并对这些资源进行预留,可以避免因资源竞争导致的任务延时。

- **任务优先级设置**:为不同的作业设置优先级,保证高优先级任务能够先于低优先级任务获得执行,提高整体效率。

- **负载均衡**:通过监控和动态调整任务分配,确保集群中的资源负载均衡,避免出现某些节点过载而其他节点闲置的情况。

### 4.1.2 数据序列化与反序列化优化

数据序列化与反序列化是MapReduce作业中的常见瓶颈。通过选择合适的序列化框架和优化序列化过程,可以显著提升性能。

- **选择高效序列化框架**:使用高效的序列化框架,如Avro或Protocol Buffers,这些框架比Java内置的序列化机制更快、更节省空间。

- **自定义序列化类**:对于需要频繁序列化的数据类型,可以考虑实现自定义的序列化逻辑,以优化性能。

- **批处理**:在可能的情况下,合并多个小型序列化操作为一个批量操作,可以减少序列化和反序列化的开销。

```java

// 示例代码:使用Protocol Buffers进行序列化

protobuf.Message message = ...;

byte[] data = message.toByteArray();

// 反序列化

protobuf.Message newMessage = MyMessage.parseFrom(data);

```

上述代码展示了如何使用Protocol Buffers将Java对象序列化为字节序列,并进行反序列化的过程。

## 4.2 高级Combine技术的应用

Combine技术不仅可以在Shuffle阶段发挥作用,还可以通过自定义策略进一步提升性能。本节将探讨如何应用高级Combine技术以优化MapReduce作业。

### 4.2.1 自定义分区和排序策略

在某些特定场景下,使用默认的分区和排序策略可能无法达到最优的性能。通过实现自定义分区和排序策略,可以对数据进行更合理的组织,从而提升作业的性能。

- **自定义分区策略**:通过实现`Partitioner`接口,可以控制Map输出键值对分配到不同Reduce任务的方式。

- **自定义排序策略**:通过继承`WritableComparable`并重写`compareTo`方法,可以定义数据的排序规则,以优化后续的数据处理流程。

```java

// 自定义分区策略示例

public class CustomPartitioner extends Partitioner<Text, IntWritable> {

public int getPartition(Text key, IntWritable value, int numPartitions) {

// 自定义分区逻辑

}

}

```

### 4.2.2 多级Combine策略的综合运用

多级Combine策略是将多个Combiner串联起来,在不同的节点上进行局部Combine操作,最终合并为一个最终结果。这种方法在处理大规模数据时尤为有效。

- **局部Combine优化**:在每个节点上进行初步的Combine操作,以减少传输的数据量。

- **全局Combine整合**:对所有局部Combine的结果进行整合,以获得最终结果。

## 4.3 构建高性能MapReduce应用的最佳实践

构建高性能的MapReduce应用需要综合考虑设计、开发、测试和部署的各个阶段。以下是一些最佳实践,可以指导我们在构建高效数据处理流程时遵循的准则。

### 4.3.1 构建可扩展的MapReduce作业设计

可扩展性是衡量MapReduce作业设计是否高效的关键标准之一。在设计阶段,就需要考虑到后续可能的扩展需求。

- **模块化设计**:将复杂的作业分解为多个可复用、可独立扩展的模块,便于维护和优化。

- **参数化配置**:通过参数化配置,可以灵活地调整作业的行为,应对不同的数据处理场景。

### 4.3.2 实际案例:构建高效数据处理流程

通过分析实际案例,我们可以更好地理解如何构建一个高效的数据处理流程。

- **案例研究**:本案例将分析如何在一个大型电子商务公司中优化订单处理流程。通过对MapReduce作业的优化,公司实现了订单数据的快速处理和分析。

- **策略应用**:本案例将展示如何应用上述优化策略,包括合理配置资源、优化任务调度、自定义序列化等。

以上所述的技术和策略,只要应用得当,都能显著提高MapReduce作业的性能。随着大数据技术的不断发展,优化MapReduce作业变得更加重要,它能够帮助企业在处理海量数据时拥有更快的处理速度和更高的成本效率。

# 5. 未来展望与MapReduce的新动向

随着大数据技术的不断发展,MapReduce作为该领域的先驱者,一直在不断地进化和融合新的技术以保持其竞争力。本章将讨论MapReduce在未来大数据处理框架中的融合与创新,并对未来技术进行展望。

## 5.1 MapReduce与大数据技术的融合发展

### 5.1.1 新兴大数据处理框架对MapReduce的影响

近年来,随着Spark、Flink等新一代大数据处理框架的崛起,MapReduce所面临的挑战日益增加。这些框架以其更高效的数据处理能力和更低的延迟,逐渐成为处理流数据和交互式查询的首选。

- **Spark**:以RDD为核心的数据抽象,引入了内存计算的概念,加快了数据处理速度。

- **Flink**:提供真正的实时处理能力,其事件时间处理机制比MapReduce的批处理模式更加灵活。

- **对比分析**:MapReduce作为批处理框架,在处理大规模静态数据集时表现出色,但在需要快速迭代或低延迟处理的场景下则逊色于这些新框架。

### 5.1.2 MapReduce在现代数据处理中的地位

尽管面临挑战,MapReduce依然在现代数据处理场景中占有重要地位,尤其是在需要稳定处理大规模数据集的场合。其主要有以下优势:

- **成熟的生态系统**:Hadoop生态系统的其他组件如Hive、Pig等为MapReduce提供了丰富的工具和接口。

- **可扩展性和稳定性**:MapReduce的可扩展性和稳定性在生产环境中得到了验证,尤其是在离线数据处理任务中。

- **容错能力**:由于其工作原理,MapReduce天然具备良好的容错能力,适合处理不经常变化的数据集。

## 5.2 探索下一代MapReduce技术

MapReduce需要适应不断变化的大数据处理需求。下一代MapReduce技术将解决现有架构中的不足,同时吸收其他框架的优势。

### 5.2.1 新架构下MapReduce的潜力与挑战

新架构下的MapReduce将面临以下挑战:

- **实时数据处理**:如何整合流处理的能力,实现实时数据处理。

- **资源管理**:如何更高效地管理计算资源,支持更加复杂的调度策略。

- **存储与计算分离**:如何在新的架构下实现存储与计算的分离,以提高资源的利用率。

同时,MapReduce在新的架构下也存在着潜力:

- **扩展性**:通过引入新的架构设计,MapReduce可以支持更多类型的计算模型。

- **性能优化**:借助于新的调度和资源管理技术,MapReduce的性能有望进一步提高。

- **易用性**:简化操作流程,提高MapReduce的易用性,使之能够更好地服务于非专业用户。

### 5.2.2 预计未来的发展趋势与技术革新

- **集成机器学习**:MapReduce框架将可能与机器学习算法结合,提供更加强大的数据处理能力。

- **云计算集成**:更多地集成到云服务平台中,实现资源的按需分配和弹性扩展。

- **硬件加速**:利用GPU等硬件加速技术提高MapReduce的计算效率。

通过这些技术革新,MapReduce将继续作为大数据处理领域的一个重要工具,为数据科学家和工程师们提供稳定和强大的数据处理能力。在未来的数据处理场景中,MapReduce将与新一代处理框架并存,发挥其独特优势。

0

0