MapReduce性能革命:Combine与Reduce协同工作,优化数据流

发布时间: 2024-10-30 18:26:45 阅读量: 21 订阅数: 17

# 1. MapReduce性能革命概述

MapReduce是一个处理大规模数据集的编程模型,它由Google提出,是大数据处理技术的鼻祖之一。尽管近年来出现了如Apache Spark等新贵,但MapReduce依然在很多大规模数据处理场景中占据着举足轻重的地位。随着计算需求的日益增长,性能优化成为了MapReduce使用过程中不可避免的话题。本章将概述MapReduce性能革命的必要性,并引入后续章节的核心内容——combine与reduce的协同优化。

MapReduce的核心思想在于将复杂的问题拆分为Map(映射)和Reduce(归约)两个阶段,Map阶段处理数据并生成中间键值对,Reduce阶段则对这些键值对进行汇总。然而,伴随着数据量的增长,原有机制中的一些瓶颈开始显现,比如Shuffle阶段的数据传输以及内存管理等。为了应对这些挑战,MapReduce框架引入了combine函数来部分合并中间数据,减少网络I/O和磁盘I/O的开销,这是性能优化的第一步。在后续章节中,我们将深入探讨如何通过combine与reduce的协同工作来实现高效的数据处理。

# 2. Combine与Reduce的基本原理

MapReduce是一个高度抽象的数据处理模型,它隐藏了数据分布式处理的复杂性,使开发者可以专注于应用逻辑的实现。在MapReduce的处理流程中,Map阶段处理输入数据生成中间键值对,而Reduce阶段则对这些键值对进行汇总处理。这一章将深入探讨Map与Reduce之间的协同机制,并详细介绍Combine函数的作用与原理,以及它与Shuffle过程的关系。

## 2.1 MapReduce模型简述

### 2.1.1 MapReduce的工作流程

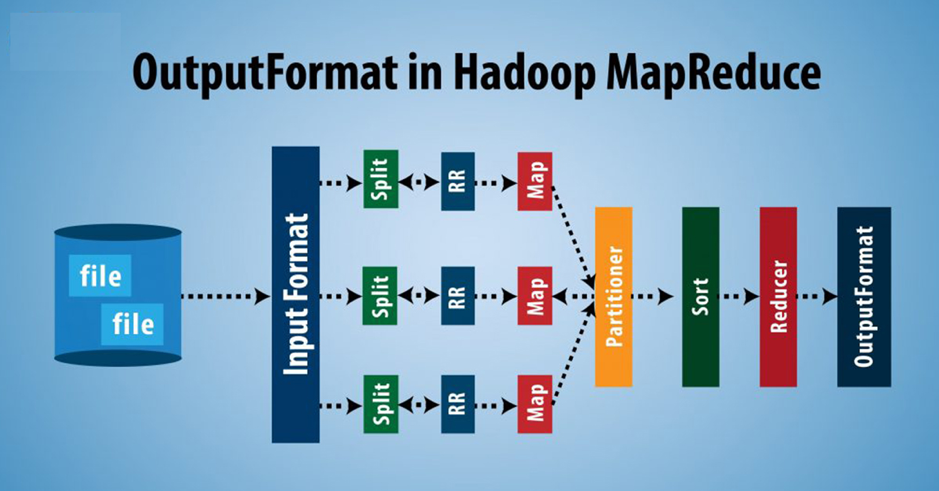

MapReduce工作流程可以分为三个主要阶段:Map阶段、Shuffle阶段和Reduce阶段。

**Map阶段:** 在这个阶段,输入数据被切分为独立的块,然后由Map任务处理。每个Map任务处理输入数据的一个块,并生成一系列中间键值对作为输出。

```java

// 伪代码:Map阶段的处理逻辑

map(String key, String value):

// 对每个输入的键值对执行Map函数

for each word w in value:

EmitIntermediate(w, "1");

```

Map函数的伪代码示例说明了基本的Map操作。其中,`EmitIntermediate`函数用于输出中间键值对。

**Shuffle阶段:** Shuffle阶段负责将Map阶段生成的中间键值对根据键值进行排序和分组,并传输到Reduce阶段。这一过程包括对键值对进行排序、合并,以及网络传输等步骤。

**Reduce阶段:** Reduce阶段的任务是对Shuffle后得到的中间键值对进行合并处理,最终生成用户所需的输出结果。

### 2.1.2 Map与Reduce的协同机制

在MapReduce模型中,Map任务和Reduce任务相互独立,但又通过Shuffle过程紧密协同。Map任务完成后,系统会自动触发Shuffle过程,并将中间结果传递给Reduce任务。

Shuffle过程不仅包括数据的传输,还涉及到错误处理、数据压缩和网络带宽优化等多个方面。优化Shuffle过程是提高MapReduce性能的关键。

## 2.2 Combine函数的作用与原理

### 2.2.1 Combine与Shuffle的关系

Combine函数的主要目的是在Map任务执行完毕后、Shuffle阶段开始前,对Map输出的键值对进行局部合并。这样做可以减少需要传输到Reduce任务的数据量,从而减少网络传输的压力。

```java

// 伪代码:Combine函数的处理逻辑

combine(String key, Iterator values):

// 对Map任务输出的键值对进行局部合并

for each value in values:

Emit(key, value);

```

Combine函数的伪代码展示了局部合并的基本思想。实际应用中,Combine可以大大提升系统的整体性能。

### 2.2.2 Combine函数的类型与选择

Combine函数的类型主要取决于具体应用的需求。通常情况下,有两种类型的Combine函数:

- **In-Mapper Combine:** 在Map任务内部实现的Combine函数,它可以进行更复杂的聚合操作。

- **框架提供的Combine:** MapReduce框架提供的标准Combine函数,它通常只进行简单的合并操作。

选择哪种类型的Combine函数取决于数据的特性和性能优化的需求。例如,如果Map输出的数据量很大,或者Reduce任务计算复杂度较高,那么使用In-Mapper Combine可能会更有效。

通过对比不同Combine函数的性能,开发者可以找出最适合当前应用需求的优化策略。在实际部署中,结合具体的数据特征和系统资源限制进行选择是至关重要的。

结合之前提到的内容,可以看到Combine函数与Shuffle阶段有着紧密的联系。它在MapReduce模型中起到了承上启下的作用,既提升了数据处理效率,也保证了系统的稳定性能。因此,在设计和实现MapReduce任务时,合理利用Combine函数是一项关键的优化策略。

# 3. Combine与Reduce的协同策略

## 3.1 优化Shuffle阶段的策略

Shuffle阶段在MapReduce作业中的性能至关重要,因为其直接关联到Map和Reduce任务之间的数据传输。在本小节中,我们将深入探讨如何优化Shuffle阶段,从而减少数据传输量和提升Shuffle效率。

### 3.1.1 减少数据传输量

减少数据传输量是优化Shuffle阶段的关键因素之一。这可以通过压缩数据实现,从而减少网络IO开销。下面将展示一个使用数据压缩的代码示例。

```java

// Java代码示例:使用数据压缩减少Shuffle阶段数据传输量

public class CompressingMapper extends Mapper<LongWritable, Text, Text, IntWritable> {

// 与非压缩相比,压缩可以显著减少数据大小,从而减少网络传输

private GZIPOutputStream gzipOutputStream;

@Override

protected void map(LongWritable key, Text value, Context context) throws IOExce

```

0

0