AdaBoost算法与集成学习方法的实战对比:优劣势大比拼

发布时间: 2024-08-20 12:17:39 阅读量: 47 订阅数: 50

模式识别和机器学习实战- 集成学习- Python实现 - AdaBoost算法

# 1. 集成学习的理论基础

集成学习是一种机器学习技术,它通过组合多个基学习器(例如,决策树、支持向量机)来提高模型的性能。集成学习的理论基础建立在以下几个关键概念之上:

- **多样性:**基学习器应该具有不同的预测能力,以减少模型的方差。

- **相关性:**基学习器之间的相关性应该较低,以避免模型的过拟合。

- **集成方法:**集成方法用于组合基学习器的预测,例如投票、加权平均或提升。

# 2. AdaBoost算法的原理与实现

### 2.1 AdaBoost算法的数学基础

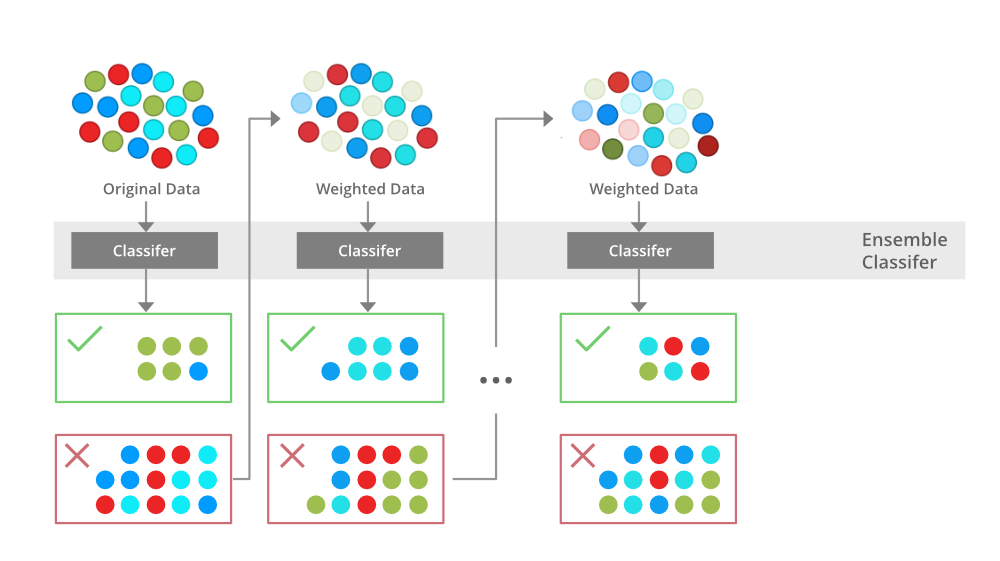

AdaBoost算法(Adaptive Boosting)是一种集成学习算法,其基本思想是通过迭代地训练多个弱分类器,并根据每个分类器的表现调整训练数据的权重,最终将这些弱分类器加权结合成一个强分类器。

AdaBoost算法的数学基础可以表示为:

```python

# 初始化训练数据权重

w_i = 1/N, i = 1, 2, ..., N

# 迭代训练弱分类器

for t = 1 to T:

# 训练第t个弱分类器h_t

# 计算弱分类器h_t的错误率e_t

# 计算弱分类器h_t的权重alpha_t = 1/2 * log((1 - e_t) / e_t)

# 更新训练数据权重

for i = 1 to N:

if h_t(x_i) != y_i:

w_i = w_i * exp(-alpha_t)

else:

w_i = w_i * exp(alpha_t)

# 归一化权重

w_i = w_i / sum(w_i)

# 最终分类器

H(x) = sign(sum(alpha_t * h_t(x), t = 1, 2, ..., T))

```

### 2.2 AdaBoost算法的算法流程

AdaBoost算法的算法流程如下:

1. 初始化训练数据权重为均匀分布。

2. 迭代训练弱分类器:

- 训练一个弱分类器。

- 计算弱分类器的错误率。

- 计算弱分类器的权重。

3. 更新训练数据权重:

- 对于被弱分类器正确分类的样本,降低其权重。

- 对于被弱分类器错误分类的样本,增加其权重。

4. 归一化权重。

5. 重复步骤2-4,直到训练出足够的弱分类器。

6. 将所有弱分类器加权结合成一个强分类器。

### 2.3 AdaBoost算法的实现步骤

AdaBoost算法的实现步骤如下:

1. **输入:**训练数据集D={(x_1, y_1), (x_2, y_2), ..., (x_N, y_N)}, 弱分类器学习算法。

2. **初始化:**训练数据权重w_i = 1/N, i = 1, 2, ..., N。

3. **迭代:**

- 对于t = 1 to T:

- 训练第t个弱分类器h_t。

- 计算弱分类器h_t的错误率e_t。

- 计算弱分类器h_t的权重alpha_t = 1/2 * log((1 - e_t) / e_t)。

- 更新训练数据权重:

- 对于i = 1 to N:

- 如果h_t(x_i) != y_i:

w_i = w_i * exp(-alpha_t)

- 否则:

w_i = w_i * exp(alpha_t)

- 归一化权重。

4. **输出:**强分类器H(x) = sign(sum(alpha_t * h_t(x), t = 1, 2, ..., T))。

# 3.1 随机森林算法

#### 3.1.1 随机森林算法的原理

随机森林算法是一种集成学习算法,它通过构建多个决策树来实现分类或回归任务。与传统的决策树不同,随机森林算法在构建决策树时采用了两种随机化策略:

- **特征随机化:**在构建每个决策树时,随机森林算法会从原始特征集中随机选择一个子集作为该决策树的特征集。这有助于减少决策树之间的相关性,提高算法的泛化能力。

- **样本随机化:**在构建每个决策树时,随机森林算法会从训练集中随机抽取一个子集作为该决策树的训练集。这有助于减少决策树之间的方差,提高算法的鲁棒性。

#### 3.1.2 随机森林算法的实现

随机森林算法的实现步骤如下:

1. **初始化:**

- 设置随机森林算法的参数,包括决策树的数量、特征子集的大小、样本子集的大小等。

2. **构建决策树:**

- 对于每个决策树:

- 从原始特征集中随机选择一个特征子集。

- 从训练集中随机抽取一个样本子集。

- 使用选择的特征子集和样本子集构建一个决策树。

3. **预测:**

- 对于新的样本:

- 将样本输入到所有决策树中,得到每个决策树的预测结果。

- 将所有决策树的预测结果进行组合,得到最终的预测结果。

**代码块:**

```python

```

0

0