AdaBoost算法在语音识别中的实战应用:实战案例解读

发布时间: 2024-08-20 12:58:46 阅读量: 18 订阅数: 41

AdaBoost算法在人脸识别中的应用.pdf

# 1. AdaBoost算法概述**

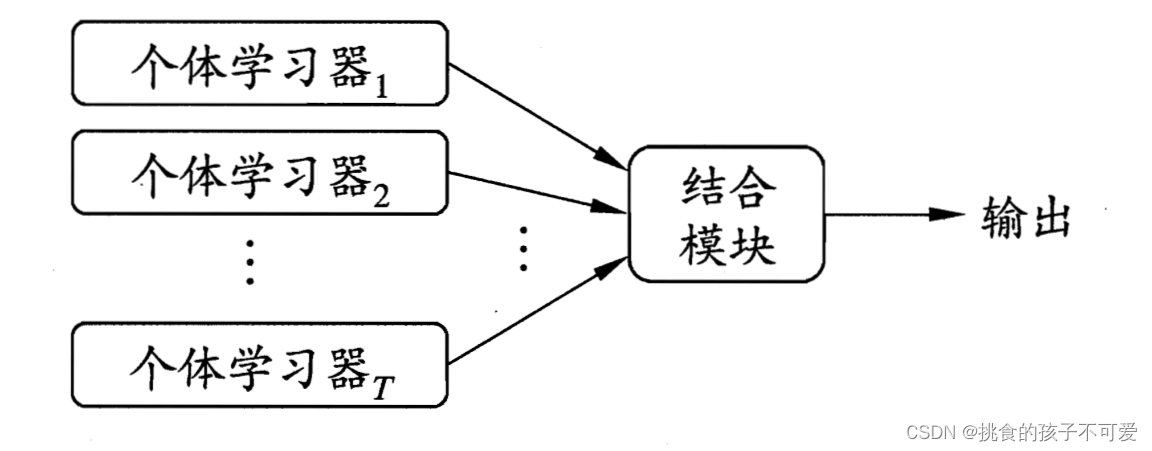

AdaBoost算法是一种迭代式集成学习算法,旨在通过组合多个弱学习器来构建一个强学习器。其核心思想是通过赋予不同训练样本不同的权重,迭代训练多个弱学习器,并根据弱学习器的表现对训练样本权重进行调整。最终,将这些弱学习器的预测结果加权求和,得到最终的预测结果。

AdaBoost算法的优势在于其能够有效处理高维、非线性数据,并且对异常值和噪声数据具有较强的鲁棒性。在语音识别领域,AdaBoost算法因其准确性和可解释性而被广泛应用,在各种语音识别任务中取得了良好的效果。

# 2. AdaBoost算法在语音识别中的应用理论

### 2.1 语音识别技术原理

语音识别技术是一种将语音信号转换为文本或其他符号形式的技术。其基本原理是:

1. **语音采集:**使用麦克风或其他设备采集语音信号。

2. **特征提取:**从语音信号中提取特征,如梅尔频率倒谱系数 (MFCC) 和线性预测系数 (LPC)。

3. **模型训练:**使用带标签的语音数据训练语音识别模型。

4. **语音识别:**将新的语音信号输入训练好的模型,输出识别结果。

### 2.2 AdaBoost算法在语音识别中的原理

AdaBoost (自适应提升) 算法是一种机器学习算法,用于提高分类器的性能。在语音识别中,AdaBoost 算法通过以下步骤应用:

1. **初始化:**为每个训练样本分配相同的权重。

2. **迭代:**

- 训练一个弱分类器。

- 计算弱分类器的错误率。

- 更新训练样本的权重,将错误分类的样本权重增加。

3. **加权:**将所有弱分类器的输出加权求和,得到最终的分类结果。

### 2.3 算法优化策略

为了提高 AdaBoost 算法在语音识别中的性能,可以采用以下优化策略:

- **弱分类器选择:**选择区分度较高的弱分类器,如决策树或支持向量机。

- **特征选择:**选择对语音识别任务最相关的特征。

- **加权策略:**调整更新训练样本权重的策略,如指数加权或对数加权。

- **迭代次数:**确定合适的迭代次数,以避免过拟合或欠拟合。

#### 代码示例:

```python

import numpy as np

from sklearn.ensemble import AdaBoostClassifier

# 训练数据

X_train = np.array([[0, 1], [1, 0], [0, 2], [1, 1]])

y_train = np.array([0, 1, 0, 1])

# 训练 AdaBoost 分类器

clf = AdaBoostClassifier(n_estimators=10)

clf.fit(X_train, y_train)

# 预测

X_test = np.array([[0, 0], [1, 2]])

y_pred = clf.predict(X_test)

print(y_pred)

```

#### 逻辑分析:

- `n_estimators` 参数指定弱分类器的数量。

- `fit` 方法训练 AdaBoost 分类器。

- `predict` 方法使用训练好的分类器进行预测。

#### 参数说明:

| 参数 | 描述 |

|---|---|

| `n_estimators` | 弱分类器的数量 |

| `learning_rate` | 更新训练样本权重的学习率 |

| `algorithm` | 弱分类器的算法,如 "SAMME" 或 "SAMME.R" |

# 3.1 算法实现框架

#### 框架设计

AdaBoost算法在语音识别中的实现框架主要包括以下几个模块:

- **数据预处理模块:**负责对语音数据进行预处理,包括语音信号的预处理、特征提取和特征选择等。

- **弱分类器训练模块:**负责训练多个弱分类器,每个弱分类器都针对语音数据的特定特征进行分类。

- **分类器权重计算模块:**负责根据弱分类器的分类性能计算每个弱分类器的权重。

- **强

0

0