集成学习利器:AdaBoost算法的实战分析,优缺点一网打尽

发布时间: 2024-08-20 12:14:08 阅读量: 32 订阅数: 42

国信证券_20160531_国信证券机器学习专题研究:Adaboost算法下的多因子选股.pdf

# 1. AdaBoost算法简介

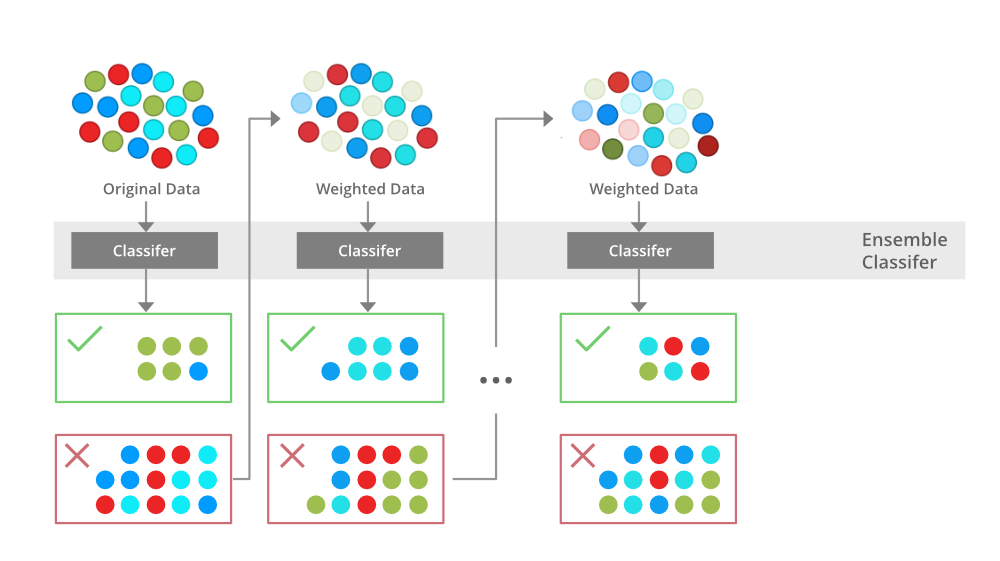

AdaBoost(Adaptive Boosting)算法是一种机器学习算法,用于构建强学习器。强学习器由多个弱学习器组合而成,每个弱学习器都对输入数据进行分类或回归。AdaBoost算法通过迭代地训练弱学习器,并根据每个弱学习器的表现对其进行加权,从而提高强学习器的准确性。

AdaBoost算法的主要思想是,在每次迭代中,算法会将重点放在难以分类的数据样本上。它通过增加错误分类样本的权重,迫使弱学习器专注于这些样本。通过这种方式,AdaBoost算法可以有效地利用弱学习器,并构建一个性能优异的强学习器。

# 2. AdaBoost算法理论基础

### 2.1 加权多数表决原理

AdaBoost算法的核心思想是加权多数表决。它将多个弱学习器(表现略好于随机猜测的学习器)组合成一个强学习器(表现远好于随机猜测的学习器)。

加权多数表决的基本原理如下:

- 对于每个训练样本,分配一个初始权重。

- 训练一个弱学习器,并根据其预测性能更新样本权重。

- 预测错误的样本权重增加,而预测正确的样本权重降低。

- 重复以上步骤,训练多个弱学习器。

- 最终的强学习器通过加权投票的方式进行预测,其中每个弱学习器的权重与其预测性能成正比。

### 2.2 弱学习器与强学习器

**弱学习器:**

- 弱学习器是表现略好于随机猜测的学习器。

- 它们通常是简单且易于训练的模型,例如决策树桩或线性分类器。

**强学习器:**

- 强学习器是表现远好于随机猜测的学习器。

- 它们通常是通过组合多个弱学习器构建的。

### 2.3 AdaBoost算法流程

AdaBoost算法流程如下:

```python

def AdaBoost(X, y, T):

"""

AdaBoost算法实现

参数:

X: 训练数据特征

y: 训练数据标签

T: 弱学习器数量

返回:

强学习器

"""

# 初始化样本权重

w = np.ones(X.shape[0]) / X.shape[0]

# 存储弱学习器

weak_learners = []

# 迭代训练弱学习器

for t in range(T):

# 训练弱学习器

h_t = train_weak_learner(X, y, w)

weak_learners.append(h_t)

# 计算弱学习器预测错误率

e_t = np.sum(w[y != h_t(X)])

# 更新样本权重

w = w * np.exp(-e_t * y * h_t(X)) / (2 * np.sqrt(e_t * (1 - e_t)))

# 构建强学习器

def strong_learner(x):

"""

强学习器预测函数

参数:

x: 输入数据

返回:

预测标签

"""

return np.sign(np.sum([h(x) * alpha for h, alpha in zip(weak_learners, alphas)]))

# 返回强学习器

return strong_learner

```

**代码逻辑分析:**

1. 初始化样本权重为均匀分布。

2. 迭代训练弱学习器,并更新样本权重。

3. 计算弱学习器的预测错误率。

4. 更新样本权重,使预测错误的样本权重增加。

5. 构建强学习器,通过加权投票的方式进行预测。

**参数说明:**

- `X`: 训练数据特征

- `y`: 训练数据标签

- `T`: 弱学习器数量

**表格:AdaBoost算法流程**

| 步骤 | 操作 |

|---|---|

| 1 | 初始化样本权重 |

| 2 | 训练弱学习器 |

| 3 | 计算弱学习器预测错误率 |

| 4 | 更新样本权重 |

| 5 | 构建强学习器 |

**Mermaid流程图:AdaBoost算法流程**

```mermaid

graph LR

subgraph 初始化

A[初始化样本权重]

end

subgraph 训练弱学习器

B[训练弱学习器]

C[计算弱学习器预测错误率]

D[更新样本权重]

end

subgraph 构建强学习器

E[构建强学习器]

end

A --> B

B --> C

C --> D

D --> B

B --> E

```

# 3.1 数据预处理与特征工程

**数据预处理**

数据预处理是机器学习任务中至关重要的一步,对于AdaBoost算法的性能至关重要。数据预处理步骤包括:

- **数据清洗:**删除缺失值、异常值和不一致的数据点。

- **数据转换:**将数据转换为适合AdaBoost算法处理的格式。这可能包括归一化、标准化或离散化。

- **特征选择:**选择与目标变量最

0

0