AdaBoost算法的实战扩展:从基本算法到提升树,实战应用

发布时间: 2024-08-20 12:25:33 阅读量: 28 订阅数: 42

机器学习面试必会算法集合

# 1. AdaBoost算法的基本原理

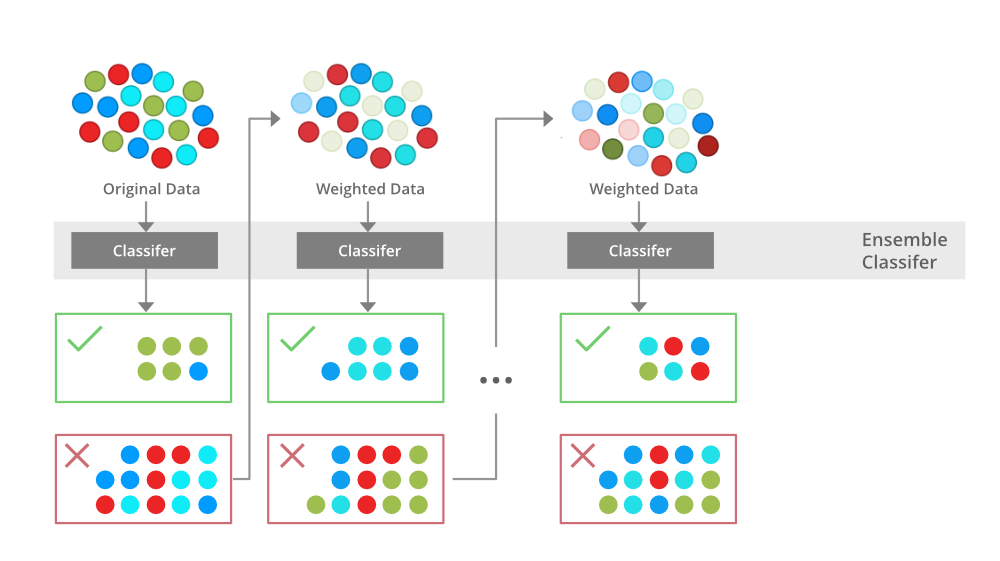

AdaBoost(自适应提升)算法是一种迭代的机器学习算法,用于提升弱学习器的性能,将其组合成一个强大的分类器。其基本原理如下:

- **弱学习器:**AdaBoost算法使用一系列弱学习器,每个弱学习器只能略微优于随机猜测。

- **权重分配:**算法根据每个样本的分类难度分配权重。被错误分类的样本的权重增加,而被正确分类的样本的权重降低。

- **迭代训练:**算法迭代地训练弱学习器,每次训练都使用更新后的权重分布。

- **加权投票:**训练完成后,算法将弱学习器的预测结果加权求和,其中权重与弱学习器的准确度成正比。

# 2. AdaBoost算法的实战扩展

### 2.1 AdaBoost.M1算法

#### 2.1.1 算法流程和数学原理

AdaBoost.M1算法是一种二分类算法,其基本思想是通过多次迭代训练弱学习器,并根据弱学习器的表现对训练数据进行加权,从而得到一个强分类器。算法流程如下:

1. 初始化训练数据权重,所有样本权重相等。

2. 对于第t次迭代:

- 训练一个弱学习器h_t。

- 计算弱学习器的错误率e_t。

- 更新训练数据权重:

- 正确分类的样本权重降低:w_t(i) = w_t(i) * exp(-α_t)

- 错误分类的样本权重增加:w_t(i) = w_t(i) * exp(α_t)

- 计算弱学习器的权重:α_t = 1/2 * log((1 - e_t) / e_t)

3. 构建强分类器:

- 强分类器的输出为:sign(∑_{t=1}^T α_t * h_t(x))

**数学原理:**

AdaBoost.M1算法的目标是找到一个强分类器,即一个能够以低错误率对数据进行分类的分类器。算法通过迭代训练弱学习器,并根据弱学习器的表现对训练数据进行加权,来达到这一目标。

在每次迭代中,算法计算弱学习器的错误率e_t。错误率越低,表明弱学习器对数据的分类能力越强。因此,算法会给正确分类的样本降低权重,而给错误分类的样本增加权重。

弱学习器的权重α_t是由错误率e_t计算得到的。错误率越低,α_t越大,表明弱学习器在强分类器中的作用越大。

#### 2.1.2 算法的优缺点和适用场景

**优点:**

- 能够有效提升弱学习器的性能。

- 对噪声数据和异常值具有鲁棒性。

- 训练速度快,计算复杂度低。

**缺点:**

- 容易过拟合,需要进行正则化处理。

- 对训练数据的分布敏感,需要对训练数据进行预处理。

**适用场景:**

- 二分类问题。

- 数据量大,特征维度高。

- 噪声数据和异常值较多。

### 2.2 AdaBoost.M2算法

#### 2.2.1 算法原理和改进之处

AdaBoost.M2算法是AdaBoost.M1算法的改进版本,其主要改进之处在于:

- 弱学习器的训练权重不再是固定的,而是根据弱学习器的错误率动态调整。

- 弱学习器的输出不再是二值分类,而是实值预测。

**算法原理:**

AdaBoost.M2算法的流程与AdaBoost.M1算法类似,但弱学习器的训练权重和输出有所不同。

在每次迭代中,算法根据弱学习器的错误率e_t计算弱学习器的权重α_t:

α_t = (1/2) * log((1 - e_t) / e_t) * (1 - 2e_t)

弱学习器的输出不再是二值分类,而是实值预测,即:

h_t(x) = 2 * (p_t(x) - 1/2)

其中,p_t(x)是弱学习器预测样本x属于正类的概率。

#### 2.2.2 算法的性能对比和应用范围

与AdaBoost.M1算法相比,AdaBoost.M2算法具有以下优点:

- 弱学习器的训练权重更合理,可以有效防止过拟合。

- 弱学习器的输出是实值预测,可以用于回归任务。

AdaBoost.M2算法适用于以下场景:

- 二分类和回归任务。

- 数据量大,特征维度高。

- 噪声数据和异常值较多。

# 3. 提升树算法

### 3.1 提升树的构造原理

#### 3.1.1 弱学习器的选择和加权

提升树算法是一种集成学习算法,通过组合多个弱学习器来构建一个强学习器。弱学习器可以是任何类型的分类器或回归器,但通常选择决策树作为弱学习器。

在提升树算法中,每个弱学习器都针对不同的训练数据子集进行训练。训练数据子集是通过对原始训练数据进行加权采样获得的。弱学习器的权重由其在训练数据子集上的表现决定。表现较好的弱学习器获得较高的权重。

#### 3.1.2 决策树的构建和剪枝

决策树是一种非参数监督学习模型,用于对数据进行分类或回归。决策树通过递归地将数据分割成更小的子集来构建。每个子集由一个特征和一个阈值定义。

在提升树算法中,决策树的构建遵循以下步骤:

1. 选择一个特征和一个阈值,将训练数据子集分割成两个子集。

2. 对每个子集重复步骤 1,直到满足停止条件。

3. 停止条件可以是:

- 数据子集中的所有样本都属于同一类。

- 数据子集中的样本数目小于某个阈值。

- 决策树的深度达到某个阈值。

决策树构建完成后,需要进行剪枝以防止过拟合。剪枝可以采用以下方法:

- **预剪枝:**在决策树构建过程中,当满足某些条件时,停止树的生长。

- **后剪枝:**在决策树构建完成后,删除一些子树以提高泛化能力。

### 3.2 提升树的实战应用

#### 3.2.1 提升树在分类任务中的应用

提升树算法可以用于解决分类任务。在分类任务中,目标是将数据样本分类到多个离散类别中。

使用提升树算法进行分类的步骤如下:

1. 初始化一个权重向量,其中每个样本的权重相等。

2. 对于每个弱学习器:

- 根据样本权重对训练数据进行加权采样。

- 训练一个决策树弱学习器。

- 计算弱学习器的权重。

3. 对于每个样本:

- 根据所有弱学习器的预测结果,计算样本的最终预测结果。

4. 更新样本权重,使表现错误的样本获得更高的权重。

5. 重复步骤 2-4,直到满足停止条件。

#### 3.2.2 提升树在回归任务中的应用

提升树算法也可以用于解决回归任务。在回归任务中,目标是预测一个连续值。

使用提

0

0