集成学习实战:使用AdaBoost算法解决现实问题,实战指南

发布时间: 2024-08-20 12:30:58 阅读量: 21 订阅数: 41

机器学习实战_机器学习_机器学习实战_peter_

# 1. 集成学习简介

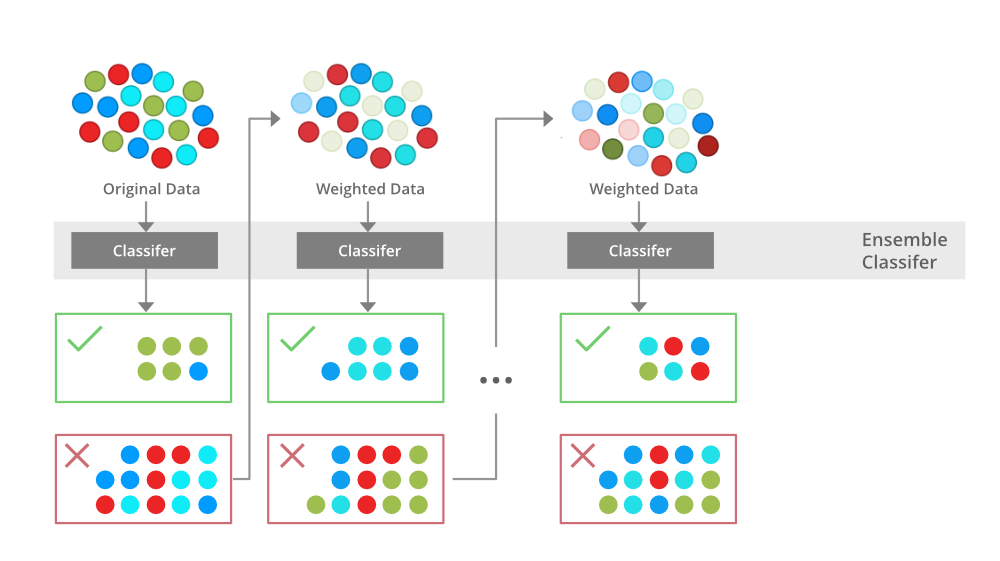

集成学习是一种机器学习技术,它通过组合多个弱学习器来创建更强大的学习器。集成学习的思想是,通过将多个弱学习器的预测结果进行加权平均,可以得到一个比任何单个弱学习器都更好的预测结果。

集成学习算法有很多种,其中最著名的算法之一是AdaBoost算法。AdaBoost算法是一种迭代算法,它通过多次迭代,逐步提高弱学习器的权重,从而得到一个最终的强学习器。AdaBoost算法在许多现实问题中都有着广泛的应用,例如图像分类、文本分类和垃圾邮件检测等。

# 2. AdaBoost算法原理与实现

### 2.1 AdaBoost算法的基本原理

AdaBoost(Adaptive Boosting)算法是一种集成学习算法,它通过对多个弱学习器进行加权组合,得到一个强学习器。弱学习器是指预测精度仅略高于随机猜测的学习器,而强学习器是指预测精度较高的学习器。

AdaBoost算法的基本原理如下:

1. 初始化训练数据,每个样本的权重相等。

2. 循环执行以下步骤:

- 训练一个弱学习器。

- 计算弱学习器的错误率。

- 更新训练数据的权重,错误分类的样本权重增加,正确分类的样本权重减小。

3. 将所有弱学习器加权组合,得到强学习器。

### 2.2 AdaBoost算法的实现步骤

AdaBoost算法的实现步骤如下:

1. 给定训练数据集 $D = \{(x_1, y_1), (x_2, y_2), ..., (x_N, y_N)\}$, 其中 $x_i$ 为样本,$y_i$ 为标签。

2. 初始化样本权重 $w_i = \frac{1}{N}$, $i = 1, 2, ..., N$。

3. 循环执行以下步骤 $T$ 次:

- 训练一个弱学习器 $h_t: X \rightarrow Y$。

- 计算弱学习器的错误率:

```

error_rate = \sum_{i=1}^{N} w_i I(h_t(x_i) \neq y_i)

```

- 更新样本权重:

```

w_i = w_i * exp(-α_t * y_i * h_t(x_i))

```

其中 $\alpha_t = \frac{1}{2} \ln(\frac{1 - error\_rate}{error\_rate})$。

4. 构建强学习器:

```

H(x) = sign(\sum_{t=1}^{T} \alpha_t * h_t(x))

```

### 2.3 AdaBoost算法的优缺点

**优点:**

- 能够有效提升弱学习器的预测精度。

- 对训练数据的分布不敏感。

- 训练过程简单,易于实现。

**缺点:**

- 容易过拟合,需要适当控制弱学习器的复杂度。

- 训练时间较长,尤其是当弱学习器数量较多时。

# 3.1 AdaBoost算法在图像分类中的应用

#### 3.1.1 图像分类问题的背景和挑战

图像分类是计算机视觉领域的一项基本任务,其目的是将图像自动分配到预定义的类别中。图像分类在许多实际应用中至关重要,例如对象识别、人脸检测和医学图像分析。

然而,图像分类也面临着一些挑战。首先,图像通常具有高维特征空间,这使得分类任务变得复杂。其次,图像往往存在噪声和变化,这可能会影响分类的准确性。

#### 3.1.2 AdaBoost算法在图像分类中的应用步骤

Ad

0

0