揭秘AdaBoost算法:集成学习中的秘密武器,助力实战应用

发布时间: 2024-08-20 12:07:28 阅读量: 30 订阅数: 34

# 1. AdaBoost算法概述**

AdaBoost(自适应提升)算法是一种集成学习算法,它通过结合多个弱分类器来构建一个强分类器。弱分类器是简单且准确率不高的分类器,而强分类器则是一个准确率较高的分类器。AdaBoost算法通过迭代地训练弱分类器并调整它们的权重,从而构建强分类器。

AdaBoost算法的核心思想是:在每次迭代中,算法会根据上一次迭代的错误率调整训练样本的权重。错误率较高的样本将获得较高的权重,而错误率较低的样本将获得较低的权重。这样,在下一轮迭代中,算法会重点训练那些错误率较高的样本,从而提高强分类器的整体准确率。

# 2. AdaBoost算法原理

### 2.1 算法流程

AdaBoost算法是一个迭代算法,其流程如下:

1. **初始化:**给定训练数据集,为每个样本分配相同的权重。

2. **循环:**对于每个迭代:

- **训练弱分类器:**使用当前权重分布训练一个弱分类器。

- **计算弱分类器的错误率:**计算弱分类器在训练集上的错误率。

- **更新权重:**增加错误分类样本的权重,降低正确分类样本的权重。

3. **组合弱分类器:**将所有弱分类器加权组合成一个强分类器。

### 2.2 权重更新策略

AdaBoost算法的权重更新策略是算法的核心。它通过增加错误分类样本的权重,降低正确分类样本的权重,来提高弱分类器的训练效果。

权重更新公式如下:

```python

w_i^(t+1) = w_i^t * exp(-α_t * y_i * h_t(x_i))

```

其中:

- `w_i^t` 是样本 `x_i` 在第 `t` 次迭代的权重。

- `α_t` 是第 `t` 次迭代弱分类器的权重。

- `y_i` 是样本 `x_i` 的真实标签。

- `h_t(x_i)` 是第 `t` 次迭代弱分类器的预测结果。

### 2.3 弱分类器的选择

AdaBoost算法可以与任何类型的弱分类器一起使用。常用的弱分类器包括:

- **决策树:**单层或多层决策树,用于根据特征将样本分类。

- **线性分类器:**线性函数,用于将样本投影到一维空间并根据阈值进行分类。

- **神经网络:**浅层神经网络,用于学习样本的非线性特征。

弱分类器的选择取决于数据集和任务的具体要求。

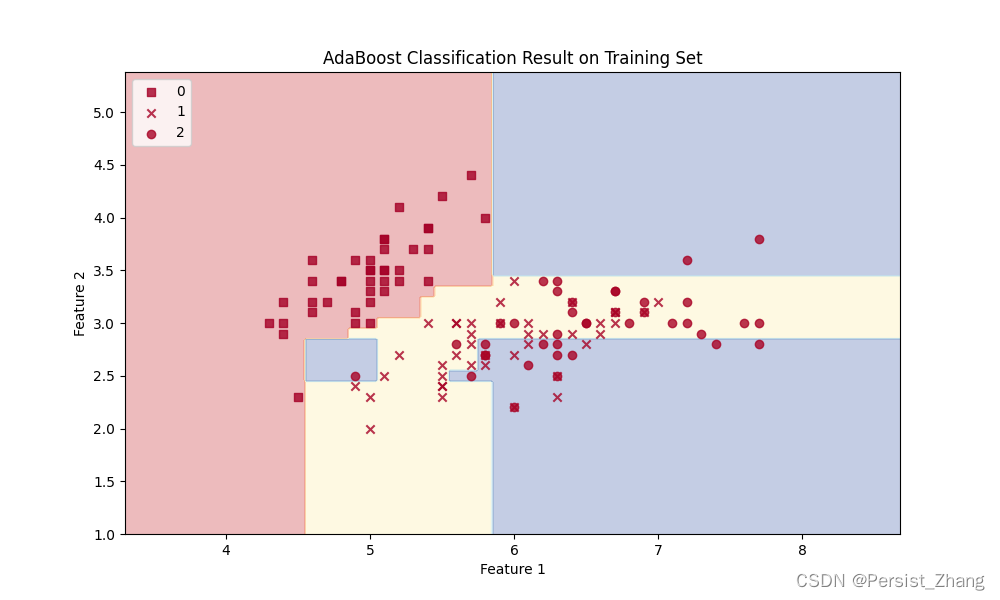

# 3.1 分类任务

AdaBoost算法在分类任务中得到了广泛的应用。其基本思想是通过训练一系列弱分类器,并根据它们的性能对它们进行加权,最终构建一个强分类器。

**步骤:**

1. **初始化:**将训练样本的权重初始化为相等。

2. **迭代:**

- 对于每个弱分类器:

- 训练弱分类器。

- 计算弱分类器的错误率。

- 计算弱分类器的权重。

- 更新训练样本的权重。

3. **构建强分类器:**将所有弱分类器的加权预测结果相加,并根据加权和对新样本进行分类。

**代码示例:**

```python

import numpy as np

class AdaBoostClassifier:

def __init__(self, n_estimators=10):

self.n_estimators = n_estimators

self.weak_classifiers = []

self.weights = []

def fit(self, X, y):

n_samples, n_features = X.shape

weights = np.ones(n_samples) / n_samples

for i in range(self.n_estimators):

# 训练弱分类器

weak_classifier = WeakClassifier()

weak_classifier.fit(X, y, weights)

# 计算弱分类器的错误率

error = weak_classifier.error(X, y, weights)

# 计算弱分类器的权重

weight = 0.5 * np.log((1 - error) / error)

# 更新训练样本的权重

weights *= np.exp(-weight * weak_classifier.predict(X) * y)

weights /= np.sum(weights)

# 保存弱分类器和权重

self.weak_classifiers.append(weak_classifier)

self.weights.append(weight)

def predict(self, X):

predictions = np.zeros(X.shape[0])

for i, weak_classifier in enumerate(self.weak_classifiers):

predictions += self.weights[i] * weak_classifier.predict(X)

return np.sign(predictions)

```

**逻辑分析:**

* `fit()`方法初始化权重,然后迭代训练弱分类器。

* 对于每个弱分类器,它计算错误率并更新权重。

* `predict()`方法将弱分类器的加权预测结果相加,并根据加权和对新样本进行分类。

### 3.2 回归任务

AdaBoost算法也可以用于回归任务。与分类任务类似,它通过训练一系列弱回归器并根据它们的性能对它们进行加权,最终构建一个强回归器。

**步骤:**

1. **初始化:**将训练样本的权重初始化为相等。

2. **迭代:**

- 对于每个弱回归器:

- 训练弱回归器。

- 计算弱回归器的平方误差。

- 计算弱回归器的权重。

- 更新训练样本的权重。

3. **构建强回归器:**将所有弱回归器的加权预测结果相加,得到最终的回归预测。

**代码示例:**

```python

import numpy as np

class AdaBoostRegressor:

def __init__(self, n_estimators=10):

self.n_estimators = n_estimators

self.weak_regressors = []

self.weights = []

def fit(self, X, y):

n_samples, n_features = X.shape

weights = np.ones(n_samples) / n_samples

for i in range(self.n_estimators):

# 训练弱回归器

weak_regressor = WeakRegressor()

weak_regressor.fit(X, y, weights)

# 计算弱回归器的平方误差

error = weak_regressor.error(X, y, weights)

# 计算弱回归器的权重

weight = 0.5 * np.log((1 - error) / error)

# 更新训练样本的权重

weights *= np.exp(-weight * (weak_regressor.predict(X) - y) ** 2)

weights /= np.sum(weights)

# 保存弱回归器和权重

self.weak_regressors.append(weak_regressor)

self.weights.append(weight)

def predict(self, X):

predictions = np.zeros(X.shape[0])

for i, weak_regressor in enumerate(self.weak_regressors):

predictions += self.weights[i] * weak_regressor.predict(X)

return predictions

```

**逻辑分析:**

* `fit()`方法初始化权重,然后迭代训练弱回归器。

* 对于每个弱回归器,它计算平方误差并更新权重。

* `predict()`方法将弱回归器的加权预测结果相加,得到最终的回归预测。

### 3.3 异常检测

AdaBoost算法还可以用于异常检测。通过训练一系列弱分类器来识别正常样本,并根据它们的性能对它们进行加权,最终构建一个强分类器来检测异常样本。

**步骤:**

1. **初始化:**将训练样本的权重初始化为相等。

2. **迭代:**

- 对于每个弱分类器:

- 训练弱分类器。

- 计算弱分类器的错误率。

- 计算弱分类器的权重。

- 更新训练样本的权重。

3. **构建强分类器:**将所有弱分类器的加权预测结果相加,并根据加权和对新样本进行分类。

**代码示例:**

```python

import numpy as np

class AdaBoostDetector:

def __init__(self, n_estimators=10):

self.n_estimators = n_estimators

self.weak_detectors = []

self.weights = []

def fit(self, X, y):

n_samples, n_features = X.shape

weights = np.ones(n_samples) / n_samples

for i in range(self.n_estimators):

# 训练弱检测器

weak_detector = WeakDetector()

weak_detector.fit(X, y, weights)

# 计算弱检测器的错误率

error = weak_detector.error(X, y, weights)

# 计算弱检测器的权重

weight = 0.5 * np.log((1 - error) / error)

# 更新训练样本的权重

weights *= np.exp(-weight * weak_detector.predict(X) * (1 - y))

weights /= np.sum(weights)

# 保存弱检测器和权重

self.weak_detectors.append(weak_detector)

self.weights.append(weight)

def predict(self, X):

predictions = np.zeros(X.shape[0])

for i, weak_detector in enumerate(self.weak_detectors):

predictions += self.weights[i] * weak_detector.predict(X)

return np.sign(predictions)

```

**逻辑分析:**

* `fit()`方法初始化权重,然后迭代训练弱检测器。

* 对于每个弱检测器,它计算错误率并更新权重。

* `predict()`方法将弱检测器的加权预测结果相加,并根据加权和对新样本进行分类。

# 4. AdaBoost算法的性能优化

在实际应用中,为了进一步提升AdaBoost算法的性能,可以从以下几个方面进行优化:

### 4.1 弱分类器的选择优化

弱分类器的选择直接影响AdaBoost算法的整体性能。常用的弱分类器包括决策树、线性判别器和神经网络等。在选择弱分类器时,需要考虑以下几个因素:

- **分类精度:**弱分类器的分类精度越高,AdaBoost算法的整体性能越好。

- **训练速度:**弱分类器的训练速度越快,AdaBoost算法的训练时间越短。

- **鲁棒性:**弱分类器对噪声和异常值越鲁棒,AdaBoost算法的性能越稳定。

### 4.2 权重更新策略优化

权重更新策略是AdaBoost算法的核心机制。常见的权重更新策略包括指数加权和对数加权等。不同的权重更新策略对AdaBoost算法的性能有不同的影响。

- **指数加权:**指数加权策略会对错误分类的样本赋予更大的权重,从而使AdaBoost算法更关注这些样本。

- **对数加权:**对数加权策略会对所有样本赋予相同的权重,从而使AdaBoost算法更均衡地考虑所有样本。

### 4.3 算法并行化

AdaBoost算法是一个串行的算法,其训练过程需要逐个训练弱分类器。为了提高算法的效率,可以采用并行化的方式来训练弱分类器。

并行化AdaBoost算法的常见方法包括:

- **多线程并行:**将弱分类器的训练任务分配给多个线程,同时进行训练。

- **GPU并行:**利用GPU的并行计算能力,同时训练多个弱分类器。

通过并行化,可以大幅缩短AdaBoost算法的训练时间,从而提高算法的整体效率。

**代码示例:**

```python

import numpy as np

import multiprocessing

def parallel_adaboost(X, y, n_weak_classifiers):

"""

并行化的AdaBoost算法

参数:

X: 特征矩阵

y: 标签向量

n_weak_classifiers: 弱分类器的数量

返回:

alpha: 弱分类器的权重向量

h: 弱分类器集合

"""

# 创建一个进程池

pool = multiprocessing.Pool()

# 创建一个任务列表,每个任务训练一个弱分类器

tasks = []

for i in range(n_weak_classifiers):

task = (X, y, i)

tasks.append(task)

# 并行执行任务

results = pool.map(train_weak_classifier, tasks)

# 关闭进程池

pool.close()

pool.join()

# 从结果中提取弱分类器和权重

h = [result[0] for result in results]

alpha = [result[1] for result in results]

return alpha, h

def train_weak_classifier(task):

"""

训练一个弱分类器

参数:

task: 一个元组,包含特征矩阵、标签向量和弱分类器的索引

返回:

h: 弱分类器

alpha: 弱分类器的权重

"""

X, y, i = task

# 训练弱分类器

h = train_classifier(X, y)

# 计算弱分类器的权重

alpha = calculate_weight(h, X, y)

return h, alpha

```

**逻辑分析:**

该代码实现了并行化的AdaBoost算法。它使用多进程并行训练弱分类器,从而提高算法的效率。

**参数说明:**

- `X`: 特征矩阵

- `y`: 标签向量

- `n_weak_classifiers`: 弱分类器的数量

- `alpha`: 弱分类器的权重向量

- `h`: 弱分类器集合

# 5. AdaBoost算法的局限性**

### **5.1 过拟合问题**

过拟合是机器学习算法的一个常见问题,它指的是模型在训练集上表现良好,但在新数据上表现不佳。AdaBoost算法容易出现过拟合,因为其通过迭代地训练弱分类器来逐步提升模型的性能。随着弱分类器数量的增加,模型可能会过分关注训练集中的噪声和异常值,从而导致对新数据的泛化能力下降。

**解决方法:**

* **早期停止:**在训练过程中,监控模型在验证集上的性能。当验证集上的性能开始下降时,停止训练以防止过拟合。

* **正则化:**向损失函数中添加正则化项,以惩罚模型的复杂度。这有助于防止模型过分拟合训练数据。

* **弱分类器多样性:**使用不同的弱分类器算法来训练弱分类器。这有助于减少模型对特定类型的特征的依赖,从而提高泛化能力。

### **5.2 噪声敏感性**

AdaBoost算法对训练数据中的噪声和异常值非常敏感。噪声数据可能会导致弱分类器的权重分配不当,从而影响模型的整体性能。

**解决方法:**

* **数据预处理:**在训练之前,对数据进行预处理以去除噪声和异常值。

* **鲁棒弱分类器:**选择对噪声数据具有鲁棒性的弱分类器算法。

* **加权训练:**根据数据的置信度对训练样本进行加权。这有助于降低噪声数据的影响。

### **5.3 计算复杂度高**

AdaBoost算法的计算复杂度随着弱分类器数量的增加而增加。对于大型数据集,训练AdaBoost模型可能需要大量的计算时间。

**解决方法:**

* **并行化:**将AdaBoost训练过程并行化,以减少训练时间。

* **弱分类器选择优化:**选择计算效率高的弱分类器算法。

* **早期停止:**在模型达到足够好的性能时停止训练,以减少计算时间。

# 6. AdaBoost算法的扩展

### 6.1 Real AdaBoost

Real AdaBoost算法是AdaBoost算法的一种改进版本,它解决了AdaBoost算法中权重更新策略存在的问题。在AdaBoost算法中,错误分类样本的权重会不断增加,这可能导致算法对异常值过于敏感。Real AdaBoost算法通过使用相对权重更新策略来解决这个问题。

```python

def real_adaboost(X, y, n_iter=100):

"""

Real AdaBoost算法

参数:

X: 特征矩阵

y: 目标变量

n_iter: 迭代次数

返回:

分类器

"""

# 初始化权重

w = np.ones(X.shape[0]) / X.shape[0]

# 迭代

for i in range(n_iter):

# 训练弱分类器

clf = DecisionTreeClassifier(max_depth=1)

clf.fit(X, y, sample_weight=w)

# 计算弱分类器的错误率

err = np.sum(w[clf.predict(X) != y]) / np.sum(w)

# 计算弱分类器的权重

alpha = 0.5 * np.log((1 - err) / err)

# 更新权重

w = w * np.exp(-alpha * y * clf.predict(X))

w = w / np.sum(w)

# 返回分类器

return clf

```

### 6.2 Gentle AdaBoost

Gentle AdaBoost算法是AdaBoost算法的另一种改进版本,它通过使用平滑的权重更新策略来解决AdaBoost算法中权重更新策略过于激进的问题。在Gentle AdaBoost算法中,错误分类样本的权重会增加一个常数,而不是像AdaBoost算法那样增加一倍。

```python

def gentle_adaboost(X, y, n_iter=100):

"""

Gentle AdaBoost算法

参数:

X: 特征矩阵

y: 目标变量

n_iter: 迭代次数

返回:

分类器

"""

# 初始化权重

w = np.ones(X.shape[0]) / X.shape[0]

# 迭代

for i in range(n_iter):

# 训练弱分类器

clf = DecisionTreeClassifier(max_depth=1)

clf.fit(X, y, sample_weight=w)

# 计算弱分类器的错误率

err = np.sum(w[clf.predict(X) != y]) / np.sum(w)

# 计算弱分类器的权重

alpha = 0.5 * np.log((1 - err) / err)

# 更新权重

w = w * np.exp(-alpha * y * clf.predict(X))

w = w / np.sum(w) + 0.01

# 返回分类器

return clf

```

### 6.3 LogitBoost

LogitBoost算法是AdaBoost算法的又一种改进版本,它通过使用逻辑回归作为弱分类器来解决AdaBoost算法中弱分类器选择过于受限的问题。在LogitBoost算法中,弱分类器可以是任意形式的分类器,只要它能够输出概率值。

```python

def logitboost(X, y, n_iter=100):

"""

LogitBoost算法

参数:

X: 特征矩阵

y: 目标变量

n_iter: 迭代次数

返回:

分类器

"""

# 初始化权重

w = np.ones(X.shape[0]) / X.shape[0]

# 迭代

for i in range(n_iter):

# 训练弱分类器

clf = LogisticRegression()

clf.fit(X, y, sample_weight=w)

# 计算弱分类器的错误率

err = np.sum(w[clf.predict(X) != y]) / np.sum(w)

# 计算弱分类器的权重

alpha = 0.5 * np.log((1 - err) / err)

# 更新权重

w = w * np.exp(-alpha * y * clf.predict_proba(X)[:, 1])

w = w / np.sum(w)

# 返回分类器

return clf

```

0

0