大型文本数据集的SpaCy策略:大规模NLP处理技巧

发布时间: 2024-09-30 20:14:38 阅读量: 40 订阅数: 44

# 1. SpaCy框架概述

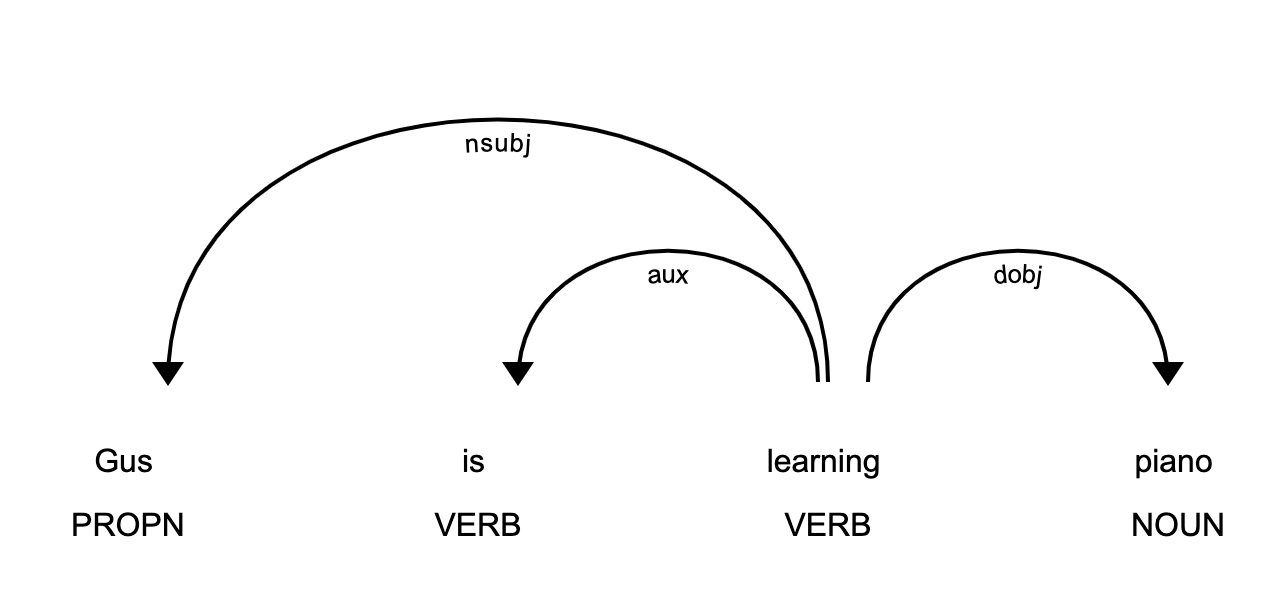

SpaCy是Python中一个广泛使用的自然语言处理库,它以速度和效率为设计核心,支持多种语言,并且拥有丰富的NLP功能,包括但不限于分词、词性标注、命名实体识别、依存解析等。它与其它如NLTK的库相比,更加强调于在真实世界中大规模的文本数据处理。由于其底层优化以及使用Cython进行编译,SpaCy能够提供快速的NLP任务处理,这对于需要处理大量数据的企业级应用场景尤为关键。

SpaCy还提供了预训练的模型,可以实现开箱即用的功能。这些模型是用真实世界的数据集训练的,确保了它们在各种NLP任务中的实用性。开发者还可以使用SpaCy进行模型的定制和训练,以适应特定场景的需求。

本文将引导读者深入了解SpaCy框架,从基础的概念介绍到高级应用,再到真实世界的项目实践。我们将探讨SpaCy的文本预处理策略、大规模数据集处理、高级NLP任务应用,并提供实际案例分析,以及未来发展趋势的预测。

```python

# 导入SpaCy并加载英文模型

import spacy

nlp = spacy.load("en_core_web_sm")

```

在这个例子中,我们导入了SpaCy模块,并加载了一个英文的小模型用于后续的文本处理实例。这是了解和使用SpaCy框架的第一步,从这个基础开始,我们将会逐步深入探讨其更高级的用法和场景应用。

# 2. 文本数据预处理策略

文本预处理是自然语言处理(NLP)中的关键步骤,它涉及清除数据中的噪声和不规则性,以便于后续的分析和建模。本章节深入探讨SpaCy在文本数据预处理中的应用,涵盖了从文本清洗到实体识别的整个流程。我们将详细讨论如何使用SpaCy标准化文本数据格式、去除无用信息、进行分词和词性标注、以及如何实现实体识别和关系抽取。

### 2.1 文本清洗技术

#### 2.1.1 标准化文本数据格式

在处理文本数据之前,将文本统一到一个标准格式是非常重要的。SpaCy通过内置的工具和方法支持多种文本清洗和标准化技术。

```python

import spacy

# 加载英文模型

nlp = spacy.load("en_core_web_sm")

# 示例文本

text = "Dr. Green was born in the U.S.A., but she moved to France in 2008."

# 使用SpaCy处理文本

doc = nlp(text)

# 标准化处理

for token in doc:

print(f"原文本: {token.text}, 标准化: {token.lemma_}")

```

以上代码展示了如何将文本中的单词进行规范化。SpaCy的`lemma_`属性返回的是单词的词根形式,对于处理语法变体和不同形式的单词非常有用。

标准化处理不仅限于单词词根化,还包括统一缩写词的全称、去除标点符号、数字转换等。SpaCy为这些任务提供了一系列的工具和方法,可以有效地应用于文本清洗流程中。

#### 2.1.2 清除无用信息和噪音

文本数据通常包含许多与分析任务无关的信息,如HTML标签、特殊符号、停用词等,这些都需要在分析前被清除。

```python

import spacy

from spacy.matcher import Matcher

# 加载英文模型

nlp = spacy.load("en_core_web_sm")

# 示例文本

text = "The quick brown fox jumps over the lazy dog. <p>It's a sentence with HTML tags.</p>"

# 使用SpaCy处理文本

doc = nlp(text)

# 创建一个匹配器对象

matcher = Matcher(nlp.vocab)

# 定义要删除的模式

pattern = [{'IS_DIGIT': True}, {'IS_PUNCT': True}, {'IS_SPACE': True}]

# 将模式添加到匹配器

matcher.add("Noise", None, pattern)

# 查找并删除噪音

matches = matcher(doc)

spans = [doc[start:end] for match_id, start, end in matches]

doc = doc.remove_spans(spans)

# 输出清洗后的文本

print([token.text for token in doc])

```

这段代码展示了如何使用SpaCy的`Matcher`组件来查找和删除文本中的特定模式。在这个例子中,我们定义了一个模式来查找数字、标点符号和空白字符,并将这些部分从文档中移除。

### 2.2 分词与词性标注

#### 2.2.1 理解SpaCy的分词机制

分词是将连续的文本序列分割为有意义的单元(如单词、短语等)。SpaCy使用预训练的模型来实现分词,这些模型通常是通过大量的文本语料库学习得到的。

```python

import spacy

# 加载英文模型

nlp = spacy.load("en_core_web_sm")

# 示例文本

text = "SpaCy is an open-source software library for advanced Natural Language Processing."

# 使用SpaCy进行分词

doc = nlp(text)

# 输出分词结果

print([token.text for token in doc])

```

通过这段代码,我们使用SpaCy的分词器对一段文本进行分词,并打印出分词结果。SpaCy的分词器会为每个分词分配一个独一无二的ID,为后续的处理步骤提供了便利。

#### 2.2.2 实践中的词性标注技巧

词性标注(POS Tagging)是为文本中的每个单词分配语法类别(名词、动词、形容词等)的过程。SpaCy通过其预训练模型,为每个分词自动添加了POS标签。

```python

import spacy

# 加载英文模型

nlp = spacy.load("en_core_web_sm")

# 示例文本

text = "SpaCy is an open-source software library for advanced Natural Language Processing."

# 使用SpaCy进行词性标注

doc = nlp(text)

# 输出POS标签

print([(token.text, token.pos_) for token in doc])

```

在这段代码中,我们利用SpaCy对示例文本进行词性标注,并打印出每个单词和对应的POS标签。SpaCy的输出可以帮助我们理解文本中单词的功能和上下文含义。

### 2.3 实体识别与关系抽取

#### 2.3.1 探索SpaCy的实体识别能力

实体识别是NLP中的一个核心任务,它涉及识别和分类文本中的命名实体(如人名、地名、组织名等)。SpaCy内置了实体识别器,并且提供了丰富的内置模型。

```python

import spacy

# 加载英文模型

nlp = spacy.load("en_core_web_sm")

# 示例文本

text = "Apple is looking at buying U.K. startup for $1 billion"

# 使用SpaCy进行实体识别

doc = nlp(text)

# 输出实体识别结果

print([(ent.text, ent.label_) for ent in doc.ents])

```

在这段代码中,我们使用SpaCy对文本中的实体进行识别,并打印出每个实体的文本及其标签。SpaCy能够识别多种实体类型,如人名、地点、组织等,并为每种类型分配了特定的标签。

#### 2.3.2 实体关系抽取方法及实践

关系抽取旨在识别实体之间的相互关系,它是在实体识别的基础上进一步分析文本的关键步骤。SpaCy通过处理词汇间的关系来实现这一目标。

```python

import spacy

# 加载英文模型

nlp = spacy.load("en_core_web_sm")

# 示例文本

text = "Google acquired DeepMind, a London-based artificial intelligence company."

# 使用SpaCy处理文本

doc = nlp(text)

# 实体关系抽取

for ent in doc.ents:

print(f"实体: {ent.text}, 类型: {ent.label_}")

for token in ent:

print(f"实体中使用的词汇: {token.text}")

# 查找实体间的关系

print([(token.text, token.dep_, token.head.text) for token in doc if token.dep_ == "nsubj"])

```

在这段代码中,我们使用SpaCy对文本中的实体进

0

0