词向量深度学习实践:SpaCy文本处理进阶之路

发布时间: 2024-09-30 19:51:46 阅读量: 31 订阅数: 44

# 1. 词向量深度学习的基础知识

## 1.1 什么是词向量?

词向量是将词语转换为计算机可理解的数值形式的过程。在深度学习中,这些数值形式通常是一组实数向量,它们能够捕捉词语间的语义关系和上下文信息。词向量通过训练模型从大量文本中学习得到,是自然语言处理(NLP)任务的关键组件。

## 1.2 词向量的发展历程

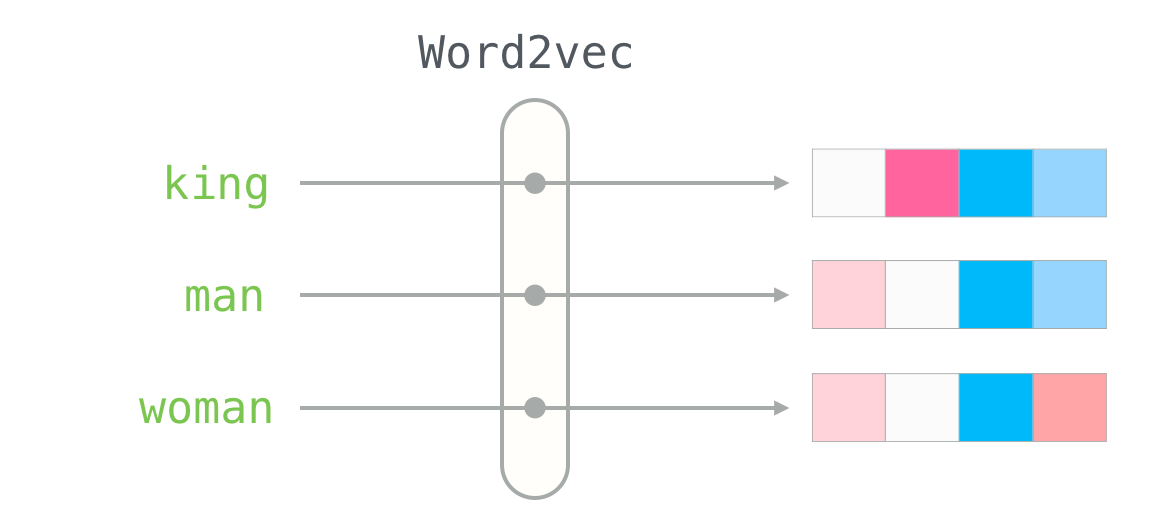

词向量的历史可追溯至One-hot编码,这种简单的表示方法因缺乏语义信息而逐渐被密集向量替代。随着深度学习的发展,Word2Vec、GloVe等模型的出现标志着词向量技术的重大进步。这些模型能够学习到词语的分布式表示,捕捉到上下文的语义关系。

## 1.3 深度学习与词向量的关系

深度学习模型特别适合处理复杂的非线性关系,它通过多层神经网络能够更好地捕捉词与词之间的细微差别,从而生成更为丰富的词向量。深度学习模型如CNN、RNN和Transformer架构,已经广泛应用于词向量的生成和优化过程中。这些模型不仅提升了词向量的质量,也推动了NLP领域的发展。

# 2. SpaCy文本处理入门

## 2.1 SpaCy的基础使用

### 2.1.1 安装和配置SpaCy

在深入了解SpaCy的文本处理能力之前,我们需要先掌握SpaCy的基础安装与配置。SpaCy 是一个强大的自然语言处理库,专为生产环境和速度优化设计。SpaCy 提供了简单易用的接口,使得处理和理解文本变得容易和快速。

SpaCy 的安装过程简单明了,可以通过Python的包管理工具pip来完成。在安装前,需要确保Python环境已经搭建完成。安装SpaCy的基本命令如下:

```bash

pip install spacy

```

安装完毕后,为了使用特定语言模型,需要加载相应的预训练模型。例如,加载英文模型的命令如下:

```python

import spacy

nlp = spacy.load("en_core_web_sm")

```

在上述代码中,`spacy.load` 方法用于加载预训练的模型,而 `"en_core_web_sm"` 是一个小型英文模型,适用于各种基础的NLP任务。

### 2.1.2 SpaCy的基本命令和操作

一旦配置完成,我们可以开始使用SpaCy执行一些基本的文本处理任务。SpaCy处理文本的一个核心对象是`doc`对象,它代表了被处理文本的文档结构。以下是一个简单的示例,展示了如何将一段文本转换为`doc`对象,并进行简单的处理。

```python

import spacy

# 加载模型

nlp = spacy.load("en_core_web_sm")

# 处理文本

doc = nlp("Apple is looking at buying U.K. startup for $1 billion")

# 遍历文档中的词元

for token in doc:

print(token.text, token.pos_, token.dep_)

```

该代码块首先加载英文模型,并处理了一段示例文本。然后,通过遍历`doc`对象中的每个词元(token),打印出了每个词元的文本内容、词性(part-of-speech, POS)和依赖关系(dependency)。这样的操作可以帮助我们理解文档的语法结构。

## 2.2 SpaCy的文本处理功能

### 2.2.1 文本的分词和标注

文本的分词和标注是NLP中非常重要的预处理步骤,SpaCy提供了强大的工具来自动化这一过程。分词指的是将连续文本切分成一个个独立的词元,而标注则是为每个词元赋予语法属性。

使用SpaCy进行分词和标注的代码示例如下:

```python

import spacy

# 加载模型

nlp = spacy.load("en_core_web_sm")

# 处理文本

doc = nlp(u"Apple is looking at buying U.K. startup for $1 billion")

# 获取词性标注和依存标注

for token in doc:

print(f"Token: {token.text}, POS: {token.pos_}, Dep: {token.dep_}")

```

执行上述代码会输出每一个词元的文本、词性标注和依赖关系。`token.pos_` 表示词性,例如名词(NOUN)、动词(VERB)等,`token.dep_` 表示词元与其他词元之间的语法关系。

### 2.2.2 词向量的生成和应用

词向量是一种将词汇表示为密集的、连续的向量的技术,这种技术在自然语言处理任务中非常重要,因为它们能够捕获词汇的语义信息。

在SpaCy中,可以使用如下代码来获取词向量,并进行一些基本的操作:

```python

import spacy

# 加载模型

nlp = spacy.load("en_core_web_sm")

# 处理文本

doc = nlp(u"Apple is looking at buying U.K. startup for $1 billion")

# 打印第一个词的词向量

apple_vector = doc[0].vector

print(apple_vector)

# 进行向量的相似度比较

vector_similarity = doc[0].similarity(doc[1])

print(vector_similarity)

```

在上面的代码中,`doc[0].vector` 可以获取“Apple”这个词的词向量。`doc[0].similarity(doc[1])` 则计算了“Apple”和紧随其后的词“is”的向量相似度,输出的相似度值在0到1之间,值越大表示两个词越相似。

## 2.3 SpaCy的高级文本处理

### 2.3.1 实体识别和关系抽取

实体识别(Named Entity Recognition, NER)是识别文本中具有特定意义实体的过程,比如人名、地点和组织机构等。关系抽取(Relation Extraction, RE)则是识别文本中实体之间的关系。

使用SpaCy进行实体识别和关系抽取的示例代码如下:

```python

import spacy

# 加载模型

nlp = spacy.load("en_core_web_sm")

# 处理文本

doc = nlp(u"Apple is looking at buying U.K. startup for $1 billion")

# 输出实体识别结果

print("Entities:", [(ent.text, ent.label_) for ent in doc.ents])

# 关系抽取

relations = []

for token in doc:

for child in token.children:

if child.dep_ == "attr" and child.ent_type_:

relations.append((token.text, child.text, child.dep_))

print("Relations:", relations)

```

在这段代码中,`doc.ents` 表示文档中被识别的实体,并打印出每个实体的文本及其类型。而关系抽取部分,通过遍历`doc`对象中的每个词元,并检查其依赖关系,以识别可能的实体间关系。

### 2.3.2 词向量的训练和优化

尽管SpaCy提供了预训练的词向量,但在某些情况下,我们可能需要根据特定的文本集或领域训练自己的词向量。Spacy也支持这一功能,可以通过简单的步骤来训练和优化词向量。

```python

import spacy

from spacy.training.example import Example

# 加载模型

nlp = spacy.load("en_core_web_sm")

# 创建一个新的空模型

nlp_new = spacy.blank("en")

# 创建文本的示例对象

text = "Highly scalable cloud-based platform for data analytics"

doc = nlp_new.make_doc(text)

example = Example.from_dict(nlp_new.make_doc(text), {

"words": text.split(),

"spaces": [True] * len(text.split())

})

# 训练模型

nlp_new.update([example])

```

在上述代码中,我们首先加载了一个空的SpaCy模型。接着,我们创建了一个文档对象,并将文本分割为词元。然后,我们创建了一个`Example`对象,并通过`nlp_new.update`方法更新模型。这个简单的过程就可以训练一个新的词向量模型,尽管在实践中,为了获得高质量的词向量,需要准备大规模的训练数据集,并多次迭代训练。

到此,我们已经了解了SpaCy的基础安装和配置方法,探索了如何使用SpaCy执行分词、标注、实体识别等任务,并展示了如何训练和优化词向量模型。接下来的章节,我们将深入探讨深度学习如何与SpaCy结合,提升文本处理的效果和能力。

# 3. 深度学习在SpaCy中的应用

## 3.1 深度学习的基础理论

深度学习是机器学习领域的一个子集,它通过构建和训练深度神经网络来模仿人类大脑处理数据和学习的机制。与传统机器学习方法相比,深度学习能在更复杂的数据上进行更深层次的特征提取和模式识别。

### 3.1.1 神经网络的基本概念和模型

神经网络是一种由大量互相连接的节点(或称神经元)组成的计算模型。每一个神经元会处理输入信号,并将其传递到其他神经元。最基础的神经网络单元是感知器(Perceptron),它通过一个线性加权和函数处理输入信号,并通过一个激活函数产生输出。

深度神经网络包含多层,这些层次包括输入层、隐藏层和输出层。隐藏层的数量和每层的神经元数量可以根据任务的复杂程度来调整。常用的深度学习模型架构包括全连接网络(Feedforward Neural Networks)、卷积神经网络(CNNs)和循环神经网络(RNNs)等。

### 3.1.2 深度

0

0