异常值检测与处理:数据清洗的终极指南

发布时间: 2024-09-03 20:19:13 阅读量: 293 订阅数: 50

# 1. 异常值检测与处理概述

在数据分析领域,异常值的检测和处理是一个关键步骤,它关系到数据质量的高低和后续分析结果的准确性。本章将概述异常值的概念及其检测和处理的重要性,为读者在实际工作中提供一个全面的理解框架。

## 1.1 数据质量与异常值

数据质量是数据分析的基础,异常值可能会因为错误、噪声或正常变异而出现。识别和处理异常值是确保数据质量的关键环节。它们不仅可能干扰模型的训练,还可能导致错误的结论和决策。

## 1.2 异常值的影响

异常值对统计分析和机器学习模型的影响可以是灾难性的。它们可能扭曲参数估计,导致错误的假设检验结论,甚至可能掩盖重要的数据趋势。因此,在数据分析流程中,合理地处理异常值是必不可少的。

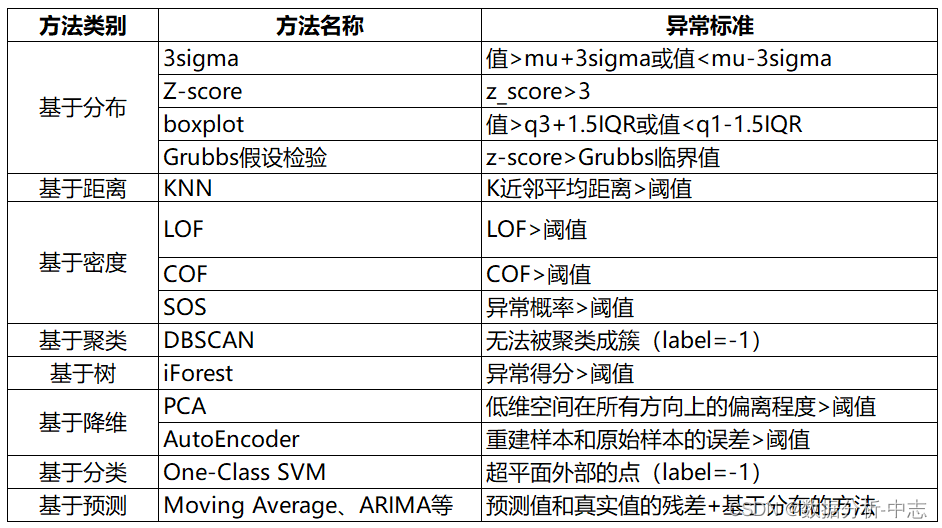

## 1.3 检测与处理方法

异常值检测的方法多种多样,从简单的统计方法如Z-Score和IQR,到复杂的机器学习算法,应根据数据的特性和需求选择合适的方法。处理方法包括但不限于删除、修正或使用鲁棒性更强的技术。本章将提供对这些方法的初步了解。

# 2. 理论基础与异常值识别方法

### 2.1 统计学中的异常值理论

异常值是数据集中与整体数据分布不一致的观测值。在统计学中,异常值的识别是数据清洗过程中的一个关键步骤,因为它们可能会扭曲分析结果和数据模型。了解异常值的基础理论对于正确识别和处理它们至关重要。

#### 2.1.1 异常值的定义和特性

异常值有时也被称作离群点,它们代表了数据集中那些不符合预期模式的观察。识别异常值首先要求我们定义什么是“正常”的数据行为。这通常涉及到对数据分布的理解。例如,在一个正态分布的数据集中,极端远离均值的数据点很可能就是异常值。这些值通常具有以下几个特性:

- **不一致性**:与其他数据相比,异常值在数据集中显得格格不入。

- **罕见性**:在大多数情况下,异常值出现的概率较低。

- **因果关系**:异常值可能源自于测量错误、数据录入错误,或者真实的数据波动,需要进一步调查。

#### 2.1.2 异常值的识别原则

识别异常值时应遵循一些基本原则,以确保过程的客观性和有效性:

- **数据分布**:理解数据的分布特性是识别异常值的前提。

- **上下文相关性**:要考虑数据收集和测量的实际环境。

- **统计检验**:运用统计检验方法来判断一个值是否是异常值。

- **可视化方法**:通过箱线图、散点图等可视化手段辅助识别。

### 2.2 常用的异常值检测技术

异常值的检测技术多种多样,根据数据的类型和分布,选择合适的检测技术是关键。

#### 2.2.1 Z-Score方法

Z-Score是基于数据的均值和标准差来检测异常值的一种方法。计算每个数据点的Z-Score值,即:

```

Z = (X - μ) / σ

```

其中,X是观察值,μ是均值,σ是标准差。如果Z-Score绝对值大于某个阈值(一般为3),则认为该数据点是异常值。

#### 2.2.2 IQR方法

四分位距(Interquartile Range, IQR)方法是一种基于百分位数的检测技术。IQR是第三四分位数(Q3)与第一四分位数(Q1)之间的差值。计算IQR后,可以通过以下公式识别异常值:

```

异常值 = Q1 - 1.5 * IQR 或 Q3 + 1.5 * IQR

```

超出这个范围的值被视作异常值。

#### 2.2.3 箱线图分析

箱线图是可视化异常值的一种有效工具,它显示了数据的最小值、第一四分位数、中位数、第三四分位数和最大值。箱线图中的“胡须”(whiskers)通常表示数据的边界,超出这个边界的点被认为是异常值。

### 2.3 多维数据的异常检测策略

多维数据的异常检测比单维数据要复杂得多,因为要考虑多个变量之间的相互作用。

#### 2.3.1 聚类分析中的异常检测

聚类是将数据分为多个组或簇的过程,数据点会根据相似性聚集在一起。在聚类分析中,位于远离簇中心的数据点可以被视为异常值。

#### 2.3.2 主成分分析(PCA)在异常检测中的应用

主成分分析是一种降维技术,它通过转换到一个新的坐标系统来减少数据的维度,同时保留数据的变异性。在PCA后,异常值通常在第一或第二主成分上有异常大的分数。

#### 2.3.3 基于密度的方法

基于密度的方法识别异常值的思路是寻找低密度区域的数据点。其中一种方法是局部异常因子(Local Outlier Factor, LOF),它通过比较数据点与其邻居的密度差异来检测异常值。

在本节中,我们深入了解了异常值检测与识别的基础理论与方法。在接下来的章节中,我们将探讨异常值处理的技术与实践,以及更高级的应用场景。

# 3. 异常值处理的技术与实践

## 3.1 异常值处理前的数据准备

### 3.1.1 数据的探索性分析

在进行异常值处理之前,必须对数据进行彻底的探索性分析。探索性数据分析(Exploratory Data Analysis, EDA)是一种分析数据集的方法,旨在提出假设,并对数据集的特征、异常值以及潜在的模式有所了解。通过EDA,可以初步发现数据的分布情况、异常值的初步迹象,以及变量之间的关系。

EDA步骤通常包括绘制直方图、箱线图、散点图等,这些图形工具有助于可视化数据的分布特性。例如,箱线图可以直观地显示数据的中位数、四分位数和潜在的异常值。直方图则可以展示数据的分布形态,帮助识别数据的集中趋势和异常分布。

例如,以下是使用Python的pandas和matplotlib库来绘制箱线图的代码:

```python

import pandas as pd

import matplotlib.pyplot as plt

# 假设df是已经加载的包含数据的DataFrame,'data_column'是需要分析的列名

df = pd.DataFrame({'data_column': [...]})

plt.figure(figsize=(10, 6))

df.boxplot(column='data_column')

plt.title('Boxplot of Data Column')

plt.show()

```

通过箱线图可以很快发现数据中的异常值,通常表现为远离主要分布的点。这些异常值可能代表真实的潜在问题,也可能是数据录入错误等。

### 3.1.2 数据预处理技术

数据预处理是异常值处理前的一个关键步骤。在这一阶段,数据需要被清洗、转换和归一化,以确保后续分析的准确性和效率。数据预处理技术包括:

1. 缺失值处理:缺失值可能是因为数据采集失败或传输错误造成的。常见的处理方法包括删除含有缺失值的记录、填充缺失值(使用均值、中位数、众数或根据其他变量建立模型预测)。

2. 数据标准化/归一化:不同量纲或量级的数据在处理前需要进行标准化或归一化,以减少量纲差异对分析结果的影响。

3. 数据转换:对于非正态分布的数据,可能需要进行对数转换、Box-Cox转换等,以满足一些异常值检测算法的假设。

## 3.2 异常值的处理方法

### 3.2.1 修正或填补技术

在某些情况下,如果确定异常值是由于错误的测量或录入造成的,可以进行修正或填补。修正通常涉及更正错误的数据点。而填补技术则包括以下几种方法:

- **均值/中位数填补**:对于数值型数据,可以使用该列的均值或中位数替换异常值。中位数填补对异常值更不敏感,因此在存在极端异常值时更受青睐。

- **模型预测填补**:使用其他变量建立预测模型,通过模型预测的值来填补异常值。这种方法适用于变量之间存在较强相关性的情况。

### 3.2.2 删除异常值

删除含有异常值的记录是处理异常值的简单方法之一

0

0