MATLAB神经网络算法:优化和超参数调整

发布时间: 2024-06-16 12:29:46 阅读量: 92 订阅数: 32

# 1. 神经网络基础

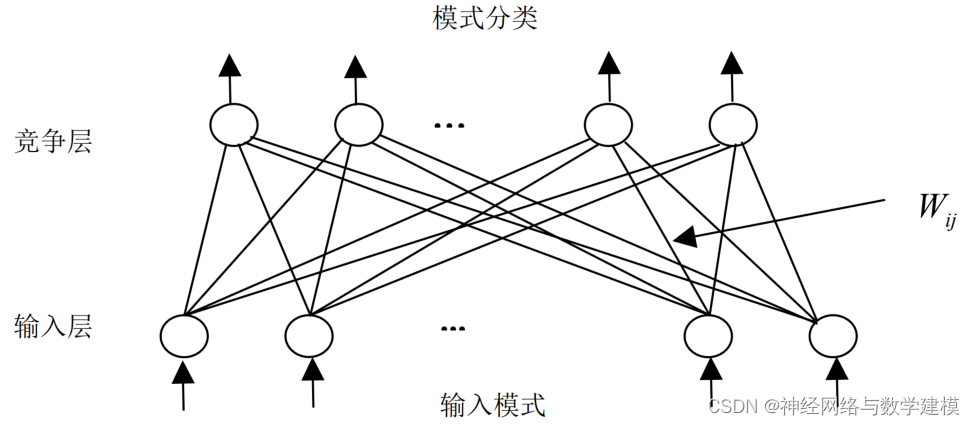

神经网络是一种机器学习算法,它受人脑结构和功能的启发。它由称为神经元的互连层组成,每个神经元接收输入、应用非线性激活函数并产生输出。

神经网络可以学习复杂的关系和模式,使其适用于各种任务,包括图像识别、自然语言处理和时间序列预测。它们通过训练过程进行优化,其中网络权重和偏差被调整以最小化损失函数。

# 2. 优化算法

### 2.1 梯度下降法

梯度下降法是一种迭代算法,用于最小化函数。它通过沿函数梯度的相反方向移动来更新模型参数,从而逐步逼近函数的最小值。

#### 2.1.1 批量梯度下降

批量梯度下降(BGD)是梯度下降法的一种,它使用整个训练数据集来计算梯度。BGD的更新规则为:

```

w = w - α * ∇f(w)

```

其中:

* w是模型参数

* α是学习率

* ∇f(w)是目标函数f(w)关于w的梯度

#### 2.1.2 随机梯度下降

随机梯度下降(SGD)是梯度下降法的一种,它使用训练数据集中的单个样本来计算梯度。SGD的更新规则为:

```

w = w - α * ∇f(w, x_i)

```

其中:

* x_i是训练数据集中的一个样本

#### 2.1.3 小批量梯度下降

小批量梯度下降(MBGD)是BGD和SGD的折衷方案。它使用训练数据集中的一个小批量样本来计算梯度。MBGD的更新规则为:

```

w = w - α * ∇f(w, X_b)

```

其中:

* X_b是训练数据集中的一个小批量样本

### 2.2 动量法

动量法是一种梯度下降法的变体,它通过引入动量项来加速收敛速度。动量项记录了梯度的历史信息,并将其用于更新模型参数。动量法的更新规则为:

```

v = β * v + (1 - β) * ∇f(w)

w = w - α * v

```

其中:

* v是动量项

* β是动量系数

### 2.3 RMSProp

RMSProp(Root Mean Square Propagation)是一种梯度下降法的变体,它通过自适应调整学习率来提高收敛速度。RMSProp的更新规则为:

```

s = γ * s + (1 - γ) * (∇f(w))^2

w = w - α * ∇f(w) / sqrt(s + ε)

```

其中:

* s是均方根梯度

* γ是平滑系数

* ε是一个小的正数,用于防止除以零

### 2.4 Adam

Adam(Adaptive Moment Estimation)是一种梯度下降法的变体,它结合了动量法和RMSProp的优点。Adam的更新规则为:

```

m = β_1 * m + (1 - β_1) * ∇f(w)

v = β_2 * v + (1 - β_2) * (∇f(w))^2

w = w - α * m / sqrt(v + ε)

```

其中:

* m是动量项

* v是均方根梯度

* β_1和β_2是平滑系数

* ε是一个小的正数,用于防止除以零

# 3.1 学习率

**定义:**

学习率是优化算法在每次迭代中更新权重的步长。它控制着算法朝着最优解移动的速度。

**影响:**

学习率对神经网络的训练有重大影响:

* **过高的学习率:**可能导致算法跳过最优解,甚至发散。

* **过低的学习率:**可能导致算法收敛缓慢,甚至陷入局部极小值。

**选择:**

选择合适的学习率至关重要。以下是一些常用的方法:

* **手动调整:**手动尝试不同的学习率,直到找到最佳值。

* **自适应学习率:**使用算法(如Adam)自动调整学习率。

* **余弦退火:**随着训练的进行,逐渐降低学习率。

**代码示例:**

```matlab

% 创建优化器

optimizer = optimizers.adam;

% 设置学习率

optimizer.LearningRate = 0.001;

% 训练神经网络

net = trainNetwork(X, Y, net, optimizer);

```

**逻辑分析:**

此代码使用Adam优化器创建了一个神经网络。优化器的学习率设置为0.001。然后,使用提供的训练数据(X和Y)训练网络。

**参数说明:**

* `LearningRate`:优化器的学习率。

### 3.2 批次大小

**定义:**

批次大小是每次迭代中用于更新权重的训练数据的样本数量。

**影响:**

批次大小也对训练过程有影响:

* **较大的批次大小:**可能导致训练更稳定,但收敛速度较慢。

* **较小的批次大小:**可能导致训练更不稳定,但收敛速度较快。

**选择:**

批次大小的选择取决于数据集的大小和神经网络的复杂性。一般来说,较大的数据集和更复杂的网络需要较大的批次大小。

**代码示例:**

```matlab

% 创建数据加载器

dataLoader = DataLoader(X, Y, 'MiniBatchSize', 32);

% 训练神经网络

net = trainNetwork(dataLoader, net);

```

**逻辑分析:**

此代码使用数据加载器创建了一个批次大小为32的训练数据加载器。然后,使用提供的训练数据加载器训练网络。

**参数说明:**

* `MiniBatchSize`:数据加载器的批次大小。

### 3.3 激活函数

**定义:**

激活函数是神经网络中非线性的数学函数,它将神经元的输入转换为输出。

**影响:**

激活函数决定了神经网络的非线性行为,这对于学习复杂模式至关重要。常用的激活函数包括:

* ReLU

* sigmoid

* tanh

**选择:**

激活函数的选择取决于网络的类型和任务。例如,ReLU通常用于图像分类,而sigmoid用于二分类。

**代码示例:**

```matlab

% 创建神经网络层

layers = [

imageInputLayer([28 28 1])

convolution2dLayer(3, 32)

```

0

0