XGBoost特征重要性:实战指南,构建高效特征集

发布时间: 2024-08-21 05:55:00 阅读量: 92 订阅数: 38

# 1. XGBoost简介和特征重要性概念**

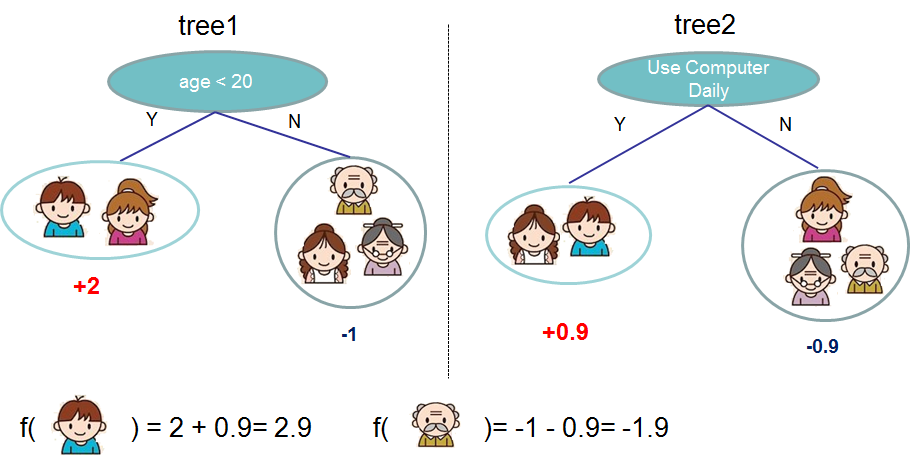

XGBoost(Extreme Gradient Boosting)是一种流行的梯度提升算法,用于解决机器学习中的分类和回归问题。其核心思想是通过组合多个弱学习器(如决策树)来构建一个强学习器。

特征重要性衡量了每个特征对模型预测结果的影响程度。在XGBoost中,特征重要性通常通过计算每个特征在构建决策树时的增益或减少量来评估。特征重要性高的特征对模型预测能力贡献更大。

# 2. 特征重要性评估方法

特征重要性评估方法是量化特征对模型预测结果影响程度的技术。在XGBoost中,有两种主要类型的特征重要性评估方法:基于树模型的和基于permutation的。

### 2.1 基于树模型的特征重要性

基于树模型的特征重要性评估方法利用树模型的结构来计算特征的重要性。这些方法通常基于特征在树中分裂的次数或分裂后信息增益的增加。

#### 2.1.1 Gini重要性

Gini重要性是基于Gini不纯度计算的特征重要性度量。Gini不纯度衡量数据集的异质性,特征在降低数据集Gini不纯度方面的贡献越大,其重要性就越高。

**计算公式:**

```

Gini_importance(feature) = Σ(Gini_gain(feature, split) * weight(split))

```

* `Gini_gain(feature, split)`:特征`feature`在分裂`split`处的信息增益

* `weight(split)`:分裂`split`的权重

#### 2.1.2 信息增益

信息增益是基于信息论计算的特征重要性度量。信息增益衡量特征在减少数据集熵方面的贡献,特征在减少数据集熵方面的贡献越大,其重要性就越高。

**计算公式:**

```

Info_gain(feature) = Σ(Info_gain(feature, split) * weight(split))

```

* `Info_gain(feature, split)`:特征`feature`在分裂`split`处的信息增益

* `weight(split)`:分裂`split`的权重

### 2.2 基于permutation的特征重要性

基于permutation的特征重要性评估方法通过随机扰乱特征值来评估特征的重要性。这些方法通常基于模型预测结果的变化或模型性能的下降。

#### 2.2.1 随机森林重要性

随机森林重要性是一种基于permutation的特征重要性评估方法,它通过随机扰乱特征值并测量模型预测结果的变化来计算特征的重要性。

**计算公式:**

```

RF_importance(feature) = Σ(OOB_error(original) - OOB_error(permuted)) / OOB_error(original)

```

* `OOB_error(original)`:原始数据集上的袋外误差

* `OOB_error(permuted)`:特征值被随机扰乱后的袋外误差

#### 2.2.2 XGBoost SHAP值

XGBoost SHAP值是一种基于permutation的特征重要性评估方法,它通过计算特征对单个预测结果的影响来计算特征的重要性。

**计算公式:**

```

SHAP_value(feature, instance) = E(f(x') - f(x))

```

* `f(x')`:特征`feature`在实例`x'`上的预测结果

* `f(x)`:特征`feature`在实例`x`上的预测结果

# 3. XGBoost特征重要性实战

### 3.1 数据预处理和特征工程

在进行特征重要性分析之前,需要对数据进行预处理和特征工程,以确保数据的质量和特征的有效性。

#### 数据预处理

数据预处理包括处理缺失值、异常值、数据类型转换和标准化等操作。缺失值可以根据具体情况进行填充或删除,异常值可以进行截断或替换,数据类型转换可以将不同类型的数据统一为可比较的格式,标准化可以将数据缩放到统一的范围,提高模型的训练效率和稳定性。

#### 特征工程

特征工程是将原始特征转换为更具信息量和预测力的特征的过程。常用的特征工程方法包括特征选择、特征转换和特征组合。特征选择可以去除冗余和无关的特征,特征转换可以将原始特征转换为更适合模型训练的格式,特征组合可以将多个特征组合成更具表达力的新特征。

### 3.2 XGBoost模型训练和特征重要性计算

数据预处理和特征工程完成后,就可以开始训练XGBoost模型并计算特征重要性。

#### XGBoost模型训练

XGBoost模型训练的过程如下:

```python

import xgboost as xgb

# 定义训练数据和标签

X_train, y_train = ..., ...

# 定义XGBoost模型参数

params = {

'max_depth': 5,

'learning_rate': 0.1,

'n_estimators': 100

}

# 训练XGBo

```

0

0