XGBoost特征重要性:基础指南,提升模型性能的基石

发布时间: 2024-08-21 05:49:21 阅读量: 41 订阅数: 43

# 1. XGBoost特征重要性的概述

特征重要性是机器学习中衡量特征对模型预测能力影响程度的指标。在XGBoost中,特征重要性被用来识别对模型贡献最大的特征,从而帮助我们理解模型的行为,优化模型性能。

XGBoost使用一种基于增益权重、覆盖率权重和F-score权重的算法来计算特征重要性。这些权重衡量了每个特征在决策树分裂中减少预测误差的程度。通过将这些权重加权平均,我们可以获得每个特征的整体重要性分数。

# 2. 特征重要性理论基础

### 2.1 信息增益和信息增益率

**信息增益**衡量特征对目标变量划分数据集的有效性。它计算为:

```python

IG(Feature, Target) = H(Target) - H(Target | Feature)

```

其中:

- `H(Target)`:目标变量的信息熵

- `H(Target | Feature)`:在给定特征值的情况下,目标变量的信息熵

**信息增益率**将信息增益标准化为特征的值的数量,以避免偏向具有更多值的特征。它计算为:

```python

IGR(Feature, Target) = IG(Feature, Target) / H(Feature)

```

其中:

- `H(Feature)`:特征的信息熵

### 2.2 基尼不纯度和基尼系数

**基尼不纯度**衡量数据集的不纯度程度,即不同类别样本混合的程度。它计算为:

```python

Gini(Dataset) = 1 - Σ(p_i)^2

```

其中:

- `p_i`:数据集中的第 `i` 类别的概率

**基尼系数**是基尼不纯度的归一化形式,范围为 `[0, 1]`。它计算为:

```python

Gini_coef(Dataset) = Gini(Dataset) / (1 - Gini(Dataset))

```

### 2.3 决策树和随机森林中的特征重要性

**决策树**中的特征重要性通常使用信息增益或基尼不纯度来计算。在每个节点,选择具有最高信息增益或最低基尼不纯度的特征作为分裂特征。

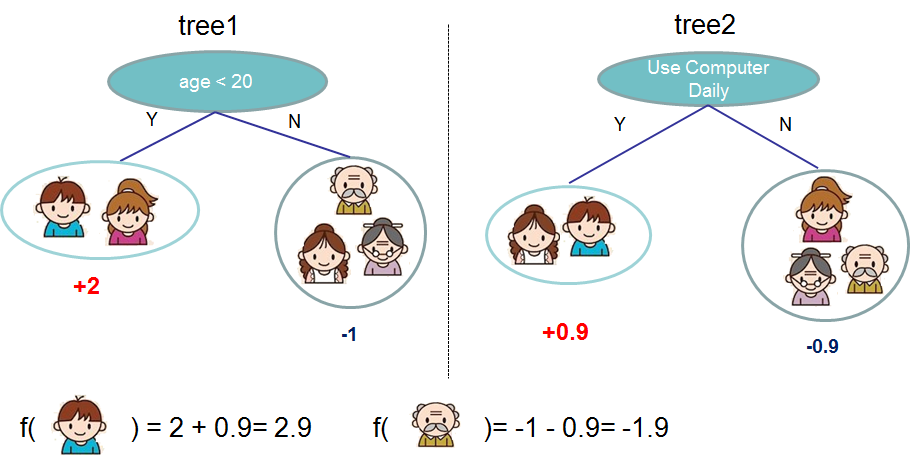

**随机森林**是一种集成学习算法,它使用多个决策树来预测目标变量。随机森林中的特征重要性是其组成决策树中所有特征重要性的平均值。

# 3. XGBoost特征重要性算法

### 3.1 增益权重

增益权重是XGBoost中衡量特征重要性的第一种方法。它基于信息增益的概念,信息增益衡量了特征在决策树中划分数据时减少的信息不确定性。

**算法:**

1. 计算特征在每个分割点处的增益。

2. 将每个分割点的增益加权平均,权重为分割点处的样本数。

3. 将所有分割点的加权平均增益相加,得到特征的增益权重。

**代码块:**

```python

import xgboost as xgb

# 训练XGBoost模型

model = xgb.XGBClassifier()

model.fit(X, y)

# 计算特征重要性

importance_gain = model.feature_importances_

# 打印特征重要性

print("增益权重:", importance_gain)

```

**逻辑分析:**

* `model

0

0