XGBoost特征重要性:分布式计算,大数据场景下的高效分析

发布时间: 2024-08-21 06:07:10 阅读量: 36 订阅数: 48

# 1. XGBoost特征重要性概述**

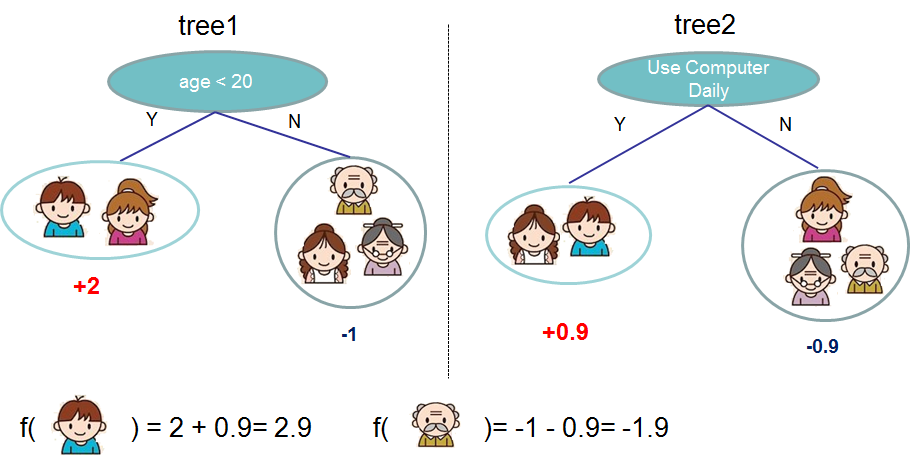

特征重要性是机器学习中衡量特征对模型预测影响程度的重要指标。XGBoost作为一种强大的机器学习算法,提供了多种计算特征重要性的方法。

XGBoost的特征重要性计算基于其决策树模型。在训练过程中,每个特征在每个决策树中被选为分割节点的次数会被记录下来。特征被选为分割节点的次数越多,说明它对模型预测的影响越大。

# 2. 分布式计算与 XGBoost

### 2.1 分布式计算的概念与优势

分布式计算是一种将计算任务分解成较小的子任务,并在多台计算机上并行执行的计算范式。与集中式计算相比,分布式计算具有以下优势:

- **可扩展性:**分布式系统可以轻松地通过添加更多节点来扩展,以处理更大规模的数据和计算任务。

- **容错性:**如果一台计算机发生故障,分布式系统可以通过将任务重新分配到其他节点来继续运行,从而提高系统的容错性。

- **并行性:**分布式系统允许同时执行多个任务,从而显著提高计算效率。

### 2.2 XGBoost 在分布式计算中的应用

XGBoost 是一款支持分布式计算的机器学习算法。在分布式环境中,XGBoost 将训练数据分发到多个节点,并并行训练多个决策树。每个节点负责训练一部分决策树,训练完成后,这些决策树会被合并成一个最终的模型。

XGBoost 使用 **Rabit** 通信库进行分布式通信。Rabit 提供了高效的并行计算和容错机制,确保 XGBoost 在分布式环境中稳定可靠地运行。

#### 分布式 XGBoost 的优势

分布式 XGBoost 继承了分布式计算的优势,同时还具有以下特定优势:

- **更快的训练速度:**并行训练决策树可以显著缩短训练时间,尤其是在处理大规模数据集时。

- **更好的模型质量:**分布式 XGBoost 可以利用更多计算资源,从而训练出更复杂、更准确的模型。

- **易于扩展:**分布式 XGBoost 可以轻松地扩展到更大的集群,以处理不断增长的数据和计算需求。

#### 分布式 XGBoost 的代码示例

以下 Python 代码示例演示了如何使用 XGBoost 的分布式训练功能:

```python

import xgboost as xgb

# 创建一个分布式 XGBoost 训练器

dtrain = xgb.DMatrix('train.csv')

params = {'tree_method': 'hist', 'max_depth': 5, 'eta': 0.1}

bst = xgb.train(params, dtrain, num_boost_round=10, nthreads=-1)

```

在这个示例中:

- `dtrain` 是一个包含训练数据的 XGBoost 数据矩阵。

- `params` 是 XGBoost 训练参数。

- `num_boost_round` 指定训练的迭代次数。

- `nthreads=-1` 指定使用所有可用的 CPU 核心进行并行训练。

训练完成后,`bst` 将包含训练好的分布式 XGBoost 模型。

# 3. 大数据场景下的XGBoost

### 3.1 大数据处理的挑战与解决方案

在大数据场景下,XGBoost面临着以下挑战:

- **数据量庞大:**大数据数据集通常包含数十亿甚至数万亿条记录,这使得在单个机器上训练XGBoost模型变得不可行。

- **计算资源受限:**训练大规模XGBoost模型需要大量的计算资源,包括CPU、内存和存储。

- **训练时间长:**训练大规模XGBoost模型可能需要数天甚至数周的时间,这会阻碍模型的快速迭代和部署。

为了应对这些挑战,需要采用以下解决方案:

- **分布式计算:**将XGBoost训练任务分布到多个机器上,并行执行,从而提高计算效率和缩短训练时间。

- **数据采样:**从大数据集中抽取一个具有代表性的子集,用于训练XGBoost模型,从而降低计算资源需求和训练时间。

- **模型压缩:**对训练好的XGBoost模型进行压缩,减少模型大小和内存占用,从而便于部署和使用。

### 3.2 XGBoost在大数据场景下的优化策略

####

0

0