XGBoost特征重要性:权威解读,增强模型的可信度

发布时间: 2024-08-21 05:57:25 阅读量: 67 订阅数: 27

IncompatibleClassChangeError(解决方案).md

# 1. XGBoost简介**

XGBoost(Extreme Gradient Boosting)是一种强大的机器学习算法,用于解决分类和回归问题。它基于梯度提升算法,通过构建一系列决策树来预测目标变量。XGBoost因其高精度、可扩展性和对特征重要性的解释能力而闻名。

XGBoost的特征重要性是衡量每个特征对模型预测的影响程度。它可以帮助我们识别最重要的特征,从而优化模型性能,提高模型的可信度。在接下来的章节中,我们将深入探讨XGBoost特征重要性的理论、计算方法和在模型优化中的应用。

# 2. XGBoost特征重要性理论

XGBoost(Extreme Gradient Boosting)是一种强大的机器学习算法,因其在各种预测任务中的出色表现而闻名。特征重要性是XGBoost的一个关键特性,它可以帮助我们了解哪些特征对模型预测最具影响力。

### 2.1 特征重要性度量

XGBoost使用多种度量来评估特征重要性:

#### 2.1.1 增益

增益衡量特征在决策树中将样本正确分类的程度。增益越大,特征越重要。

#### 2.1.2 覆盖率

覆盖率衡量特征在决策树中出现的频率。覆盖率较高的特征通常比覆盖率较低的特征更重要。

#### 2.1.3 权重

权重衡量特征在决策树中节点分裂的权重。权重较大的特征通常比权重较小的特征更重要。

### 2.2 特征重要性计算方法

XGBoost通过两种方法计算特征重要性:

#### 2.2.1 树模型的特征重要性

对于每个决策树,XGBoost计算每个特征的增益、覆盖率和权重。然后,它将这些度量加权平均,得到该树的特征重要性。

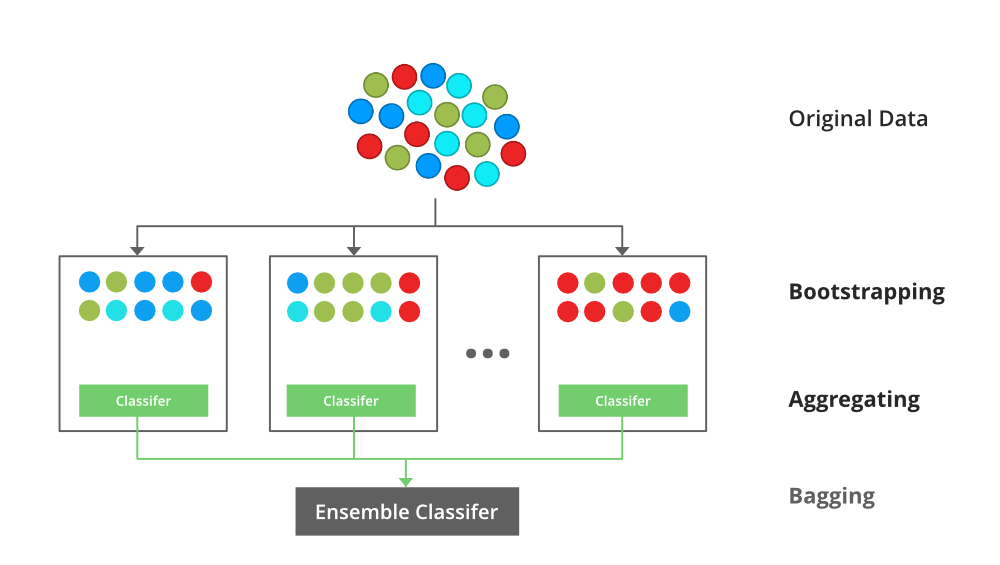

#### 2.2.2 集成模型的特征重要性

对于集成模型(例如随机森林),XGBoost将每个树的特征重要性加权平均,得到集成模型的特征重要性。

**代码块:**

```python

import xgboost as xgb

# 训练XGBoost模型

model = xgb.XGBClassifier()

model.fit(X_train, y_train)

# 计算特征重要性

feature_importance = model.feature_importances_

# 打印特征重要性

print(feature_importance)

```

**逻辑分析:**

这段代码使用XGBoost库训练了一个分类模型。然后,它计算并打印每个特征的特征重要性。特征重要性是一个浮点数数组,其中每个元素表示相应特征的重要性。

**参数说明:**

* `X_train`:训练数据特征矩阵。

* `y_train`:训练数据目标变量向量。

* `feature_importance`:特征重要性数组。

# 3. XGBoost特征重要性实践

### 3.1 特征重要性计算

#### 3.1.1 使用Python代码计算特征重要性

```python

import xgboost as xgb

# 加载数据集

data = xgb.DMatrix("train.csv")

# 训练XGBoost模型

model = xgb.train({"objective": "binary:logistic"}, data, num_boost_round=100)

# 计算特征重要性

importance = model.get_score(importance_type="gain")

# 打印特征重要性

for feature, score in importance.items():

print(f"{feature}: {score}")

```

**代码逻辑逐行解读:**

1. 导入XGBoost库。

2. 加载训练数据集。

0

0