揭秘XGBoost特征重要性:实战案例,提升模型性能

发布时间: 2024-08-21 05:31:15 阅读量: 49 订阅数: 43

# 1. XGBoost简介**

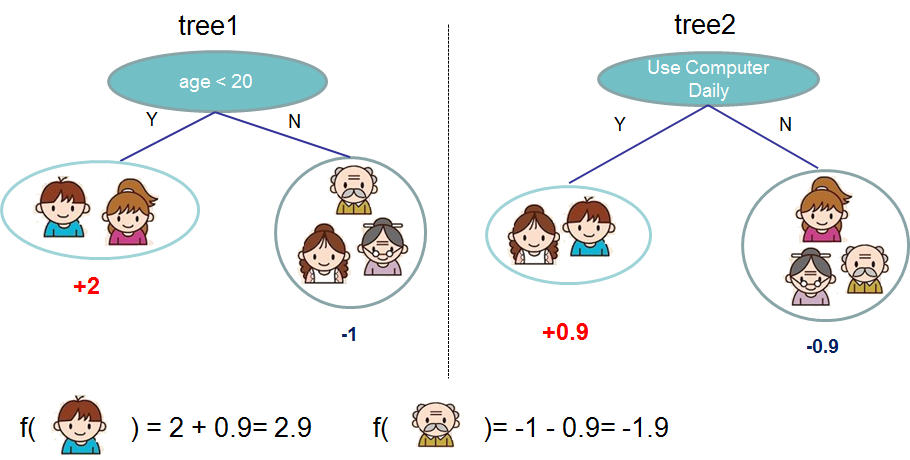

XGBoost(Extreme Gradient Boosting)是一种强大的机器学习算法,用于解决分类和回归问题。它是一种梯度提升算法,通过迭代地构建决策树来学习数据中的模式。XGBoost以其高准确性、可解释性和对大数据集的处理能力而著称。

XGBoost算法的核心思想是使用多个决策树来拟合数据。在每一步迭代中,XGBoost会创建一个新的决策树,以更正前一棵树的预测误差。通过这种方式,XGBoost可以生成一个强大的模型,能够捕捉数据中的复杂关系。

# 2. XGBoost特征重要性

### 2.1 特征重要性的概念和意义

**特征重要性**衡量每个特征对模型预测结果的影响程度。它反映了特征在模型决策过程中的权重,有助于理解模型的行为并提高其可解释性。

### 2.2 XGBoost中特征重要性的计算方法

XGBoost使用**增益**和**覆盖率**两个指标来计算特征重要性。

#### 2.2.1 增益

**增益**衡量一个特征在决策树中分裂数据集时减少的**信息增益**。信息增益越大,特征越重要。

#### 2.2.2 覆盖率

**覆盖率**衡量一个特征在决策树中被用来分裂数据集的次数。覆盖率越高,特征越重要。

XGBoost将增益和覆盖率结合起来,计算每个特征的**加权增益**:

```python

Weighted Gain = Gain * Coverage

```

加权增益较高的特征被认为更重要。

### 2.2.3 代码示例

以下代码展示了如何计算XGBoost中特征重要性:

```python

import xgboost as xgb

# 训练XGBoost模型

model = xgb.XGBClassifier()

model.fit(X, y)

# 获取特征重要性

feature_importance = model.feature_importances_

# 打印特征重要性

print(feature_importance)

```

### 2.2.4 参数说明

* `X`: 训练数据特征矩阵

* `y`: 训练数据目标向量

* `model`: 训练好的XGBoost模型

* `feature_importance`: 特征重要性数组

### 2.2.5 逻辑分析

* 模型在训练过程中,会根据特征值将数据集划分为多个子集。

* 增益衡量每个特征在分裂数据集时减少的信息增益,反映了该特征在决策过程中的影响力。

* 覆盖率衡量每个特征被用于分裂数据集的次数,反映了该特征在模型中被使用的频率。

* 加权增益综合考虑了增益和覆盖率,更全面地衡量了特征的重要性。

# 3. 特征重要性在实践中的应用

### 3.1 识别无用特征和优化模型性能

特征重要性可以帮助我们识别无用特征,从而优化模型性能。无用特征是指对模型预测没有贡献或贡献很小的特征。这些特征的存在不仅会增加模型的复杂度,还会降低模型的泛化能力。

通过计算特征重要性,我们可以识别出无用特征。对于重要性较低的特征,我们可以考虑将其从模型中移除。这将简化模型,提高其可解释性,并可能提高其预测精度。

### 3.2 特征选择和变量工程

特征选择是选择对模型预测最相关的特征的过程。特征重要性可以作为特征选择的一个重要依据。我们可以根据特征重要性对特征进行排序,然后选择重要性最高的特征作为模型的输入。

变量工程是指对原始特征进行转换或组合,以创建更具预测力的特征。特征重要性可以帮助我们确定哪些

0

0