MapReduce大数据处理:优化磁盘I_O,减少Map阶段时间的3大技巧

发布时间: 2024-10-30 17:25:13 阅读量: 44 订阅数: 40

java+sql server项目之科帮网计算机配件报价系统源代码.zip

# 1. MapReduce大数据处理概述

## 1.1 MapReduce框架的起源与发展

MapReduce是一种编程模型,用于处理大规模数据集的并行运算。它由Google提出并广泛应用于Hadoop等大数据处理框架中。自从2004年首次公开介绍以来,MapReduce已经演变成处理海量数据的核心技术之一,并且逐渐成为云计算领域不可或缺的组成部分。

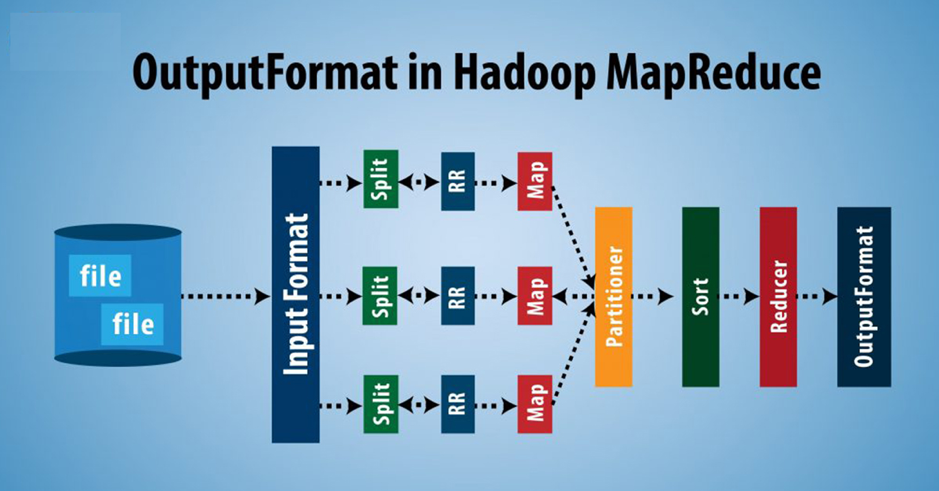

## 1.2 MapReduce的基本工作原理

MapReduce框架主要通过两个阶段完成对数据的处理:Map阶段和Reduce阶段。在Map阶段,框架将输入数据集分割成独立的数据块,并并行执行用户定义的Map函数以处理这些块。之后在Reduce阶段,框架对Map处理结果进行汇总,执行Reduce函数以得到最终结果。这一过程允许MapReduce充分利用分布式计算资源,实现高效的数据处理。

## 1.3 MapReduce在大数据处理中的地位

随着数据量的不断增长,MapReduce成为了处理大数据的关键技术。其可扩展性、容错性和简易性使得它成为了数据分析师和工程师在进行数据挖掘、日志分析和统计分析等任务时的首选。如今,MapReduce的应用已不仅限于传统的Hadoop环境,还扩展到了各种大数据处理场景中。

# 2. MapReduce中的磁盘I/O优化理论

MapReduce框架广泛应用于大规模数据处理领域,其性能在很大程度上依赖于底层存储系统,尤其是磁盘I/O的效率。本章将深入探讨MapReduce中磁盘I/O优化的理论与实践,通过分析磁盘I/O在MapReduce中的作用,理解优化的必要性,并学习如何基于理论基础进行实际的优化工作。

## 2.1 磁盘I/O在MapReduce中的作用

### 2.1.1 磁盘I/O基础知识

磁盘I/O是指计算机系统与磁盘存储设备之间进行的数据读写操作。磁盘I/O性能的高低直接影响到系统的整体性能,尤其是在处理大数据时,磁盘I/O速度往往成为瓶颈。在MapReduce框架中,Hadoop使用HDFS作为其分布式存储系统,HDFS为MapReduce提供了数据存储和读写的基础设施。

### 2.1.2 磁盘I/O对Map阶段的影响

在MapReduce模型中,Map阶段是处理输入数据的关键步骤。Map任务读取HDFS上的数据块进行处理,这些操作都涉及到磁盘I/O。如果Map任务读取数据时磁盘I/O效率低下,将严重影响Map阶段的处理速度,进而影响整个作业的执行效率。

## 2.2 MapReduce的磁盘I/O模型分析

### 2.2.1 HDFS的I/O模型

Hadoop分布式文件系统(HDFS)的设计旨在提供高吞吐量的数据访问,它优化了大块数据的读写操作,适合大数据的批处理作业。HDFS的I/O模型涉及到数据的分块存储、冗余复制和数据本地性等关键特性。

### 2.2.2 MapReduce作业的I/O流程

一个MapReduce作业的I/O流程包括了从HDFS读取输入数据、执行Map任务处理数据,以及写入中间结果到本地磁盘或HDFS。这些步骤中的每一个都与磁盘I/O紧密相关,因此理解和优化这个流程是提升MapReduce性能的关键。

## 2.3 磁盘I/O优化的理论基础

### 2.3.1 减少磁盘I/O瓶颈的策略

减少磁盘I/O瓶颈的策略通常包括数据预处理、数据压缩、优化存储格式和使用更快的存储介质等。合理规划数据的存储结构和访问模式,可以显著提升数据读写的效率。

### 2.3.2 优化磁盘I/O的理论框架

优化磁盘I/O的理论框架应该基于对数据访问模式的深入分析。这包括理解数据的读写频率、数据大小、访问模式和作业调度等因素,从而在不同级别实施针对性的优化策略。

```mermaid

graph LR

A[开始优化流程] --> B[数据访问模式分析]

B --> C[确定优化策略]

C --> D[磁盘I/O性能测试]

D --> E[优化参数配置]

E --> F[效果评估与调整]

F --> G[结束优化流程]

```

通过一个理论框架的循环迭代,可以不断地调整优化策略,直到达到预期的性能提升目标。

```mermaid

graph TD

A[磁盘I/O理论框架]

A -->|1.分析| B[数据访问模式分析]

A -->|2.规划| C[优化策略确定]

A -->|3.测试| D[磁盘I/O性能测试]

A -->|4.调优| E[优化参数配置]

A -->|5.评估| F[效果评估与调整]

```

以上流程图展示了优化磁盘I/O的一般步骤,从分析数据访问模式到配置优化参数,再到评估调整,最终达到性能优化的目的。在实际操作中,这些步骤可能需要多次迭代以达到最佳效果。

在探讨了磁盘I/O在MapReduce中的作用、HDFS的I/O模型以及优化理论框架之后,接下来的章节将继续深入探讨Map阶段时间的实践技巧和综合案例分析,以及总结与未来展望。这将帮助读者更深入地理解并掌握如何在实际应用中进行磁盘I/O的优化工作。

# 3. 减少Map阶段时间的实践技巧

## 3.1 输入数据的优化处理

MapReduce的Map阶段是整个处理流程的入口点,因此优化Map阶段可以显著提升作业的执行效率。在Map阶段,输入数据的优化处理是重要的第一步,其中包括数据压缩技术和数据本地化策略的实施。

### 3.1.1 数据压缩技术的应用

数据压缩技术在大数据处理中非常关键,它可以大幅度减少磁盘I/O的负载,从而加快数据读取速度。Hadoop生态系统支持多种数据压缩格式,如Gzip、Bzip2、Snappy和LZO等。每种压缩格式都有其适用场景和特点。

Gzip和Bzip2提供较高的压缩比,但解压缩速度较慢。Snappy和LZO则是以牺牲部分压缩比来达到快速压缩和解压缩的目的,它们特别适用于需要快速读取数据的场景。为了进一步提升性能,用户可以在Hadoop的配置文件`

0

0