深入MapReduce:专家带你快速诊断并加速数据Shuffle阶段

发布时间: 2024-10-30 16:58:09 阅读量: 2 订阅数: 4

# 1. MapReduce基础和Shuffle阶段概述

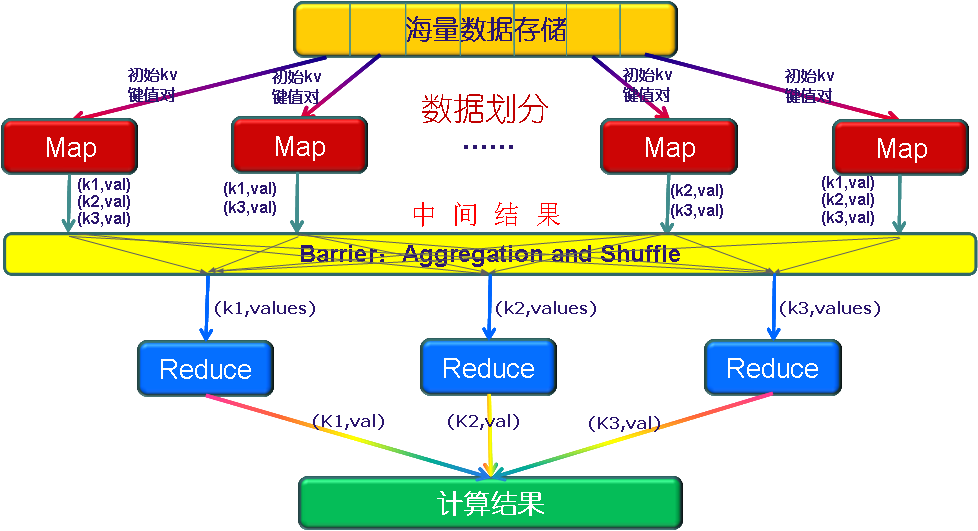

MapReduce是Hadoop生态系统中的核心处理框架,它通过Map和Reduce两个主要操作来处理大规模数据集。MapReduce程序在运行时,其Shuffle阶段是整个数据处理流程中的关键环节,负责将Map端处理好的数据分发到Reduce端进行汇总处理。理解Shuffle阶段的工作机制对于优化MapReduce程序性能至关重要。

Shuffle阶段是MapReduce从数据准备到计算输出的桥梁,其作用不仅限于数据的传递,还包括数据排序和分组,为Reduce任务提供了有序的键值对集合。这个过程涉及到大量数据在网络上的传输和磁盘I/O操作,因此,Shuffle阶段的效率直接影响着整个作业的执行时间。

在后续章节中,我们将深入分析Shuffle机制的理论模型、探讨性能瓶颈和优化策略,并最终通过实践案例来展示如何在实际应用中进行Shuffle优化。这一章节为MapReduce的高级主题打下基础,为读者逐步揭示Shuffle阶段的复杂性和优化的必要性。

# 2. MapReduce Shuffle机制理论分析

## 2.1 Shuffle阶段的作用和流程

### 2.1.1 Shuffle的定义和重要性

Shuffle是MapReduce计算框架中最重要的阶段之一,它负责在Map任务和Reduce任务之间传输数据。Shuffle的字面意思为“洗牌”,在MapReduce中指将Map任务的输出结果按照Reduce任务的分区进行重新排列和传输的过程。

Shuffle的定义包括以下两个核心动作:

1. **分区(Partitioning)**: 数据根据某种规则被分配到不同的Reducer上。

2. **排序(Sorting)**: 将数据按键进行排序,通常是按照键值对的Key进行排序,以便于后续的聚合操作。

Shuffle的重要性体现在以下几个方面:

- **数据重组**: 它是Map和Reduce两个阶段的桥梁,没有Shuffle,Map阶段产生的中间结果无法正确地传递给Reduce阶段。

- **资源利用**: 正确的Shuffle处理可以提升集群资源的利用率,有效平衡各个节点间的负载。

- **性能影响**: Shuffle阶段的性能瓶颈会对整个MapReduce作业的执行时间产生巨大影响。

### 2.1.2 Shuffle流程的各个阶段解析

Shuffle流程大致可以分为以下阶段:

1. **Map端输出(Map Output)**:

- 在Map任务执行过程中,原始数据被处理并输出中间键值对。

- 数据首先被写入内存,并定期刷新到磁盘上,形成小的输出文件。

2. **Map端Spill(Spill)**:

- 当内存达到一定阈值后,Map任务开始将内存中的数据溢写(Spill)到磁盘,形成Spill文件。

- 在Spill过程中,数据会经过一个简单的排序,以保证同一个分区内的数据是有序的。

3. **Map端合并(Merge)**:

- Spill文件写入磁盘后,Map任务可能会执行合并操作,将多个Spill文件合并成一个有序的输出文件。

4. **Shuffle传输(Shuffle Transfer)**:

- Shuffle传输是指Map任务完成后,由Reduce任务主动从Map任务的机器上拉取(Fetch)中间数据。

- 这个过程中,网络I/O的效率是影响性能的关键因素。

5. **Reduce端排序(Reduce Sort)**:

- Reduce任务在接收到Map任务的输出数据后,需要将相同Key的数据聚集到一起。

- 这通常意味着对数据进行排序,以便进行后续的合并和聚合操作。

6. **Reduce端处理(Reduce Processing)**:

- 完成数据排序后,Reduce任务开始执行实际的数据处理逻辑。

- 在此阶段,可以进行最终的数据聚合和输出。

## 2.2 Shuffle阶段的理论模型

### 2.2.1 理论模型的构建

构建Shuffle的理论模型需要对Shuffle过程中的关键组件和操作进行抽象。这些组件包括但不限于网络传输、磁盘I/O、内存管理以及数据处理算法。理论模型应该能够帮助我们理解在不同负载和配置下,Shuffle的性能行为。

在构建模型时,通常会考虑以下几个方面:

- **资源限制**: 包括内存容量、磁盘空间、CPU速度和网络带宽等因素。

- **任务特性**: Map和Reduce任务执行时间和数据量的估计。

- **数据分布**: 数据在各个节点和分区中的分布情况。

### 2.2.2 关键组件和参数的影响

Shuffle的性能受到很多参数的影响,了解这些参数及其作用对于优化Shuffle至关重要。下面列举了一些关键参数及其影响:

- **Map端缓冲区大小** (`mapreduce.job.maps.memory.buffer.spillpercentage`):

- 控制着Map任务的内存缓冲区大小,影响Spill操作的触发时机。

- **Shuffle传输线程数** (`mapreduce.reduce.shuffle.parallelcopies`):

- 决定着Reduce任务拉取数据时使用的线程数,影响网络I/O的效率。

- **排序合并策略**:

- 影响数据在Map端和Reduce端的排序效率,以及中间文件的数量和大小。

## 2.3 Shuffle优化的理论依据

### 2.3.1 性能瓶颈的识别

优化Shuffle的首要步骤是识别性能瓶颈。瓶颈通常出现在以下几个地方:

- **磁盘I/O**: 如果Spill操作过于频繁,可能表明磁盘I/O成为了瓶颈。

- **网络传输**: 大量数据在Map和Reduce任务之间传输时,网络带宽可能会成为瓶颈。

- **内存管理**: 如果Map任务频繁进行垃圾回收,内存可能成为瓶颈。

### 2.3.2 优化目标和策略的理论基础

Shuffle优化的核心目标是减少资源的消耗,缩短数据传输的时间,以及提升数据处理的效率。基于这些目标,可以采取以下优化策略:

- **减少数据量**: 通过压缩数据、调整数据格式或筛选无用数据来减少数据的大小。

- **网络优化**: 采用更有效的网络协议或优化数据传输过程,减少网络的使用。

- **I/O优化**: 例如提升磁盘读写速度、优化数据写入模式等。

- **资源合理分配**: 调整Map和Reduce任务的数量和资源配额,使得资源得到合理利用。

以上便是第二章:MapReduce Shuffle机制理论分析的详细内容。接下来我们进入第三章,深入了解MapReduce Shuffle优化实践。

# 3. MapReduce Shuffle优化实践

## 3.1 Shuffle阶段常见的性能问题诊断

在MapReduce的执行过程中,Shuffle阶段是性能的关键瓶颈所在。对于经验丰富的IT行业从业者来说,理解并解决这些问题能够显著提高整体任务的执行效率。

### 3.1.1 网络和磁盘IO的瓶颈诊断

网络和磁盘I/O是Shuffle性能的重要影响因素。具体诊断步骤如下:

1. **监控网络带宽使用情况**:通过监控工具如`iftop`或`nethogs`,可以观察到在Shuffle过程中网络带宽的使用情况。如果发现带宽使用率接近网络卡的上限,则表明网络可能是一个瓶颈。

2. **检查磁盘I/O性能**:通过`iostat`命令可以监控到磁盘的读写性能。如果发现IOPS(每秒读写操作次数)接近硬件的最大值,或者磁盘响应时间(await)过长,就可能表明磁盘I/O已经成为Shuffle性能的瓶颈。

3. **使用操作系统级别的工具**:操作系统提供了多种工具,如`perf`(性能分析工具),可以用来分析CPU、磁盘等资源的使用情况,辅助判断瓶颈。

### 3.1.2 JVM和内存管理的性能问题识别

JVM的性能参数和内存管理的不当也会导致Shuffle阶段性能下降。

1. **垃圾回收(GC)分析**:不合理的JVM参数设置会导致频繁的垃圾回收,影响任务执行效率。使用`jstat`工具可以监控垃圾回收事件和内存使用情况。

2. **内存溢出问题**:如果MapReduce作业频繁遇到内存溢出异常,则需要增加JVM的堆内存设置。可以通过`-Xmx`和`-Xms`参数来调整最大和初始堆内存大小。

3. **分析内存泄漏**:如果JVM长时间运行后出现性能下降,可能是内存泄漏导致的。此时可以使用`jmap`来生成内存堆转储文件,然后用`MAT`(Memory Analyzer Tool)等工具进行分析。

## 3.2 Shuffle阶段的参数调优实践

对Shuffle阶段的参数进行调整是优化性能的常见手段。

### 3.2.1 调优参数的详细解读

以下是一些重要的参数调整建议:

- `mapreduce.job.maps`:设置Map任务的数量。

- `mapreduce.job.reduces`:设置Reduce任务的数量。

- `mapreduce.input.fileinputformat.split.maxsize`:设置Map任务处理的输入数据块的最大大小。

- `mapreduce.job.shuffle.input.buffer.percent`:定义为Shuffle缓冲区占用堆内存的百分比。

### 3.2.2 实际案例中的参数调整技巧

在实际的生产环境中,参数调整需要根据具体情况进行。以下是一个参数调整的示例流程:

1. **初始参数设置**:根据硬件资源和数据规模,给出一组基础参数。

2. **监控与分析**:在调整参数之前,必须有一个良好的监控机制,记录任务执行前后的性能数据。

3. **小范围测试**:每次调整参数,只对部分节点进行测试,以免影响整个集群的稳定性。

4. **性能评估**:通过测试结果,评估参数调整带来的性能变化,并决定是否保留该调整。

5. **全面应用**:如果测试结果良好,再将参数调整应用到整个集群。

## 3.3 Shuffle阶段的代码优化策略

除了参数调优,通过代码级别的优化也可以实现Shuffle的性能提升。

### 3.3.1 编写高效的数据序列化/反序列化代码

在MapReduce中,数据的序列化和反序列化是重要的性能考量点。

1. **选择合适的序列化框架**:应选择占用带宽和内存较少的序列化框架。如使用`Kryo`序列化框架代替默认的`Java`序列化。

2. **自定义序列化类**:对于频繁使用的数据类型,可以编写自定义序列化类,以减少序列化和反序列化的开销。

### 3.3.2 优化Map和Reduce任务的数据处理逻辑

优化数据处理逻辑可以有效提升Shuffle的性能:

- **减少Map输出数据量**:在Map阶段,可以通过合理设计键值对的生成逻辑,尽量减少输出数据量,这将直接影响Shuffle的网络传输量和磁盘IO。

- **合并小文件**:对于大量小文件的输入,可以通过合并小文件的方式来减少Map任务的启动次数,提升Shuffle效率。

- **排序和分区策略**:合理设计Map输出的排序和分区策略,可以减少Reduce阶段的处理压力,同时提高数据合并和排序的效率。

通过上述章节的介绍,我们可以看到,MapReduce Shuffle优化实践不仅是理论上的讨论,更是实际操作中的技术要点。针对常见的性能问题进行诊断,通过调优参数和优化代码,可以有效提升Shuffle阶段的性能,从而提高整个MapReduce作业的执行效率。这不仅对于IT行业从业者,尤其是大数据平台开发和运维人员来说,是非常重要的技能。

# 4. MapReduce Shuffle加速技术深入探索

MapReduce Shuffle阶段是整个处理流程中的关键部分,它负责将Map任务的输出进行排序,并将数据传输给Reduce任务。加速Shuffle阶段可以显著提升大数据处理的效率。本章节深入探讨了Shuffle加速技术,包括自定义Partitioner和Comparator、外部排序及内存管理优化,以及数据压缩和编码技术的应用。

## 4.1 自定义Partitioner和Comparator的作用

### 4.1.1 分区策略的调整

MapReduce框架默认使用哈希分区策略,但有时候默认策略并不适合所有的应用场景。自定义Partitioner能够更好地控制数据的分配,提高Shuffle效率。例如,如果有一个维度是时间戳,我们可以根据时间戳进行分区,这样所有相同时间戳的数据就会被发送到同一个Reduce任务中进行处理。

```java

public class TimeBasedPartitioner extends Partitioner<Text, IntWritable> {

@Override

public int getPartition(Text key, IntWritable value, int numPartitions) {

// 提取时间戳信息

long timestamp = Long.parseLong(key.toString().split(" ")[0]);

// 计算分区

return (int)(timestamp % numPartitions);

}

}

```

在这段代码中,我们自定义了一个Partitioner,根据时间戳信息将数据分区。这种策略在需要按时间序列分析数据时非常有用。

### 4.1.2 自定义排序逻辑的优势和实现方法

默认情况下,MapReduce使用自然排序,也就是字典序排序。某些特定场景下,我们需要根据业务逻辑定义排序顺序。自定义Comparator允许我们实现更复杂的排序逻辑,比如按照多个字段排序或者特定的业务规则排序。

```java

public class CustomComparator extends WritableComparator {

protected CustomComparator() {

super(Text.class, true);

}

@Override

public int compare(byte[] b1, int s1, int l1, byte[] b2, int s2, int l2) {

try {

// 反序列化对象

Text t1 = new Text(b1, s1, l1);

Text t2 = new Text(b2, s2, l2);

// 按照特定规则比较两个对象

return t1.toString().compareTo(t2.toString());

} catch (IOException e) {

throw new IllegalArgumentException(e);

}

}

}

```

这段代码自定义了一个Comparator,允许我们按照特定的业务规则对数据进行排序。通过这种方式,我们可以优化数据的处理,使得后续分析更加高效。

## 4.2 外部排序和内存管理优化

### 4.2.1 外部排序机制的理解与应用

MapReduce在Shuffle阶段使用了外部排序机制,这是因为内存不能容纳所有数据。理解外部排序对于优化Shuffle性能至关重要。当Map任务的输出数据超过了内存限制时,MapReduce会将数据写入到磁盘,并使用外部排序算法进行排序,以便高效地传输给Reduce任务。

优化外部排序通常涉及调整缓冲区大小和对临时文件进行合并优化。例如,增加缓冲区大小可以减少磁盘I/O次数,从而提升性能。

### 4.2.2 内存管理优化的技术细节

在MapReduce中,合理配置内存参数是至关重要的。例如,增加Map和Reduce任务可用的内存可以提升处理速度,但这需要考虑到集群的总体资源使用情况。通过`mapreduce.job.memory.levels`、`mapreduce.job.memory.mb`等参数,我们可以精细调整内存使用,避免内存溢出或者浪费。

```shell

hadoop jar my-mapreduce.jar -Dmapreduce.job.memory.levels=2 -Dmapreduce.job.memory.mb=1500 myjob

```

以上命令示例中,我们为MapReduce作业设置了两个内存等级,总共分配了1500MB的内存。通过这样的调整,可以确保内存使用更加高效,从而加速Shuffle过程。

## 4.3 数据压缩和编码的Shuffle加速

### 4.3.1 数据压缩技术的选择和实施

数据压缩是降低网络传输和磁盘存储开销的有效方法。选择合适的数据压缩技术能够显著减少Shuffle过程中的数据量。常见的压缩算法包括Snappy、LZ4和Gzip等。在选择压缩算法时,需要权衡压缩效率和解压缩速度。

```***

***press=***press.type=BLOCK myjob

```

此命令行示例启用了FileOutputFormat的压缩功能,类型为BLOCK。通过设置这些参数,MapReduce作业在输出结果时会自动应用压缩,从而加快Shuffle速度。

### 4.3.2 编码优化对Shuffle性能的影响

除了数据压缩,编码优化也是提升Shuffle性能的有效手段。合理的编码策略能够减少数据的体积,降低网络I/O开销。例如,使用高效的序列化框架如Kryo可以提升序列化速度,减少内存占用。

```java

Configuration conf = new Configuration();

conf.set("mapreduce.job.output.key.class", "org.apache.hadoop.io.IntWritable");

conf.set("mapreduce.job.output.value.class", "org.apache.hadoop.io.Text");

conf.set("io.serializations", "org.apache.hadoop.io.serializer.KryoSerialization");

```

通过代码示例,我们设置了Kryo序列化框架作为作业的序列化方法。Kryo序列化通常比默认的Java序列化更高效,可以提升整个作业的性能。

通过本章的深入探索,我们可以看到MapReduce Shuffle加速技术涵盖广泛,从自定义Partitioner和Comparator、到外部排序和内存管理优化,再到数据压缩和编码技术的应用。掌握这些技术,并根据实际需求合理运用,能够显著提高数据处理的效率和性能。下一章节,我们将深入分析MapReduce Shuffle阶段优化的实际应用案例,通过真实案例来进一步了解这些理论和技术的应用。

# 5. MapReduce Shuffle进阶应用案例分析

## 5.1 大数据平台的Shuffle优化案例

Shuffle优化在大数据平台的应用至关重要,优化后的效果能够显著提升整体计算性能和效率。本节将通过具体的企业级案例分析,分享他们的成功经验以及在优化过程中遇到的挑战和解决方案。

### 5.1.1 企业级优化策略分析

企业级的Shuffle优化策略往往围绕着资源的合理配置、参数调优和代码级别的性能改进。例如,某知名电商公司通过监控和分析发现,其在使用MapReduce处理订单数据时,Shuffle阶段的磁盘IO成为了性能瓶颈。他们采取了以下优化措施:

- **资源合理分配**:通过YARN资源管理器动态调整各个任务的资源分配,确保关键任务可以获得更多的CPU和内存资源。

- **参数调优**:针对MapReduce的`mapreduce.job.maps`、`mapreduce.job.reduces`、`mapreduce.task.io.sort.factor`等关键参数进行了调整,减少了不必要的磁盘IO操作。

- **代码级别的优化**:改进数据序列化/反序列化的方式,使用更高效的压缩算法,减少了网络传输的数据量。

### 5.1.2 成功案例分享与经验总结

通过对上述电商公司的优化措施实施后,Shuffle阶段的性能提升了30%以上。公司内部的数据处理速度提高了,能更快速地响应业务需求。

从该案例中我们可以总结出以下几点经验:

- **监控是优化的基础**:通过实时监控工具,如Ganglia、Prometheus等,可以准确了解系统瓶颈所在。

- **持续优化**:优化是一个持续的过程,需要结合实时监控数据不断调整优化策略。

- **团队协作**:优化工作涉及多个部门和技术栈,需要跨团队合作,共享优化成果。

## 5.2 Shuffle阶段监控和问题处理

为了保证大数据处理的高效性,对Shuffle阶段进行有效监控和问题处理是必不可少的。本节将探讨如何实现Shuffle阶段的实时监控以及遇到问题时的应对策略。

### 5.2.1 实时监控Shuffle性能的工具和方法

为了监控Shuffle性能,运维人员和开发人员通常会使用以下工具和方法:

- **Web UI**:Hadoop自带的Web UI界面,可以查看各个阶段的任务执行时间和资源使用情况。

- **日志分析**:通过分析MapReduce任务的日志文件,可以发现具体的性能瓶颈和异常。

- **第三方监控工具**:如Datadog、New Relic等,提供了更加丰富和直观的监控指标。

### 5.2.2 应对Shuffle阶段问题的处理流程

当监控工具反映出Shuffle阶段出现问题时,问题处理流程大致包括以下几个步骤:

1. **问题确认**:确认是Shuffle阶段的问题,并且排除其他因素的影响。

2. **定位瓶颈**:通过监控数据和日志分析,定位问题发生的环节,如是Map端还是Reduce端,以及具体是哪个子环节。

3. **问题分析**:深入分析导致问题的原因,如资源分配、网络延迟、硬件故障等。

4. **优化或修复**:根据问题分析的结果,采取优化配置参数或修复相关代码的方式解决问题。

5. **结果验证**:完成优化或修复后,通过监控工具验证问题是否得到解决。

## 5.3 未来趋势和Shuffle技术的发展方向

随着大数据和云计算技术的发展,Shuffle技术也在不断地演进。本节将探讨Shuffle技术未来的发展方向,以及新兴技术如何影响Shuffle阶段。

### 5.3.1 新兴技术对Shuffle阶段的影响

当前,以下几个技术趋势对Shuffle阶段产生了显著的影响:

- **分布式计算框架的创新**:如Apache Flink、Apache Spark等,这些新一代的计算框架对数据处理流程进行了优化,降低了Shuffle阶段的负载。

- **硬件加速技术**:如使用SSD替换HDD、GPU加速等,这些硬件级别的改进也能够显著提升Shuffle阶段的处理效率。

- **云计算资源的弹性使用**:云计算服务提供的资源弹性调整能力,可以根据数据处理的需求动态地增加或减少计算资源。

### 5.3.2 面向未来的Shuffle优化思路和展望

针对未来可能出现的技术趋势,Shuffle优化的思路可以从以下几个方面入手:

- **资源动态分配**:结合云计算的优势,进一步优化资源动态分配算法,实现更精细的资源管理和调度。

- **深度性能分析**:利用机器学习等先进技术对Shuffle过程中的性能数据进行深度学习,自动发现潜在问题并提出优化建议。

- **数据处理优化**:在保证数据处理准确性的基础上,对数据处理流程进行深度优化,比如在数据预处理、缓存策略等方面进行创新。

以上就是关于Shuffle进阶应用案例分析的详细内容,本章通过分享实际案例、监控和问题处理方法,以及对未来发展展望的讨论,希望能为读者在MapReduce Shuffle优化的道路上提供一些帮助和启发。

0

0