MapReduce任务合并策略:减少Map任务数量,提升效率的5大方法

发布时间: 2024-10-30 17:56:56 阅读量: 1 订阅数: 4

# 1. MapReduce任务合并策略概述

MapReduce作为一个广泛应用于大数据处理的编程模型,其任务合并策略在提高处理效率、节约资源消耗方面起着至关重要的作用。本章将为大家提供一个关于MapReduce任务合并策略的概述,为后续深入分析奠定基础。

在MapReduce模型中,任务合并(Task Combining)是优化Map和Reduce阶段的一种关键技术。合理的任务合并可以大幅度减少Map和Reduce任务的数量,降低作业的调度开销,提高数据处理的效率。它通过将多个小任务合并为一个或少数几个大任务来执行,减少了任务初始化和上下文切换的开销,从而优化整体处理性能。

在接下来的章节中,我们将从理论基础出发,深入探讨MapReduce的工作原理及其任务合并的必要性,以及如何通过各种策略实现有效的任务合并。理解这些策略对于设计和优化大数据处理流程至关重要。

# 2. 理论基础与任务合并的必要性

### 2.1 MapReduce工作原理简述

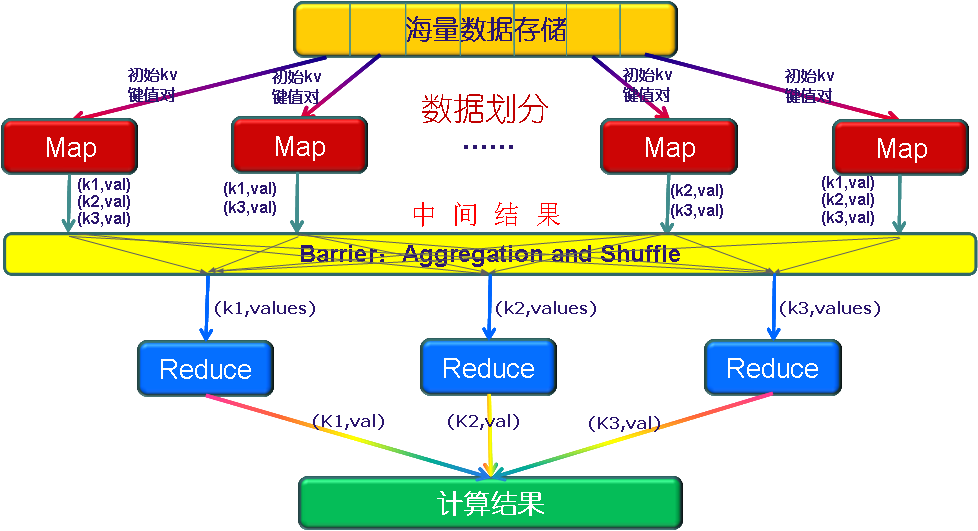

在本小节中,我们将探讨MapReduce模型的基本工作原理,从而深入理解Map和Reduce两个阶段的具体工作流程。

#### 2.1.1 Map阶段的工作流程

Map阶段是MapReduce计算框架的初步处理阶段,用于数据的解析和初步处理。以下是Map阶段的关键步骤:

1. **数据读取与解析**:Map任务首先从数据源读取输入数据,通常是存储在分布式文件系统(如HDFS)上的大文件。数据源被自动分割成若干个分片(split),Map任务对每个分片进行处理。

2. **键值对生成**:在读取数据后,Map函数被调用,将输入数据转换成中间键值对(key-value pairs)。这些键值对是Map任务的输出,供后续的Reduce任务使用。

3. **排序与合并**:Map任务输出的中间键值对,会根据键进行部分排序和合并。这一步骤旨在减少网络传输的数据量,并为下一阶段的分组操作做准备。

```python

# Python伪代码示例:Map阶段处理流程

def map(input_data):

for record in input_data:

key, value = process(record) # 处理每条记录,生成键值对

emit(key, value) # 输出键值对

```

#### 2.1.2 Reduce阶段的工作流程

Reduce阶段处理Map阶段输出的键值对,并进行最终的数据汇总和输出。这个阶段通常涉及以下步骤:

1. **分组操作**:Reduce任务首先根据键(key)对来自所有Map任务的中间数据进行分组。这确保了相同键的数据项会被传递到同一个Reduce任务中。

2. **数据聚合**:对每个键分组的数据,调用Reduce函数进行聚合处理。用户定义的Reduce函数会对分组内的所有值执行合并操作,以生成最终结果。

3. **结果输出**:聚合后的结果最终被写回到输出文件系统中,完成整个MapReduce任务。

```python

# Python伪代码示例:Reduce阶段处理流程

def reduce(key, values):

result = process(values) # 聚合处理相同键的值

emit(key, result) # 输出聚合结果

```

### 2.2 任务合并对性能的影响

任务合并是优化MapReduce性能的一个关键策略。下面将分别从性能优势和资源消耗优化两个角度探讨任务合并的必要性。

#### 2.2.1 理解任务合并的性能优势

任务合并涉及将多个小任务打包成更大的任务执行,这样做能够带来以下性能上的优势:

1. **减少任务调度开销**:在分布式系统中,任务调度是耗时且资源消耗大的过程。通过合并任务,可以减少任务数量,从而降低调度开销。

2. **优化数据本地性**:合并后的任务处理的数据量更大,这使得任务更有可能在数据存储的同一节点上执行,减少了数据在网络中的传输,提升了数据访问效率。

3. **提高资源利用率**:合并任务可以更好地利用集群的计算资源,避免因小任务数量过多导致的资源碎片化问题。

#### 2.2.2 任务合并对资源消耗的优化

任务合并不仅提高了性能,还能在资源利用方面起到优化作用:

1. **减少中间状态存储**:合并任务减少了Map和Reduce阶段之间的中间结果存储需求,从而减少了对存储资源的占用。

2. **降低网络压力**:任务合并减少了需要处理的数据分片数量,网络传输的数据量也随之减少,减轻了网络的压力。

3. **节约资源管理开销**:在资源有限的集群中,资源管理和调度的开销可能成为性能瓶颈。任务合并能够有效降低这一开销。

```mermaid

graph LR

A[任务调度开销] -->|减少| B[资源管理开销]

C[数据本地性] -->|提升| D[数据传输减少]

E[中间状态存储] -->|减少| F[存储资源占用]

G[网络压力] -->|减轻| H[网络带宽优化]

```

通过本小节的介绍,我们不仅深入了解了MapReduce的基本工作原理,还探讨了任务合并带来的性能和资源消耗上的优势。这为下一章节中,我们将具体分析如何通过减少Map任务数量来进一步优化MapReduce任务提供了理论基础。

# 3. 减少Map任务数量的策略

## 3.1 数据本地化优化

### 3.1.1 输入数据分割策略

在MapReduce框架中,输入数据通常是按照HDFS块进行分割的,每个块被一个Map任务处理。通过精心设计数据分割策略,可以减少Map任务的数量,进而影响整个作业的性能。数据分割策略不仅与数据量大小相关,还与数据在集群中的分布有关。

为了最大化数据本地化,首先需要了解数据是如何存储在HDFS中的。HDFS将文件分割为固定大小的块,默认大小为128MB。每个块的副本被存储在不同的数据节点上,副本的多少可以在Hadoop配置中指定。优化数据分割策略要考虑数据的物理存储位置,以减少网络传输。

下面是一个简单的逻辑分析和代码块示例,说明如何自定义输入分片器以实现数据本地化优化:

```java

public class CustomInputSplit extends FileInputFormat<LongWritable, Text> {

@Override

protected boolean isSplitable(JobContext context, Path file) {

// 通过禁用分片,确保每个Map任务处理一个完整的输入文件

return false;

}

@Override

public RecordReader<LongWritable, Text> createRecordReader(InputSplit split, TaskAttemptContext context) {

// 定义如何读取文件中的数据

return new LineRecordReader();

}

}

```

逻辑分析:

- `isSplitable`方法被重写以禁止自动分片,这样Hadoop框架不会将输入文件分割成多个片段。相反,每个Map任务处理一个文件,这有助于数据本地化,因为通常整个文件都会存储在一个数据节点上。

- `createRecordReader`方法定义了如何将文件内容转换为键值对,以便Map任务可以处理它们。

### 3.1.2 数据本地化与Map任务的关联

数据本地化指的是将计算任务尽可能地靠近数据存储的位置执行,以减少数据传输开销。MapReduce框架默认会尽量调度Map任务在存储有输入数据的节点上执行,但在数据分布式存储系统中,数据可能分布在多个节点上,这就需要更精细的控制。

为了加强数据本地化效果,可以利用Hadoop的`Data locality`属性。Hadoop允许配置数据本地化级别,如优先选择机架本地或节点本地的数据。机架本地是指数据副本所在的服务器在同一个机架上,而节点本地是指数据副本所在的服务器在同一个节点上。通过配置`mapreduce.job.

0

0