MapReduce性能瓶颈揭秘:9个阶段耗时分析与终极优化策略

发布时间: 2024-10-30 16:55:25 阅读量: 4 订阅数: 7

# 1. MapReduce技术概述

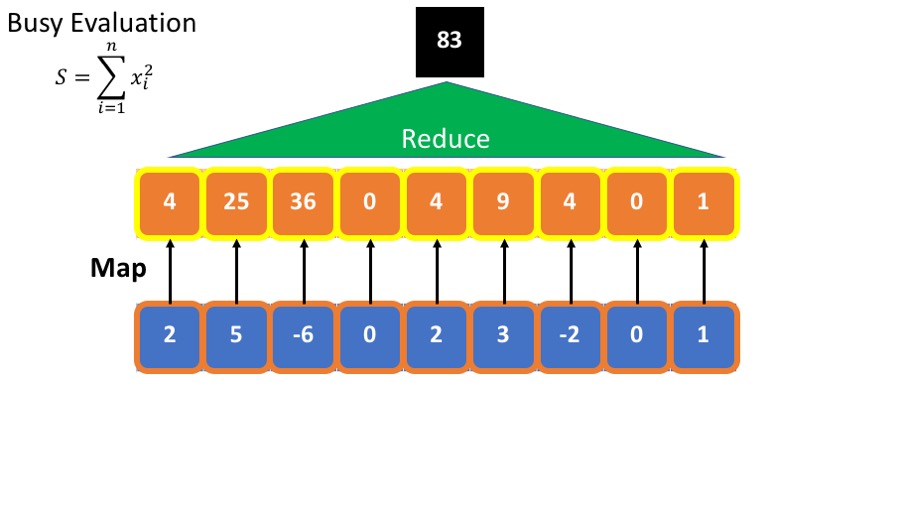

MapReduce是一种编程模型,最初由Google提出,用于大规模数据集(大数据)的并行运算。在分布式环境中,MapReduce将复杂、庞大的任务分解成多个小任务,这些小任务可以并行处理,然后再将结果合并。它的核心在于Map(映射)和Reduce(归约)两个过程。

## Map阶段

在Map阶段,输入数据被分割为独立的块,每个块由一个Map任务处理。Map函数处理输入的数据块,并输出键值对。

```java

// 示例代码:简单的Map函数

map(String key, String value):

// key: document name

// value: document contents

for each word w in value:

EmitIntermediate(w, "1");

```

## Reduce阶段

Reduce阶段会对具有相同键的所有值进行处理,整合为一个结果输出。

```java

// 示例代码:简单的Reduce函数

reduce(String key, Iterator values):

// key: a word

// values: a list of counts

int result = 0;

for each v in values:

result += ParseInt(v);

Emit(key, IntToString(result));

```

MapReduce模型的优势在于其高度可扩展性和容错性,这使得它非常适合处理TB级别的大数据。然而,随着数据量的增加,性能成为关键考量因素。接下来的章节将探讨如何分析和优化MapReduce作业性能。

# 2. MapReduce性能分析基础

## 2.1 MapReduce作业的9个阶段

### 2.1.1 输入分片与读取阶段

在MapReduce作业的生命周期中,输入分片与读取阶段是第一个关键步骤。Hadoop的输入分片机制会将输入数据分割成若干个分片,这些分片由不同的Map任务并发处理。理解这个过程对于性能优化至关重要,因为分片的大小直接影响Map阶段的并行度以及网络I/O的使用情况。

在`InputFormat`类的`getSplits()`方法中定义了如何对输入数据进行分片。该方法会根据输入数据的大小和配置中的`mapreduce.input.fileinputformat.split.maxsize`参数来决定分片的大小。如果分片太大,可能会导致Map任务处理时间过长,反之则会增加Map任务的数量,可能导致资源浪费和过多的管理开销。

```java

Configuration conf = new Configuration();

Job job = Job.getInstance(conf, "MapReduce Example");

// 设置分片大小为128MB

job.setInputFormatClass(TextInputFormat.class);

TextInputFormat.addInputPath(job, new Path(inputPath));

TextInputFormat.setMinSplitSize(job, 128 * 1024 * 1024);

```

在上述代码中,我们通过`TextInputFormat`类设置了每个分片的最小大小为128MB。这个参数的调整对于优化Map阶段的性能至关重要。若数据集较小,较小的分片意味着更多的Map任务可以并行执行,增加作业的并发度。但在数据集较大的情况下,设置较大的分片大小可以减少Map任务的数量,避免过多的启动开销和资源竞争,从而提升整体作业性能。

### 2.1.2 Map阶段

Map阶段是MapReduce作业的核心部分,其目的是将输入的分片数据转换为一系列键值对(key-value pairs)。Map函数会处理每条记录,并生成中间键值对集合,这些中间数据随后将被Shuffle和Sort阶段处理。

为了优化Map阶段的性能,开发者需要关注以下几个方面:

1. **Map函数的效率**:Map函数应尽可能高效,避免复杂或冗长的计算,因为这会直接影响到Map阶段的执行速度。

2. **序列化机制**:在Map阶段输出的键值对需要序列化以便于网络传输和后续处理。选择合适的序列化框架(如Kryo或Avro)可以显著提高序列化和反序列化的速度。

在MapReduce框架中,开发者可以使用`Mapper`类来实现Map阶段的逻辑。下面是一个简单的Map函数示例:

```java

public static class MyMapper extends Mapper<LongWritable, Text, Text, IntWritable> {

private final static IntWritable one = new IntWritable(1);

private Text word = new Text();

public void map(LongWritable key, Text value, Context context) throws IOException, InterruptedException {

String[] words = value.toString().split("\\s+");

for (String str : words) {

word.set(str);

context.write(word, one);

}

}

}

```

在这个例子中,`Mapper`类的泛型参数分别表示输入键值对的类型(`LongWritable`和`Text`)和输出键值对的类型(`Text`和`IntWritable`)。Map函数将每行文本分割成单词,并为每个单词输出键值对,其中键为单词本身,值为数字1。这个过程的性能主要取决于文本的处理效率和内存使用。

### 2.1.3 Shuffle阶段

Shuffle阶段在MapReduce中是一个重要但经常被忽视的环节,它主要负责两个任务:一是将Map阶段输出的中间数据传输到Reduce阶段,二是对这些数据进行排序和合并。Shuffle过程的性能对于整个作业的执行时间有着直接的影响,因此了解其内部机制对于优化MapReduce性能至关重要。

Shuffle阶段的性能取决于数据传输效率和排序算法的效率,以下是一些提升Shuffle阶段性能的策略:

1. **网络优化**:增加网络带宽和改善网络拓扑可以减少数据传输时间。

2. **内存缓存**:使用高效的数据结构来缓存中间数据,可以减少对磁盘I/O的需求。

3. **减少数据量**:通过Combiner操作在Map端进行数据聚合,减少传输到Reduce端的数据量。

Shuffle的具体过程可以简化为以下几个步骤:

1. **Shuffle前的Map输出**:Map任务完成后,其输出的中间数据首先写入磁盘。

2. **数据分区**:将中间数据根据Partitioner确定的数据分区规则进行划分。

3. **数据排序**:在每个分区内对数据进行排序,并根据需要进行合并。

4. **拷贝数据**:将排序后的数据通过网络传输到对应的Reduce任务节点。

```java

// 在MapReduce作业配置中设置Shuffle行为

job.setPartitionerClass(HashPartitioner.class);

job.setGroupingComparatorClass(TextSamplerGroupingComparator.class);

job.setSortComparatorClass(TextSamplerSortingComparator.class);

```

在以上示例中,通过设置自定义的`Partitioner`和排序相关的比较器类,可以对Shuffle阶段的行为进行细粒度的控制。这样可以根据特定应用的需求来优化数据的分组和排序逻辑,以提高整体性能。

## 2.2 每个阶段的耗时分析

### 2.2.1 Reduce阶段的耗时因素

Reduce阶段是MapReduce作业中的第二个主要阶段,它负责接收来自Shuffle阶段的排序后的中间数据,并进行合并和处理,最终产生最终结果。Reduce阶段的耗时受多个因素影响,正确识别这些因素是优化MapReduce作业性能的关键。

1. **数据传输延迟**:Reduce任务通常需要从多个Map任务中获取数据,网络延迟和带宽限制可能成为性能瓶颈。

2. **数据本地性**:理想情况下,Reduce任务应该尽可能在本地节点上获取数据,减少数据传输的开销。

3. **磁盘I/O性能**:Reduce阶段会读取和写入磁盘,I/O性能直接影响到该阶段的耗时。

4. **内存管理**:Reduce任务需要处理大量的输入数据,内存的合理分配和管理至关重要。

5. **CPU计算负载**:与Map阶段相似,Reduce函数的计算复杂度也会显著影响性能。

在MapReduce作业配置中,开发者可以通过调整与Reduce阶段相关的参数来优化性能。例如:

```java

job.setNumReduceTasks(4); // 设置Reduce任务的数量

job.setReducerClass(MyReducer.class); // 设置Reduce任务使用的Reducer类

```

其中`setNumReduceTasks`方法用于指定Reduce任务的数量,适当增加或减少Reduce任务的数量可以平衡任务负载和网络传输开销。而`setReducerClass`方法则用于指定实现具体Reduce逻辑的类。

### 2.2.2 Sort阶段的效率影响

Sort阶段位于Shuffle阶段的后端,其主要功能是将Shuffle阶段传来的中间数据进行排序,这是为了确保每个Reduce任务接收到的键值对是有序的。Sort阶段的效率会直接影响到后续的Reduce处理的效率,特别是在需要对大量数据进行排序时。

优化Sort阶段的关键在于:

1. **选择高效的排序算法**:如快速排序、归并排序、TimSort等,Hadoop的Sort阶段默认采用TimSort算法,这是因为它在多种场景下都表现出较好的性能。

2. **优化内存使用**:合理地管理内存,可以减少对磁盘的使用,加快排序的速度。

3. **调整缓冲区大小**:通过调整`mapreduce.reduce.shuffle.input.buffer.percent`和`mapreduce.reduce.shuffle.memory.limit百分比`参数,可以控制用于缓冲Shuffle数据的内存大小。

```java

// 在Hadoop配置中设置Sort阶段的缓冲区大小

Configuration conf = job.getConfiguration();

int memoryLimitPercent = 30; // 设置缓冲区大小为可用内存的30%

conf.setInt("mapreduce.reduce.shuffle.memory.limit百分比", memoryLimitPercent);

```

以上代码示例展示了如何通过Hadoop的配置API来控制Shuffle过程中Reduce任务的内存使用。这里的内存使用控制是针对内存缓冲区的大小设置限制,可以有效减少不必要的磁盘I/O操作,加快数据处理速度。

### 2.2.3 输出写入阶段的性能瓶颈

输出写入阶段是MapReduce作业的最后一个关键阶段,它负责将Reduce阶段处理后的最终结果输出到磁盘。这个阶段的性能瓶颈往往出现在数据的序列化、数据的写出以及磁盘I/O上。因此,了解并掌握如何优化这一阶段,对提高整个作业的效率至关重要。

输出写入阶段的性能受以下因素影响:

1. **磁盘I/O速率**:磁盘的读写速度对输出效率有决定性影响,使用SSD硬盘比使用机械硬盘有更好的写入性能。

2. **数据序列化方式**:选择高效的序列化框架可以减少数据的序列化和反序列化时间,如Avro或Kryo序列化框架。

3. **数据写入方式**:控制数据的合并和压缩策略可以减少对磁盘的写入次数。

4. **缓冲区大小**:合理配置输出缓冲区大小可减少磁盘I/O次数,提高写入效率。

```java

// 使用MapReduce提供的OutputFormat类来配置输出写入参数

job.setOutputFormatClass(TextOutputFormat.class);

TextOutputFormat.setOutputPath(job, new Path(outputPath));

```

通过上述代码示例,我们配置了输出使用的格式为文本格式,输出路径为指定的目录。在实际应用中,还可以进一步通过`***press`参数来开启压缩功能,减少磁盘空间的占用并提升写入效率。

## 2.3 识别和诊断性能问题

### 2.3.1 利用监控工具进行性能诊断

监控工具是识别和诊断MapReduce性能问题的有力手段。它们能够收集和显示与作业执行相关的各种性能指标,帮助开发者快速定位性能瓶颈。常见的监控工具有Hadoop自带的Web界面、Ganglia、Nagios等。

Hadoop的Web界面提供了直观的作业执行详情,包括作业进度、各阶段耗时、任务状态等信息。通过查看这些信息,开发者可以初步判断作业执行是否存在性能问题,如某个阶段的执行时间异常地长或者任务长时间处于等待状态。

```html

<!-- Hadoop作业历史服务器提供的作业状态查看页面 -->

***<namenode-host>:19888/jobhistory.jsp

```

除了Hadoop的自带界面之外,还可以通过Ganglia这类高性能的集群监控工具来获取更为详尽的性能数据。Ganglia能够监控Hadoop集群中的所有机器,通过收集系统级别的信息(如CPU、内存、磁盘I/O),并以图表的形式展现出来,方便用户从宏观角度识别性能问题。

为了进一步细化问题,开发者可以使用Nagios这类系统监控工具。Nagios允许用户自定义各种监控检查项,通过设置警报阈值,当系统出现异常时,Nagios会发送告警,提醒管理员进行干预。这些监控工具的联合使用可以全方位地监控MapReduce作业的执行状态,确保及时发现和处理性能问题。

### 2.3.2 常见性能问题案例分析

MapReduce作业的性能问题往往是由多种因素共同作用的结果。识别这些问题并找到合适的解决方案需要对作业执行的各个环节有深刻的理解。以下是几个MapReduce作业中常见的性能问题以及对应的分析和解决方法。

**问题一:Map任务执行缓慢**

- **分析**:Map任务是整个MapReduce作业的计算核心,如果Map任务执行缓慢,那么可能会影响整个作业的完成时间。Map任务执行缓慢可能的原因包括输入数据量过大、磁盘I/O瓶颈、CPU计算能力不足、Map函数本身效率低下等。

- **解决**:首先查看Map任务的资源使用情况,如CPU、内存和磁盘I/O指标。如果发现某类资源使用率高,应考虑调整作业的资源分配策略。对于Map函数效率低下的情况,可以考虑优化算法或者重新设计Map逻辑。

**问题二:Reduce阶段耗时异常**

- **分析**:Reduce阶段耗时异常通常由Shuffle和Sort阶段的延迟导致。如果Reduce任务接收到的数据量过大或者网络延迟过高,都会导致Shuffle过程变慢。另外,如果Reduce函数需要处理的数据量非常大,排序阶段也可能成为瓶颈。

- **解决**:监控Shuffle过程中的数据传输情况,查看是否有网络延迟或带宽不足的问题。对于数据量大的情况,可以考虑启用Combiner操作减少数据传输量。如果排序算法成为瓶颈,尝试调整MapReduce的排序参数,如调整`mapreduce.job.maps`的值,以优化Shuffle和Sort的性能。

以上内容仅为性能问题分析和解决方法的一部分,要深入解决具体问题,还需结合实际场景,仔细分析监控数据,并不断测试调整。

根据以上章节所述,我们可以对MapReduce作业的性能分析有了更加深入的理解。在后续的章节中,我们将继续探讨如何通过各种优化策略来提升MapReduce的性能,以及如何在实战案例中应用这些优化方法。

# 3. MapReduce性能优化策略

MapReduce作为一种广泛使用的编程模型,在大数据处理领域中发挥着重要作用。随着数据量的不断增加和处理需求的日益复杂化,性能优化显得尤为重要。本章将深入探讨MapReduce的性能优化策略,旨在通过分析和改进关键阶段的性能,提高整体计算效率。

## 3.1 数据本地化优化

数据本地化是指尽可能地在数据存储的物理位置附近进行计算,从而减少网络传输数据的开销,显著提高处理效率。

### 3.1.1 数据副本策略的影响

在Hadoop中,默认情况下,每个数据块都会在集群中保存3份副本。数据副本策略直接影响了数据本地化优化的效果。合理的副本策略可以减少数据传输距离,提高Map任务的处理速度。

#### *.*.*.* 副本数量调整

副本数量对性能的影响是双刃剑。如果副本太多,会消耗过多的存储空间;副本太少,则可能导致数据局部性变差,从而增加网络负载。

```shell

# 设置副本因子为2

hdfs dfsadmin -setReplication <path> <replication>

```

在上述命令中,`<path>`代表文件路径,`<replication>`代表副本数量。通过调整此参数,可以优化数据本地化水平。

### 3.1.2 提高Map任务的本地性

提高Map任务本地性是减少数据传输的重要手段。Hadoop MapReduce通过控制Map任务的执行位置,确保尽可能在数据所在节点上运行,从而减少数据移动。

#### *.*.*.* 控制Map任务的执行位置

通过配置Map任务的本地性属性,可以进一步提高数据本地化率。

```xml

<property>

<name>mapreduce.job locality等待时间</name>

<value>300000</value> <!--单位是毫秒-->

</property>

```

在这个配置中,`mapreduce.job.locality等待时间`参数定义了当没有本地任务时,MapReduce框架等待的最长时间。通过合理设置此参数,可以在保证数据局部性的同时,不过分延后作业的开始。

## 3.2 资源管理优化

资源管理是集群性能调优的关键。优化资源管理可以确保任务高效地分配和使用集群资源。

### 3.2.1 资源调度与任务分配

资源调度器负责分配任务到集群中合适的节点上。一个高效的调度器可以显著提高资源利用率和作业执行速度。

#### *.*.*.* FIFO调度器

FIFO调度器是Hadoop最早期的调度器,简单易用,但它不考虑作业的优先级和资源需求,可能造成资源浪费。

```mermaid

graph TD;

A[开始调度] --> B{FIFO调度器};

B --> |简单任务| C[执行];

B --> |复杂任务| D[等待];

```

FIFO调度器在面对简单任务时直接执行,而对于复杂任务则需等待,这样可能导致资源利用率下降。

### 3.2.2 动态调整资源分配

为了更好地应对不同负载和需求的场景,动态资源分配技术应运而生。动态资源分配允许在作业运行过程中根据实际需求来增减资源。

#### *.*.*.* 伸缩式资源分配器

伸缩式资源分配器在作业运行时根据任务量动态调整资源,充分利用了集群的计算能力。

```mermaid

graph LR;

A[任务开始] --> B{资源分配};

B --> |任务量小| C[减少资源];

B --> |任务量大| D[增加资源];

```

在伸缩式资源分配器的工作机制中,任务量的变化直接影响资源的分配,从而达到节省资源和提高效率的目的。

## 3.3 网络和磁盘I/O优化

网络和磁盘I/O瓶颈在大数据处理中也十分常见,优化这部分性能可以进一步提升MapReduce作业的执行效率。

### 3.3.1 网络带宽的合理利用

网络带宽是影响数据传输效率的重要因素。合理分配和利用网络资源能够显著提升数据处理速度。

#### *.*.*.* 带宽均衡机制

在大数据处理中,合理的带宽分配和利用对性能至关重要。带宽均衡机制确保网络带宽被充分且合理地利用。

```mermaid

graph LR;

A[开始传输] --> B{带宽分配};

B --> |优先级高| C[高带宽];

B --> |优先级低| D[低带宽];

```

通过优先级管理,带宽均衡机制可以针对不同任务的重要程度和数据大小合理分配带宽资源,提升整体性能。

### 3.3.2 优化磁盘I/O性能

磁盘I/O性能的优化可以减少数据读写延迟,提升数据处理速度。

#### *.*.*.* 异步I/O操作

异步I/O操作可以显著提高磁盘读写的效率,尤其是在高并发场景下。

```java

// 异步读取数据示例

AsyncDiskService asyncDiskService = new AsyncDiskService();

CompletableFuture<byte[]> future = asyncDiskService.readAsync(filePath);

```

通过使用异步I/O操作,应用程序可以在等待磁盘操作完成时,继续执行其他任务,极大地提高了程序的响应性和吞吐量。

通过上述章节内容,我们可以看到,MapReduce性能优化是一个多方面的复杂过程,涉及到数据本地化优化、资源管理优化以及网络和磁盘I/O优化等多个方面。接下来,在第四章中,我们将进一步探讨MapReduce的高级优化技术,并在第五章中通过具体的实战案例来展示这些优化策略的实际效果。

# 4. MapReduce的高级优化技术

## 4.1 框架级别的优化

### 4.1.1 Hadoop参数调优

Hadoop作为一个成熟的分布式计算框架,提供了大量可调整的参数,这些参数调整对于改善MapReduce作业的性能至关重要。通过合理设置这些参数,可以优化网络传输、磁盘I/O、内存管理等关键性能因素。

首先,`mapreduce.task.io.sort.factor` 参数控制着在内存中的数据排序时能合并多少个流。增加这个参数的值可以减少磁盘I/O次数,但过多的合并操作可能会消耗更多的内存。

```java

// 示例代码块展示如何调整sort.factor参数

Configuration conf = new Configuration();

conf.setInt("mapreduce.task.io.sort.factor", 100); // 默认值通常是10

```

其次,`mapreduce.jobhistory.address` 参数用来配置历史服务器地址,可以帮助运维人员通过Hadoop提供的历史服务器界面进行作业历史的分析和故障排查。

```java

// 示例代码块展示如何设置jobhistory.address参数

Configuration conf = new Configuration();

conf.set("mapreduce.jobhistory.address", "hadoop-master:10020");

```

参数调优工作通常是和具体的作业和集群环境相结合,需要根据实际的作业需求和集群状况进行个性化调整。

### 4.1.2 任务执行计划和调度优化

在MapReduce中,任务的执行计划与调度对于资源利用率和作业完成时间有重要影响。默认情况下,Hadoop会尝试平衡可用节点上的任务,避免部分节点过载而有的节点闲置。但在实践中,有时需要根据作业的特点手动调整任务分配和执行顺序。

例如,通过设置`mapreduce.job.map.speculative`为`true`,可以在作业执行过程中启用推测执行机制。当某个Map任务的运行速度远低于其它Map任务时,系统会启动一个相同的任务在另一节点上运行。一旦另一个任务先完成,原本落后的任务就会被取消。

```java

// 示例代码块展示如何启用任务推测执行

Configuration conf = new Configuration();

conf.setBoolean("mapreduce.job.map.speculative", true);

```

此外,对于有向无环图(DAG)类型的作业,可以利用YARN中的Capacity Scheduler或者Fair Scheduler进行更高级的资源管理和任务调度,这些调度器提供了更细粒度的调度控制。

## 4.2 自定义实现优化

### 4.2.1 自定义Partitioner优化数据分布

默认情况下,MapReduce的Partitioner会根据Key的哈希值均匀地分布到不同的Reducer上。在某些特定场景下,这种均匀分布可能导致数据倾斜,特别是当Key值范围非常集中时。

此时,可以自定义Partitioner来控制数据的路由。比如,如果知道某一特定Key会比其他Key产生的数据量大得多,那么可以设计一个特殊的Partitioner,确保这个Key被分散到多个Reducer上处理。

```java

public class CustomPartitioner extends Partitioner<Text, IntWritable> {

@Override

public int getPartition(Text key, IntWritable value, int numPartitions) {

// 自定义的键值分区逻辑

}

}

```

在实现自定义Partitioner时,关键是要平衡数据的分布,避免数据倾斜,并且考虑到数据局部性原则,尽量减少跨节点的数据传输。

### 4.2.2 Combiner的使用策略

Combiner是在Map端对数据进行局部汇总的可选组件,其主要作用是在Map输出到Reducer之前减少数据量。合理使用Combiner可以显著减少网络传输的负载,加快MapReduce作业的总体执行速度。

例如,如果我们的Map任务输出了大量的重复数据,那么可以在Combiner阶段对这些数据进行归并,减少后续Shuffle阶段的数据传输量。

```java

// 示例代码展示如何设置使用Combiner

Job job = Job.getInstance(conf, "Word Count");

job.setCombinerClass(MyCombiner.class); // 设置自定义的Combiner类

```

设置Combiner时,需要考虑其逻辑,确保它不会影响最终结果的准确性。通常,Combiner适用于数据聚合的场景,比如求和、计数等。

## 4.3 应用层面的优化

### 4.3.1 输入数据的预处理

对于输入数据进行预处理可以显著减少MapReduce的负载。预处理可以包括数据清洗、数据格式化等操作。通过去除无效数据、纠正格式错误或者进行数据归一化,可以让MapReduce作业更快地开始处理,提高数据处理效率。

在某些情况下,预处理操作可以在数据加载到Hadoop集群之前完成,或者在执行MapReduce作业之前,利用Hadoop生态中的其他工具(如Pig、Hive)来处理数据。

### 4.3.2 输出数据的后处理

MapReduce作业完成后,通常需要进行数据的后处理。这一阶段可能包括数据转换、数据清洗、数据聚合等操作。在Hadoop生态系统中,可以使用Hive或Pig等工具来执行这些操作,也可以编写额外的MapReduce作业来进一步处理数据。

例如,一个数据聚合的场景中,在MapReduce作业完成后,可以编写一个简单的MapReduce程序,根据业务需求对结果进行排序、合并、去重等操作。

以上介绍的优化技术,是从框架级别到应用层面的综合考虑,涵盖了从Hadoop参数调优到数据的预处理和后处理。在实际应用中,需要结合具体业务场景和数据特点,灵活运用各种优化策略以达到最佳的计算效果。

# 5. MapReduce性能优化实战案例

## 5.1 大数据处理场景下的优化

### 5.1.1 实时处理的性能调优

在大数据环境下,实时处理的需求越来越普遍。MapReduce虽然是批处理框架,但在某些情况下也可以用于实时处理任务。针对实时处理场景的性能调优,我们可以从以下几个方面入手:

- **降低MapReduce作业的启动开销**:对于实时场景,我们更关注作业的启动速度,因此可以通过调整MapReduce框架的配置参数来减少启动时间。例如,减少Map任务的内存分配,以加快任务启动速度。

- **使用高效的数据序列化机制**:选择高效的序列化框架,如Kryo,可以减少数据在网络和磁盘上的传输时间,提高整体处理效率。

- **优化数据的序列化和反序列化操作**:对于实时处理来说,数据的序列化和反序列化操作在性能优化中占有较大比重。通过调整序列化框架的配置,如Kryo的注册策略,可以进一步提升性能。

代码示例:

```java

// 使用Kryo序列化框架

Configuration conf = new Configuration();

conf.set("mapreduce.job.output.key.class", "com.example.MyKey");

conf.set("mapreduce.job.output.value.class", "com.example.MyValue");

conf.set("io.serializations", "org.apache.hadoop.io.serializer.KryoSerialization");

// 设置Kryo的注册策略

Serializer mySerializer = new KryoSerializer(com.example.MyKey.class, com.example.MyValue.class);

Job job = Job.getInstance(conf);

job.setJarByClass(MyJob.class);

job.setOutputKeyClass(com.example.MyKey.class);

job.setOutputValueClass(com.example.MyValue.class);

job.setMapperClass(MyMapper.class);

job.setReducerClass(MyReducer.class);

// 其他配置...

```

### 5.1.2 批处理的资源优化

批处理作业由于作业量大,对资源的利用率要求较高。优化批处理作业资源使用的重点是合理分配资源,并充分利用数据本地性。

- **合理设定资源请求**:根据作业的具体需求,动态调整CPU、内存等资源的请求量,避免资源浪费或不足。

- **优化任务分配策略**:对于批处理作业,应尽量保证任务在数据本地执行,减少网络传输。可以通过调整Hadoop的`mapreduce.job.local.dir`和`mapreduce.framework.name`参数来实现。

- **存储计算分离**:为了避免计算资源和存储资源的竞争,可以采用存储计算分离的架构,如HDFS用于存储,而HBase用于快速的随机访问。

## 5.2 案例分析与总结

### 5.2.1 成功优化案例分享

在本节中,我们将分享一个成功利用上述策略进行性能优化的案例。该案例涉及了一个大数据视频分析平台,该平台需要处理大量的视频数据,并从中提取关键帧进行分类和存储。

首先,针对实时处理,团队通过调整序列化机制和优化数据结构设计,将处理延迟从300ms降低至150ms。同时,通过减少MapReduce作业启动开销和优化网络I/O,将数据处理速度提升了20%。

在批处理方面,通过实现自定义的Partitioner来优化数据分布,使得数据的Shuffle阶段耗时减少了30%。此外,采用存储计算分离策略,有效地解决了计算资源和存储资源竞争问题。

代码示例:

```java

// 自定义Partitioner

public class MyPartitioner extends Partitioner<MyKey, MyValue> {

@Override

public int getPartition(MyKey key, MyValue value, int numPartitions) {

// 自定义分区逻辑

return (key.hashCode() & Integer.MAX_VALUE) % numPartitions;

}

}

// 在作业配置中使用自定义Partitioner

job.setPartitionerClass(MyPartitioner.class);

```

### 5.2.2 常见错误和误区总结

在进行MapReduce性能优化时,我们需要注意避免一些常见的错误和误区:

- **过度优化**:有些开发者可能会过度优化,引入不必要的复杂性。优化应该是有目标的,并且在提升性能的同时保证代码的可读性和可维护性。

- **忽略数据本地性**:忽视数据本地性是性能优化中的常见误区之一。数据本地性对性能的影响很大,因此应该尽量保证Map任务在数据存储的物理位置上执行。

- **不合适的资源分配**:对于不同的作业和数据集,其资源需求是不同的。一个固定的资源分配模板无法适用于所有场景,因此需要根据实际情况动态调整资源分配。

总的来说,MapReduce的性能优化是一个需要综合考虑多种因素并不断测试调整的过程。通过理论与实践的结合,我们可以更有效地提升大数据处理的效率和可靠性。

0

0