MapReduce性能监控与分析:识别慢操作的关键指标及改善方法

发布时间: 2024-10-30 17:08:00 阅读量: 35 订阅数: 40

基于MapReduce+Pandas的电影排名与推荐以及数据分析与可视化展示

# 1. MapReduce性能监控与分析概述

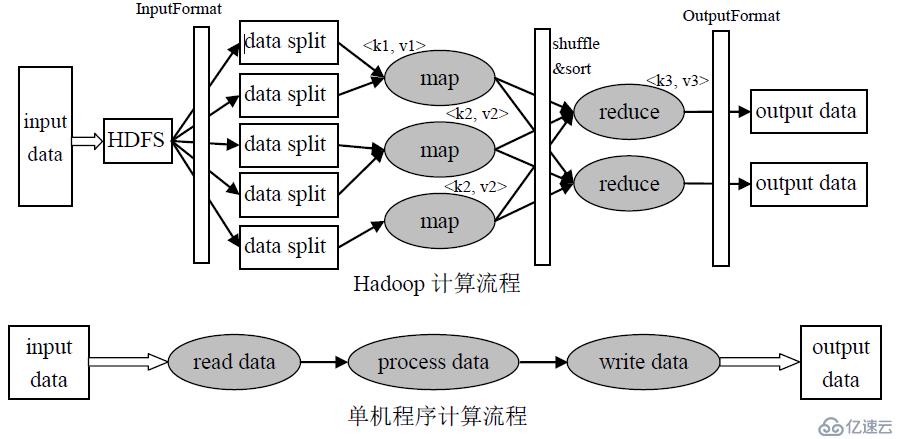

MapReduce作为大数据处理领域的重要技术框架,其性能监控与分析对于保障大数据处理效率至关重要。本章将简要介绍性能监控与分析在MapReduce工作流中的重要性,并概述如何通过对关键性能指标的分析,诊断潜在的性能瓶颈,并提出相应的优化策略。

在大数据的计算生态系统中,MapReduce通过分布式处理能够有效地处理PB级别的数据量。然而,随着数据量的增长和计算需求的提升,其性能成为影响整体处理效率的关键因素。因此,性能监控与分析成为了优化MapReduce作业不可或缺的部分。

性能监控与分析不仅仅是对运行状态的简单观察,它涉及到作业执行时间、资源使用情况、任务执行状况等多方面的细致考量。通过对这些关键指标的持续监控,可以在问题发生前采取预防措施,或在性能瓶颈出现时进行及时的诊断和调整,确保MapReduce作业的高效稳定运行。

# 2. MapReduce关键性能指标

### 2.1 作业执行时间分析

#### 2.1.1 作业生命周期中的关键阶段

MapReduce作业的生命周期包括初始化、运行和结束阶段。在初始化阶段,系统进行作业配置和任务分配。运行阶段涉及到Map任务和Reduce任务的执行,同时,监控任务和Shuffle过程也是作业执行时间分析的关键部分。结束阶段主要包括作业的清理工作。

```markdown

1. **初始化阶段**

- 分析系统资源,根据作业的资源配置要求进行分配。

- 读取输入数据,进行任务划分,生成Map任务。

2. **运行阶段**

- **Map任务执行**:处理输入数据,输出中间键值对。

- **Shuffle过程**:对中间结果进行排序、分区,传输给Reduce任务。

- **Reduce任务执行**:对收到的中间结果进行合并操作,输出最终结果。

3. **结束阶段**

- 清理作业使用的临时资源。

- 更新系统状态,为下一个作业做准备。

```

#### 2.1.2 作业执行时间的度量和分析

作业执行时间度量需要关注Map阶段、Shuffle阶段以及Reduce阶段的时间消耗。通过监控作业执行时间,可以对性能瓶颈进行定位和分析。

```markdown

1. **Map阶段耗时**:记录所有Map任务的开始和结束时间,计算总耗时。

2. **Shuffle阶段耗时**:包括网络传输时间和排序处理时间。

3. **Reduce阶段耗时**:记录Reduce任务的开始和结束时间,计算耗时。

4. **总耗时分析**:作业总执行时间 = Map阶段耗时 + Shuffle阶段耗时 + Reduce阶段耗时。

```

### 2.2 资源使用情况监控

#### 2.2.1 CPU和内存使用情况监控

CPU和内存是集群中最宝贵的资源,其使用情况直接影响作业的执行效率。监控CPU和内存使用情况可以确保作业运行在资源充足的环境下,避免因资源不足导致的性能下降。

```markdown

1. **CPU使用率**:监控集群中每个节点的CPU使用情况,定期采集CPU占用百分比。

2. **内存使用率**:监控内存占用和内存消耗,保证内存资源充足,避免频繁的内存交换。

通过收集和分析CPU和内存使用数据,可以优化资源分配,提升系统整体性能。

```

#### 2.2.2 磁盘I/O和网络I/O监控

磁盘I/O和网络I/O同样是影响MapReduce作业性能的关键因素。磁盘I/O影响数据读写效率,而网络I/O则影响Shuffle过程中的数据传输。

```markdown

1. **磁盘I/O监控**:监控读写速度和读写次数,分析是否存在I/O瓶颈。

2. **网络I/O监控**:监控网络传输的带宽占用,确保数据传输过程中网络畅通。

通过适当的监控和分析,可以合理配置磁盘和网络资源,减少I/O延迟。

```

### 2.3 Map和Reduce任务的性能分析

#### 2.3.1 Map任务的性能瓶颈识别

Map任务的性能瓶颈可能出现在磁盘读取、CPU计算和网络传输等多个方面。正确识别这些瓶颈可以帮助我们针对性地进行优化。

```markdown

1. **磁盘读取瓶颈**:通过监控Map任务的磁盘读取速率,分析是否因为磁盘性能限制导致Map任务执行缓慢。

2. **CPU计算瓶颈**:监控Map任务的CPU使用率,判断是否是CPU资源不足导致任务处理速度下降。

通过这些分析,可以针对具体情况进行硬件升级或算法优化。

```

#### 2.3.2 Reduce任务的性能瓶颈识别

Reduce任务的瓶颈可能由多个因素引起,比如数据倾斜、内存不足、磁盘写入速度慢等。

```markdown

1. **数据倾斜**:检查Reduce任务中是否某个或某些键对应的值数量异常多,造成性能瓶颈。

2. **内存不足**:监控Reduce任务的内存使用情况,避免内存溢出和频繁的垃圾回收。

针对Reduce任务的性能瓶颈分析,可以采取负载均衡、内存管理优化等措施。

```

在进行性能瓶颈识别时,要进行多维度的监控和分析,以确保全面掌握MapReduce作业的性能状态。通过对不同阶段、不同资源的监控,可以对性能进行深入的分析,并找到优化的方向。

# 3. MapReduce慢操作识别与诊断

随着大数据处理需求的不断增长,MapReduce作为处理大规模数据集的并行计算框架,在其长时间运行过程中,可能会出现性能瓶颈或慢操作问题。有效识别并诊断这些慢操作对于保障集群性能至关重要。本章将深入探讨如何识别MapReduce任务中的慢操作问题,并提供相应的诊断方法。

## 3.1 任务调度延迟分析

任务调度延迟是MapReduce作业性能问题的常见因素之一。当作业提交到集群后,任务调度过程会受到多种因素的影响,导致任务实际开始执行的时间大大延迟。

### 3.1.1 任务调度过程的监控

任务调度过程涉及对可用资源的管理与分配,包括任务队列的管理、任务优先级的判断和执行资源的分配。在Hadoop集群中,通常由ResourceManager进行资源管理,NodeManager负责节点管理。理解这一过程是诊断调度延迟的基础。

监控任务调度过程需要关注以下几点:

- 任务队列的状态信息。

- 任务提交顺序和优先级。

- 资源的分配情况和资源利用率。

### 3.1.2 调度延迟的识别与诊断方法

#### 诊断工具与方法

- **YARN ResourceManager Web UI**: 这是一个Web界面工具,可以帮助我们可视化整个调度过程。

- **Timeline Server**: 通过这个组件,我们可以观察到从作业提交到作业完成的整个时间线。

#### 具体步骤

1. 通过ResourceManager Web UI观察队列和任务的等待情况。

2. 分析Timeline Server提供的详细时间线,查看任务执行的各个阶段耗时。

3. 结合YARN日志,使用grep等工具找出慢操作的线索。

#### 示例代码块

```shell

# 查询ResourceManager Web UI的日志

yarn logs -applicationId <applicationId> | grep -i "Scheduling delay"

# 使用Timeline Server分析特定作业的时间线

curl -s "***<timeline-server-host>:<port>/ws/v1/timeline/?appid=<applicationId>" | jq '.'

```

#### 参数说明

- `<applicationId>`:这是要分析的MapReduce作业ID。

- `<timeline-server-host>` 和 `<port>`:分别代表Timeline Server的主机和端口。

#### 代码逻辑分析

在上述代码块中,首先使用 `yarn logs` 命令与 grep 工具组合来筛选出与调度延迟相关的日志条目。`grep -i "Scheduling delay"` 表示不区分大小写地搜索包含"调度延迟"关键词的日志。接着,使用 `curl` 命令和 Timeline Server 的API获取特定作业的时间线信息,然后利用 `jq` 工具进行JSON格式数据的处理和分析。

## 3.2 数据倾斜问题的分析

数据倾斜问题通常发生在Map任务

0

0