【算法竞赛秘籍】:使用混淆矩阵进行模型评估与选择

发布时间: 2024-11-21 04:13:49 阅读量: 12 订阅数: 14

# 1. 混淆矩阵概念解析

## 1.1 混淆矩阵的定义与组成

在机器学习的分类问题中,混淆矩阵是一个重要的工具,用于评估模型的性能。它是一个表格,展示了模型预测结果与真实值的对应关系。通过四个基本的统计量:真正例(True Positive, TP)、假正例(False Positive, FP)、真负例(True Negative, TN)和假负例(False Negative, FN),混淆矩阵能够提供详细的分类情况。

## 1.2 混淆矩阵的直观理解

混淆矩阵的直观性在于,通过其结构我们可以清晰地看到分类模型的成功和失败之处。例如,在二分类问题中,TP和TN分别表示模型正确预测正例和负例的数量,而FP和FN则分别表示将负例错误预测为正例和将正例错误预测为负例的数量。这种分解为更细致的分析提供了可能。

## 1.3 混淆矩阵与模型性能

混淆矩阵不仅仅是数字的展示,它背后蕴藏着模型性能的深层信息。通过分析混淆矩阵,我们可以进一步计算出精确度、准确率、召回率以及F1分数等关键指标,从而更全面地了解模型在各个方面的表现。

```mermaid

flowchart LR

A[混淆矩阵] -->|定义与组成| B[TP, FP, TN, FN]

A -->|直观理解| C[分类成功与失败分析]

A -->|模型性能| D[计算关键指标]

B -->|连接| D

C -->|连接| D

```

在下一章中,我们将深入探讨混淆矩阵在模型评估中的应用,以及如何利用它来深入分析分类问题的评估指标。

# 2. 混淆矩阵在模型评估中的应用

### 2.1 分类问题的评估指标

在机器学习的分类任务中,混淆矩阵是评估模型性能的关键工具,它提供了一个清晰的视角来理解分类器对样本的预测情况。在开始具体探讨混淆矩阵之前,我们首先需要了解分类问题的几个基本评估指标:真正例(TP)、假正例(FP)、真负例(TN)以及假负例(FN)。

#### 真正例(TP)、假正例(FP)

真正例指的是模型正确预测为正类的样本,即实际类别和预测类别均为正类。在很多实际应用中,TP是模型最希望增加的指标,例如在疾病诊断中,真正例的增加意味着更多的患者被正确诊断出疾病。

```mermaid

graph LR

A[真正例 TP] -->|正确预测正类| B[正类样本]

```

假正例则是模型错误预测为正类的样本,实际上样本属于负类。FP对模型的性能有负面影响,特别是在成本敏感的领域,如金融欺诈检测,过多的FP可能会带来额外的审查成本。

```mermaid

graph LR

A[假正例 FP] -->|错误预测正类| B[负类样本]

```

#### 真负例(TN)、假负例(FN)

真负例是模型正确预测为负类的样本,即实际类别和预测类别均为负类。TN是模型正确分类的体现,在许多场景下也同样重要,比如在垃圾邮件识别中,TN表示非垃圾邮件被正确识别为负类。

```mermaid

graph LR

A[真负例 TN] -->|正确预测负类| B[负类样本]

```

假负例指的是模型错误预测为负类的正类样本。FN是模型漏诊的指标,在医疗诊断等高风险领域尤其重要,因为FN可能导致疾病未被及时发现和治疗。

```mermaid

graph LR

A[假负例 FN] -->|错误预测负类| B[正类样本]

```

通过理解这些基本概念,我们可以开始构建混淆矩阵,并以此为基础进行进一步的模型评估。在下一节中,我们将介绍如何计算二分类和多分类问题中的混淆矩阵。

### 2.2 混淆矩阵的计算方法

#### 2.2.1 二分类问题的混淆矩阵

在二分类问题中,混淆矩阵是一个2x2的表格,它将样本分类为TP、FP、TN和FN四个类别。具体结构如下:

| 预测\实际 | 正类 | 负类 |

|-----------|------|------|

| 正类 | TP | FP |

| 负类 | FN | TN |

为了计算混淆矩阵,我们需要将测试集的数据通过模型进行预测,并根据模型的输出和实际标签来填充这个表格。以下是构建二分类混淆矩阵的Python代码示例:

```python

from sklearn.metrics import confusion_matrix

# 假设 y_true 是真实的标签,y_pred 是模型预测的标签

y_true = [1, 0, 1, 1, 0, 0, 1, 0, 0, 1]

y_pred = [1, 0, 1, 0, 0, 1, 1, 0, 0, 0]

# 计算混淆矩阵

conf_matrix = confusion_matrix(y_true, y_pred)

print(conf_matrix)

```

执行逻辑说明:

- `y_true` 是一个列表,包含了样本的真实标签。

- `y_pred` 是一个列表,包含了模型对相应样本的预测结果。

- `confusion_matrix` 函数来自 `sklearn.metrics` 模块,用于计算混淆矩阵。

- 执行后,我们得到的 `conf_matrix` 将是一个2x2的数组,其中的元素对应于TP、FP、TN和FN的数量。

#### 2.2.2 多分类问题的混淆矩阵

多分类问题的混淆矩阵要比二分类问题复杂,因为它涉及到多个类别的预测和实际结果。混淆矩阵在这里是一个N维矩阵,N是类别数。我们以三分类问题为例来说明:

| 预测\实际 | 类别1 | 类别2 | 类别3 |

|-----------|-------|-------|-------|

| 类别1 | TP1 | FP21 | FP31 |

| 类别2 | FP12 | TP2 | FP32 |

| 类别3 | FP13 | FP23 | TP3 |

在这个例子中,TP1、TP2和TP3分别代表三个类别的真正例数量,而FPij代表预测为类别i但实际上是类别j的假正例数量。在Python中,我们同样可以使用 `confusion_matrix` 函数来计算多分类问题的混淆矩阵。假设我们有三个类别的真实标签和预测结果:

```python

y_true = [2, 0, 2, 2, 0, 1, 1, 2, 0, 1]

y_pred = [2, 0, 2, 2, 0, 0, 1, 2, 0, 2]

conf_matrix = confusion_matrix(y_true, y_pred)

print(conf_matrix)

```

执行逻辑说明:

- 类似于二分类的情况,不过这次 `y_true` 和 `y_pred` 列表包含了三个类别的标签。

- 输出的 `conf_matrix` 是一个3x3的数组,能够详细地展示每个类别在混淆矩阵中的分布情况。

### 2.3 混淆矩阵的评估指标解读

通过混淆矩阵,我们可以计算出多个有用的评估指标来衡量模型的性能。这些指标包括精确度(Accuracy)、准确率(Precision)和召回率(Recall),以及F1分数。

#### 2.3.1 精确度(Accuracy)

精确度是所有被正确分类样本数占总样本数的比例。它是一个普遍使用的指标,计算方法如下:

$$ Accuracy = \frac{TP + TN}{TP + TN + FP + FN} $$

精确度适合于正负类样本分布均衡的情况。如果一个数据集中的样本类别分布非常不均衡,那么精确度可能会产生误导。

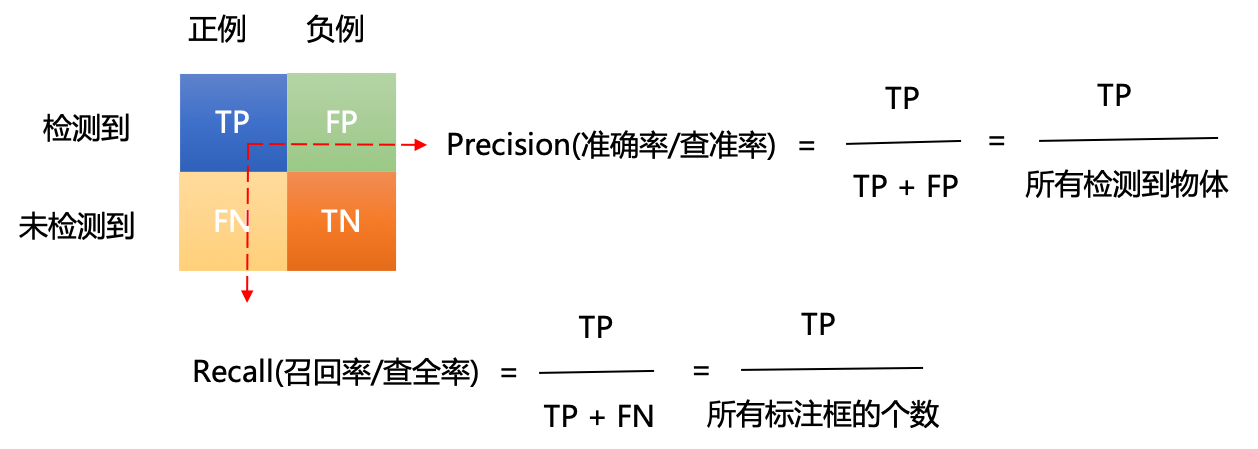

#### 2.3.2 准确率(Precision)和召回率(Recall)

准确率是指被模型预测为正类的样本中,实际为正类的比例。其计算公式为:

$$ Precision = \frac{TP}{TP + FP} $$

召回率是指实际为正类的样本中,被模型预测为正类的比例。其计算公式为:

$$ Recall = \frac{TP}{TP + FN} $$

准确率与召回率之间往往存在权衡关系。在实际应用中,需要根据具体问题的场景来决定是优先考虑准确率还是召回率。

#### 2.3.3 F1分数的计算和意义

F1分数是准确率和召回率的调和平均数,综合考虑了模型的准确性和召回能力。其计算公式如下:

$$ F1 = 2 \times \frac{Precision \times Recall}{Precision + Recall} $$

F1分数对于那些类别不平衡的数据集特别有用,因为它提供了一个单一的度量值来平衡准确率和召回率。在选择模型时,如果一个模型的F1分数显著高于另一个模型,那么它通常在性能上更优秀。

在本章中,我们已经介绍混淆矩阵在模型评估中的应用,从分类问题的基本评估指标到计算方法,再到评估指标的解读。混淆矩阵不仅为模型性能提供了直观的展示,还帮助我们通过不同的指标对模型进行综合评估。下一章我们将深入探讨模型选择与混淆矩阵之间的关系,并且介绍如何在实际案例中应用混淆矩阵来进行策略选择。

# 3. 模型选择与混淆矩阵的关系

模型选择是机器学习过程中的关键步骤,其决定了最终模型的性能和泛化能力。混淆矩阵,作为一种评估分类模型性能的重要工具,能够为我们提供更深入的洞察,帮助我们做出更明智的模型选择。

### 3.1 模型泛化能力的重要性

在模型训练过程中,我们经常面临过拟合和欠拟合的问题。了解这些问题对于选择恰当的模型至关重要。

#### 3.1.1 过拟合与欠拟合的概念

过拟合是指模型在训练数据上表现优异,但在未见过的测试数据上表现差强人意。这种情况通常是因为模型学习到了训练数据中的噪声和细节,而没有抓住数据背后的普遍规律。

```python

# 示例代码:使用Python和scikit-learn库展示过拟合现象

from sklearn.datasets

```

0

0