【R语言MCMC算法优化】:性能提升秘籍与统计推断实战技巧

发布时间: 2024-11-03 01:50:37 阅读量: 34 订阅数: 40

统计计算-MH算法(R语言)

# 1. R语言与MCMC算法基础

在这一章中,我们将初步探索R语言与MCMC算法的基础,为后续章节的深入探讨打下坚实的基础。

## 1.1 R语言简介

R语言是一种用于统计计算和图形的编程语言和软件环境。它拥有强大的数据处理能力,广泛应用于数据挖掘、统计分析和生物信息学等领域。R语言的特点包括丰富的包、灵活的图形功能以及社区支持的开源特性。

## 1.2 MCMC算法概念

MCMC(Markov Chain Monte Carlo)算法是一系列随机模拟算法的总称,用于从复杂的概率分布中抽取样本。这些算法的共同点在于通过构建一个马尔科夫链,在达到稳态后,从链的平稳分布中抽取样本以进行统计推断。MCMC算法在贝叶斯统计中尤为重要,因为它提供了一种近似计算后验分布的方法。

## 1.3 R语言与MCMC的结合

R语言与MCMC算法的结合,使得数据分析者可以利用R丰富的统计和图形功能,对MCMC生成的样本进行深入分析。R语言提供了多个包(如`MCMCpack`、`coda`等),专门用于MCMC算法的实现和分析,使得在R环境中进行MCMC模拟和推断变得非常方便。

通过本章的介绍,我们奠定了理解后续章节内容的基础,下章我们将深入探讨MCMC算法的理论框架。

# 2. MCMC算法的理论框架

## 2.1 随机模拟方法

随机模拟方法是蒙特卡洛方法的核心组成部分,它依赖于随机数生成和对随机过程的深入理解。在统计推断和复杂系统分析中,随机模拟提供了一种强大的工具,帮助我们理解和解决那些难以用解析方法解决的问题。

### 2.1.1 随机数生成基础

随机数生成是蒙特卡洛方法不可或缺的步骤。在计算机上生成的随机数实际上都是伪随机数,它们是通过确定性的算法生成的,目的是尽可能模拟真实的随机行为。生成好的随机数对于算法的准确性和可靠性至关重要。

在R语言中,可以通过`sample()`函数生成随机数。例如,生成一个有放回的随机整数序列可以使用:

```R

# 生成一个包含10个0到9之间的随机整数序列

sample(0:9, 10, replace = TRUE)

```

该代码块演示了如何在R中生成基础随机数。`sample()`函数的`replace`参数被设为`TRUE`,这表示在取样时允许重复,即有放回的抽样。这与在有限集合中进行多次独立的随机抽取类似。

### 2.1.2 Markov链的基本理论

Markov链是随机过程的一种,其核心特征是具有无记忆性。这意味着下一个状态的概率分布仅取决于当前状态,而与之前的状态无关。Markov链在MCMC算法中扮演着核心角色,因为它可以用来模拟复杂的概率分布。

Markov链的基本性质如下:

- 状态空间:随机过程可能存在的状态集合。

- 转移矩阵:描述了从一个状态转移到另一个状态的概率。

- 长期行为:链是否收敛到一个稳定的状态分布。

理解Markov链的关键是掌握其转移矩阵。R语言中并没有直接生成Markov链的函数,但可以通过自定义函数或使用矩阵运算来模拟Markov链的动态行为。以下是模拟一个简单的Markov链的R代码:

```R

# 定义初始状态

initial_state <- c(0.1, 0.9)

# 定义转移矩阵

transition_matrix <- matrix(c(0.8, 0.2, 0.4, 0.6), nrow = 2, byrow = TRUE)

# 生成Markov链的下一个状态

next_state <- initial_state %*% transition_matrix

```

在这个例子中,我们设定了一个初始状态分布和一个2x2的转移矩阵。通过矩阵乘法,我们得到下一个状态分布。这个简单的Markov链模拟展示了如何利用矩阵运算来理解和预测系统在不同时间点的状态。

## 2.2 MCMC算法原理

MCMC算法是一类基于蒙特卡洛方法的数值计算技术,它们的核心是通过构建Markov链来采样目标分布。算法的效率和准确性极大地依赖于Markov链的特性,特别是在如何选择合适的状态转移策略上。

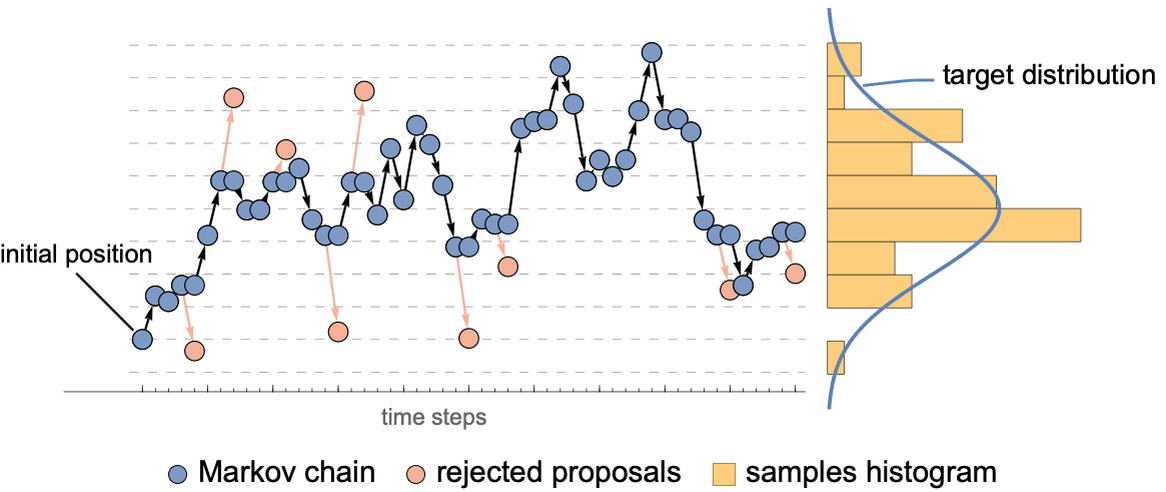

### 2.2.1 Metropolis-Hastings算法介绍

Metropolis-Hastings算法是一种广泛使用的MCMC算法。它的基本思想是利用一个易于采样的建议分布(proposal distribution)来生成新的状态,并通过接受-拒绝规则来确定是否接受新的状态。

算法步骤如下:

1. 从当前状态 \(x^{(t)}\) 开始。

2. 根据建议分布生成一个候选状态 \(y\)。

3. 计算接受概率 \( \alpha = \min \left(1, \frac{f(y) \times q(x^{(t)}|y)}{f(x^{(t)}) \times q(y|x^{(t)})} \right) \),其中 \( f(\cdot) \) 是目标分布的概率密度函数,\( q(\cdot|\cdot) \) 是建议分布。

4. 以概率 \( \alpha \) 接受新的状态 \( y \) 并设为 \( x^{(t+1)} \),否则保持当前状态 \( x^{(t+1)} = x^{(t)} \)。

5. 重复步骤2到4。

### 2.2.2 Gibbs采样原理

Gibbs采样是一种特殊的MCMC算法,专门用于多变量分布。其基本思想是从每个维度轮流进行采样,每次只固定其它维度不变,采样一个维度上的新值。

Gibbs采样的算法步骤:

1. 初始化所有变量的值 \(x_1^{(0)}, x_2^{(0)}, ..., x_n^{(0)}\)。

2. 对于每一步 \(t\),对于所有的 \(i\) 从 1 到 \(n\):

a. 从条件分布 \(P(X_i | X_1^{(t)}, X_2^{(t)}, ..., X_{i-1}^{(t)}, X_{i+1}^{(t-1)}, ..., X_n^{(t-1)})\) 中采样新的 \(x_i^{(t)}\)。

b. 用新采样得到的 \(x_i^{(t)}\) 替换旧的 \(x_i^{(t-1)}\)。

3. 重复步骤2直到收敛。

下面是一个简单的Gibbs采样的R语言实现,用于二维正态分布的采样:

```R

# 初始化

n <- 1000 # 迭代次数

x <- y <- numeric(n)

x[1] <- y[1] <- 0

# Gibbs采样迭代

for (i in 2:n) {

x[i] <- rnorm(1, y[i-1], 1)

y[i] <- rnorm(1, x[i], 1)

}

# 生成结果散点图

plot(x, y)

```

在这个例子中,我们初始化了两个变量 \(x\) 和 \(y\) 的值,然后在每次迭代中,我们根据对方变量的当前值采样新值,这个过程基于两个变量都是从标准正态分布中采样的假设。迭代完成后,我们得到了 \(x\) 和 \(y\) 的一个联合分布的样本,可以用散点图来表示。

## 2.3 统计推断在MCMC中的应用

统计推断是利用数据来推断总体参数的过程。在MCMC算法中,统计推断通常与后验分布的估计、点估计和区间估计等方法相关。

### 2.3.1 后验分布估计

后验分布是在贝叶斯统计中,结合先验分布和观测数据后得到的概率分布。它代表了在考虑了数据后,参数的不确定性。MCMC算法可以用来近似地从后验分布中采样,从而对参数的不确定性进行评估。

### 2.3.2 点估计与区间估计

点估计是对参数的一个单值估计,如均值或中位数。区间估计提供了参数可能落在的一个区间,给出了估计的不确定性范围,通常使用可信区间或置信区间来表示。

在使用MCMC算法得到样本后,可以通过计算样本均值来得到参数的点估计,通过排序样本并计算分位数来得到可信区间。

本章深入探讨了MCMC算法的理论基础,包括随机模拟的基本方法、Markov链理论、MCMC算法的具体原理以及在统计推断中的应用。下一章将着重介绍如何

0

0