机器学习中的随机数:从数据中抽丝剥茧

发布时间: 2024-07-03 08:54:58 阅读量: 62 订阅数: 38

随机数抽取

# 1. 随机数在机器学习中的作用**

随机数在机器学习中扮演着至关重要的角色,它为以下方面提供了基础:

- **数据采样:**随机数用于从大数据集抽取代表性样本,用于训练机器学习模型。

- **模型超参数优化:**随机数用于探索模型超参数空间,以找到最佳配置。

- **模型集成:**随机数用于创建多个模型,然后将它们集成在一起,以提高预测准确性。

- **减少过拟合:**随机数通过引入随机性,有助于减少模型对训练数据的过拟合。

# 2. 随机数生成器

随机数生成器是机器学习中的关键组件,用于生成用于训练和评估模型的随机数。在本章中,我们将探讨伪随机数生成器和真随机数生成器的不同类型,并讨论它们的优缺点。

### 2.1 伪随机数生成器

伪随机数生成器(PRNG)使用确定性算法生成看似随机的数字序列。它们从一个称为种子的固定值开始,并使用数学公式生成后续数字。虽然 PRNG 产生的数字序列不是真正的随机,但它们对于许多机器学习应用来说足够好。

#### 2.1.1 线性同余生成器

线性同余生成器(LCG)是最简单的 PRNG 之一。它使用以下公式生成随机数:

```

X[n+1] = (a * X[n] + c) % m

```

其中:

* X[n] 是第 n 个随机数

* a 是乘数

* c 是增量

* m 是模数

LCG 的优点是速度快、生成周期长。然而,它产生的数字序列可能具有可预测的模式,这可能会影响机器学习模型的性能。

#### 2.1.2 梅森旋转生成器

梅森旋转生成器(MT)是一种更复杂的 PRNG,它产生更长的随机数序列,并且具有更好的统计特性。它使用以下公式生成随机数:

```

X[n+1] = (X[n-w] ^ (X[n-w] >> r)) ^ (X[n-u] ^ (X[n-u] >> s))

```

其中:

* X[n] 是第 n 个随机数

* w、r、u、s 是常数

MT 的优点是它产生高品质的随机数,并且具有非常长的生成周期。然而,它比 LCG 慢,并且需要更多的内存。

### 2.2 真随机数生成器

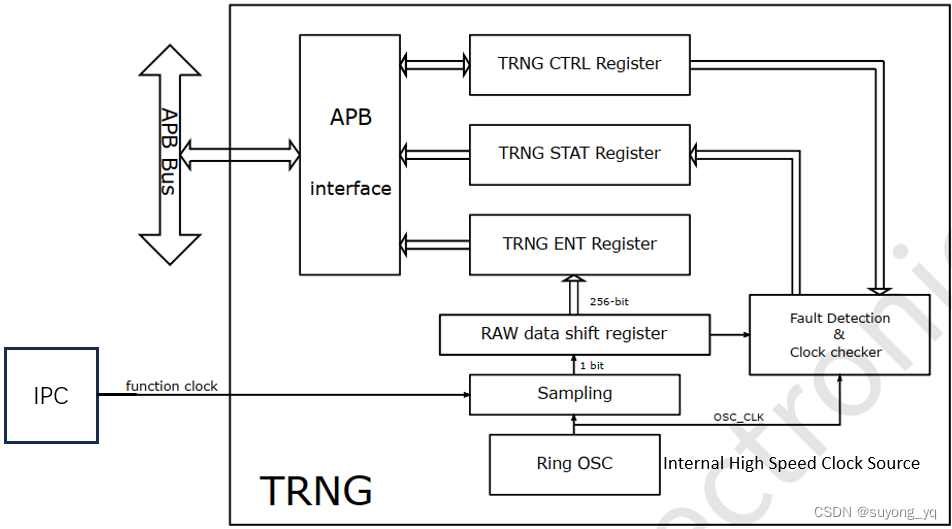

真随机数生成器(TRNG)使用物理过程生成真正的随机数。它们不依赖于确定性算法,因此产生的数字序列是不可预测的。TRNG 通常比 PRNG 更安全,但它们也更慢、更昂贵。

#### 2.2.1 物理随机数生成器

物理随机数生成器使用自然现象来生成随机数。例如,它们可能使用放射性衰变、热噪声或大气湍流。物理 TRNG 产生高品质的随机数,但它们通常很大、昂贵且难以维护。

#### 2.2.2 伪随机数生成器

伪随机数生成器使用伪随机数生成器作为种子来生成真正的随机数。这是一种折衷方案,它提供了比 PRNG 更好的安全性,同时比物理 TRNG 更快、更便宜。

**表格:随机数生成器比较**

| 特性 | PRNG | TRNG |

|---|---|---|

| 速度 | 快 | 慢 |

| 生成周期 | 短 | 长 |

| 质量 | 伪随机 | 真随机 |

| 安全性 | 低 | 高 |

| 成本 | 低 | 高 |

# 3. 随机数在机器学习算法中的应用**

### 3.1 训练数据采样

训练数据采样是机器学习中至关重要的一步,它决定了模型训练时所使用的训练数据。随机数在训练数据采样中扮演着关键角色,它可以帮助我们从原始数据中选择具有代表性的子集,从而提高模型的泛化能力。

#### 3.1.1 简单随机采样

简单随机采样是一种最基本的采样方法,它从原始数据中随机选择样本,每个样本被选中的概率相等。这种方法简单易行,但它可能会导致样本不具有代表性,特别是当原始数据分布不均匀时。

```python

import random

def simple_random_sampling(data, sample_size):

"""

简单随机采样

参数:

data: 原始数据

sample_size: 样本大小

返回:

样本

"""

# 创建一个样本列表

sample = []

# 从原始数据中随机选择样本

for i in range(sample_size):

index = random.randint(0, len(data) - 1)

sample.append(data[index])

return sample

```

#### 3.1.2 分层采样

分层采样是一种更复杂的采样方法,它将原始数据划分为不

0

0