奇异值分解(SVD):对角化矩阵的利器,揭开数据隐藏的秘密

发布时间: 2024-07-12 19:20:47 阅读量: 111 订阅数: 31

数学建模13-01 奇异值分解SVD的理论以及对矩阵的压缩

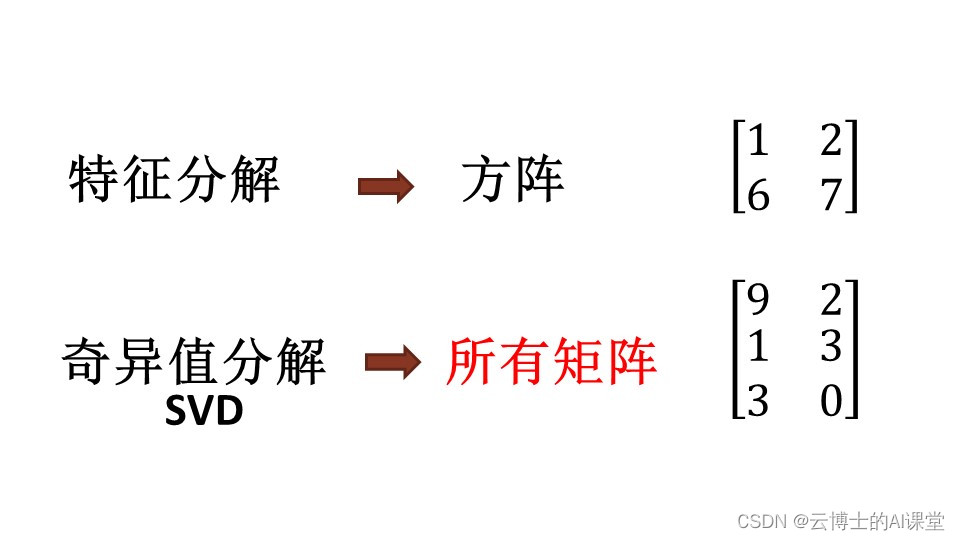

# 1. 奇异值分解(SVD)简介

奇异值分解(SVD)是一种强大的线性代数技术,用于分解矩阵为三个矩阵的乘积:一个正交矩阵 U、一个对角矩阵 Σ 和一个正交矩阵 V。它在数据科学、机器学习和图像处理等领域有着广泛的应用。

SVD 的核心思想是将矩阵分解为其奇异值和奇异向量的集合。奇异值是对角矩阵 Σ 中的对角元素,表示矩阵中方差最大的方向。奇异向量是 U 和 V 中的列,表示这些方向。

# 2. 奇异值分解的理论基础

### 2.1 线性代数基础

奇异值分解(SVD)是一种线性代数技术,用于分解一个矩阵为三个矩阵的乘积。要理解 SVD,首先需要了解一些线性代数基础。

**向量和矩阵**

向量是由数字组成的有序列表,表示一个方向和大小。矩阵是由数字组成的矩形数组,表示一个线性变换。

**线性变换**

线性变换是将一个向量映射到另一个向量的函数。它具有以下性质:

- 线性性:如果将一个向量乘以一个标量,然后对其进行线性变换,则结果与先进行线性变换再乘以标量相同。

- 叠加性:如果将两个向量相加,然后对其进行线性变换,则结果与先对每个向量进行线性变换再相加相同。

### 2.2 矩阵的奇异值分解

矩阵的奇异值分解(SVD)将一个矩阵分解为三个矩阵的乘积:

```

A = UΣV^T

```

其中:

- **A** 是原始矩阵。

- **U** 是正交矩阵,其列向量称为左奇异向量。

- **Σ** 是对角矩阵,其对角线元素称为奇异值。

- **V** 是正交矩阵,其列向量称为右奇异向量。

**奇异值**

奇异值是矩阵 A 的特征值,表示矩阵 A 的伸缩程度。奇异值越大,矩阵 A 在相应方向上的伸缩程度就越大。

**奇异向量**

奇异向量是矩阵 A 的特征向量,表示矩阵 A 的旋转和反射程度。左奇异向量表示矩阵 A 在行空间上的旋转和反射,而右奇异向量表示矩阵 A 在列空间上的旋转和反射。

**SVD 的几何解释**

SVD 可以几何地解释为将矩阵 A 分解为一系列旋转、伸缩和反射的组合。左奇异向量和右奇异向量分别表示这些旋转和反射的轴。奇异值表示这些变换的幅度。

**代码示例**

以下 Python 代码演示了如何使用 NumPy 库对矩阵进行 SVD:

```python

import numpy as np

A = np.array([[1, 2], [3, 4]])

U, Σ, V = np.linalg.svd(A)

print("U:")

print(U)

print("Σ:")

print(Σ)

print("V:")

print(V)

```

**逻辑分析**

此代码使用 NumPy 的 `svd()` 函数对矩阵 A 进行 SVD。该函数返回三个矩阵:U、Σ 和 V。

**参数说明**

- `A`:要分解的矩阵。

- `U`:左奇异向量矩阵。

- `Σ`:奇异值矩阵。

- `V`:右奇异向量矩阵。

# 3.1 降维与数据压缩

### 降维概述

降维是一种将高维数据映射到低维空间的技术,目的是保留原始数据的重要特征,同时减少数据的复杂性和计算成本。奇异值分解(SVD)是一种有效的降维方法,它通过将矩阵分解为奇异值、左奇异向量和右奇异向量来实现。

### SVD 降维原理

SVD 将矩阵 **A** 分解为以下形式:

```

A = UΣV^T

```

其中:

- **U** 是 **A** 的左奇异向量矩阵,其列向量是 **A** 的左奇异向量。

- **Σ** 是一个对角矩阵,其对角线元素是 **A** 的奇异值,按从大到小的顺序排列。

- **V** 是 **A** 的右奇异向量矩阵,其列向量是 **A** 的右奇异向量。

### 降维步骤

使用 SVD 进行降维的步骤如下:

1. 计算矩阵 **A** 的奇异值分解。

2. 选择前 **k** 个奇异值和相应的奇异向量,其中 **k** 是所需的低维空间的维度。

3. 将 **A** 投影到由前 **k** 个奇异向量构成的低维子空间中。

### 数据压缩

SVD 降维还可以用于数据压缩。通过保留前 **k** 个奇异值和相应的奇异向量,我们可以近似原始矩阵 **A** 为:

0

0