机器学习中的线性相关性:特征选择与降维的最佳实践

发布时间: 2024-07-09 01:09:33 阅读量: 97 订阅数: 25

# 1. 机器学习中的线性相关性**

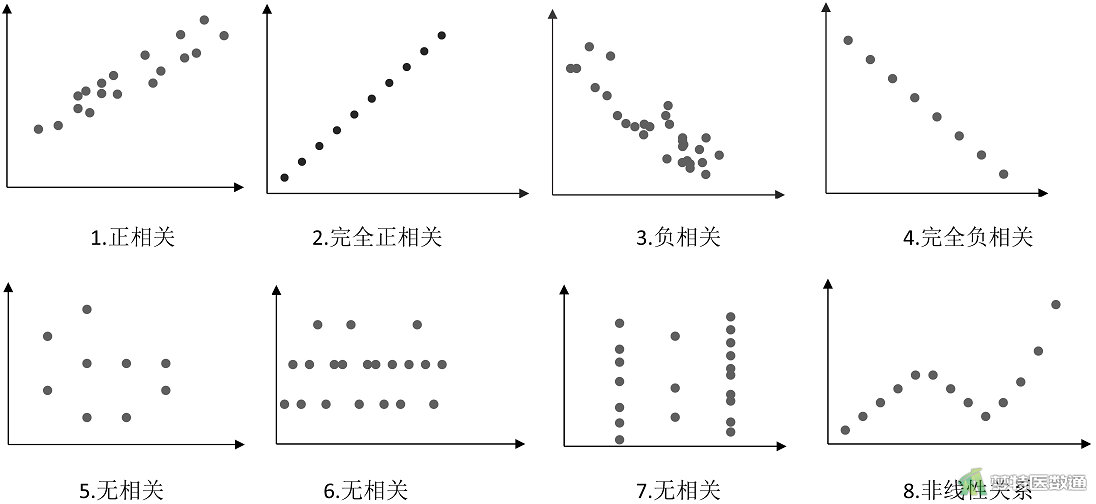

线性相关性描述了两个或多个变量之间线性关系的强度。在机器学习中,理解线性相关性至关重要,因为它可以影响模型的性能和解释性。

**线性相关性的概念和度量**

线性相关性通常使用相关系数来度量,其值在 -1 到 1 之间。正值表示正相关,负值表示负相关,而 0 表示没有相关性。相关系数可以根据协方差和标准差计算:

```python

import numpy as np

def corr_coef(x, y):

"""计算两个变量之间的相关系数。

参数:

x (np.array): 第一个变量。

y (np.array): 第二个变量。

返回:

float: 相关系数。

"""

cov = np.cov(x, y)[0, 1]

std_x = np.std(x)

std_y = np.std(y)

return cov / (std_x * std_y)

```

**线性相关性的影响**

线性相关性对机器学习模型的影响包括:

* **过拟合:**高度相关的特征可能会导致模型过拟合训练数据,降低泛化能力。

* **冗余:**高度相关的特征提供的信息重叠,导致模型冗余和效率低下。

* **解释性:**线性相关性会使模型解释变得困难,因为高度相关的特征难以区分其独立影响。

# 2. 特征选择

### 2.1 特征选择概述

特征选择是机器学习中一种重要的技术,它通过选择最相关的特征来减少数据集的维度。这可以提高模型的性能、减少训练时间,并提高模型的可解释性。

特征选择方法可以分为三类:

- **过滤式方法:**根据特征的统计属性(如信息增益、卡方检验)对特征进行评分,并选择得分最高的特征。

- **包装式方法:**将特征选择过程嵌入到模型训练中,通过迭代地添加或删除特征来选择最佳特征子集。

- **嵌入式方法:**在模型训练过程中同时执行特征选择和模型训练,通过正则化项或其他机制惩罚不相关的特征。

### 2.2 特征选择算法

#### 2.2.1 信息增益

信息增益衡量特征对目标变量的信息量。它定义为:

```

IG(T, A) = H(T) - H(T|A)

```

其中:

- `T` 是目标变量

- `A` 是特征

- `H(T)` 是目标变量的熵

- `H(T|A)` 是在给定特征 `A` 的情况下目标变量的条件熵

信息增益较高的特征对目标变量具有更强的预测能力。

#### 2.2.2 卡方检验

卡方

0

0