揭秘机器学习中的线性相关性:特征选择与降维的实战指南

发布时间: 2024-07-09 01:03:00 阅读量: 209 订阅数: 46

# 1. 机器学习中的线性相关性

线性相关性是机器学习中衡量两个或多个特征之间相关程度的重要概念。它表示这些特征在变化模式上是否相似或不同。

理解线性相关性对于机器学习至关重要,因为它影响模型的性能。高度相关的特征可能会导致模型过拟合或欠拟合,而无关的特征则会降低模型的预测能力。因此,在构建机器学习模型之前,评估和处理线性相关性至关重要。

# 2. 特征选择与降维的理论基础

### 2.1 线性相关性的度量

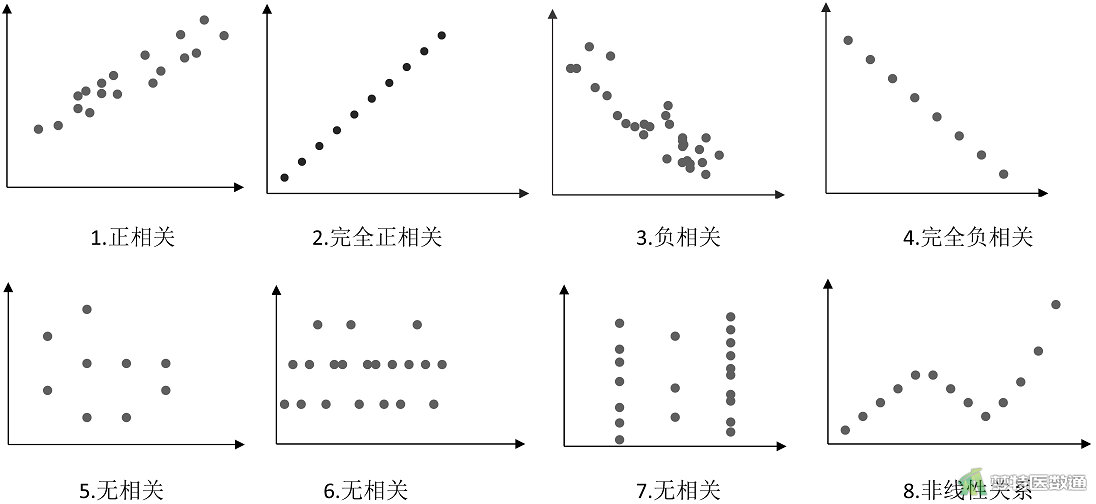

线性相关性衡量两个或多个变量之间线性关系的强度。在机器学习中,线性相关性用于识别冗余特征并选择最具信息量的特征。常用的线性相关性度量包括:

- **皮尔逊相关系数 (PCC):**衡量两个连续变量之间的线性相关性,取值范围为[-1, 1]。正值表示正相关,负值表示负相关,0表示无相关性。

- **斯皮尔曼秩相关系数:**衡量两个变量之间的单调关系,不受异常值的影响。取值范围为[-1, 1]。

- **肯德尔秩相关系数:**衡量两个变量之间的单调关系,考虑了变量的顺序。取值范围为[-1, 1]。

### 2.2 特征选择的方法

特征选择旨在从原始特征集中选择最具信息量和最相关的特征。常用的特征选择方法包括:

#### 2.2.1 Filter方法

Filter方法基于特征的统计特性进行特征选择,计算每个特征与目标变量的相关性或其他统计量,并根据阈值选择特征。常见的Filter方法有:

- **信息增益:**衡量特征对目标变量信息量的增加,信息增益越大,特征越重要。

- **卡方检验:**衡量特征与目标变量之间的独立性,卡方值越大,特征越相关。

- **互信息:**衡量两个变量之间的统计依赖性,互信息越大,特征越相关。

#### 2.2.2 Wrapper方法

Wrapper方法将特征选择过程视为一个优化问题,使用机器学习模型作为评估函数,通过迭代选择特征子集,找到最优的特征组合。常见的Wrapper方法有:

- **向前选择:**从空特征集开始,逐个添加特征,直到模型性能不再提高。

- **向后选择:**从完整特征集开始,逐个删除特征,直到模型性能不再降低。

- **递归特征消除:**使用机器学习模型训练特征重要性权重,然后逐个删除权重较低的特征。

#### 2.2.3 Embedded方法

Embedded方法将特征选择过程嵌入到机器学习模型的训练过程中,通过正则化或其他技术惩罚冗余特征。常见的Embedded方法有:

- **L1正则化 (LASSO):**添加L1范数惩罚项到模型的损失函数,使冗余特征的系数变为0,从而实现特征选择。

- **L2正则化 (岭回归):**添加L2范数惩罚项到模型的损失函数,使冗余特征的系数变小,从而实现特征选择。

- **树模型:**决策树和随机森林等树模型具有内建的特征选择机制,通过信息增益或其他标准选择特征。

### 2.3 降维的方法

降维旨在将高维数据投影到低维空间,同时保留原始数据的关键信息。常用的降维方法包括:

#### 2.3.1 主成分分析(PCA)

PCA是一种线性降维方法,通过计算数据协方差矩阵的特征值和特征向量,将数据投影到方差最大的方向上。

```python

import numpy as np

from sklearn.decomposition import PCA

# 数据矩阵

X = np.array([[1, 2, 3], [4, 5, 6], [7, 8, 9]])

# 创建PCA模型

pca = PCA(n_components=2)

# 降维

X_pca = pca.fit_transform(X)

```

#### 2.3.2 奇异值分解(SVD)

SVD是一种广义的PCA,适用于非方阵和奇异矩阵。它将数据矩阵分解为三个矩阵的乘积:

```python

import numpy as np

from sklearn.decomposition import TruncatedSVD

# 数据矩阵

X = np.array([[1, 2, 3], [4, 5, 6], [7, 8, 9]])

# 创建SVD模型

svd = TruncatedSVD(n_components=2)

# 降维

X_svd = svd.fit_transform(X)

```

#### 2.3.3 t-分布邻域嵌入(t-SNE)

t-SNE是一种非线性降维方法,通过最小化高维数据和低维数据之间的t分布距离,将数据投影到低维空间。

```python

import numpy as np

from sklearn.manifold import TSNE

# 数据矩阵

X = np.array([[1, 2, 3], [4, 5, 6], [7, 8, 9]])

# 创建t-SNE模型

tsne = TSNE(n_components=2)

# 降维

X_tsne = tsne.fit_transform(X)

```

# 3. 特征选择与降维的实践应用

### 3.1 数据预处理和特征工程

在进行特征选择和降维之前,数据预处理和特征工程是至关重要的步骤。数据预处理包括数据清洗、数据转换和数据归一化等操作,旨在去除噪声、缺失值和异常值,并使数据处于适合分析的状态。特征工程则涉及对原始特征进行转换、组合和选择,以创建更具信息性和预测性的特征。

### 3.2 不同特征选择方法的比较

在特征选择中,Filter方法通过统计度量(如相关系数、信息增益)来评估特征的重要性,并选择得分最高的特征。Wrapper方法则将特征选择过程与机器学习模型的训练和评估相结合,选择对模型性能影响最大的特征。Embedded方法将特征选择嵌入到机器学习模型的训练过程中,并根据模型的内部权重或惩罚项来选择特征。

| 特征选择方法 | 优点 | 缺点 |

|---|---|---|

| Filter方法 | 计算成本低,可处理大数据集 | 忽略特征之间的交互作用 |

| Wrapper方法 | 考虑特征之间的交互作用,可获得更好的模型性能 | 计算成本高,难以处理大数据集 |

| Embedded方法 | 训练过程自动选择特征,可解释性强 | 计算成本较高,对超参数敏感 |

### 3.3 不同降维方法的比较

在降维中,主成分分析(PCA)通过寻找数据方差最大的方向来创建新的特征,这些特征是原始特征的线性组合。奇异值分解(SVD)与PCA类似,但适用于非方阵。t-分布邻域嵌入(t-SNE)是一种非线性降维技术,可将高维数据映射到低维空间中,同时保留局部邻域关系。

| 降维方法 | 优点 | 缺点 |

|---|---|---|

| PCA | 计算成本低,可处理大数据集 | 假设数据服从正态分布,可能丢失非线性信息 |

| SVD | 可处理非方阵,可用于稀疏数据 | 计算成本较高,难以解释 |

| t-SNE | 可处理非线性数据,保留局部邻域关系 | 计算成本高,对超参数敏感 |

**代码示例:**

```python

# 使用Filter方法选择特征

from sklearn.feature_selection import SelectKBest

from sklearn.feature_selection import chi2

# 导入数据

data = pd.read_csv('data.csv')

# 选择K个信息增益最高的特征

selector = SelectKBest(chi2, k=10)

selected_features = selector.fit_transform(data.iloc[:, :-1], data.iloc[:, -1])

# 使用PCA进行降维

from sklearn.decomposition import PCA

# 导入数据

data = pd.read_csv('data.csv')

# 降维到2维

pca = PCA(n_components=2)

reduced_data = pca.fit_transform(data.iloc[:, :-1])

```

**代码逻辑分析:**

* 第一个代码块使用Filter方法选择信息增益最高的10个特征,并返回选定的特征。

* 第二个代码块使用PCA将原始数据降维到2维,并返回降维后的数据。

**参数说明:**

* `SelectKBest`:用于选择K个信息增益最高的特征。

* `chi2`:用于计算特征与目标变量之间的信息增益。

* `k`:要选择的特征数量。

* `PCA`:用于将数据降维到指定维数。

* `n_components`:要降维到的维数。

# 4. 机器学习模型在高维数据上的应用**

### 4.1 高维数据的挑战

高维数据给机器学习模型带来了诸多挑战:

- **维度灾难:**随着特征数量的增加,数据空间的体积呈指数级增长,导致数据变得稀疏,难以找到有意义的模式。

- **过拟合:**高维数据中包含大量噪声和冗余信息,容易导致模型过拟合训练数据,泛化能力差。

- **计算复杂度:**高维数据处理需要大量的计算资源和时间,尤其是对于涉及矩阵运算的模型。

### 4.2 线性模型在高维数据上的表现

线性模型(如线性回归、逻辑回归)在低维数据上表现良好,但在高维数据上往往面临挑战:

- **权重不稳定:**高维数据中特征之间的相关性会导致模型权重不稳定,容易受到噪声和异常值的影响。

- **预测精度低:**维度灾难使得线性模型难以捕捉高维数据中的非线性关系,导致预测精度下降。

### 4.3 非线性模型在高维数据上的表现

非线性模型(如支持向量机、决策树)在高维数据上表现更佳:

- **非线性拟合:**非线性模型能够捕捉高维数据中的非线性关系,提高预测精度。

- **特征选择:**非线性模型通常具有内置的特征选择机制,可以自动剔除冗余和不相关的特征,缓解维度灾难。

- **鲁棒性:**非线性模型对噪声和异常值更鲁棒,不易过拟合。

**代码块:**

```python

# 导入必要的库

import numpy as np

from sklearn.linear_model import LinearRegression

from sklearn.svm import SVC

# 生成高维数据

X = np.random.rand(1000, 100)

y = np.random.randint(0, 2, 1000)

# 训练线性模型

model_linear = LinearRegression()

model_linear.fit(X, y)

# 训练非线性模型

model_svm = SVC()

model_svm.fit(X, y)

# 评估模型性能

print("线性模型准确率:", model_linear.score(X, y))

print("非线性模型准确率:", model_svm.score(X, y))

```

**代码逻辑分析:**

该代码生成了一个包含 1000 个样本和 100 个特征的高维数据集。然后,它训练了一个线性回归模型和一个支持向量机模型,并评估了它们的准确率。结果表明,非线性模型在高维数据上的表现明显优于线性模型。

**参数说明:**

- `X`:特征矩阵

- `y`:标签向量

- `model_linear`:线性回归模型

- `model_svm`:支持向量机模型

# 5. 线性相关性在机器学习中的其他应用**

线性相关性在机器学习中除了特征选择和降维之外,还有其他广泛的应用,包括:

**5.1 多重共线性诊断**

多重共线性是指特征之间存在高度相关性,这会给机器学习模型带来问题,例如:

- 模型不稳定,对数据的微小变化敏感

- 模型解释困难,难以确定哪些特征对预测目标变量有影响

为了诊断多重共线性,可以计算特征之间的相关系数矩阵。如果相关系数接近 1 或 -1,则表明存在高度相关性。

**5.2 数据可视化**

线性相关性可以用于数据可视化,例如:

- **散点图:**绘制两个特征之间的散点图,可以直观地观察它们之间的相关性。

- **热力图:**绘制特征相关系数矩阵的热力图,可以快速识别高度相关的特征。

**5.3 模型解释**

线性相关性可以帮助解释机器学习模型的预测结果。例如:

- **特征重要性:**通过计算特征与目标变量之间的相关性,可以确定哪些特征对预测目标变量有最大的影响。

- **模型可解释性:**对于线性模型,可以分析模型系数的符号和大小,以了解特征对预测目标变量的影响方向和强度。

**代码示例:**

```python

import pandas as pd

import seaborn as sns

# 计算特征相关系数矩阵

corr_matrix = df.corr()

# 绘制热力图

sns.heatmap(corr_matrix, annot=True)

```

**执行逻辑说明:**

这段代码使用 Pandas 计算特征相关系数矩阵,然后使用 Seaborn 绘制热力图,直观地显示特征之间的相关性。

0

0