机器学习中的线性相关性:特征选择与降维的案例研究

发布时间: 2024-07-09 01:23:26 阅读量: 67 订阅数: 24

java计算器源码.zip

# 1. 机器学习中的线性相关性**

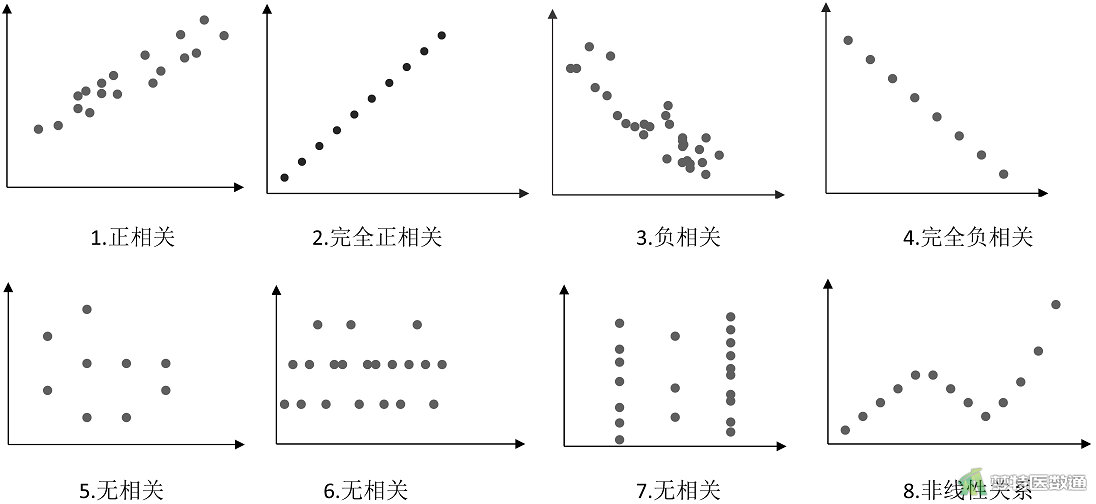

机器学习中,线性相关性描述了两个或多个变量之间线性关系的强度。它量化了变量变化之间的相关程度,范围从 -1 到 1。

- 正相关性(0 到 1):当一个变量增加时,另一个变量也增加。

- 负相关性(-1 到 0):当一个变量增加时,另一个变量减少。

- 无相关性(接近 0):两个变量之间没有线性关系。

线性相关性在机器学习中至关重要,因为它可以:

- 识别冗余特征,从而提高模型效率。

- 揭示变量之间的潜在关系,从而提高预测准确性。

- 减少数据维度,从而简化模型训练和部署。

# 2. 特征选择与降维理论

### 2.1 特征选择方法

特征选择是识别和选择对机器学习模型性能至关重要的特征的过程。它有助于提高模型的准确性、可解释性和效率。特征选择方法可分为三大类:

#### 2.1.1 过滤式方法

过滤式方法根据特征的统计特性(如相关性、方差)对特征进行评分。它们独立于机器学习模型进行计算,因此速度很快。

**代码块:**

```python

import pandas as pd

from sklearn.feature_selection import SelectKBest, chi2

# 导入数据

data = pd.read_csv('data.csv')

# 使用卡方检验选择前 10 个特征

selector = SelectKBest(chi2, k=10)

selector.fit(data.drop('target', axis=1), data['target'])

# 获取选择的特征

selected_features = data.drop('target', axis=1).columns[selector.get_support()]

```

**逻辑分析:**

* `SelectKBest` 类使用卡方检验(`chi2`)作为特征评分函数。

* `fit()` 方法拟合过滤式选择器,计算每个特征的卡方统计量。

* `get_support()` 方法返回布尔掩码,指示哪些特征被选择。

#### 2.1.2 包裹式方法

包裹式方法将特征选择过程与机器学习模型训练集成在一起。它们通过迭代地添加或删除特征来评估模型性能。

**代码块:**

```python

import pandas as pd

from sklearn.feature_selection import RFE, LinearRegression

# 导入数据

data = pd.read_csv('data.csv')

# 使用递归特征消除 (RFE) 选择特征

selector = RFE(LinearRegression(), n_features_to_select=10)

selector.fit(data.drop('target', axis=1), data['target'])

# 获取选择的特征

selected_features = data.drop('target', axis=1).columns[selector.get_support()]

```

**逻辑分析:**

* `RFE` 类使用线性回归模型作为基础估计器。

* `fit()` 方法拟合包裹式选择器,通过迭代地移除特征来优化模型性能。

* `get_support()` 方法返回布尔掩码,指示哪些特征被选择。

#### 2.1.3 嵌入式方法

嵌入式方法将特征选择作为机器学习模型训练过程的一部分。它们使用模型训练过程中的信息来评估特征的重要性。

**代码块:**

```python

import pandas as pd

from sklearn.linear_model import LogisticRegression

# 导入数据

data = pd.rea

```

0

0