机器学习中的线性相关性:揭秘特征选择与降维的利器

发布时间: 2024-07-09 00:56:22 阅读量: 89 订阅数: 42

# 1. 机器学习中的线性相关性概述

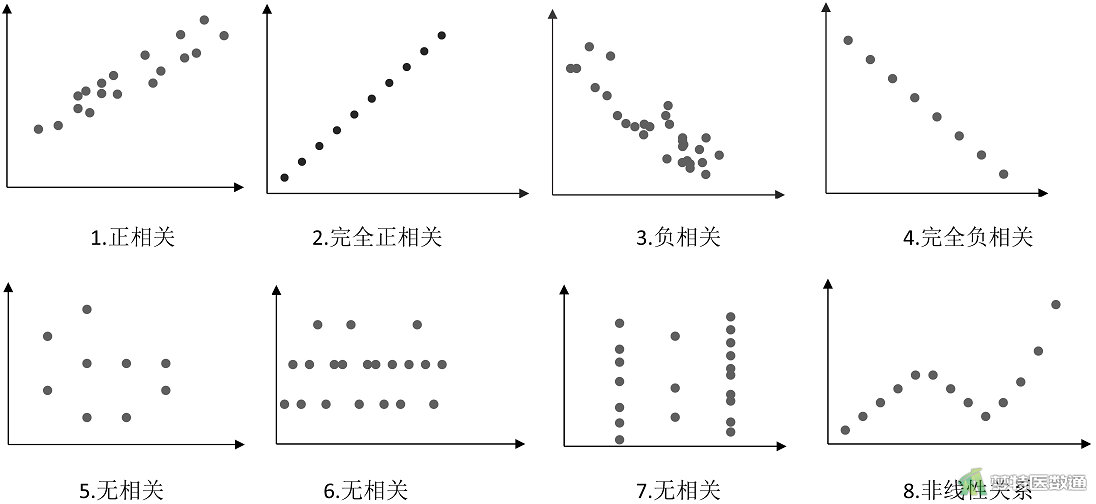

线性相关性是机器学习中衡量两个或多个变量之间相关程度的重要概念。它提供了对数据中变量间关系的深入理解,并有助于优化机器学习模型的性能。

线性相关性通常用相关系数来度量,其值在-1到1之间。相关系数为正值表示正相关,为负值表示负相关,而0表示没有线性相关性。相关系数的绝对值越大,线性相关性越强。

# 2. 线性相关性分析理论

### 2.1 线性相关性的定义和度量

#### 2.1.1 相关系数

相关系数(Pearson 相关系数)是衡量两个变量之间线性相关性的指标,其取值范围为 -1 到 1。

- 相关系数为 1,表示两个变量完全正相关,即当一个变量增加时,另一个变量也增加。

- 相关系数为 -1,表示两个变量完全负相关,即当一个变量增加时,另一个变量减少。

- 相关系数为 0,表示两个变量之间没有线性相关性。

相关系数的计算公式为:

```python

corr(X, Y) = cov(X, Y) / (std(X) * std(Y))

```

其中:

- `corr(X, Y)` 是 X 和 Y 之间的相关系数

- `cov(X, Y)` 是 X 和 Y 之间的协方差

- `std(X)` 和 `std(Y)` 分别是 X 和 Y 的标准差

#### 2.1.2 协方差

协方差是衡量两个变量之间线性相关性的另一种指标。协方差表示两个变量同时变化的程度。

- 正协方差表示两个变量正相关,即当一个变量增加时,另一个变量也增加。

- 负协方差表示两个变量负相关,即当一个变量增加时,另一个变量减少。

- 零协方差表示两个变量之间没有线性相关性。

协方差的计算公式为:

```python

cov(X, Y) = sum((X - mean(X)) * (Y - mean(Y))) / (n - 1)

```

其中:

- `cov(X, Y)` 是 X 和 Y 之间的协方差

- `mean(X)` 和 `mean(Y)` 分别是 X 和 Y 的均值

- `n` 是样本数量

### 2.2 线性相关性的影响和应用

#### 2.2.1 过拟合和欠拟合

线性相关性在机器学习中至关重要,因为它影响着模型的性能。

- **过拟合**是指模型在训练数据上表现良好,但在新数据上表现不佳。过拟合通常是由高相关性变量造成的,这些变量在训练数据中可能具有相关性,但在新数据中可能没有。

- **欠拟合**是指模型在训练数据和新数据上都表现不佳。欠拟合通常是由低相关性变量造成的,这些变量在训练数据中可能没有相关性,但在新数据中可能具有相关性。

#### 2.2.2 特征选择和降维

线性相关性分析可用于特征选择和降维。

- **特征选择**是指从一组特征中选择最相关的特征,以提高模型的性能。线性相关性分析可用于识别高相关性特征,这些特征可以从模型中移除。

- **降维**是指将高维数据转换为低维数据,以提高模型的效率。线性相关性分析可用于识别低相关性特征,这些特征可以从数据中移除。

# 3. 线性相关性分析实践

### 3.1 线性相关性分析工具和方法

#### 3.1.1 相关矩阵和热力图

相关矩阵是一个二维矩阵,其中每个元素表示两个变量之间的相关系数。相关系数是一个介于-1和1之间的值,表示两个变量之间的线性关系。正值表示正相关,负值表示负相关,0表示没有相关性。

热力图是相关矩阵的图形表示。它使用颜色来表示相关系数的大小和符号。深色表示强相关,浅色表示弱相关。

```python

import pandas as pd

import matplotlib.pyplot as plt

# 创建一个数据框

df = pd.DataFrame({

'feature1': [1, 2, 3, 4, 5],

'feature2': [6, 7, 8, 9, 10],

'feature3': [11, 12, 13, 14, 15]

})

# 计算相关矩阵

corr_matrix = df.corr()

# 创建热力图

plt.figure(figsize=(10, 10))

plt.imshow(corr_matrix, cmap='RdYlGn')

plt.colorbar()

plt.title('相关矩阵热力图')

plt.show()

```

#### 3.1.2 主成分分析(PCA)

主成分分析(PCA)是一种降维技术,它通过将数据投影到一个新的正交坐标系上,从而找到数据中的主要成分。这些主要成分是数据中方差最大的方向。

```python

from sklearn.decomposition import PCA

# 创建 PCA 对象

pca = PCA(n_components=2)

# 拟合数据

pca.fit(df)

# 获取主成分

principal_components = pca.components_

# 获取方差

variances = pca.explained_variance_ratio_

```

#### 3.1.3 奇异值分解(SVD)

奇异值分解(SVD)是一种矩阵分解技术,它可以将矩阵分解为三个矩阵的乘积:左奇异矩阵、奇异值矩阵和右奇异矩阵。奇异值矩阵的对角线元素就是矩阵的奇异值,它们表示矩阵中主要成分的方差。

```python

from numpy import linalg

# 创建一个矩阵

A = np.array([[1, 2, 3], [4, 5, 6], [7, 8, 9]])

# 进行奇异值分解

U, s, Vh = linalg.svd(A)

# 获取奇异值

singular_values = s

```

### 3.2 线性相关性分析在特征选择中的应用

#### 3.2.1 过滤法

过滤法是一种特征选择方法,它根据特征与目标变量的相关性来选择特征。相关系数较高的特征被认为是相关的,而相关系数较低的特征被认为是不相关的。

```python

# 计算相关系数

corr_matrix = df.corr()

# 选择相关系数大于 0.5 的特征

selected_features = corr_matrix['target'].abs() > 0.5

```

#### 3.2.2 包裹法

包裹法是一种特征选择方法,它通过训练一个模型并评估其性能来选择特征。它迭代地添加或删除特征,直到找到最佳特征子集。

```python

from sklearn.model_selection import cross_val_score

# 创建一个模型

model = RandomForestClassifier()

# 使用包裹法选择特征

selector = SelectKBest(f_classif, k=5)

selector.fit(df, df['target'])

# 获取选定的特征

selected_features = selector.get_support()

```

#### 3.2.3 嵌入法

嵌入法是一种特征选择方法,它将特征选择作为模型训练过程的一部分。它使用模型的权重或系数来确定哪些特征是重要的。

```python

from sklearn.linear_model import LogisticRegression

# 创建一个模型

model = LogisticRegression()

# 训练模型

model.fit(df, df['target'])

# 获取特征权重

feature_weights = model.coef_

# 选择权重绝对值最大的特征

selected_features = np.argsort(np.abs(feature_weights))[-5:]

```

# 4. 线性相关性分析在降维中的应用

### 4.1 降维的必要性和优势

在机器学习中,数据维度过高往往会带来一系列问题,例如:

- **数据可视化困难:**高维数据难以直观地表示和理解。

- **模型训练和预测效率低:**高维数据会增加模型训练和预测的时间和计算资源消耗。

- **过拟合风险增加:**高维数据中包含的噪声和冗余信息可能导致模型过拟合,降低泛化能力。

因此,在实际应用中,经常需要对高维数据进行降维,以降低数据维度,同时保留其主要信息。降维的主要优势包括:

- **数据可视化更直观:**降维后的数据可以更直观地表示和理解,便于探索数据分布和模式。

- **模型训练和预测效率更高:**降维后的数据维度更低,可以显著减少模型训练和预测的时间和计算资源消耗。

- **过拟合风险降低:**降维可以去除数据中的噪声和冗余信息,从而降低模型过拟合的风险,提高泛化能力。

### 4.2 降维算法和技术

常用的降维算法和技术包括:

#### 4.2.1 主成分分析(PCA)

PCA是一种线性降维技术,通过寻找数据中方差最大的方向来投影数据,从而保留数据的主要信息。PCA的步骤如下:

1. 对数据进行中心化,即减去每个特征的均值。

2. 计算协方差矩阵。

3. 计算协方差矩阵的特征值和特征向量。

4. 选择前k个特征值对应的特征向量作为降维后的数据。

**代码块:**

```python

import numpy as np

from sklearn.decomposition import PCA

# 假设X是原始数据

pca = PCA(n_components=2) # 降维到2维

X_reduced = pca.fit_transform(X)

```

**逻辑分析:**

该代码块使用scikit-learn库中的PCA模块对数据X进行降维。n_components参数指定降维后的维度,这里设置为2。fit_transform方法将数据中心化、计算协方差矩阵并投影数据,得到降维后的数据X_reduced。

#### 4.2.2 线性判别分析(LDA)

LDA是一种监督降维技术,通过寻找能够最大化类间差异和最小化类内差异的方向来投影数据。LDA的步骤如下:

1. 计算类均值向量和类内散度矩阵。

2. 计算类间散度矩阵。

3. 计算类间散度矩阵和类内散度矩阵的广义特征值和特征向量。

4. 选择前k个广义特征值对应的特征向量作为降维后的数据。

**代码块:**

```python

import numpy as np

from sklearn.discriminant_analysis import LinearDiscriminantAnalysis

# 假设X是原始数据,y是标签

lda = LinearDiscriminantAnalysis(n_components=2)

X_reduced = lda.fit_transform(X, y)

```

**逻辑分析:**

该代码块使用scikit-learn库中的LinearDiscriminantAnalysis模块对数据X进行降维。n_components参数指定降维后的维度,这里设置为2。fit_transform方法计算类均值向量、类内散度矩阵和类间散度矩阵,并投影数据,得到降维后的数据X_reduced。

#### 4.2.3 t-分布邻域嵌入(t-SNE)

t-SNE是一种非线性降维技术,通过将数据映射到低维空间并最小化数据点之间的t分布相似度来投影数据。t-SNE的步骤如下:

1. 计算数据点之间的成对距离矩阵。

2. 计算数据点之间的t分布相似度矩阵。

3. 初始化低维嵌入。

4. 迭代优化低维嵌入,最小化数据点之间的t分布相似度矩阵和低维嵌入之间的欧氏距离矩阵之间的差异。

**代码块:**

```python

import numpy as np

from sklearn.manifold import TSNE

# 假设X是原始数据

tsne = TSNE(n_components=2)

X_reduced = tsne.fit_transform(X)

```

**逻辑分析:**

该代码块使用scikit-learn库中的TSNE模块对数据X进行降维。n_components参数指定降维后的维度,这里设置为2。fit_transform方法计算数据点之间的成对距离矩阵和t分布相似度矩阵,并迭代优化低维嵌入,得到降维后的数据X_reduced。

# 5. 线性相关性分析在机器学习中的应用案例

线性相关性分析在机器学习中有着广泛的应用,它可以帮助我们理解数据中的相关性,并据此做出决策。在本章中,我们将探讨线性相关性分析在文本分类和图像识别中的应用案例。

### 5.1 文本分类

#### 5.1.1 特征选择和降维

在文本分类中,线性相关性分析可以用于特征选择和降维。通过计算文本特征之间的相关性,我们可以识别出冗余或不相关的特征,并将其剔除。这可以提高分类模型的准确性和效率。

```python

# 导入相关库

import pandas as pd

from sklearn.feature_selection import SelectKBest, chi2

# 加载文本数据

data = pd.read_csv('text_data.csv')

# 计算特征之间的相关性

corr_matrix = data.corr()

# 使用卡方检验选择特征

selector = SelectKBest(chi2, k=10)

selected_features = selector.fit_transform(data.drop('target', axis=1), data['target'])

```

#### 5.1.2 模型训练和评估

选择特征后,我们可以使用线性相关性分析来评估模型的性能。通过计算模型预测值与真实值之间的相关性,我们可以衡量模型的拟合优度。

```python

# 导入相关库

from sklearn.linear_model import LogisticRegression

from sklearn.metrics import classification_report

# 训练逻辑回归模型

model = LogisticRegression()

model.fit(selected_features, data['target'])

# 评估模型性能

predictions = model.predict(selected_features)

print(classification_report(data['target'], predictions))

```

### 5.2 图像识别

#### 5.2.1 特征选择和降维

在图像识别中,线性相关性分析可以用于特征选择和降维。通过计算图像特征之间的相关性,我们可以识别出冗余或不相关的特征,并将其剔除。这可以提高识别模型的准确性和效率。

```python

# 导入相关库

import numpy as np

from sklearn.decomposition import PCA

# 加载图像数据

images = np.load('image_data.npy')

# 计算特征之间的相关性

corr_matrix = np.corrcoef(images)

# 使用主成分分析降维

pca = PCA(n_components=10)

reduced_features = pca.fit_transform(images)

```

#### 5.2.2 模型训练和评估

选择特征后,我们可以使用线性相关性分析来评估模型的性能。通过计算模型预测值与真实值之间的相关性,我们可以衡量模型的拟合优度。

```python

# 导入相关库

from sklearn.svm import SVC

from sklearn.metrics import accuracy_score

# 训练支持向量机模型

model = SVC()

model.fit(reduced_features, data['target'])

# 评估模型性能

predictions = model.predict(reduced_features)

print(accuracy_score(data['target'], predictions))

```

0

0