机器学习中的线性相关性:特征选择与降维的数学原理

发布时间: 2024-07-09 01:15:23 阅读量: 55 订阅数: 25

# 1. 机器学习中的线性相关性**

线性相关性是机器学习中一个重要的概念,它描述了两个或多个特征之间存在相关性的程度。在机器学习模型中,线性相关性会影响模型的性能,例如:

- **过拟合:**当特征之间存在高线性相关性时,模型可能会过拟合训练数据,导致泛化能力差。

- **冗余特征:**高度相关的特征会提供重复的信息,导致模型冗余,降低模型的效率。

- **多重共线性:**当特征之间存在完全线性相关性时,模型的系数估计会变得不稳定,导致模型不稳定。

# 2. 特征选择与降维的理论基础

### 2.1 线性相关性的数学定义

#### 2.1.1 协方差和相关系数

**协方差**衡量两个随机变量之间的线性关系,计算公式为:

```python

cov(X, Y) = 1 / (n - 1) * Σ[(x_i - μ_x) * (y_i - μ_y)]

```

其中:

* `X` 和 `Y` 为两个随机变量

* `n` 为样本数量

* `μ_x` 和 `μ_y` 为 `X` 和 `Y` 的均值

**相关系数**表示两个随机变量之间线性关系的强度,计算公式为:

```python

corr(X, Y) = cov(X, Y) / (σ_x * σ_y)

```

其中:

* `σ_x` 和 `σ_y` 为 `X` 和 `Y` 的标准差

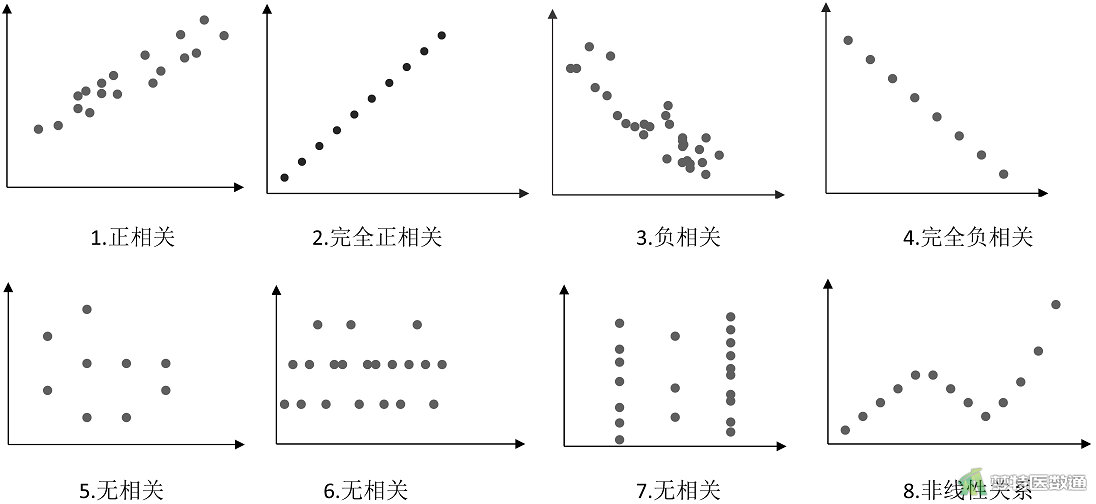

相关系数取值范围为 `[-1, 1]`:

* `1` 表示完全正相关

* `0` 表示无相关性

* `-1` 表示完全负相关

#### 2.1.2 相关矩阵和特征值分解

**相关矩阵**是一个方阵,其元素表示各个特征之间的相关系数。相关矩阵是一个对称矩阵,其对角线元素为 `1`。

**特征值分解**可以将相关矩阵分解为特征值和特征向量。特征值表示相关矩阵中线性独立方向上的方差,特征向量表示这些方向。

### 2.2 降维的数学原理

#### 2.2.1 主成分分析(PCA)

**主成分分析(PCA)**是一种线性降维技术,通过将数据投影到方差最大的方向上来减少特征数量。PCA 的步骤如下:

1. 对数据进行中心化,即减去每个特征的均值。

2. 计算相关矩阵。

3. 对相关矩阵进行特征值分解。

4. 选择前 `k` 个特征值对应的特征向量作为新的特征。

#### 2.2.2 奇异值分解(SVD)

**奇异值分解(SVD)**是一种更通用的降维技术,可以用于处理非方阵或奇异矩阵。SVD 的步骤如下:

1. 对数据进行中心化。

2. 计算数

0

0