机器学习中的线性相关性:特征选择与降维的进阶技巧

发布时间: 2024-07-09 01:05:12 阅读量: 56 订阅数: 42

# 1. 机器学习中的线性相关性概述

机器学习中,线性相关性是衡量两个或多个特征之间线性关系强度的指标。理解线性相关性对于特征选择和降维等机器学习任务至关重要。

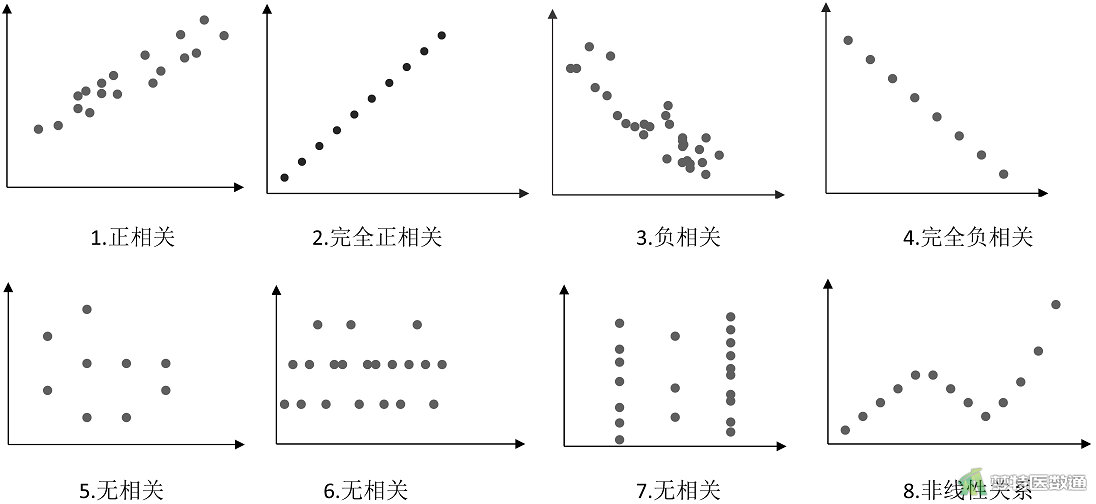

线性相关性度量主要包括相关系数和信息增益。相关系数表示两个特征之间的线性相关程度,范围从-1到1,其中-1表示完全负相关,1表示完全正相关,0表示无相关性。信息增益度量一个特征对目标变量预测能力的增加,它考虑了特征的熵和条件熵。

特征选择旨在从原始特征集中选择出与目标变量最相关、最具信息量的特征子集。降维则通过将高维数据投影到低维空间来减少数据维度,同时保留关键信息。

# 2.1 线性相关性的度量与特征选择

### 2.1.1 相关系数和信息增益

**相关系数**是衡量两个变量之间线性相关性的统计量,其值在[-1, 1]之间。相关系数为正值表示正相关,为负值表示负相关,为0表示不相关。

**计算公式:**

```python

corr = (cov(X, Y)) / (std(X) * std(Y))

```

其中:

* `cov` 为协方差

* `std` 为标准差

**信息增益**是衡量一个特征对目标变量区分能力的度量,其值越大表示区分能力越强。

**计算公式:**

```python

IG(X, Y) = H(Y) - H(Y | X)

```

其中:

* `H(Y)` 为目标变量的熵

* `H(Y | X)` 为在给定特征 `X` 条件下目标变量的条件熵

### 2.1.2 卡方检验和互信息

**卡方检验**是一种用于检验两个分类变量之间是否独立的统计检验。其值越大表示相关性越强。

**计算公式:**

```python

chi2 = sum((O - E)^2 / E)

```

其中:

* `O` 为观测频率

* `E` 为期望频率

**互信息**是一种衡量两个变量之间非线性相关性的度量,其值越大表示相关性越强。

**计算公式:**

```python

MI(X, Y) = sum(p(x, y) * log(p(x, y) / (p(x) * p(y))))

```

其中:

* `p(x, y)` 为联合概率

* `p(x)` 为 `X` 的概率

* `p(y)` 为 `Y` 的概率

# 3.1 特征选择算法的实现

特征选择算法可以分为三种主要类型:过滤法、包裹法和嵌入法。

#### 3.1.1 过滤法

过滤法基于特征的统计属性(如相关系数、信息增益等)对特征进行评分,然后根据评分阈值选择特征。过滤法计算效率高,但可能导致次优特征选择结果。

**代码示例:**

```python

import pandas as pd

from sklearn.feature_selection import SelectKBest, chi2

# 加载数据

data = pd.read_csv('data.csv')

# 计算卡方检验得分

scores = SelectKBest(chi2, k=10).fit(data.drop('target', axis=1), data['target'])

# 选择特征

selected_features = data.drop('target', axis=1).columns[scores.get_support()]

```

**逻辑分析:**

* `SelectKBest`类用于基于卡方检验得分选择前`k`个特征。

* `fit`方法将数据和目标变量拟合到模型中,计算每个特征的卡方检验得分。

* `get_support`方法返回布尔数组,指示哪些特征被选中。

#### 3.1.2 包裹法

包裹法将特征选择问题视为一个组合优化问题,通过评估所有可能的特征组合来选择最

0

0